O que os apps de relacionamento podem ensinar às big techs sobre privacidade

Controles do tipo “deslizar para consentir” são intuitivos, fáceis de aplicar e estão alinhados com as melhores práticas de consentimento

Há mais de 15 anos atuo na área de privacidade de dados, mas nada conseguiu me preparar para as complexidades que a IA criou para as empresas desde que se tornou popular, em 2022.

Toda semana, uma nova empresa está no centro das atenções. Exemplos disso são as críticas contra a Meta por usar os dados dos usuários do Facebook e do Instagram para treinamento de IA, o recurso Recall da Microsoft (que mais tarde foi forçada a voltar atrás) e o cancelamento de assinaturas por parte dos usuários da Adobe por temerem que suas obras de arte alimentassem modelos generativos.

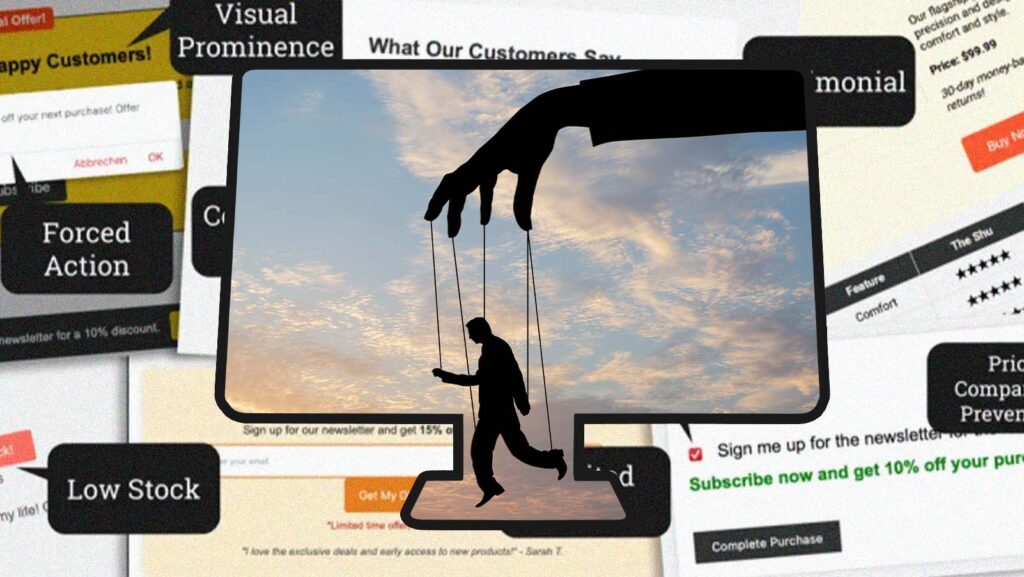

A questão quase sempre se resume a se os usuários podem optar por não entregar seus dados aos sistemas de IA. Se eles tiverem essa opção, como será essa experiência? O aviso de coleta de dados está embutido nos Termos e Condições? O mecanismo de cancelamento está cheio de padrões obscuros, feitos para enganar os usuários e levá-los a aceitar tudo ou desencorajá-los a tentar mudar algum detalhe?

A maioria das pessoas clica cegamente em “aceitar todos os cookies” ao navegar pela internet. E isso não é motivo de comemoração. Isso revela uma falha das empresas de tecnologia em explicar quais informações coletam, por que são coletadas e como são usadas.

A raiz do problema é que, por padrão, os consumidores quase sempre optam automaticamente por novas experiências e recursos e pela consequente coleta e uso de dados que os acompanham. Mesmo quando lhes é dada a opção de recusar, o processo costuma ser muito confuso ou cheio de obstáculos para que alguém se dê ao trabalho.

Assim, os consumidores continuam fornecendo seus dados, dia após dia, até que, finalmente, o copo transborda em reações públicas e manchetes polêmicas. Esse ciclo não é ruim apenas para os direitos de privacidade do consumidor – é ruim para as empresas e para o futuro dos modelos de IA.

No mundo da privacidade de dados, defendemos o conceito de minimização de dados. É considerada uma prática recomendada coletar a menor quantidade possível de dados e informar os consumidores com antecedência sobre o que coletamos e como os usamos. Por que, então, as empresas de tecnologia continuam insistindo na opção de aceitação padrão, fazendo dela a norma?

Em um artigo da revista "Wired" sobre as políticas de privacidade da Anthropic, fiquei sabendo que a empresa usa as solicitações e os resultados dos usuários para treinar seu modelo, o Claude. Mas um porta-voz da Anthropic afirma que eles só usam esses dados para treinamento quando “o usuário dá permissão expressa para isso, como clicar em um sinal de polegar para cima ou para baixo em uma saída específica do Claude para nos fornecer feedback”.

Ler isso me fez lembrar de minha função anterior como diretor de privacidade do aplicativo de namoro Grindr e líder de programas de privacidade no Match Group (empresa controladora do Tinder e do Hinge). Isso também me inspirou a pensar em um novo modelo para um futuro que seja livre de padrões prontos de privacidade.

Por que as empresas de tecnologia continuam insistindo na opção de aceitação padrão, fazendo dela a norma?

Imitar gestos de aplicativos de namoro – como deslizar o dedo para a esquerda ou para a direita ou um simples polegar para cima ou para baixo – em cada ponto da coleta de dados é uma maneira brilhante de obter consentimento, especialmente ao coletar dados para treinamento de modelos.

Um consumidor pode se sentir confortável com o fato de seus dados serem usados para treinar um tipo de modelo, como um modelo para detecção de doenças, mas não outros. Outro consumidor pode ceder todos os seus dados de saúde para treinamento, mas se recusar a fornecer seus dados de escrita criativa. Outro ainda pode “passar o dedo para a esquerda” em tudo isso.

A realidade é que cortar o acesso a todos os dados não é a solução para nenhuma empresa. E os modelos de IA são os que mais precisam deles. Pesquisadores estimam que podemos ficar sem dados para o treinamento de modelos dentro de uma década. Há casos demais de usos inovadores para a IA no mundo – desde saúde e finanças até tecnologia de consumo e educação – para permitir que isso aconteça.

A implementação de controles pontuais e fáceis de usar, como a passagem de dedo, para aprimorar a forma como coletamos o consentimento, dá aos usuários o poder real de decidir quando conceder acesso aos seus dados com base no que eles são e em como serão usados.

Esses controles não são apenas intuitivos e escalonáveis, mas também estão alinhados com as práticas recomendadas de consentimento que reduzem o risco comercial. Isso pode resultar em mais e melhores dados coletados para treinar os modelos de IA do futuro.

Embora algumas empresas possam argumentar que um modelo de deslizar para consentir resultaria em menos coleta de dados, eu discordo. Um consumidor informado e com direitos é um consumidor leal e engajado.

Pelo futuro da inteligência artificial, esse é um modelo que eu adotaria de imediato.