Seus funcionários podem estar vazando segredos corporativos para o ChatGPT

Quase um terço dos usuários de IA compartilham informações sensíveis com o chatbot – e 14% admitem revelar segredos comerciais

Praticamente todo CEO que conheço quer que sua equipe use mais inteligência artificial – e com razão: ela pode acelerar processos em praticamente todas as áreas e aumentar significativamente a produtividade. O uso da tecnologia já se tornou uma necessidade estratégica. Mas como as empresas podem evitar dores de cabeça com a segurança da IA?

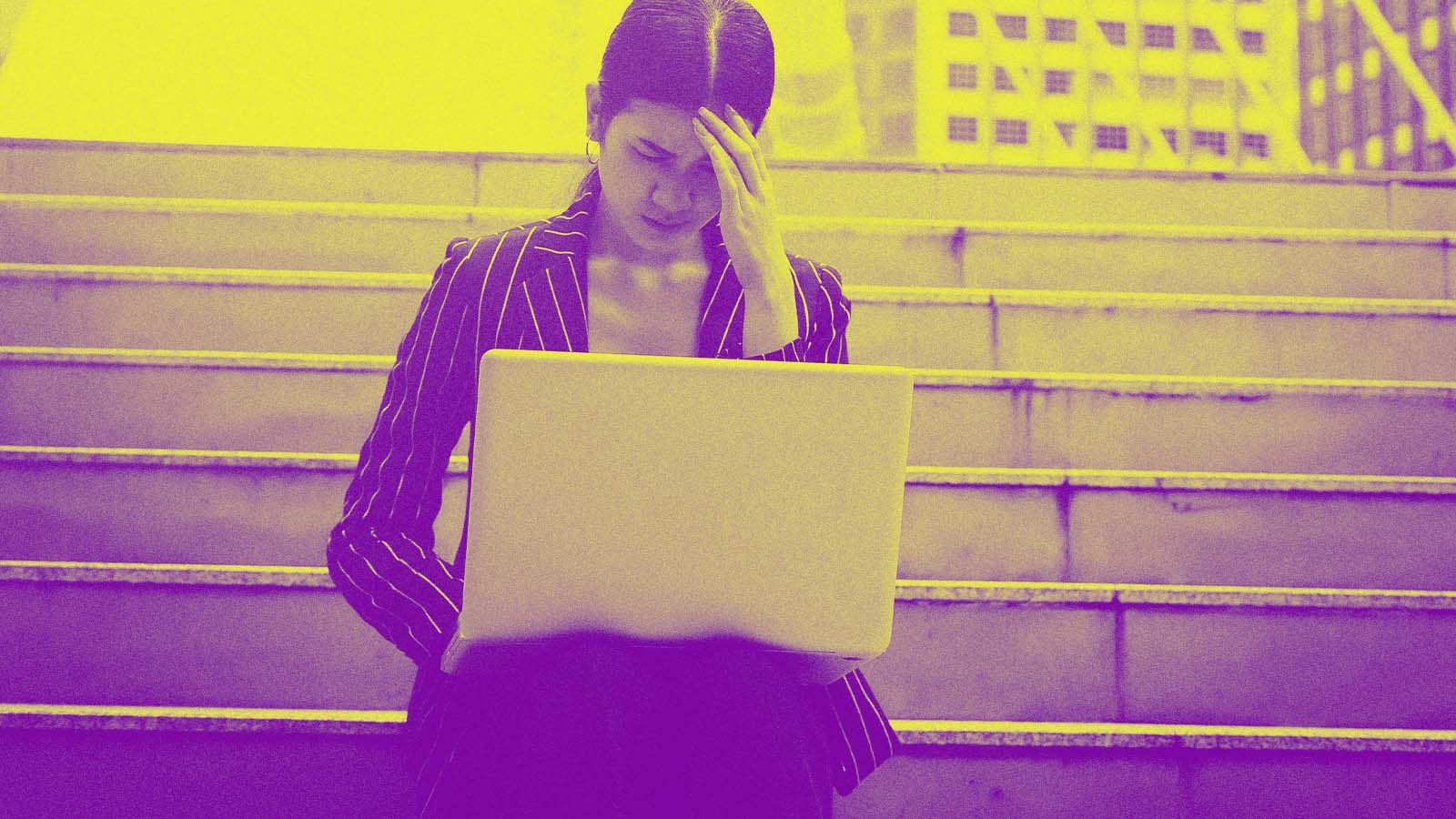

De acordo com dados recentes da Sift, 31% dos usuários admitem já ter usado informações pessoais ou sensíveis em ferramentas de IA generativa como o ChatGPT. Entre eles, 14% confessam ter compartilhado segredos comerciais da empresa.

Outros tipos de dados que os usuários dizem ter compartilhado com chatbots incluem informações financeiras, conteúdos não públicos, e-mails, números de telefone e dados corporativos. Na prática, isso mostra que as pessoas estão cada vez mais confortáveis – talvez até demais – em dividir informações delicadas com sistemas de IA.

Essa confiança exagerada não se limita ao ambiente de trabalho. A mesma falta de preocupação que leva alguém a compartilhar dados sensíveis com um chatbot também os torna mais vulneráveis a deepfakes e golpes com inteligência artificial no dia a dia.

Os dados da Sift mostram que, embora a preocupação com fraudes envolvendo IA tenha caído 18% no último ano, o número de vítimas desse tipo de golpe aumentou 62% desde 2024.

Seja ao vazar informações sigilosas no trabalho ou ao cair em um golpe fora dele, o padrão é o mesmo: quanto mais familiaridade com a inteligência artificial, maiores os pontos cegos.

No dia a dia das empresas, os funcionários recorrem à IA para resolver questões específicas: buscar ideias para uma proposta comercial, reescrever um e-mail interno para torná-lo mais conveniente, ajustar o tom de um texto de marketing ou até inserir detalhes de roadmaps de produto em conversas com chatbots de atendimento.

O QUE AS EMPRESAS PODEM FAZER?

O grande problema é que esse tipo de exposição de dados muitas vezes passa despercebido pelas ferramentas tradicionais de monitoramento. Como as IAs normalmente são acessadas fora da rede interna, os funcionários têm liberdade para inserir praticamente qualquer informação à qual tenham acesso.

Na prática, é bem provável que você não saiba exatamente que tipo de dado sensível está sendo compartilhado nessas plataformas. Diferente de um ataque de phishing, que pode ser rastreado, o uso da inteligência artificial costuma acontecer de forma discreta, muitas vezes em contas pessoais. Mas isso não significa que a solução seja proibir a tecnologia.

o número de vítimas de golpes com IA aumentou 62% desde 2024.

Uma abordagem mais eficiente é tentar entender a real dimensão do problema com pesquisas anônimas entre os funcionários. Pergunte: quais ferramentas de IA você tem usado? Para quais tarefas elas têm sido mais úteis? O que você gostaria que essas ferramentas pudessem fazer?

Mesmo que ninguém admita compartilhar dados sensíveis, entender como a inteligência artificial está sendo usada pela equipe ajuda a identificar riscos – e também oportunidades.

O foco, nesse caso, deve ser a prevenção. Proibir o uso da IA de forma geral não é viável e pode até colocar a empresa em desvantagem. O ideal é estabelecer diretrizes claras, que deixem bem evidente o que pode e o que não pode ser compartilhado.

Crie regras objetivas: dados de clientes, informações financeiras, contratos, documentos internos e termos legais não devem ser inseridos em ferramentas de IA generativa. Essas diretrizes precisam ser práticas, não baseadas no medo.

Para incentivar o uso seguro da tecnologia, ofereça alternativas seguras. Crie fluxos de trabalho aprovados para os casos de uso mais comuns, utilizando plataformas que não armazenam dados ou que não os utilizam para treinar seus modelos.

TI AJUDA A GARANTIR A SEGURANÇA DA IA

Garanta que a equipe de TI avalie todas as ferramentas de IA com base em critérios claros de governança de dados. Isso é essencial, já que diferentes tipos de conta podem seguir políticas distintas de armazenamento e uso de informações. Esse processo também ajuda a conscientizar os funcionários sobre os riscos envolvidos.

Promova treinamentos que abordem os perigos da IA tanto no ambiente corporativo quanto na vida pessoal. Mostre exemplos reais de como interações aparentemente inofensivas podem vazar informações confidenciais e oriente os funcionários sobre golpes com inteligência artificial que eles podem sofrer fora da empresa.

O ideal é estabelecer diretrizes que deixem bem claro o que pode e o que não pode ser compartilhado.

A mesma confiança excessiva que pode levar a vazamentos também pode transformar os funcionários em alvos fáceis de fraudes sofisticadas, colocando em risco sua segurança e da empresa.

A IA tem potencial para impulsionar a produtividade como poucas outras tecnologias. Mas isso não significa que seu uso seja livre de riscos. Empresas que enfrentarem esse desafio de frente conseguirão aproveitar os benefícios da tecnologia sem comprometer seus dados mais valiosos.

O segredo está em reconhecer que o excesso de confiança na inteligência artificial pode ser perigoso – tanto dentro quanto fora do escritório – e agir desde já para se proteger, garantindo a segurança da IA.