Estas ferramentas ajudam artistas a blindar seus trabalhos da garimpagem da IA

Ferramentas como Glaze e Nightshade buscam confundir os modelos de IA, mas especialistas alertam: talvez nenhum sistema de proteção seja totalmente eficaz

A arte gerada por inteligência artificial tem enfrentado uma forte oposição, especialmente diante do medo de que criativos humanos sejam substituídos. A chamada “aversão ao algoritmo” – a rejeição a obras criadas por máquinas – só cresce, e hoje apenas 20% dos adultos nos EUA acreditam que a IA terá um impacto positivo na arte e no entretenimento.

Os artistas estão entre os críticos mais contundentes. Não apenas porque a tecnologia já está ameaçando sua renda ao suprir demandas antes atendidas por profissionais, mas também porque muitos modelos podem ter sido treinados justamente com as criações deles.

A capacidade da IA de imitar e manipular imagens com precisão levanta sérias questões sobre violação de direitos autorais, como explica Phillip Rieger, pesquisador da Universidade Técnica de Darmstadt, na Alemanha.

Como resposta, alguns artistas estão recorrendo à Justiça, alegando que as empresas de IA estariam violando leis de propriedade intelectual ao treinar modelos com obras protegidas. Outros estão apostando em ferramentas digitais para tentar proteger seus trabalhos. Mas, segundo especialistas, essas obras ainda continuam vulneráveis – mais do que muitos imaginam.

Geradores como Midjourney e DALL-E são treinados com milhões de imagens. Esse imenso banco de dados permite aos modelos replicar estilos com uma precisão impressionante, tornando cada vez mais difícil distinguir o que foi feito por IA do que foi feito por pessoas.

As empresas se apoiam no conceito de “fair use” (uso justo), que permite utilizar materiais protegidos sem autorização em alguns contextos – como para fins não comerciais ou quando não prejudicam o valor da obra original. Para especialistas, essa justificativa não se sustenta.

“Esses modelos estão sendo treinados com o trabalho de todos, sem autorização”, afirma Kevin Madigan, vice-presidente sênior da Copyright Alliance, grupo que representa detentores de direitos autorais.

Algumas empresas, como a OpenAI, se defendem dizendo que oferecem aos artistas a opção de retirar suas obras do conjunto de treinamento. Mas, para muitos, isso está longe de ser suficiente.

FERRAMENTAS PARA PROTEGER O TRABALHO DOS ARTISTAS

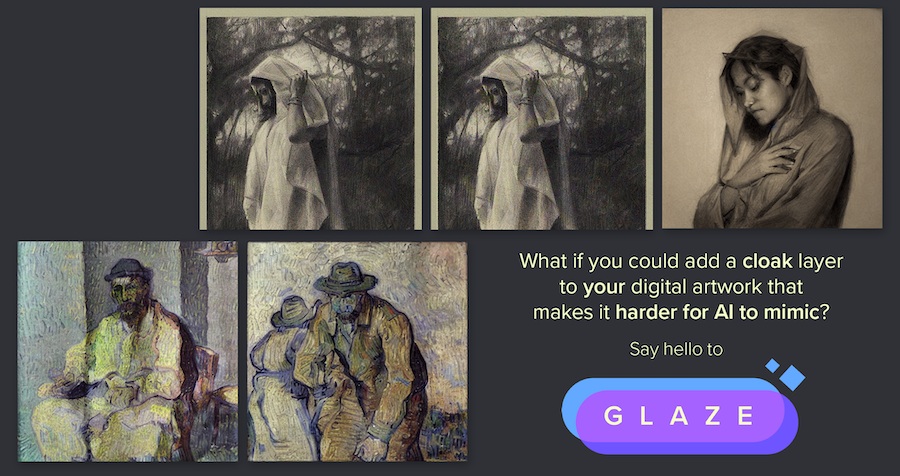

Como é praticamente impossível remover obras já incluídas, alguns artistas tentam impedir o acesso desde o início. É aí que entram ferramentas como as do Glaze Project, da Universidade de Chicago, que “envenenam” imagens, alterando pixels de forma imperceptível ao olho humano, mas o bastante para confundir os modelos de IA.

Uma dessas soluções, chamada Nightshade, faz com que o sistema interprete imagens de forma equivocada – por exemplo, vendo uma bolsa onde há uma vaca. Já o Glaze altera o estilo, levando a máquina a interpretar um retrato em carvão como uma pintura de Jackson Pollock.

Essas técnicas buscam proteger obras já incluídas em conjuntos de dados de treinamento. Outras soluções, como o arquivo robots.txt, atuam de forma preventiva, indicando a robôs que varrem a internet os conteúdos que não devem ser coletados.

Todas essas estratégias, no entanto, têm limitações. O robots.txt, por exemplo, apesar de conseguir bloquear robôs de coleta, também impede que o conteúdo seja indexado em buscadores, reduzindo a visibilidade do artista.

MODELOS APRENDEM A DRIBLAR FERRAMENTAS

Mesmo os “venenos” digitais não são infalíveis. Pesquisadores de segurança criaram a ferramenta LightShed, que mostrou como essas defesas podem ser revertidas.

A equipe analisou como os programas alteravam as imagens e identificou padrões consistentes, então treinou um modelo para reconhecê-los. Ao comparar versões originais e “envenenadas” das mesmas imagens, conseguiram desfazer as alterações.

“O processo pode variar de imagem para imagem, mas segue sempre o mesmo padrão”, explica Hanna Foerster, que trabalhou no LightShed durante seu estágio na Universidade Técnica de Darmstadt.

A capacidade da IA de imitar e manipular imagens levanta sérias questões sobre violação de direitos autorais.

Os pesquisadores afirmam não querer prejudicar artistas nem sabotar ferramentas de proteção. “Nossa intenção foi mostrar a necessidade de defesas mais robustas e alertar que não se deve confiar cegamente nessas soluções”, diz Rieger.

O LightShed está disponível apenas para pesquisa, mas a equipe espera que ele inspire sistemas de proteção mais fortes contra a coleta e manipulação de dados por IA.

“Estamos agindo de forma transparente e avisando sobre as vulnerabilidades, já que pessoas mal-intencionadas certamente não fariam isso”, conclui Rieger. Segundo ele, os criadores das ferramentas foram notificados das falhas, e a expectativa é que os próprios artistas usem essas informações para repensar como proteger suas obras.

O FUTURO DA PROTEÇÃO CONTRA IA

Pesquisadores afirmam que criar uma defesa infalível contra modelos de inteligência artificial pode ser praticamente impossível, especialmente à medida que os sistemas de geração de imagens ficam mais sofisticados.

Para barrar ferramentas como o LightShed, os chamados “venenos de imagem” teriam de ser muito mais aleatórios, mas com isso haveria o risco de tornar a imagem irreconhecível para os próprios humanos.

Outras abordagens, como a marca d’água criptográfica, poderiam ajudar artistas a detectar quando suas obras são usadas em conteúdos gerados por IA. Mas, segundo Foerster, “é definitivamente um problema muito difícil”.

Além das soluções técnicas, alguns especialistas defendem que a resposta real está na regulação. Para Madigan, proteger os artistas exigirá legislação e ações judiciais que obriguem as empresas de IA a serem transparentes sobre suas práticas de treinamento.

Mesmo diante desses desafios, especialistas reforçam que os artistas não devem perder a esperança. O cenário em torno da IA evolui rapidamente, e os esforços para se defender de seus riscos também. “Ficar atento a essas questões ajuda a fortalecer toda a comunidade de artistas”, conclui Madigan.