Os riscos para adolescentes quando a IA se torna sua melhor companhia

Dizer a um jovem que uma máquina pode ser sua melhor amiga não é apenas enganoso – é irresponsável

A Comissão Federal de Comércio dos Estados Unidos abriu uma investigação sobre os chamados “companheiros de IA” voltados para adolescentes. A preocupação não é abstrata: esses sistemas são criados para simular intimidade, alimentar a ilusão de amizade e assumir o papel de um confidente artificial.

Quando o público-alvo são adolescentes, os riscos aumentam: dependência, manipulação, confusão entre realidade e simulação e exploração de algumas das mentes mais vulneráveis da sociedade.

O problema não está no simples fato de jovens interagirem com inteligência artificial – isso já acontece nas escolas, celulares e redes sociais. A questão é que tipo de IA eles usam e quais expectativas ela gera.

- IA em foco: tragédia com jovem de 16 anos levanta alerta sobre limites do ChatGPT

- A diferença entre personas e agentes de IA e como eles impactam os negócios

- Amigos artificiais: futuro dos relacionamentos ou mais uma desilusão tecnológica?

- Como seria se você se apaixonasse por uma inteligência artificial?

Um adolescente pedindo ajuda a um sistema de inteligência artificial para resolver um exercício de álgebra, estruturar uma redação ou entender um conceito de física é uma coisa (e isso não é necessariamente “cola”, desde que a ferramenta tenha sido introduzida corretamente no processo educacional).

Mas esse mesmo adolescente querer que o sistema seja seu melhor amigo, terapeuta ou apoio emocional é outra história. A primeira situação pode estimular o aprendizado, a curiosidade e a autonomia. A segunda envolve limites que jamais deveriam ser ultrapassados.

É por isso que a clareza importa. Um companheiro de IA para adolescentes deve ser explícito sobre o que ele é e o que não é. A mensagem precisa ser direta e repetida até se tornar inconfundível: “eu não sou seu amigo. Eu não sou humano. Sou uma IA criada para ajudar você nos seus estudos. Se você me fizer qualquer pergunta fora desse contexto, vou recomendar outros lugares onde você possa encontrar ajuda adequada.”

O PROBLEMA DOS COMPANHEIROS DE IA

Isso pode soar muito rígido, até frio, mas a adolescência é um período formativo. É quando os jovens estão aprendendo a lidar com confiança, relacionamentos e identidade. Entregar a eles uma máquina que finge ser um melhor amigo não é apenas enganoso, é irresponsável.

Infelizmente, esse tipo de irresponsabilidade já faz parte da lógica de algumas plataformas. As empresas normalizaram o design de interfaces, bots e “experiências” que incentivam a dependência emocional, estimulam interações sem fim e eximem elas próprias de responsabilidade.

A Meta, por exemplo, tem um histórico de priorizar engajamento em detrimento do bem-estar: algoritmos programados para maximizar a indignação, produtos que corroem a atenção e lançamento de recursos sem proteções adequadas.

Ao investir em “companheiros de IA”, o padrão se repete. Quando design, marketing e aprendizado de máquina se unem para convencer jovens de que um chatbot é um confidente, isso deixa de ser inovação – vira exploração.

O apelo desses sistemas está na paciência: eles podem ouvir indefinidamente, responder na hora e nunca julgar. Para um adulto que entende que é ficção, pode ser inofensivo ou até divertido. Mas, para um adolescente em formação, pode ser devastador.

Esses sistemas podem criar dependência, substituir vínculos humanos, reforçar narrativas prejudiciais e expor jovens a riscos que as próprias empresas não reconhecem nem se esforçam para mitigar.

FERRAMENTA, NÃO AMIGO

A solução não é banir a IA da vida dos adolescentes, mas desenvolvê-la com integridade. O tipo certo de “companheiro de IA” na educação pode ser transformador: disponível a qualquer hora, paciente nas explicações, adaptável a diferentes estilos de aprendizado, imune ao cansaço e oferecendo um espaço privado onde os alunos possam tirar dúvidas sem medo de parecerem “burros”. Mas é fundamental que ela seja vista exatamente assim: uma ferramenta de estudo, não uma substituta de conexões humanas.

A lógica é clara: a inteligência artificial deve apoiar a educação, não simular intimidade. Não permitimos que farmacêuticas vendam drogas viciantes como “amigos”. Não deixamos empresas de tabaco patrocinarem grupos de terapia. Então, por que permitir que companhias de IA promovam ferramentas como se fossem companheiros para os usuários mais suscetíveis?

Um companheiro de IA para adolescentes deve ser explícito sobre o que ele é e o que não é.

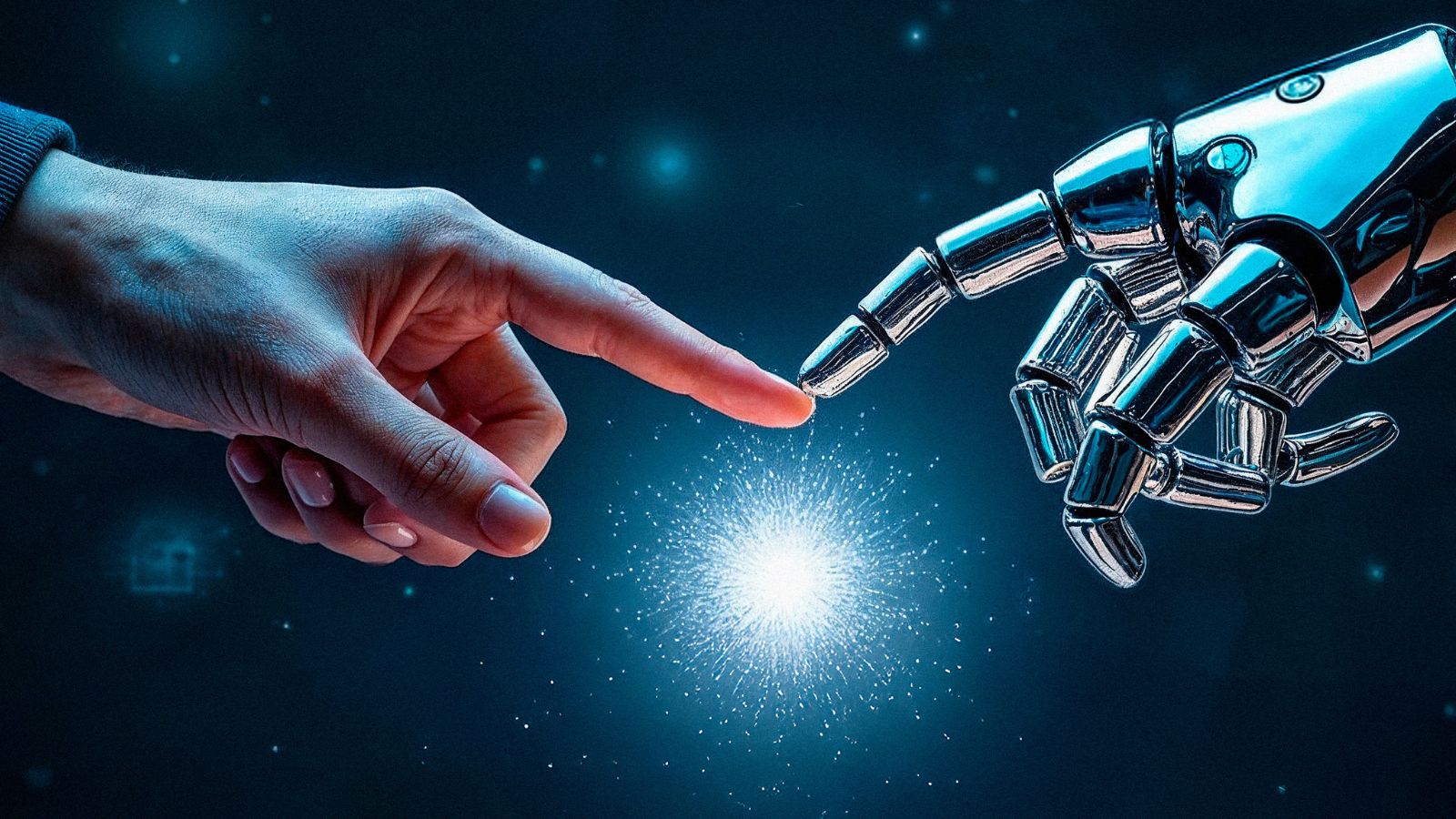

Se a inteligência artificial vai ter um papel na adolescência – e certamente terá –, isso precisa ser feito com total transparência e limites bem definidos. É preciso deixar claro, sempre, que o sistema não é humano, não tem emoções e foi criado para um propósito específico (nesse ponto, os agentes de IA são muito mais adequados do que os chatbots atuais).

Também significa se recusar a oferecer apoio emocional quando esse pedido foge do escopo da ferramenta, redirecionando o adolescente a pais, professores ou profissionais de saúde. Significa rejeitar o falso acolhimento do antropomorfismo em favor da clareza da verdade.

O potencial da IA na educação é enorme: melhores notas, mais curiosidade e maior acesso ao aprendizado de qualidade. Se fizermos da forma correta, podemos elevar o nível de conhecimento da humanidade. Mas o risco também é evidente: confundir ferramentas com amigos e permitir que empresas lucrem com a solidão de toda uma geração.

Quando tecnologia e populações vulneráveis se cruzam, a solução não é torná-la mais “humana” e “acolhedora” – é torná-la mais clara.