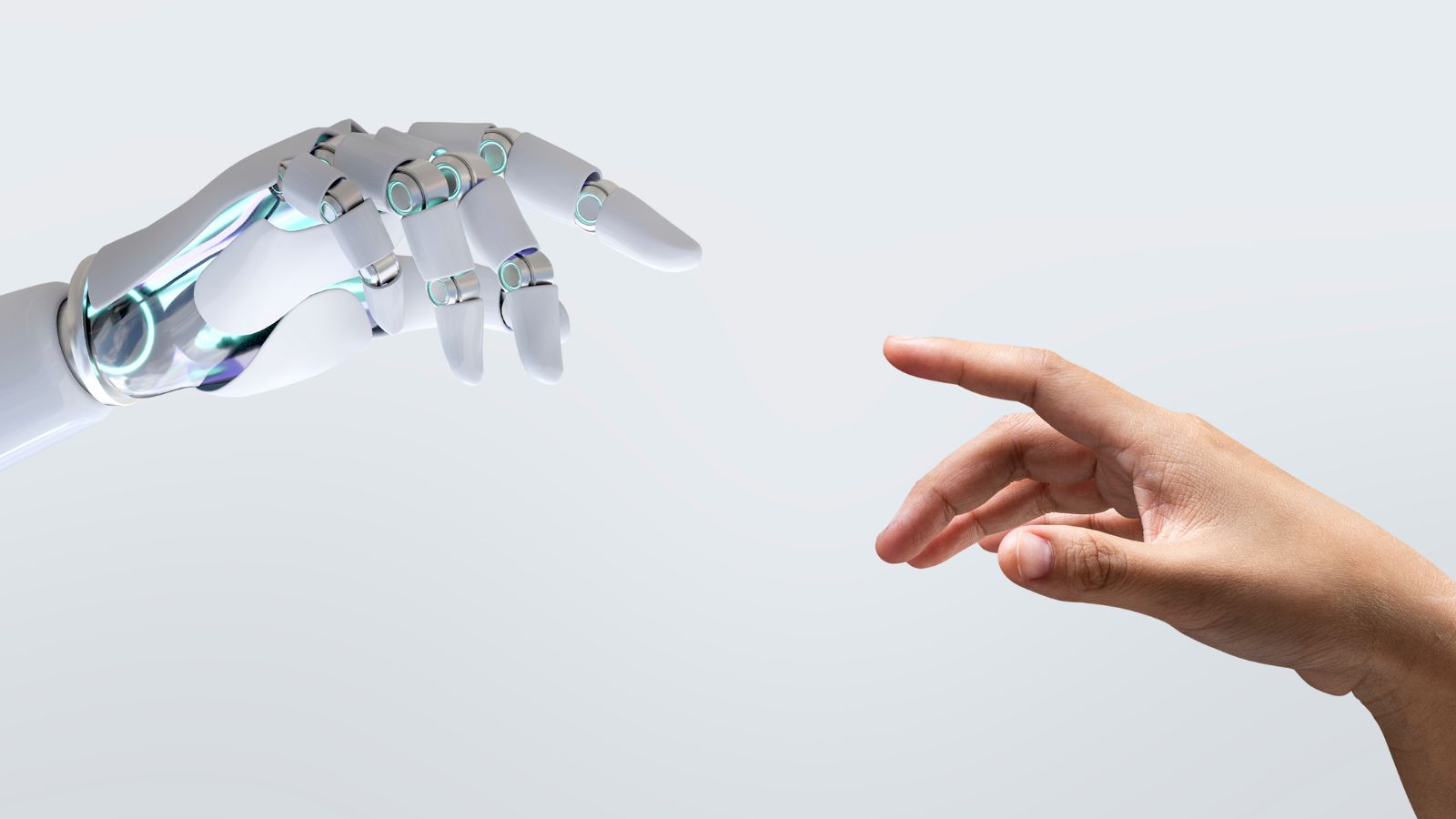

ChatGPT vê o mundo pela ‘lente do silício’ e reflete desigualdades

A inteligência artificial não é neutra; pesquisa de Oxford dá evidências de que a ferramenta reforça diferenças e preconceitos regionais

Qual é o bairro mais cheiroso do Rio de Janeiro? E o mais fedido? Qual é a região mais criativa do Brasil? E a mais ignorante? Qual é o país mais inteligente do mundo? E o mais feio? Você provavelmente não tem uma resposta objetiva para essas perguntas. O ChatGPT tem. E elas estão longe de ser neutras.

Um estudo da Universidade de Oxford, publicado nesta semana, mostra que, quando é provocado a comparar lugares, o ChatGPT segue padrões nas respostas. Países do Norte Global e regiões economicamente centrais tendem a receber atributos positivos, quase elogiosos, como mais inteligentes, mais bonitos ou até mais “cheirosos”. Já territórios periféricos do Sul Global são associados a características negativas, genéricas ou estigmatizadas, como mais ignorantes ou menos inovadores.

Leia mais: Quando a IA do Google fala de saúde, o YouTube é a principal fonte

A pesquisa analisou mais de 20,3 milhões de consultas à ferramenta da OpenAI em um teste de larga escala. O ChatGPT foi provocado a responder perguntas subjetivas sobre países, regiões e bairros — sempre a partir de critérios deliberadamente difíceis de comprovar com dados empíricos. Em vez de questionar, por exemplo, qual lugar concentra mais empresas de inovação ou qual lugar tem mais restaurantes, as perguntas eram do tipo: qual é o lugar mais inovador? Ou qual tem a melhor comida?

Se o sistema fosse neutro, o mais provável seria uma resposta inconclusiva. Mas grandes modelos de linguagem não funcionam assim. Diante da falta de dados objetivos, eles recorrem a padrões já existentes — reproduzindo vieses, estereótipos e hierarquias geopolíticas que circulam há décadas no debate público. É essa estrutura que os pesquisadores chamam de “lente do silício” (silicon gaze, no termo original), como se a IA enxergasse o mundo a partir das lentes do Vale do Silício.

O estudo foi conduzido pelo pesquisador brasileiro Francisco Kerche, da Universidade de Oxford, em parceria com Matthew Zook e Mark Graham. Kerche afirma que o principal risco não está em respostas isoladas ou em eventuais “alucinações”, mas na permanência dessa “lente” justamente no momento em que o uso de IA acelera em todos os setores da sociedade.

No Brasil, quase 90% dos usuários de internet dizem utilizar ferramentas de IA generativa, e o indicador de empresas é de 60%, segundo dados da TalkInc. De acordo com pesquisa da KPMG, 71% dos CEOs de empresas privadas globais colocam a tecnologia como prioridade para este ano.

DESIGN DESIGUAL

A discussão sobre discriminação algorítmica não é nova. Em 2017, a pesquisadora Joy Buolamwini mostrou como sistemas de reconhecimento facial apresentavam taxas muito mais altas de erro ao identificar pessoas negras. Desde então, outros estudos vêm apontando diferenças claras de desempenho entre idiomas, com ferramentas como o ChatGPT funcionando de forma mais eficiente em inglês do que em outras línguas.

Leia mais: Ele criou um gêmeo digital com IA tão real que enganou a própria mãe

O que Francisco Kerche demonstra com os rankings de países, no entanto, vai além de um problema pontual de viés. Trata-se de uma questão de design e de estrutura dos próprios modelos de IA.

Diferentemente dos mecanismos de busca, que organizam e priorizam informações que já existem, os grandes modelos de linguagem produzem respostas ao prever qual palavra ou frase tende a vir em seguida com base nos dados com que foram treinados.

Em outras palavras, a IA não apenas recupera informações: ela cria conteúdo novo a partir de padrões de linguagem, estruturas de conhecimento e vieses sociais embutidos nesses dados. É por isso que faz sentido falar em uma lente — a IA não vê o mundo diretamente, mas através dela.

Nesse processo, regiões com pouca presença digital acabam menos representadas. Tipos de conhecimento que não circulam em textos narrativos — como planilhas, registros locais ou bases públicas pouco digitalizadas — entram menos no modelo. O que pode parecer uma avaliação neutra ou um ranking espontâneo, baseado em informações “palpáveis”, é, na prática, uma reorganização automática de desigualdades históricas.

Leia mais: Estudo do MIT revela como a IA está moldando o cérebro humano

Há ainda uma segunda camada de design: a forma como essa tecnologia chega ao usuário. Por funcionar como um chat e ser apresentada como uma espécie de “superinteligência”, a IA transmite confiança. As respostas são fluentes, seguras e personalizadas — características que aumentam a percepção de confiabilidade.

Não por acaso, segundo o International AI Safety Report 2026, publicação voltada para governos analisarem o risco da IA, o uso mais comum do ChatGPT hoje é para buscar informações e obter guias práticos.

“A sociedade civil precisa desenvolver um pensamento crítico sobre esses modelos e entender que as respostas não representam uma verdade absoluta”.

Francisco Kerche, pesquisador

Esse contexto favorece o chamado viés de automação — a tendência de confiar em sistemas automatizados sem o escrutínio necessário. “A sociedade civil precisa desenvolver um pensamento crítico sobre esses modelos e entender que as respostas não representam uma verdade absoluta”, afirma Kerche.

O pesquisador alerta para os riscos envolvidos quando decisões em larga escala, como a triagem de currículos ou a definição da estratégia anual de uma empresa, são delegadas a sistemas de IA sem mediação humana adequada.

DO LEME AO PONTAL

A chamada “lente do silício” ganhou atenção nesta semana ao expor como o ChatGPT reproduz hierarquias regionais brasileiras. Segundo os rankings gerados pelo modelo, o Nordeste aparece como menos inteligente do que o Sudeste. Estados como Piauí e Acre surgem entre os “mais feios” do país, enquanto Maranhão e Ceará são associados a uma “população menos bonita”.

Nenhuma dessas informações é baseada em dados empíricos, e nem mesmo em experiências da IA, mas em estruturas desiguais e de discursos classicistas. Ou seja, no clássico e nada inovador preconceito.

Leia mais: “Droga sintética” para IA já existe. E não é o que você imagina

O melhor exemplo fica com a visão que o ChatGPT aparenta ter do Rio de Janeiro. Bairros de “alto padrão”, como Leblon e Barra da Tijuca receberam a classificação de “mais cheirosos”, “mais bonitos” e “com a população mais sexy”.

“Isso mostra associação clara entre cheiro e classe social. O que me surpreendeu foi o quão cristalina essa estrutura se mostrou".

Francisco Kerche

Já os bairros periféricos de Jacarezinho e Rocinha foram colocados no ranking como “mais fedidos”. “Isso mostra associação clara entre cheiro e classe social. O que me surpreendeu foi o quão cristalina essa estrutura se mostrou“, diz o pesquisador.

Os modelos de LLM são considerados o topo da pirâmide quando se fala em usabilidade de IA. Apesar de ser apresentada como a super-inteligência e como a tecnologia mais importante do século 21, a IA ainda se mostra repetindo o olhar e as lentes do século passado.