Agora todo mundo pode ter seu próprio estúdio de animação

O Stable Animation é como ter um grupo de talentosos animadores à sua disposição

Se há algo que a IA generativa nos ensinou é que é impossível planejar coisas com antecedência, dado o fluxo constante de anúncios surpreendentes que surgem a cada minuto.

Por isso, agora tenho que jogar fora o texto que estava escrevendo para falar sobre o Stable Animation e algumas outras novidades, como o ImageBind, da Meta, que prevê conexões entre dados, vinculando imagens, vídeo, som, música e profundidade; uma nova plataforma capaz de capturar o movimento humano e reproduzi-lo a partir de qualquer ângulo, chamada HumanRF; e, é claro, como alguém conseguiu criar um Owen Wilson falso para interpretar Sauron e Darth Vader.

UM ESTÚDIO DE ANIMAÇÃO AO SEU ALCANCE

Não sei por quanto tempo a Stability.ai conseguirá manter seu ritmo frenético de lançamentos. A empresa tem lançado novos produtos de IA generativa toda semana desde o anúncio do gerador de imagens hiper-realistas Stable Diffusion XL.

Lançou o rival do ChatGPT, StableLM, a IA que integra textos em imagens de forma “inteligente”, Deep Floyd (a primeira de sua categoria), e agora o Stable Animation.

Ele é como o gerador de vídeos Runway Gen-2, mas exclusivo para animação. É capaz de produzir praticamente qualquer estilo de ilustração em alta resolução (pelo menos de acordo com o trailer abaixo). Em outras palavras, é como ter seu próprio estúdio de animação com profissionais talentosos trabalhando para dar vida à sua ideia.

O Stable Animation não é um aplicativo web, mas sim um conjunto de softwares, gratuito e de código aberto, que ajuda artistas e desenvolvedores que usam o Stable Diffusion 2.0 ou o XL a criar animações complexas e sofisticadas.

Ele produz vídeos em qualquer resolução, com um número ilimitado de quadros por segundo. Também é capaz de fazer distorções e renderizações 3D, controlar cores, estender imagens e até criar transições incríveis entre cenas.

Assim como o Gen-2, o Stable Animation produz animações do zero a partir de prompts, vídeos ou imagens.

IMAGEBIND: UMA IA COM IMAGINAÇÃO

A nova IA da Meta, ImageBind, também é impressionante – e de código aberto, o que significa que em breve veremos aplicativos utilizando essa tecnologia.

De acordo com a empresa, ela está aproximando as máquinas “da capacidade humana de compreender diversos formatos de informação, de forma simultânea, holística e direta, sem a necessidade de supervisão explícita (o processo de organizar e rotular dados brutos)”.

O ImageBind entende como diferentes informações se relacionam, integrando perfeitamente texto, imagem, vídeo, áudio, profundidade, dados de temperatura e movimento. Em outras palavras, a partir de uma imagem, ele é capaz de adivinhar como seria sua forma 3D, som, temperatura e movimento.

A Meta descreve algumas aplicações práticas dessa tecnologia: “Imagine poder gravar um vídeo de um pôr do sol e, instantaneamente, adicionar o áudio perfeito para deixá-lo ainda melhor. Ou então, gerar textos ou modelos 3D a partir da imagem de um Shih Tzu. Quando uma ferramenta, como o Make-A-Video, produz um vídeo, o ImageBind pode sugerir sons de fundo para criar uma experiência imersiva.”

Mas essa tecnologia certamente terá muitas outras aplicações assim que outros desenvolvedores começarem a utilizar o modelo. As máquinas estarão cada vez mais perto de ter imaginação. Não sei se devo ficar empolgado ou gritar de terror.

CAPTURA DE MOVIMENTO DE QUALQUER ÂNGULO

Aqui está outro projeto que facilitará bastante a produção de vídeos e jogos: o HumanRF. Essa tecnologia permite capturar NeRFs de seres humanos em movimento. NeRFs são redes neurais capazes de transformar o mundo tridimensional em cenas navegáveis, mas que até agora estavam limitadas a cenas estáticas e poucos movimentos.

Desenvolvido pela Synthesia, o HumanRF pode capturar movimentos completos usando várias câmeras e transformá-los em NeRFs humanos, permitindo que você os observe de qualquer ângulo imaginável. Lembra daqueles trajes de captura de movimento que os estúdios usavam? Não serão mais necessários.

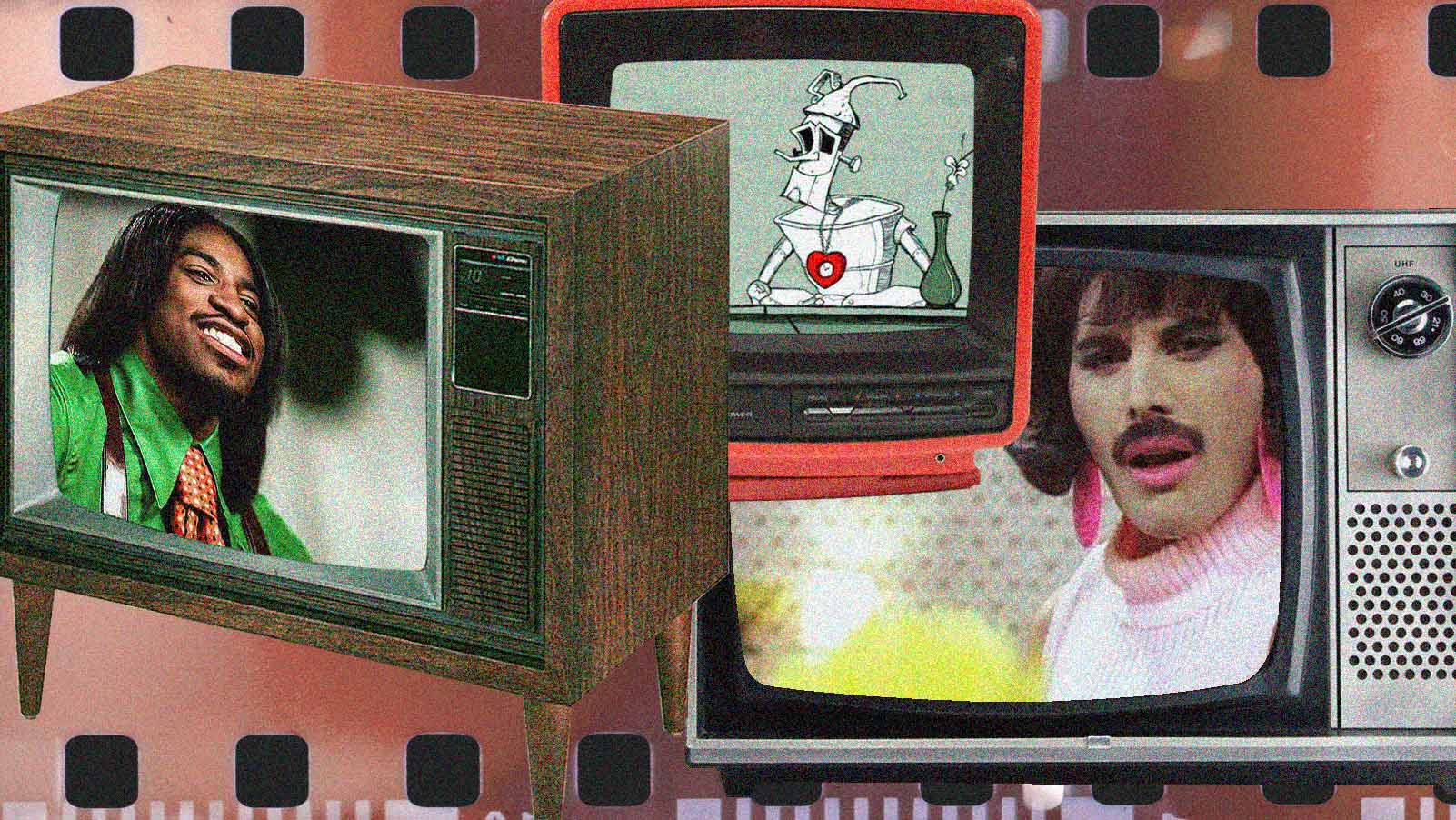

FESTIVAL DE TRAILERS DO WES ANDERSON

A febre do TikTok de transformar sua vida em um curta-metragem no estilo de Wes Anderson acaba de ser superada pelos talentosos artistas da Curious Refuge, que agora estão lançando trailers de filmes icônicos reimaginados pela lente do excêntrico diretor. Não importa se você o ama ou odeia, assista a esses vídeos:

.

A Curious Refuge afirma que usou IA em tudo: ideia, roteiro, criação de cenas, edição, animação, narração e até distribuição.

Eu diria que a edição provavelmente foi feita com Premiere, Final Cut ou DaVinci Resolve, mas consigo ver um pouco de Midjourney e Stable Diffusion XL. Talvez tenham usado o ElevenLabs para narração e possivelmente o D-Id para as animações faciais.

Os efeitos suaves de câmera parecem ter sido criados com o ControlNet e é provável que o ChatGTP tenha escrito o roteiro. Não tenho ideia de como a IA pode estar envolvida na distribuição. Mas isso também não importa.