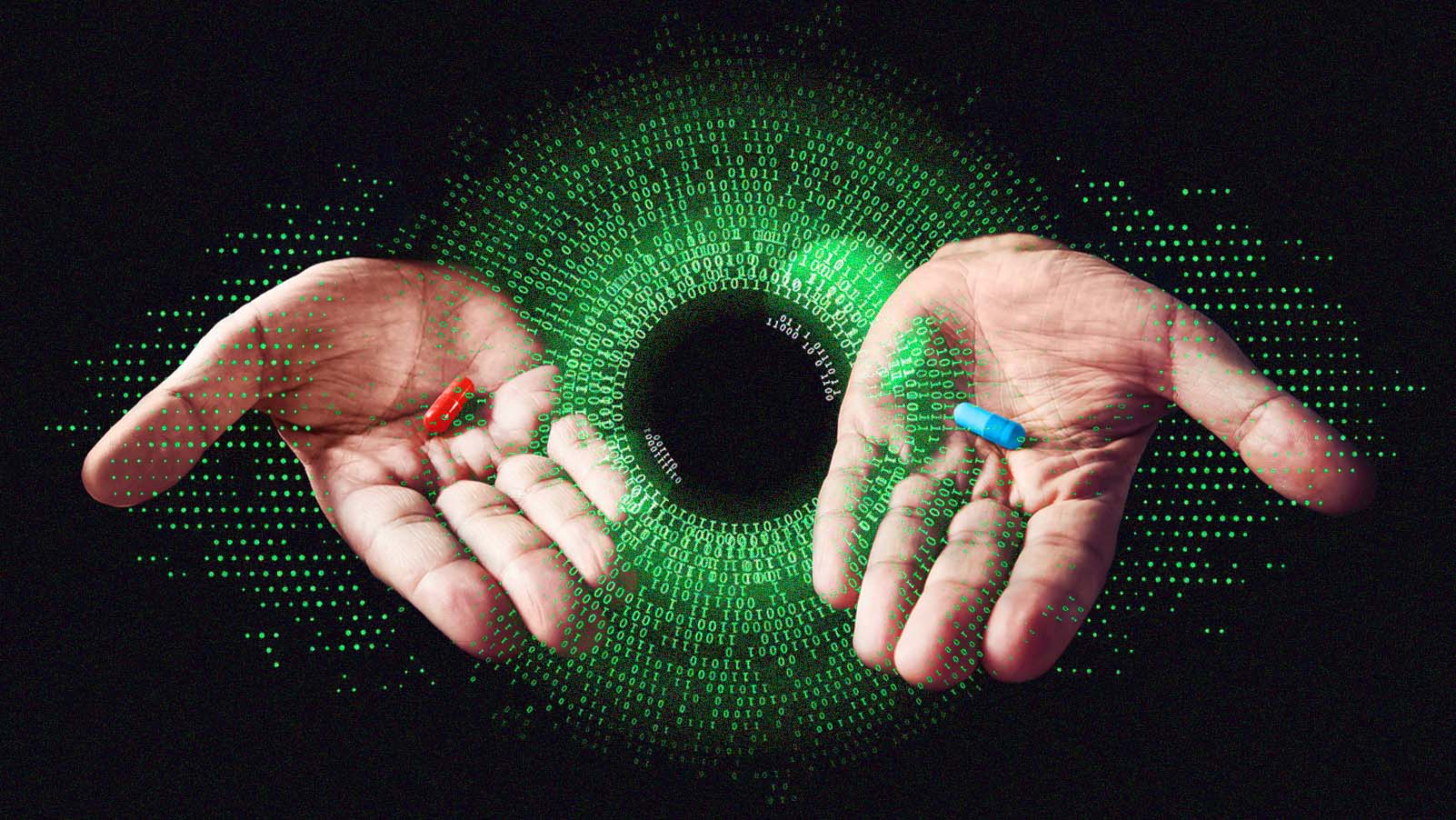

A ciência explica como os algoritmos conseguem moldar nossos pontos de vista

Os algoritmos das redes sociais são projetados para o engajamento e não para o compartilhamento de informações

Os algoritmos com os quais interagimos todos os dias quando estamos online afetam como nos comunicamos com os outros – e com consequência negativas, como erros de percepção, conflitos e compartilhamento de desinformação.

As pessoas estão cada vez mais interagindo em plataformas de redes sociais, onde os algoritmos controlam o fluxo de informação que elas recebem. Eles determinam, em parte, quais mensagens, pessoas e ideias o usuário da rede social vai ver.

Em nossa pesquisa, descobrimos que as interações diárias com algoritmos online afetam a forma como as pessoas aprendem com os outros. Nas plataformas de redes sociais, os algoritmos são projetados principalmente para ampliar as informações que sustentam o engajamento, ou seja, o conteúdo que faz com que o usuário clique no conteúdo e continue retornando às mesmas plataformas.

Sou psicólogo social, e meus colegas e eu encontramos evidências que sugerem que um efeito colateral desse modelo é que os algoritmos amplificam as informações com as quais as pessoas já estão fortemente inclinadas a interagir. Chamamos essas informações de "PRIME", sigla do inglês que engloba as informações de prestígio, de grupo, morais e emocionais.

Em nosso passado evolutivo, as tendências de aprender com informações PRIME eram muito vantajosas: aprender com gente de prestígio é eficiente porque essas pessoas são bem-sucedidas e seu comportamento pode ser copiado. Por outro lado, prestar atenção às pessoas que violam as normas morais é importante porque puni-las ajuda a comunidade a manter a cooperação.

Nas plataformas de redes sociais, os algoritmos são projetados principalmente para ampliar as informações que sustentam o engajamento.

Mas o que acontece quando as informações PRIME são amplificadas por algoritmos e algumas pessoas exploram a amplificação do algoritmo para se promoverem? O sucesso de alguém se torna um sinal insuficiente de qualidade, porque nas redes sociais esse sucesso pode ser simulado. Além disso, os feeds de notícias ficam saturados de informações negativas e moralistas, de modo que ocorre conflito em vez de cooperação.

A interação da psicologia humana e da amplificação do algoritmo leva a uma disfunção, porque a aprendizagem social apoia a cooperação e a solução de problemas, mas os algoritmos de mídia social são projetados apenas para aumentar o engajamento. Chamamos essa incompatibilidade de desalinhamento funcional.

POR QUE ISSO É IMPORTANTE

Um dos principais resultados do desalinhamento funcional na aprendizagem social mediada por algoritmos é que as pessoas começam a formar percepções incorretas a respeito de seu universo social.

os algoritmos amplificam as informações com as quais as pessoas já estão fortemente inclinadas a interagir.

Por exemplo, pesquisas recentes sugerem que, quando os algoritmos amplificam seletivamente visões políticas mais extremas, as pessoas começam a pensar que seu grupo político interno e externo está mais polarizado do que realmente está. Essa "falsa polarização" pode ser uma importante causa para o acirramento do conflito político.

O desalinhamento funcional também pode levar a uma maior disseminação de informações incorretas. Um estudo recente sugere que as pessoas que estão divulgando desinformação política aproveitam as avaliações de cunho moral e motivadas por fortes emoções – por exemplo, publicações que provocam indignação – para fazer com que o conteúdo seja mais compartilhado. Quando os algoritmos amplificam informações de cunho moral e sensível, a desinformação acaba sendo incluída nessa divulgação.

PESQUISAS EM ANDAMENTO

Em geral, as pesquisas sobre esse tema ainda estão engatinhando, mas estão surgindo novos estudos que examinam os principais componentes da aprendizagem social mediada por algoritmos. Alguns estudos demonstraram que os algoritmos de mídia social amplificam claramente as informações PRIME.

o que pode ser feito para que os algoritmos promovam a aprendizagem social de modo mais preciso, em vez de explorar preconceitos e vieses?

O fato de essa amplificação levar à polarização off-line é muito contestado no momento. Um experimento recente encontrou evidências de que o feed de notícias do Facebook aumenta a polarização, mas outro experimento que envolveu colaboração com a Meta não encontrou evidências de aumento da polarização devido à exposição ao feed algorítmico da rede social.

São necessárias mais pesquisas para entender completamente os resultados que surgem quando humanos e algoritmos interagem em ciclos de feedback de aprendizagem social.

As empresas de mídia social têm a maior parte dos dados necessários e acredito que elas devem dar acesso a eles aos pesquisadores acadêmicos e, ao mesmo tempo, equilibrar preocupações éticas, como a questão da privacidade.

O QUE VEM POR AÍ

Uma questão importante é o que pode ser feito para que os algoritmos promovam a aprendizagem social de modo mais preciso, em vez de explorar preconceitos e vieses. Nossa equipe de pesquisa está trabalhando em novos projetos de algoritmos que aumentam o engajamento e, ao mesmo tempo, punem as informações PRIME.

Nosso argumento é que isso pode manter a atividade do usuário que as plataformas de mídia social buscam, mas também tornar as percepções sociais das pessoas mais precisas.

Este artigo foi republicado do The Conversation sob licença Creative Commons. Leia o artigo original.