Especialista alerta sobre perigos de IAs desenhadas como “caixas pretas”

O campo da IA explicável trabalha para desenvolver algoritmos que os humanos sejam capazes de entender. Mas, por enquanto, estamos no escuro

Para a maioria das pessoas, o termo “caixa preta” remete aos dispositivos de gravação em aviões que são fundamentais para análises posteriores caso o impensável aconteça. Para os fotógrafos, o termo evoca a câmara escura que está na base da invenção da fotografia. Mas caixa preta também é um termo importante no mundo da inteligência artificial.

Nesse caso, as caixas pretas referem-se a sistemas de IA com funcionamento interno invisível para o usuário. Você pode alimentá-los com dados de entrada e obter dados de saída, mas não consegue averiguar o código do sistema ou a lógica que produziu tais saídas.

O aprendizado de máquina (machine learning) é o subconjunto dominante da inteligência artificial. Ele é a base de sistemas de IA generativos como ChatGPT e DALL-E 2. Existem três componentes para o aprendizado de máquina: um algoritmo ou um conjunto de algoritmos, dados de treinamento e um modelo.

Um algoritmo é um conjunto de procedimentos. No aprendizado de máquina, ele aprende a identificar padrões depois de ser treinado com um grande conjunto de exemplos – os dados de treinamento. Depois que um algoritmo de aprendizado de máquina é treinado, o resultado é um modelo de aprendizado de máquina. O que as pessoas usam é o modelo.

Por exemplo, imagine que um algoritmo de aprendizado de máquina foi projetado para identificar padrões em imagens, e os dados de treinamento são imagens de cães. O modelo de aprendizado de máquina resultante seria um identificador de cães.

Como entrada, você alimentaria a IA com uma imagem qualquer. Como saída, obteria dela uma resposta: se e onde naquela imagem algum conjunto de pixels representa um cachorro.

CAIXAS PRETAS x CAIXAS DE VIDRO

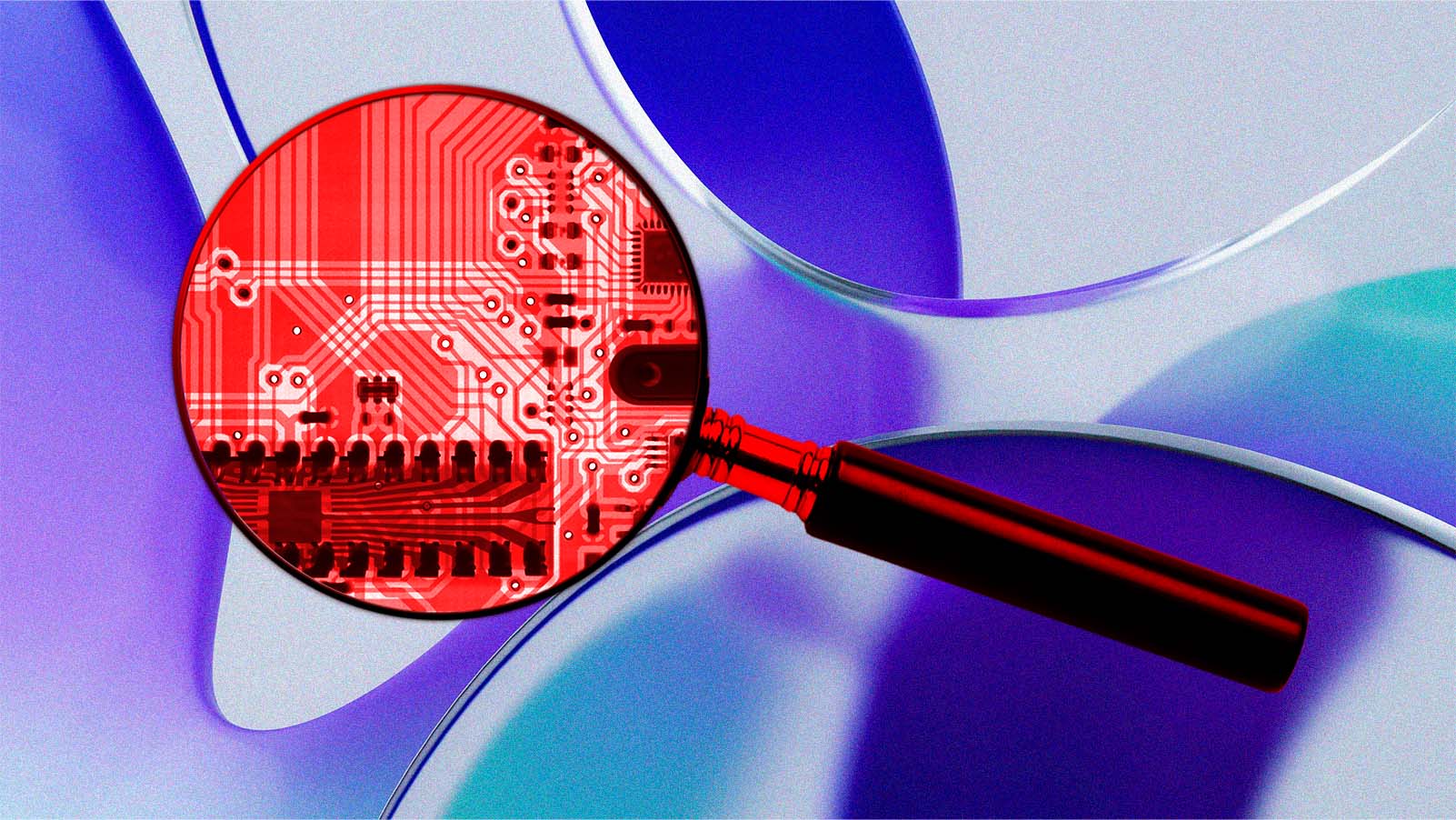

Qualquer um desses três componentes pode estar oculto. Em geral, o algoritmo é conhecido publicamente, o que torna menos eficaz e mais difícil colocá-lo em uma caixa preta. Portanto, para proteger a propriedade intelectual, o que os desenvolvedores de IA fazem é colocar o modelo em uma caixa preta.

caixas pretas referem-se a sistemas de IA com funcionamento interno invisível para o usuário.

Outra estratégia que os desenvolvedores de software adotam é ocultar quais dados foram usados para treinar aquele modelo – em outras palavras, colocar os dados de treinamento em uma caixa preta.

O oposto de uma caixa preta tem sido chamado de “caixa de vidro”. Uma IA em caixa de vidro é um sistema cujos algoritmos, dados de treinamento e modelo estão disponíveis para qualquer um ver. Mas os pesquisadores às vezes consideram que até mesmo esses sistemas são também “caixas pretas”, em alguns aspectos.

Isso ocorre porque os pesquisadores nunca entendem completamente como funcionam os algoritmos de aprendizado de máquina, particularmente os de aprendizado profundo (deep learning).

O campo da IA explicável (ou seja, sistemas de IA em que os resultados da solução podem ser entendidos por humanos) ainda está trabalhando para desenvolver algoritmos que, embora não sejam necessariamente caixas de vidro, possam ser mais bem compreendidos.

POR QUE DEVEMOS NOS PREOCUPAR

Em muitos casos, há boas razões para desconfiar de algoritmos e modelos de aprendizado de máquina de caixa preta. Suponha que um deles tenha feito um diagnóstico sobre sua saúde. Você gostaria que o modelo fosse caixa preta ou de vidro? E a médica que vai prescrever o seu tratamento? Talvez ela precise saber como o modelo chegou àquele resultado.

os pesquisadores às vezes consideram que até mesmo sistemas em caixas de vidro são também “caixas pretas”, em alguns aspectos.

E se um modelo de aprendizado de máquina determinar que você não se qualifica para um empréstimo bancário? Você não ia querer saber por quê? Se entender a lógica por trás dessa saída, a pessoa tem como recorrer da decisão com mais eficácia. Ou tentar mudar sua situação, para aumentar as chances de obter um empréstimo na próxima vez.

As caixas pretas também têm implicações importantes para a segurança do sistema de software. Durante anos, muitas pessoas no campo da computação pensaram que manter o software em uma caixa preta impediria que hackers o examinassem e que, portanto, ele seria seguro.

Essa suposição se mostrou redondamente enganada, porque os hackers são capazes de fazer engenharia reversa de software – isto é, construir um fac-símile observando de perto como um software funciona – e descobrir vulnerabilidades para explorar.

Agora, se o software estiver em uma caixa de vidro, os testadores e hackers bem-intencionados podem examiná-lo e informar os desenvolvedores sobre seus pontos fracos, minimizando assim os ataques cibernéticos.

Este artigo foi republicado do The Conversation sob uma licença Creative Commons. Leia o artigo original.