Software “envenenado” ajuda artistas a defender seus trabalhos da IA

O Nightshade oferece aos artistas uma ferramenta silenciosa para combater a violação de direitos autorais

Desde que o ChatGPT foi lançado, no final de 2022, vem provocando um frenesi de desenvolvimento de inteligência artificial. Diante disso, os artistas enfrentam um dilema. Para criar um público para seu trabalho, eles precisam divulgá-lo pela internet.

Mas, ao fazer isso, eles correm o risco de serem aproveitados por empresas de tecnologia, que treinam seus modelos de IA a partir dessas obras sem o consentimento do artista e sem a devida remuneração.

Várias ações judiciais em andamento movidas contra empresas de tecnologia alegam exatamente isso: que elas estão treinando modelos com arte protegida por direitos autorais dos artistas. Uma ação coletiva contra Midjourney, Stability AI, DeviantArt e Runway AI está pendente.

A própria OpenAI, criadora do ChatGPT, admitiu abertamente em janeiro que "seria impossível treinar os principais modelos de IA atuais sem usar materiais protegidos por direitos autorais".

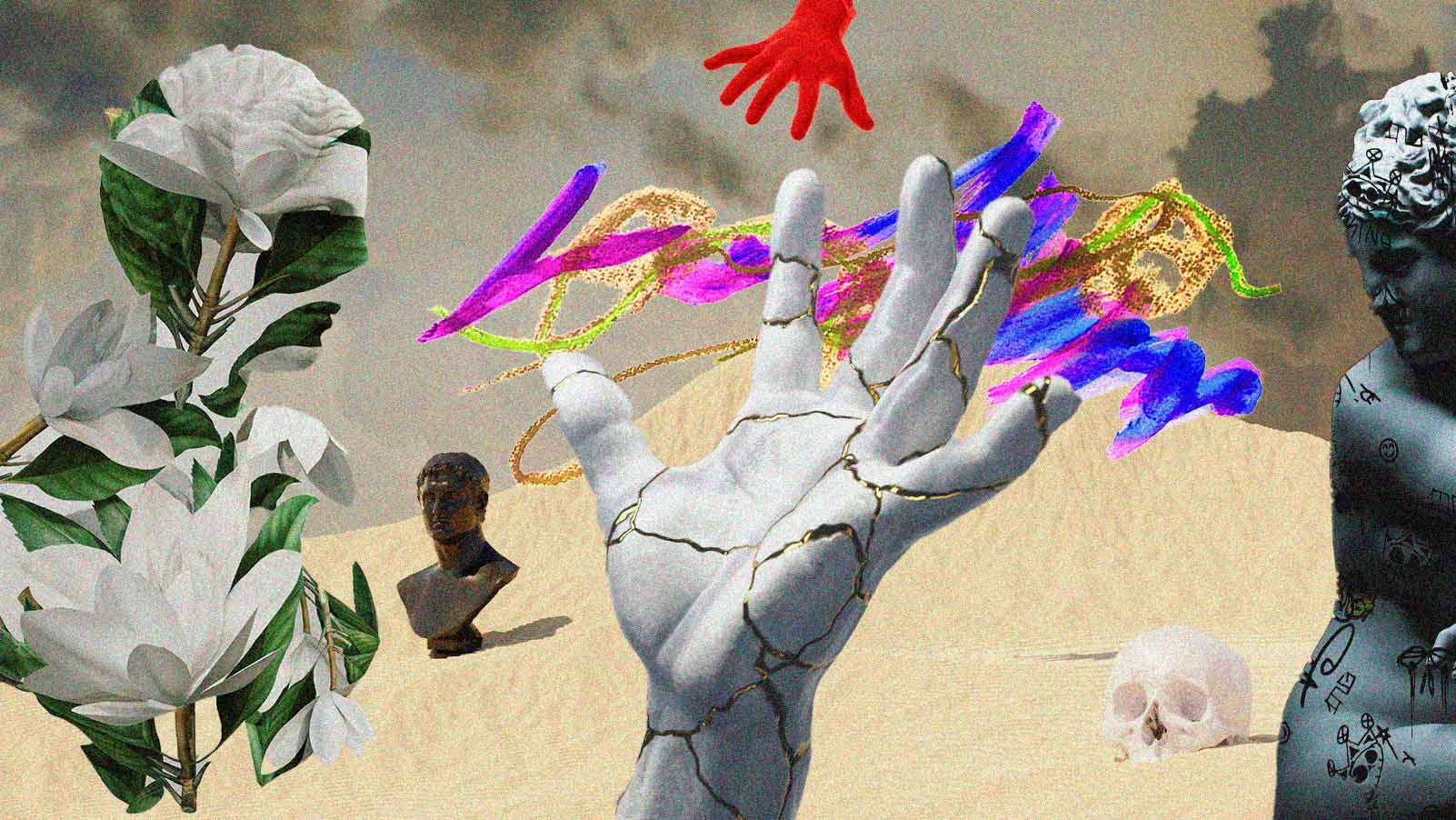

O Nightshade está trabalhando para redefinir o equilíbrio de poder. É uma ferramenta lançada em outubro de 2023 que ajuda os artistas a proteger seus trabalhos contra a extração da web. Ele atua como um agente de "envenenamento" que polui os modelos de IA, induzindo-os a treiná-los com dados incorretos.

COMO O GLAZE LEVOU AO NIGHTSHADE

A ideia da ferramenta, desenvolvida por uma equipe da Universidade de Chicago liderada pelo pesquisador de sistemas de IA Shawn Shan, surgiu a partir de uma ferramenta semelhante que ele criou chamada Glaze, que os artistas podem instalar e aplicar em seus trabalhos.

O Glaze impede que os modelos de IA de texto para imagem imitem o estilo de um artista, adicionando uma camada sobre uma obra que muda radicalmente o estilo da arte. Por exemplo, uma peça realista, quando "glazeada", pode aparecer para um modelo de IA como uma peça abstrata no estilo Pollock.

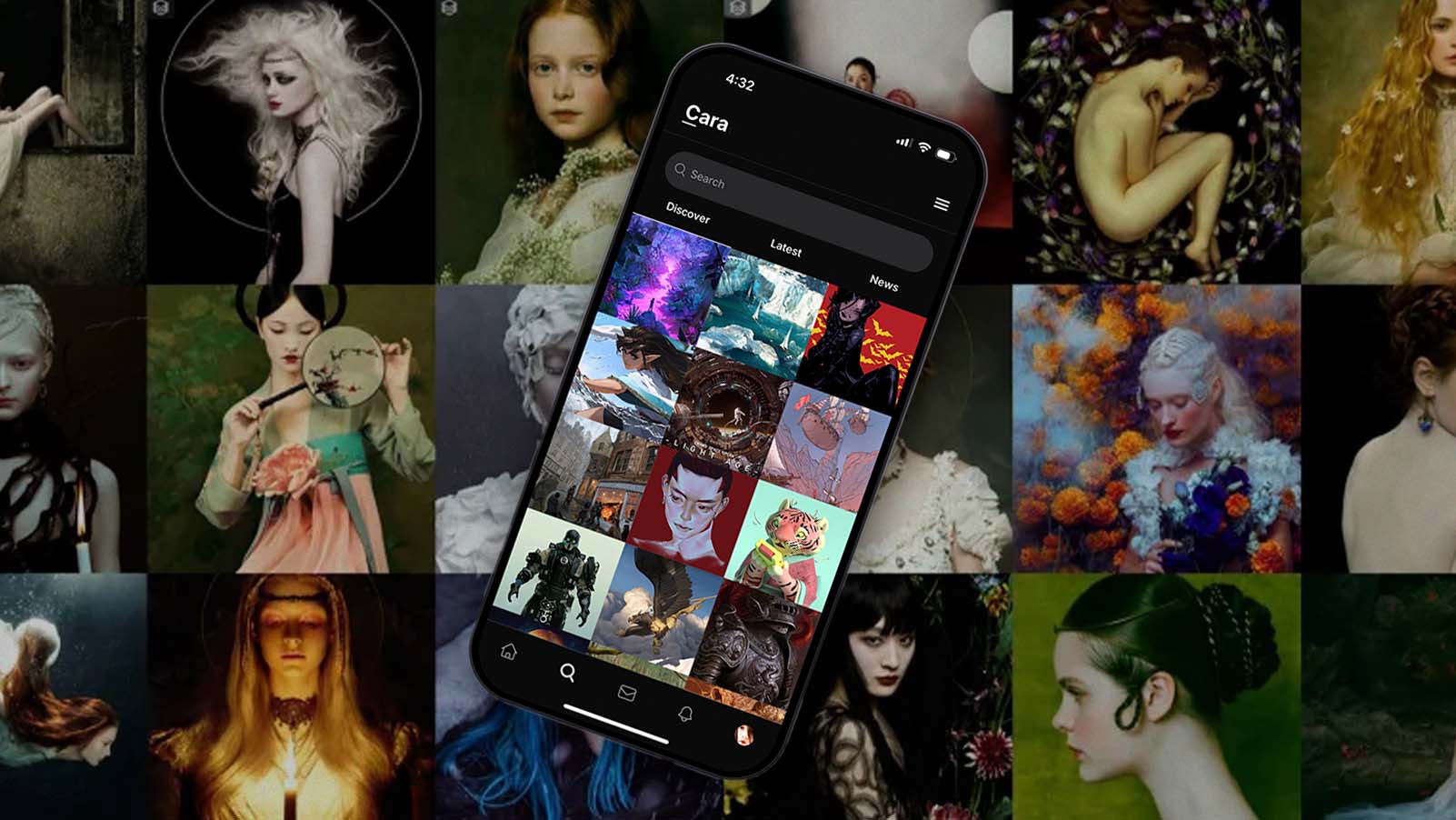

O Glaze foi lançado em 2022 e conta mais de dois milhões de downloads. Mas muitos artistas não têm um estilo de assinatura consistente que seja fácil de proteger dessa forma, e as empresas de IA nem sempre se incomodam com a passividade da ferramenta, denuncia Shan.

O Nightshade, que acumulou mais de 300 mil downloads nos primeiros meses desde seu lançamento, adota uma abordagem mais ativa. Ele impede que as empresas de IA treinem seus modelos com arte protegida por direitos autorais, transformando em armas os dados das imagens que os rastreadores encontrariam e adicionando alterações para tornar esses dados problemáticos para serem extraídos.

Quando um artista aplica o Nightshade a uma imagem de uma vaca em um campo verde, por exemplo, um modelo de IA enxerga uma imagem diferente, como uma grande bolsa de couro no campo. Se o modelo for cada vez mais treinado em imagens "shadeadas" de vacas, ele acabará se convencendo de que as vacas têm características semelhantes às de uma bolsa.

Portanto, se um usuário final de um mecanismo de pesquisa de IA solicitar que ele gere a imagem de uma vaca, ele poderá gerar uma imagem de um objeto com alças de couro e zíper, tornando o resultado impreciso.

"Se você utilizar meus dados, não só não conseguirá aprender nada, como também o desempenho do seu modelo será prejudicado do ponto de vista do modelo básico", explica Shan.

ENVOLVIMENTO DOS ARTISTAS

O Glaze e o Nightshade funcionam bem o suficiente para não afetar a aparência da arte para o espectador em geral, diz Reid Southern, artista conceitual e ilustrador de filmes, que trabalha com a equipe de Shan para testar as ferramentas.

Jon Lam, artista de storyboard, diz que usa as duas ferramentas em todas as obras que posta publicamente nas mídias sociais e na internet em geral, sendo que leva apenas alguns minutos para aplicar a ferramenta antes da postagem.

O Nightshade atua como um agente de "envenenamento" que polui os modelos de IA com dados incorretos.

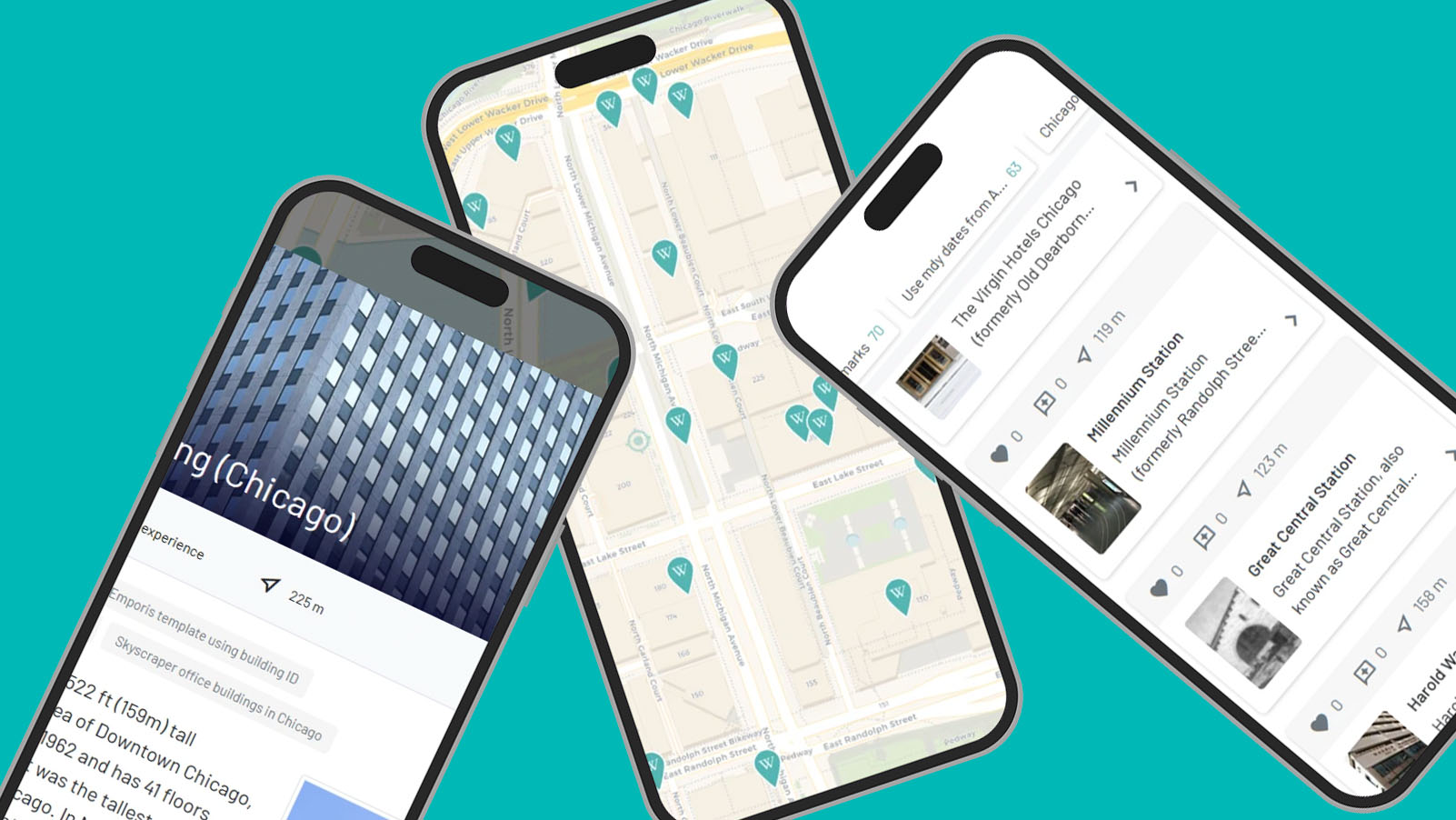

A introdução do WebGlaze, uma versão web da ferramenta de proteção, permite que os artistas apliquem o escudo protetor por celular quando estiverem longe do computador.

Shan e sua equipe de pesquisa recusaram o financiamento de capital de risco e de empresas privadas, apesar de terem sido abordados por algumas delas. Eles administram o projeto como uma organização sem fins lucrativos alimentada exclusivamente por doações.

"A maioria dessas organizações têm fins lucrativos e é a favor da IA", diz Shan. "O envolvimento desses investidores de capital de risco tornaria tudo muito mais complicado."

TRAVANDO A MAIOR BATALHA

Após a chegada, em fevereiro, do modelo de IA de texto para vídeo da OpenAI, o Sora, além das respostas ambíguas que a OpenAI deu sobre quais são seus dados de treinamento, Shan e seus colegas também estão procurando estender as proteções do Nightshade e do Glaze para vídeos e animações.

O Nightshade acumulou mais de 300 mil downloads nos primeiros meses desde seu lançamento.

Ainda assim, embora ambos ofereçam algum controle e proteção aos artistas no momento, não pretendem ser uma solução de longo prazo para o problema dos modelos de IA que se utilizam do trabalho dos artistas sem consentimento, diz Shan.

Sua equipe está trabalhando com o Escritório de Direitos Autorais dos EUA, a FTC e outros órgãos nos Estados Unidos e na União Europeia para estabelecer proteções mais amplas para os direitos dos artistas.

"Glaze e Nightshade nos devolvem um pouco do nosso poder. Sentimos que é possível fazer alguma coisa enquanto esperamos que outras pessoas façam o que é realmente certo", diz Shan.