A masculinização da inteligência artificial e o SXSW 2023

Quando os temas das palestras e painéis do festival South by Southwest foram selecionados em meados de 2022, Hugh Forrest, diretor do evento, não imaginava que em novembro do mesmo ano um sistema de inteligência artificial (IA) generativa chamado Chat-GPT se tornaria o assunto do ano – e impactaria as nossas vidas dali pra frente.

Diante do hype gerado em torno do assunto e da repentina adesão da tecnologia, não só do ChatGPT, mas de diversas outras aplicações de IA generativa, a exemplo do Dall-E-2 e do Midjourney, a organização do evento correu para editar a pauta já “fechada” e garantiu que o tema invadisse as palestras. IA generativa dominou a conversa entre os participantes. Finalmente percebeu-se o poder dessa tecnologia emergente que, até então, parecia ter lugar apenas na ficção científica.

Os sistemas de inteligência artificial são modelos estatísticos de probabilidade. Grandes modelos de linguagem (Large Language Models – LLMs) como o ChatGPT são treinados com uma enorme base de dados (big data), e se beneficiam do aumento do poder computacional, permitindo respostas cada vez mais assertivas, embora não possamos creditar confiança absoluta, já que funcionam com base em predição.

Esses sistemas ainda precisam de supervisão humana. São os humanos que selecionam as bases de dados de treinamento, aperfeiçoam os algoritmos com o processo de treinamento, e dão feedbacks com a intenção de melhorá-los. Quando o Google nos pede, por exemplo, para “confirmar” que somos humanos e clicar em todas as imagens de pontes ou extintores de incêndio, estamos treinando os seus sistemas de IA, dando feedbacks e permitindo que ele fique mais “inteligente”.

É a partir desse processo de treinamento das máquinas, feito por humanos, selecionando inputs e dando feedbacks, que decorrem os vieses algorítmicos, um dos desafios que os sistemas de IA impõem à sociedade. Sem falar na falta de transparência e na dificuldade de respeitar as leis de proteção de dados.

A discriminação decorrente dos vieses algorítmicos, tema mencionado no SXSW por palestrantes como Amy Webb, uma das maiores futuristas do mundo, e também por Ginni Rometty, ex-presidente da IBM, tem levado à masculinização da inteligência artificial.

Amy Webb relatou um caso sobre resultado de busca no Google que denota discriminação de gênero. Ela contou que fez, há anos, uma pesquisa no Google pelos termos “CEO de empresas”. Como resultado, vinham imagens de homens brancos engravatados. Mais recentemente, inserindo o prompt (frase contendo as palavras a serem pesquisadas) “CEO de startups”, como resultado apareciam apenas imagens de homens CEOs. Por fim, quando ela fez a pesquisa por “CEOs de empresas de absorventes”, item do universo feminino, ainda assim, só homens apareciam como resultado.

Em nenhuma circunstância a AI mostrou mulheres como CEOs. Esses resultados revelam a existência de vieses algorítmicos, já que os sistemas são treinados, em sua maioria, por homens. Eles ocupam mais de 70% dos cargos envolvendo programação, análise de sistemas ou desenvolvimento de softwares, segundo a Eurostat, e, por sua vez, acabam inserindo nos dados de treinamento e feedbacks, as suas crenças, pensamentos, e preconceitos arraigados.

Ginni Rometty contou a sua história como presidente da IBM. Na época, quando as pessoas pesquisavam na internet sobre o seu marido, ele aparecia nos resultados de busca como presidente da IBM e não ela – demonstrando como o viés de gênero está impregnado na sociedade e acaba sendo perpetuado pelos sistemas de IA.

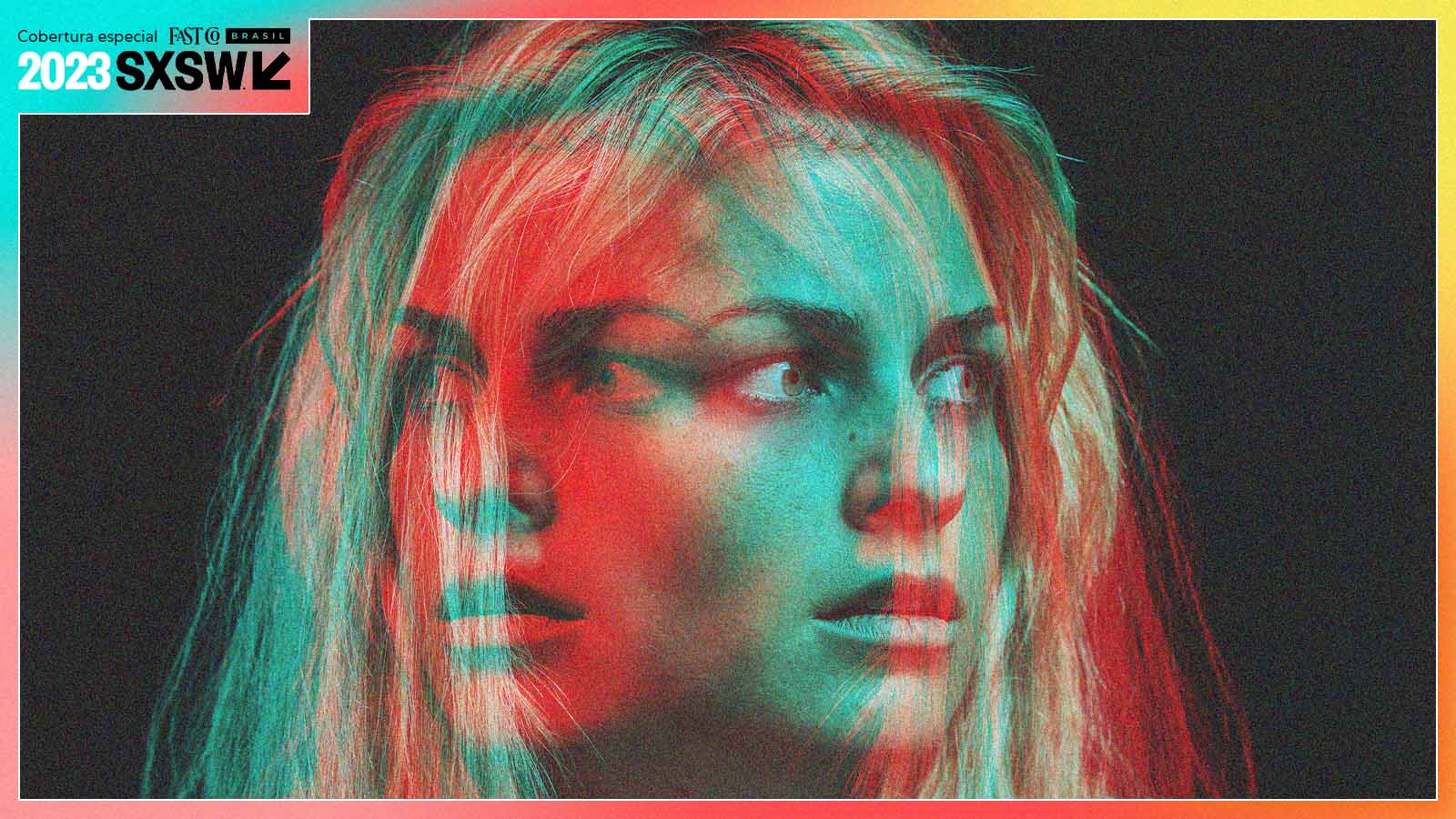

Quando pedi ao Dall-E-2 para gerar uma imagem de robô mulher em homenagem ao Dia das Mulheres, recebi como resultado imagens de robôs mulheres com sex appeal, seios grandes e cabelos lisos longos. Um padrão estético de mulher muito provavelmente imputado por homens por trás do processo de treinamento desses sistemas. Um padrão, que não faz jus à diversidade feminina, mais um reflexo da masculinização da IA.

Esses sistemas não são, de fato, inteligentes. Eles apenas repetem os humanos, aprendendo com os dados que lhes são fornecidos e identificando padrões entre eles. Se na sociedade em que vivemos hoje, estão impregnados textos que discriminam pelo gênero, é natural que as máquinas repitam esse padrão. A IA não entende que aquele conteúdo é discriminatório. Ela é apenas treinada para ser como os humanos. Como bem lembra Cathy O’Neil (2016), modelos são apenas opiniões incorporadas em algoritmos matemáticos.

Diante dessa capacidade de perpetuação de preconceitos, como o que decorre da masculinização da IA, espera-se que os sistemas evoluam de tal forma que esses padrões discriminatórios possam ser identificados e eliminados. A regulação pode ser uma grande aliada de uma IA ética e confiável, mais transparente e sem discriminação. Talvez seja utopia, já que os humanos ainda carregam preconceitos, mas podemos sonhar e trabalhar em prol de uma IA que perpetue padrões positivos para a sociedade.

Ao mesmo tempo que a IA causa espanto, ela também anima quem aposta na sua capacidade de expansão do potencial humano. Se formos capazes de enxergar a IA como ferramenta de trabalho e aliada, quem sabe poderemos voltar a ser apenas pessoas, como sugeriu Whurley, fundador da Strangeworks e palestrante no SXSW sobre computação quântica e inteligência artificial. Ao final de sua apresentação no seu festival, ele surpreendeu a todos ao revelar que sua palestra tinha sido montada por sistemas de IA, como o ChatGPT.

Referências:

O’NEIL, Cathy. Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. NY: Crown, 2016.

KAUFMAN, Dora. A inteligência artificial irá suplantar a inteligência humana? Barueri, SP: Estação das Letras e Cores, 2019.