Amazon acelera na corrida da IA com novos superchips e modelos de base

Empresa lança uma nova família de modelos de base e novos servidores equipados com seus próprios chips de inteligência artificial

A Amazon Web Services (AWS), divisão de computação em nuvem da Amazon, anunciou esta semana uma nova família de modelos de base para impulsionar aplicações de IA generativa, chamada Nova.

São quatro modelos Nova: Micro, Lite, Pro e Premier, cada com configurações próprias de capacidade e tamanho.

- Micro: modelo só para textos, é o que oferece a menor latência do grupo, o que significa que pode processar texto mais rapidamente.

- Lite: é o modelo multimodal que processa entradas de imagens, vídeos e texto.

- Pro: tem a melhor combinação de precisão, velocidade e custo para uma variedade de tarefas.

- Premier: é melhor para tarefas de raciocínio complexo e para desenvolvimento de modelos personalizados.

A empresa também apresentou um novo modelo de geração de imagens, o Nova Canvas, e um modelo de geração de vídeos, Nova Reel.

Os modelos de base servem como uma base forte para tarefas de aprendizado de máquina e são frequentemente usados para tarefas de IA generativa, que incluem criar novos conteúdos como imagens, texto e áudio.

Em vez de treinar e desenvolver modelos de inteligência artificial do zero, cientistas de dados muitas vezes usam um modelo de base como ponto de partida para desenvolver seus próprios modelos de aprendizado de máquina.

"Na Amazon, temos cerca de mil aplicações de IA generativa em andamento e tivemos uma visão geral do que os desenvolvedores ainda estão enfrentando", disse Rohit Prasad, vice-presidente sênior de inteligência artificial geral da Amazon.

"Continuamos a trabalhar em nossos próprios modelos de fronteira, que fizeram um progresso tremendo nos últimos quatro a cinco meses", disse o CEO da Amazon, Andy Jassy.

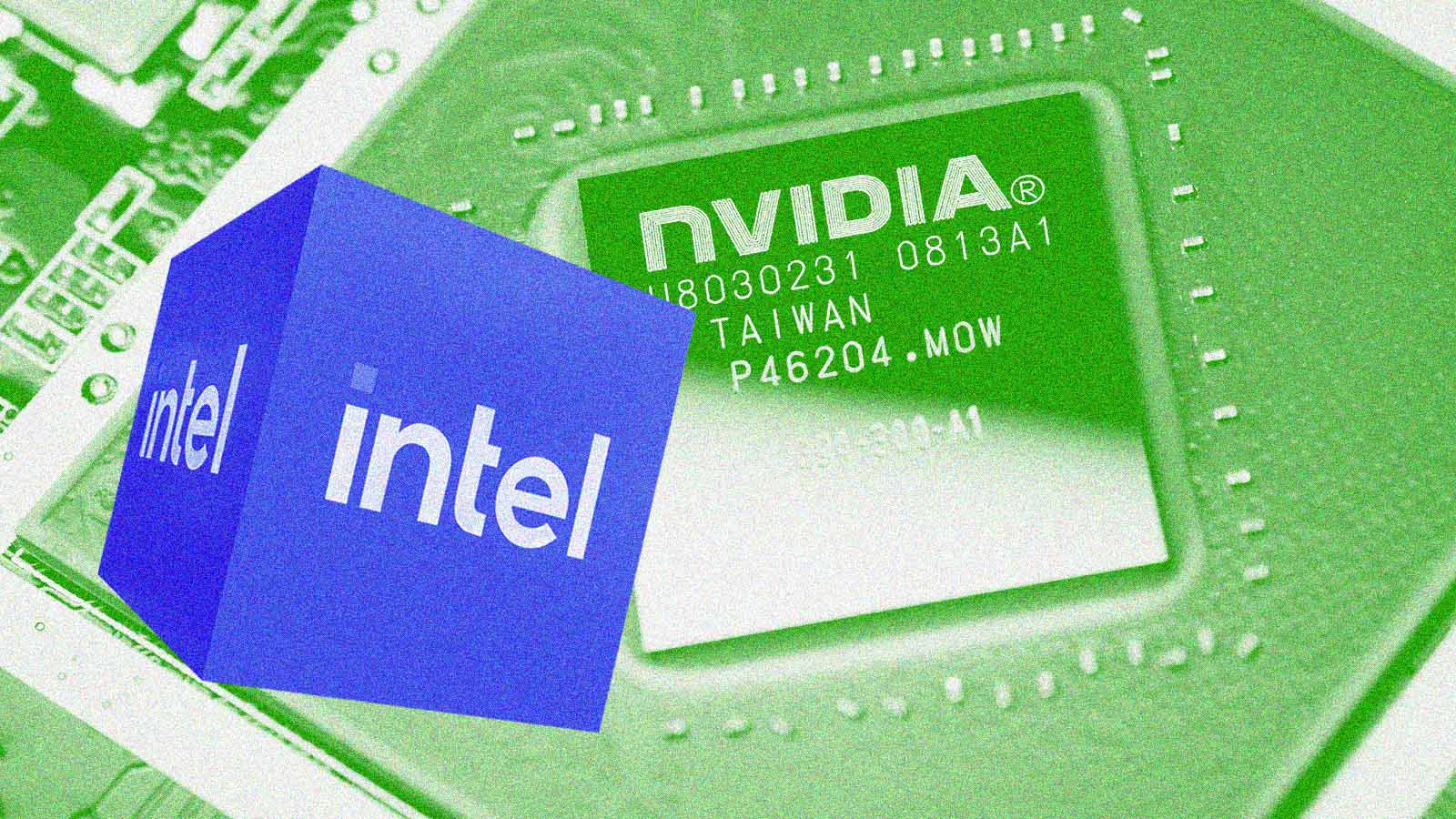

DESAFIO À NVIDIA

A Amazon apresentou também novos servidores equipados com seus próprios chips de IA. Baseados nos chips Trainium2, da AWS, os novos servidores serão conectados em um supercomputador, com a ajuda da startup de IA Anthropic, que será a primeira a usá-lo. Benoit Dupin, executivo da Apple, disse que a empresa também está usando os chips Trainium2.

Com mais de 70% de participação de mercado, a Nvidia domina a venda de chips de inteligência artificial, e concorrentes tradicionais do setor, como a AMD, estão correndo para tentar alcançá-la.

Mas alguns dos maiores concorrentes da Nvidia também são seus clientes: Meta Platforms, Microsoft e Google, da Alphabet, todos contam com seus próprios chips de IA personalizados. O da Meta é usado em operações internas, mas a Amazon e o Google também vendem os seus no mercado.

Os novos servidores, que a AWS chama de Trn2 UltraServers, vão concorrer com o servidor principal da Nvidia, equipado com os chips "Blackwell". Ambas as empresas também oferecem tecnologia proprietária para conectar os chips, embora Gadi Hutt, que lidera o desenvolvimento de negócios para os chips de IA na AWS, tenha dito que a AWS será capaz de conectar um maior número de chips do que a Nvidia.

"Acreditamos que, com o Trainium2, os clientes terão mais capacidade de computação do que o disponível da Nvidia hoje e poderão reduzir custos", disse Hutt, acrescentando que alguns modelos de IA podem ser treinados com um custo 40% menor do que nos chips da concorrente.

Segundo os executivos da AWS, os novos servidores e o supercomputador estarão disponíveis em 2025, mas não deram uma data específica. Tanto a AWS quanto a Nvidia estão correndo para lançar suas principais ofertas em meio à crescente demanda do mercado.

Com informações de Stephen Nellis e Greg Bensinger, da Reuters