Ele disse que a IA destruiria o mundo em 2027. Agora mudou a data

Especialista projeta que a superinteligência pode surgir apenas em 2034 e admite que não sabe se ela pode representar uma ameaça à humanidade

Daniel Kokotajlo previu que o fim do mundo aconteceria em abril de 2027, em um documento intitulado “AI 2027”, publicado em abril de 2025 e que detalhava os impactos iminentes da inteligência artificial.

No documento, o ex-funcionário da OpenAI e outros pesquisadores afirmavam que, até abril de 2027, o desenvolvimento descontrolado de IA levaria à superinteligência e, consequentemente, à destruição da humanidade.

Agora, porém, os autores estão revisando suas próprias previsões. Kokotajlo projeta que a superinteligência pode surgir apenas em 2034 e admite que não sabe se, ou quando, a IA poderia de fato representar uma ameaça existencial.

Em “AI 2027”, ele argumentava que a superinteligência surgiria por meio da “programação totalmente autônoma”, permitindo que sistemas de IA impulsionassem seu próprio desenvolvimento.

O lançamento do ChatGPT, em 2022, acelerou especulações sobre a chegada da inteligência artificial geral (IAG), com algumas previsões apontando anos, e não décadas, como horizonte.

O documento ganhou ampla repercussão. Segundo relatos, o vice-presidente dos EUA, JD Vance, leu “AI 2027” e depois incentivou o Papa Leão XIV – que destacou a IA como um dos principais desafios da humanidade – a exercer liderança internacional para evitar os cenários descritos no texto.

Por outro lado, críticos como Gary Marcus, professor emérito de neurociência da Universidade de Nova York, classificaram o relatório como “obra de ficção”, chamando algumas previsões de “puro jargão de ficção científica”.

À medida que pesquisadores e o público começam a lidar com o quão irregular é o desempenho atual da IA, os prazos para a IAG voltam a se estender, segundo Malcolm Murray, especialista em gestão de riscos em IA e um dos autores do Relatório Internacional de Segurança em IA.

não se sabe se, ou quando, a IA poderia de fato representar uma ameaça existencial.

“Para que um cenário como o de ‘AI 2027’ aconteça, a IA precisaria de muito mais habilidades práticas aplicáveis às complexidades do mundo real”, afirmou.

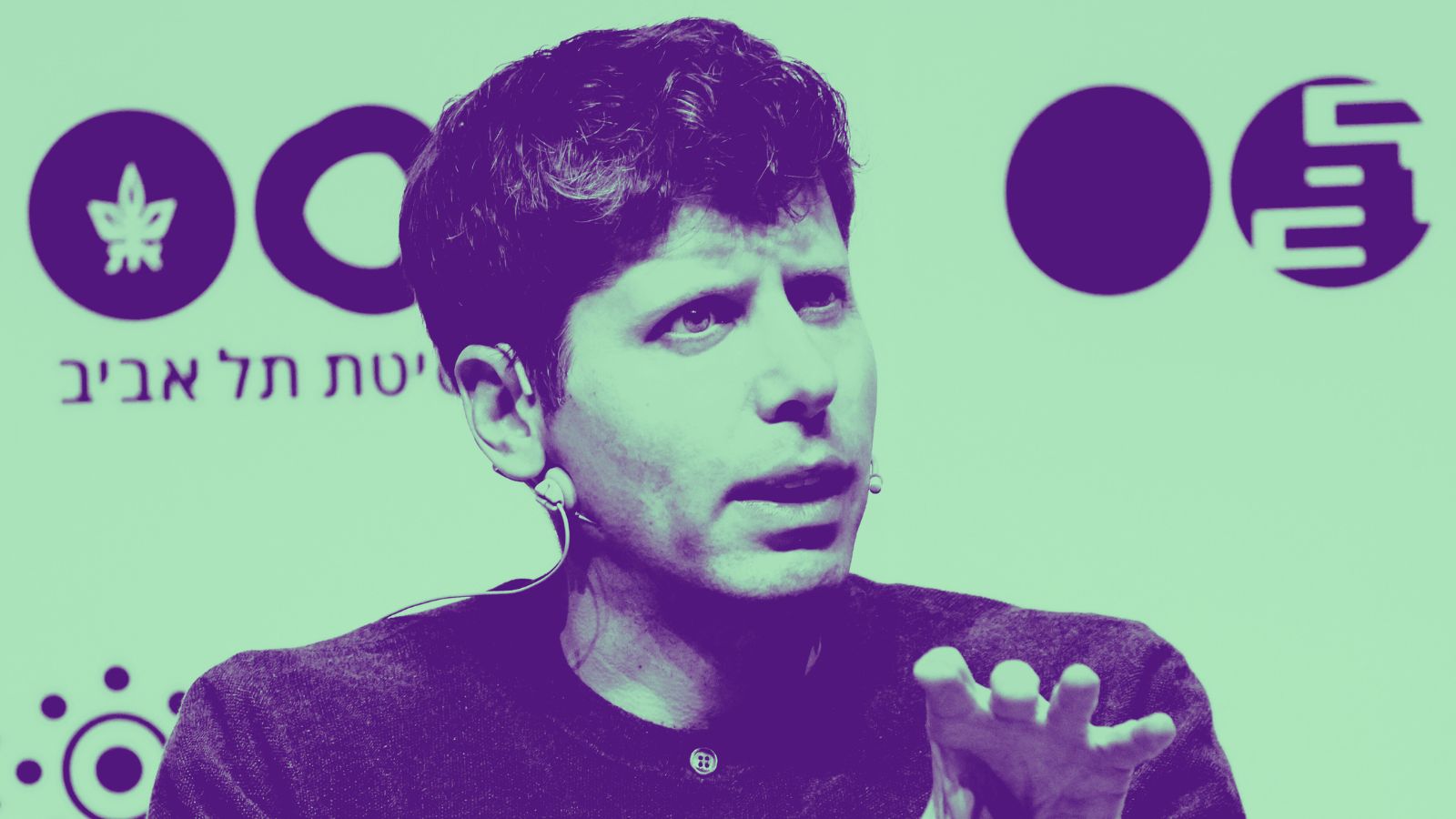

Ainda assim, desenvolver modelos capazes de treinar a si próprios continua sendo uma meta central para as principais empresas do setor. Sam Altman, CEO da OpenAI, estabeleceu metas internas para alcançar “um verdadeiro pesquisador automatizado de IA até março de 2028”.

Ele, porém, reconhece as incertezas. “Podemos fracassar totalmente nesse objetivo”, escreveu Altman no X. “Mas, dado o potencial impacto extraordinário, acreditamos que é do interesse público sermos transparentes sobre isso.”

Leia mais: Apesar do buzz, ainda não dá para levar a superinteligência muito a sério

A superinteligência, portanto, ainda pode ser possível. Mas quando ela chegará – e do que será capaz – parece hoje muito mais nebuloso do que “AI 2027” sugeria.

Este artigo foi publicado originalmente na Inc.,publicação parceira da Fast Company. Leia o artigo original.