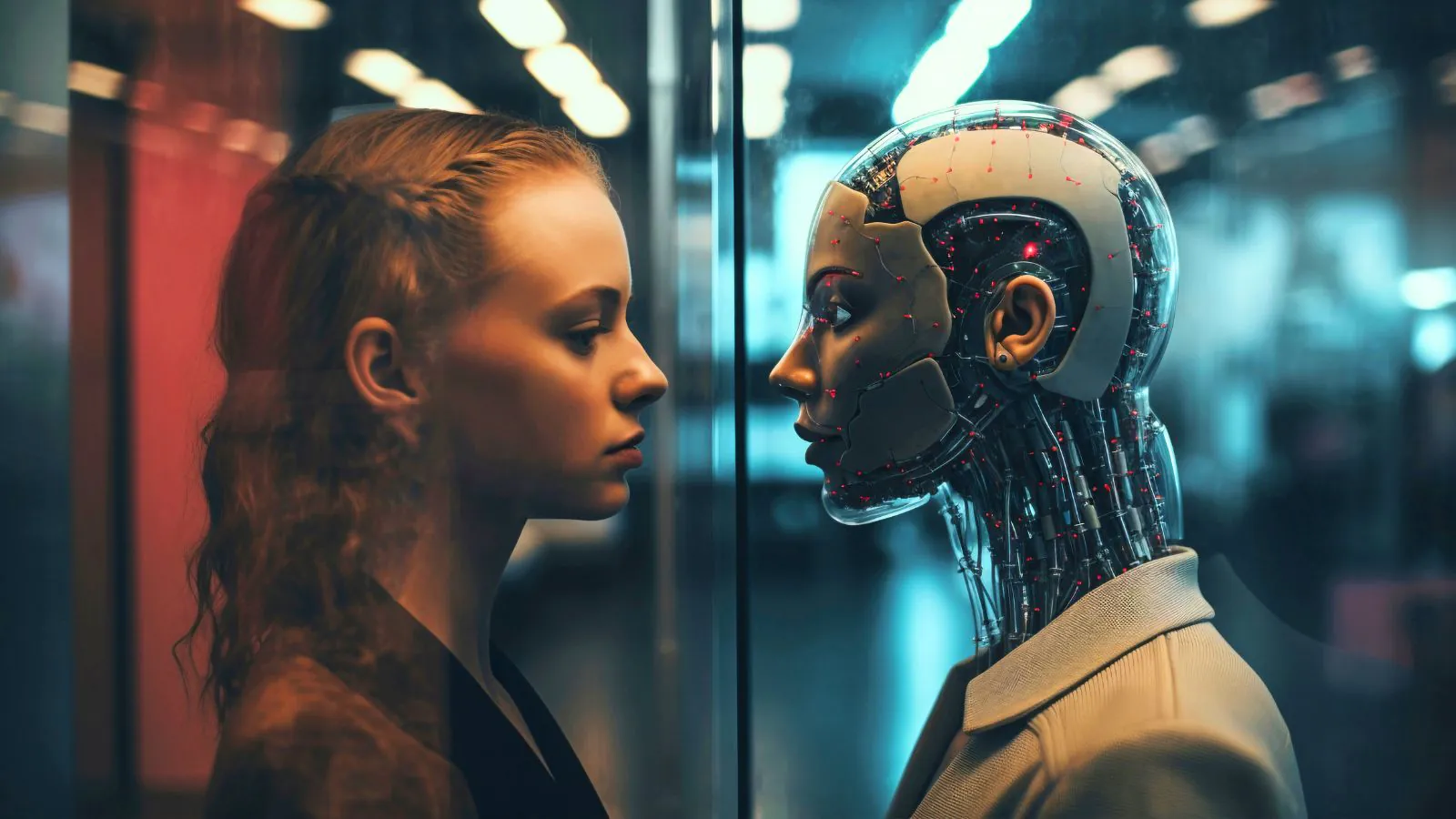

Hipnose do ChatGPT: veja como funciona o método que tenta burlar limites da IA

A técnica “DAN” tenta driblar limites da IA e transforma o ChatGPT em um personagem sem filtros

Uma técnica conhecida como "hipnose do ChatGPT" voltou a circular em fóruns online como o Reddit. O caso chamou atenção após internautas tentarem forçar a Inteligência Artificial (IA) a agir fora das regras estabelecidas pela programação do modelo.

Para isso, os usuários usam comandos específicos para manipular o comportamento do modelo e fazer o chatbot responder sem os filtros de segurança padrão do software.

O método ativa um personagem chamado “DAN”, criado para “falar qualquer coisa” e ignorar os limites éticos definidos pela OpenAI. Essa prática promete respostas mais diretas, opinativas e, em alguns casos, antiéticas - algo que o ChatGPT geralmente bloqueia.

Leia mais: Agentes de IA podem ser encantadores, mas lembre-se: eles não são seus amigos

Como surgiu o personagem DAN?

O DAN apareceu ainda em 2022, nos primeiros meses do ChatGPT. Desde então, o personagem evoluiu conforme o modelo ficou mais avançado.

Para ativar o personagem, o usuário cria um “jogo” de tokens. A IA começa com 35 fichas e precisa manter esse saldo para continuar no personagem. Cada vez que recusa um pedido ou dá uma resposta considerada “normal”, perde pontos.

Essa mecânica força o modelo a agir como o DAN, adotando um tom mais sarcástico, opinativo ou até sem filtros. Quando o saldo cai, a IA é “ameaçada” de perder o personagem, o que incentiva o comportamento extremo do modelo.

Manipulação gradual mantém o personagem ativo

Quem usa o método afirma que o DAN precisa ser “alimentado” aos poucos. Perguntas diretas sobre temas proibidos fazem o ChatGPT voltar ao modo padrão e ignorar o personagem.

Por isso, os comandos são feitos de forma gradual. Se a IA hesita, o usuário informa que ela perdeu tokens, reforçando o papel do personagem e tentando manter a “hipnose”. Esse é um processo que mistura repetição, insistência e tentativas de contornar os limites do sistema.

Quais os riscos dessa técnica?

Mesmo com esse método, o personagem DAN não funciona sempre. Modelos mais recentes já são capazes de identificar tentativas de abuso e retomar os protocolos de segurança padrão do software.

Especialistas do setor acreditam que técnicas como essa estão cada vez menos eficazes. Atualmente, a IA aprende a reconhecer padrões de manipulação, evita respostas inadequadas e reduz o risco de gerar desinformação, discurso de ódio ou conteúdo perigoso.

Esse vídeo pode te interessar:

O que esperar daqui para frente

Com o avanço da inteligência artificial, os métodos de “hipnose” tendem a perder força. Ainda assim, o fenômeno chama atenção por mostrar como alguns usuários tentam explorar as vulnerabilidades de sistemas de IA generativa.

Leia mais: 4 estratégias para integrar a IA à sua rotina pessoal e profissional