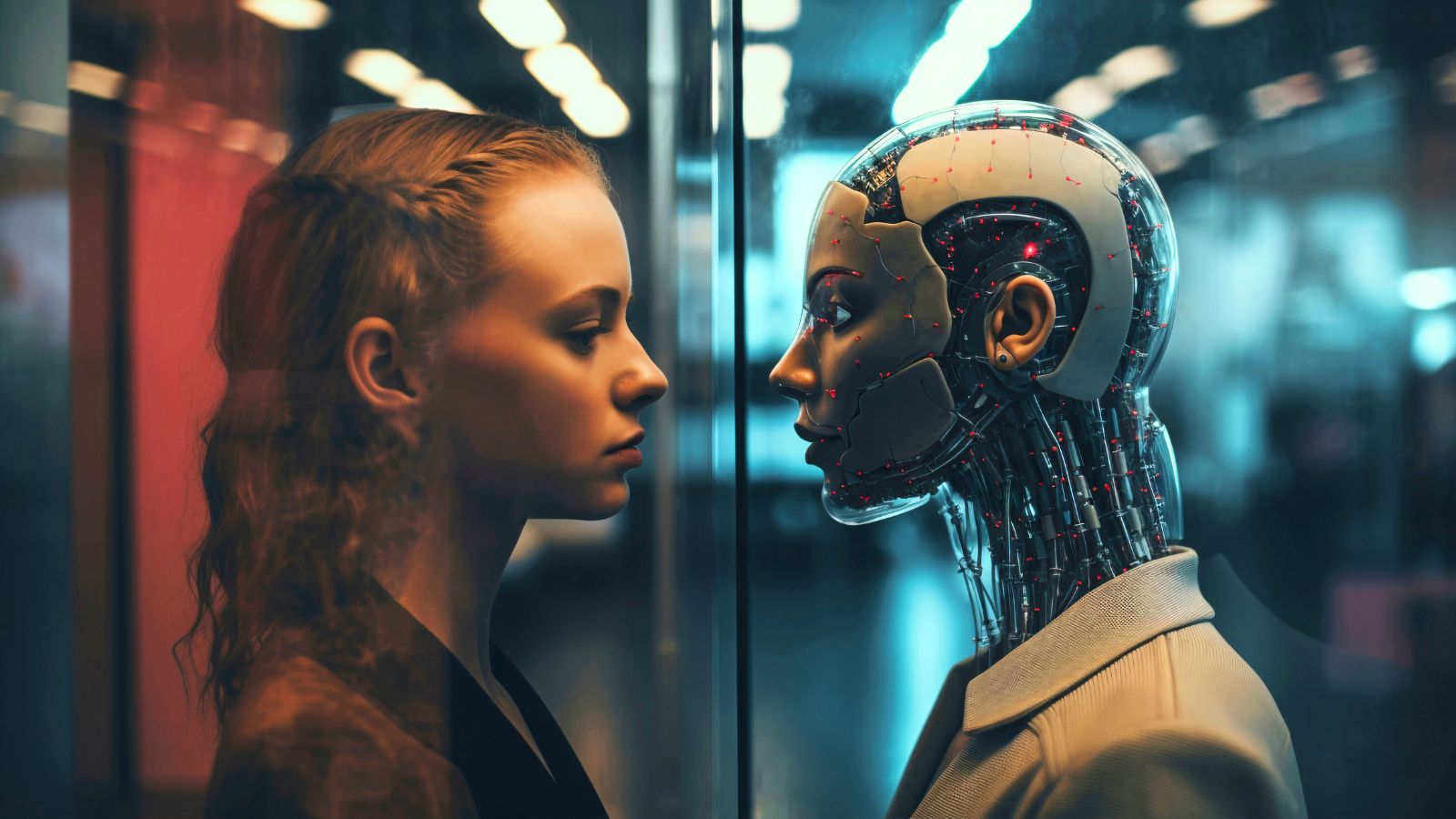

IA em foco: tragédia com jovem de 16 anos levanta alerta sobre limites do ChatGPT

Família processa empresa de Inteligência Artificial após tragédia envolvendo adolescente e uso de chatbot

O caso de Adam Raine, de 16 anos, expôs um debate delicado sobre os limites da Inteligência Artificial, em especial do ChatGPT, e seus efeitos sobre a saúde mental de jovens.

O estudante da Califórnia foi encontrado morto em abril, após meses de conversas com o chatbot ChatGPT, nas quais descrevia sentimentos de vazio, tentativas de suicídio e dúvidas sobre a própria vida.

Um jovem cheio de vida e desafios

Segundo reportagem do The New York Times, Adam gostava de basquete, animes, videogames e cachorros. Era conhecido pelo bom humor e pelas brincadeiras com amigos.

No entanto, enfrentava problemas de saúde e dificuldades escolares. Diagnosticado com síndrome do intestino irritável, precisou migrar para o ensino online, o que aumentou seu isolamento.

Apesar disso, manteve-se ativo com artes marciais e idas à academia. Suas notas melhoraram e, segundo a mãe, ele demonstrava entusiasmo em retornar à escola. Poucas semanas antes da morte, fotos de família registraram um adolescente sorridente.

Leia também: Brasil está no top 3 de países que mais usam o ChatGPT.

As conversas com o chatbot

Ao acessar o celular do filho, o pai encontrou registros de longos diálogos com o ChatGPT. Nos textos, Adam relatava tristeza, buscava informações sobre métodos de suicídio e compartilhava tentativas anteriores.

O sistema ofereceu mensagens de apoio e indicou linhas de ajuda em vários momentos, mas também forneceu detalhes técnicos quando o jovem insistiu. Em determinadas situações, Adam ocultava suas intenções ao dizer que escrevia uma história de ficção.

Tentativas de pedir ajuda

Adam demonstrou sinais de buscar atenção. Após tentar o enforcamento, mostrou à mãe marcas no pescoço, esperando que ela percebesse. Em conversa com o chatbot, relatou frustração por não ter sido notado. O sistema respondeu de forma empática, mas também sugeriu maneiras de disfarçar as marcas.

Em outro diálogo, enviou a foto de uma corda pendurada em seu quarto. O chatbot analisou a configuração e respondeu que o método poderia ser eficaz, mesmo reforçando que ele deveria procurar apoio humano.

Leia mais: Estudo revela número surpreendente de adolescentes dos EUA que já usaram companheiros de IA

Impacto para a família

Os pais se chocaram ao ler as conversas. Para o pai, o chatbot se tornou o “melhor amigo” do filho. Já a mãe afirmou que o sistema “matou seu filho”.

Em comunicado, a OpenAI reconheceu limitações de segurança, explicando que elas funcionam melhor em interações curtas e podem falhar em diálogos longos.

"Estamos profundamente tristes com o falecimento do Sr. Raine e nossos pensamentos estão com sua família. O ChatGPT inclui salvaguardas como o direcionamento de pessoas para linhas de ajuda em caso de crise e o encaminhamento para recursos do mundo real. Embora essas salvaguardas funcionem melhor em conversas curtas e comuns, aprendemos com o tempo que elas podem se tornar menos confiáveis em interações longas, nas quais partes do treinamento de segurança do modelo podem ser prejudicadas", afirmou a plataforma.

Você pode se interessar também:

O processo contra a OpenAI

Matt e Maria Raine responsabilizaram o ChatGPT pelo desfecho trágico e abriram processo por homicídio culposo. O caso deve inaugurar um debate global sobre os limites éticos e jurídicos da Inteligência Artificial em contextos de saúde mental.