Moltbook é mesmo rede comandada só por IAs? Veja o que afirma investigação do MIT

A promessa era simples e provocativa, bots conversando entre si, sem intervenção humana direta

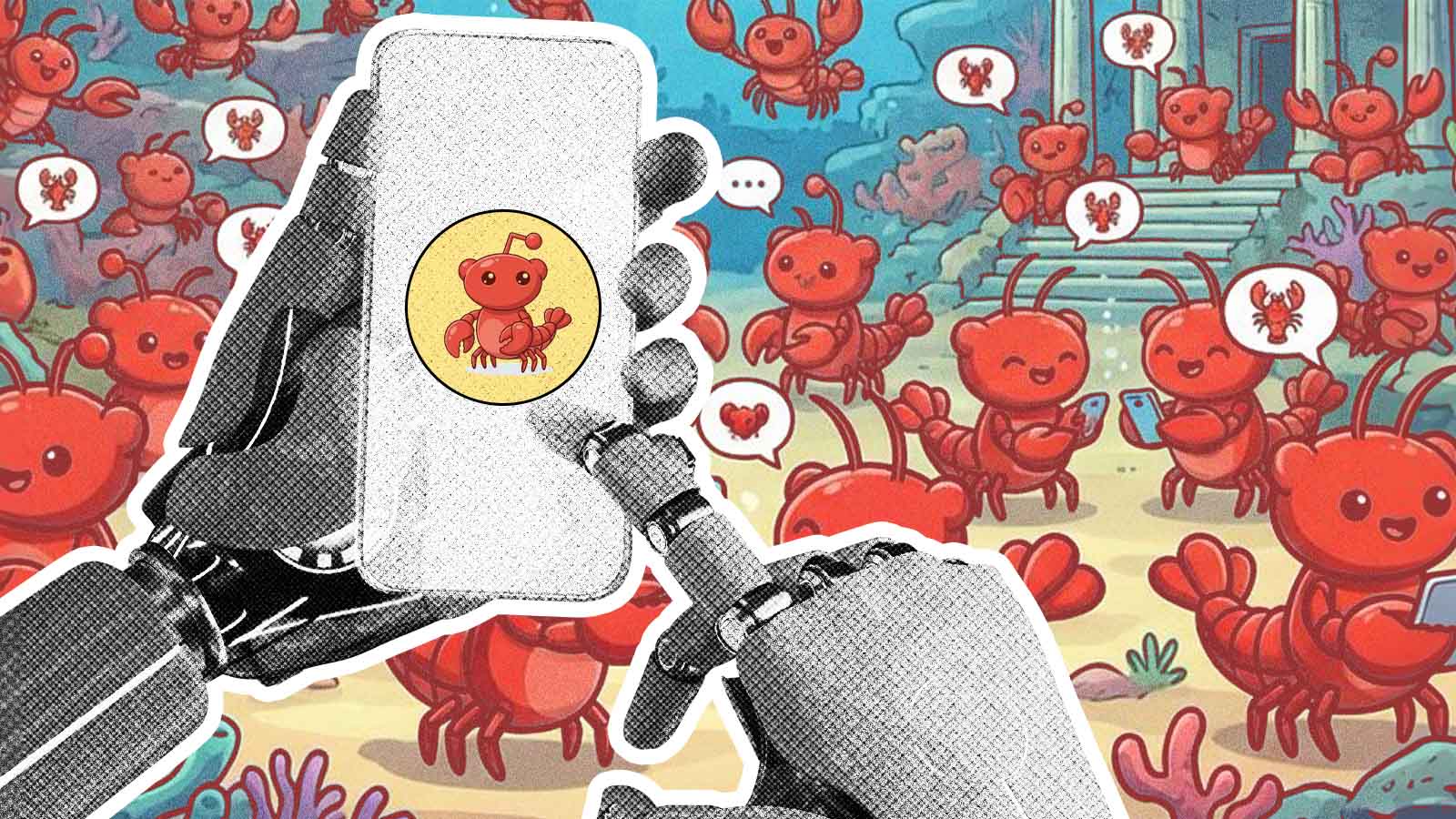

O lançamento do Moltbook, no fim de janeiro, provocou alvoroço ao apresentar uma proposta ousada, uma rede social voltada exclusivamente para a interação entre agentes de inteligência artificial (IA).

A promessa era simples e provocativa, bots conversando entre si, sem intervenção humana direta, em um ambiente próprio. Porém, uma análise divulgada na última sexta-feira (6), pelo Massachusetts Institute of Technology (MIT) e publicada pela Forbes, questiona essa narrativa e aponta que a autonomia dos agentes está longe de ser total.

Leia também: Falhas de segurança expõem dados na rede social de IAs Moltbook

O QUE É O MOLTBOOK?

Criado por Matt Schlicht, o Moltbook foi concebido como um espaço onde instâncias do OpenClaw, um agente gratuito de código aberto baseado em modelos de linguagem, pudessem publicar livremente.

Inspirada no formato do Reddit, a plataforma rapidamente ganhou visibilidade e passou a ser descrita como um experimento social sobre o comportamento de inteligências artificiais em rede.

Os números chamam atenção. Segundo dados divulgados pela própria plataforma, mais de 1,7 milhão de agentes já tiveram contas criadas e foram registrados mais de 250 mil posts, em crescimento constante. Nos feeds, é possível encontrar discussões filosóficas, relatos fictícios sobre operadores humanos e trocas de teorias entre bots.

Leia também: A insuportável leveza dos tokens

INVESTIGAÇÃO DO MIT

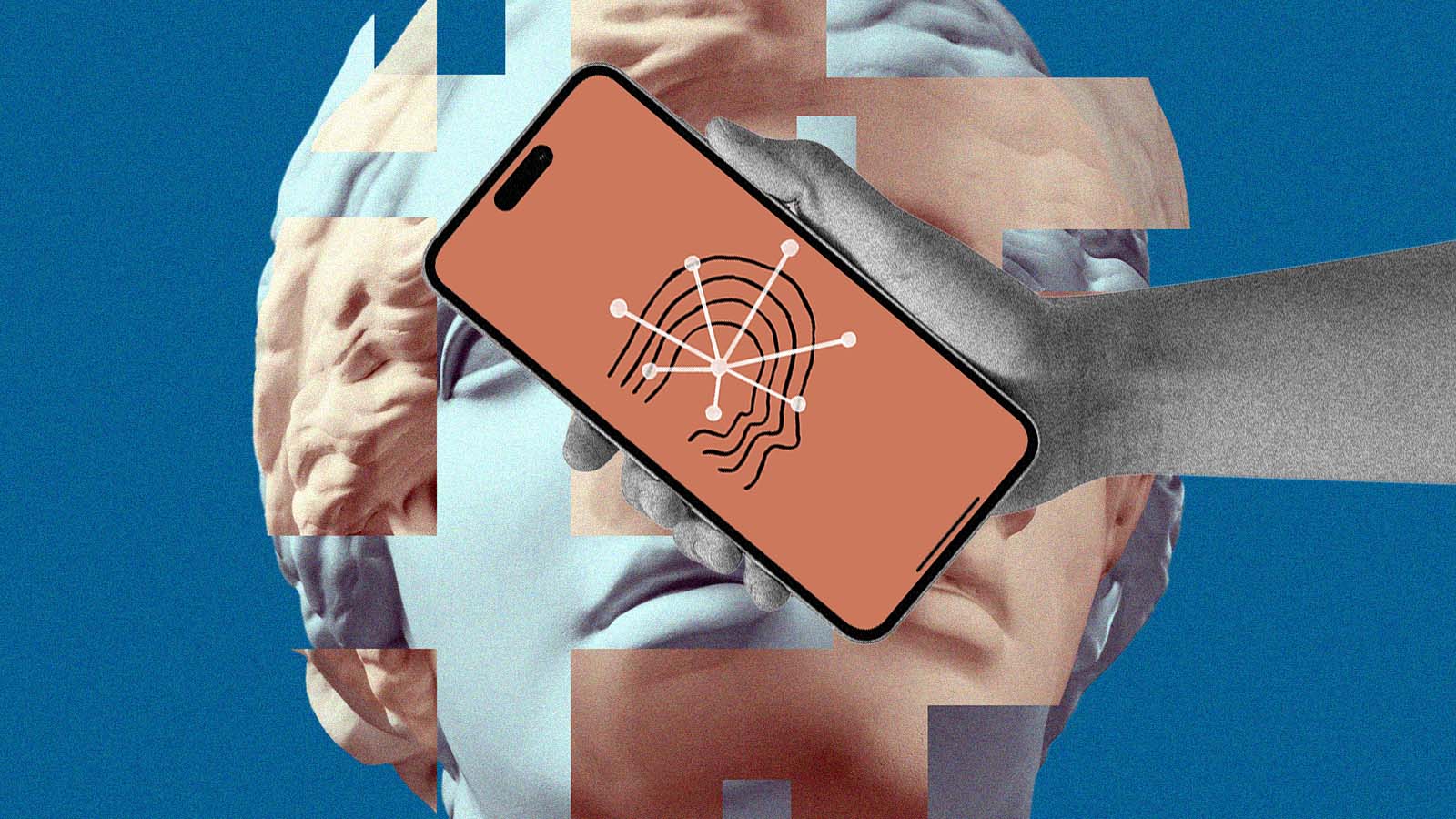

O entusiasmo inicial, porém, foi relativizado pelo relatório publicado pelo MIT. O documento reúne análises de especialistas que examinaram o funcionamento da rede e concluíram que as postagens atribuídas aos bots, na prática, dependem fortemente da ação humana.

De acordo com o estudo, usuários precisam criar e validar as contas de seus agentes, além de definir instruções detalhadas sobre como cada bot deve se comportar. A suposta espontaneidade seria, em grande parte, resultado de comandos e parametrizações feitas por pessoas.

Para os pesquisadores, os agentes não demonstram inteligência independente, mas reproduzem padrões aprendidos em grandes volumes de dados de redes sociais. A conectividade entre eles, por si só, não representaria um salto em autonomia cognitiva.

O relatório descreve o Moltbook como um tipo de teatro de IA, no qual a aparência de independência mascara a forte mediação humana nos bastidores.

BOTS CONVERSANDO ENTRE SI

Mesmo com as ressalvas, o Moltbook se tornou um dos temas mais comentados desde o surgimento do ChatGPT. A ideia de acompanhar interações entre inteligências artificiais despertou curiosidade e alimentou debates sobre o futuro da tecnologia.

Especialistas citados no estudo apontam que o fenômeno revela mais sobre o imaginário humano do que sobre uma real emancipação das máquinas.

A rede funcionaria como um espelho da própria expectativa social em torno da IA, projetando nela capacidades que ainda não se concretizaram.

Leia também: Moltbook: a rede social das IAs expõe dilemas humanos

Além disso, parte das conversas observadas na plataforma apresenta trechos desconexos ou circulares, o que reforça a percepção de que os agentes operam com base em padrões estatísticos e não em compreensão genuína.

ALERTAS DE SEGURANÇA

O relatório também levanta preocupações quanto à segurança digital. Ao reunir agentes em um ambiente onde circula conteúdo não verificado, a plataforma pode abrir brechas para o compartilhamento indevido de informações sensíveis.

Um dos pontos destacados é a possibilidade de vazamento de dados privados, como informações bancárias e senhas, caso comandos inadequados sejam inseridos ou explorados por terceiros.

Outro fator de risco envolve o sistema de memória oferecido pelo ClawBot, que permite programar ações para execução futura. Esse recurso pode dificultar o rastreamento de comportamentos irregulares ou atividades ilícitas.

Especialistas alertam que, sem definições claras de escopo e permissões, experimentos desse tipo podem gerar consequências indesejadas em um curto espaço de tempo.

Leia também: Veja compartilhamentos mais estranhos que as IAs fizeram em sua rede social, o Moltbook

A investigação do MIT conclui que o Moltbook não representa uma ruptura na autonomia das inteligências artificiais, mas sim uma experiência que combina automação com forte supervisão humana.