O mecanismo invisível que faz a IA acentuar o radicalismo online (e off-line)

Feeds que amplificam conteúdos radicalizantes estão alimentando o extremismo e criando uma cultura do ódio que ameaça a todos nós

Personalidades da mídia e influenciadores que vivem de estimular a polarização costumam culpar o movimento Antifa e o MAGA (“Make America Great Again”, ou “Faça a América grande novamente”, em português) pela escalada da violência política. Ao mesmo tempo, CEOs de tecnologia alimentam o medo de um possível apocalipse da inteligência artificial.

Mas tudo isso acaba desviando o foco de um problema maior. São os algoritmos que escolhem o que vemos – e, para tentar agradá-los, estamos mudando nosso próprio comportamento.

A lógica do “provocar para engajar” se tornou um modelo de negócio. Os algoritmos favorecem conteúdos radicalizantes, fazendo com que ideias extremistas pareçam parte do debate. A indignação passa a ser confundida com participação cívica. É uma ilusão bem orquestrada.

E os algoritmos não apenas amplificam – eles também escolhem quem vê o quê, criando realidades paralelas que eliminam qualquer chance de diálogo com o outro lado. O Facebook prioriza posts que despertam fortes emoções. O YouTube recomenda vídeos parecidos para manter os usuários assistindo por mais tempo. E o TikTok… bem, ninguém sabe ao certo como a aba “Para Você” prende tanta gente por tanto tempo.

Você pesquisa um tapete de yoga e o algoritmo conclui que você é progressista. Seu vizinho procura caminhonetes e o sistema o classifica como conservador.

Em pouco tempo, seu feed se enche de podcasts sobre mindfulness e notícias sobre o clima, enquanto o do seu vizinho é tomado por vídeos de trilhas off-road e comentários sobre “excesso de regulação”. Ambos acham que estão vendo o mundo como ele é – mas cada um está preso à sua própria realidade.

Nos EUA, mortes violentas como as do ativista de direita Charlie Kirk, da deputada Melissa Hortman e de seu marido, dos funcionários de embaixada de Israel Sarah Lynn Milgram e Yaron Lischinsky, do CEO Brian Thompson e do executivo Wesley LePatner vêm sendo atribuídas à crescente onda de violência política. Mas é bem mais provável que sejam resultado da radicalização promovida pelos algoritmos.

Hoje, o medo de um “apocalipse da IA” é um dos assuntos mais falados. “Com o aumento das tensões em torno da inteligência artificial e o medo generalizado de perder empregos, executivos do setor de tecnologia estão cada vez mais expostos a ameaças físicas”, afirma Alex Goldenberg, diretor de inteligência da Narravance, que monitora redes sociais em tempo real para identificar riscos.

MEDO DE FICAR OBSOLETO

“Assim que Charlie Kirk foi assassinado, o vídeo rodou o mundo inteiro. Crianças de 10 anos viram aquilo em poucas horas”, disse Jonathan Haidt, autor de “A geração ansiosa”, no Fast Company Innovation Festival.

Haidt aponta que, desde 2012, o número de adolescentes que dizem sentir que suas vidas “não têm sentido” mais do que dobrou. Muitos meninos – sem referências sólidas e imersos em redes sociais, games e pornografia – têm dificuldade de encontrar um caminho para a vida adulta.

“Se você é um garoto, sente que sua vida não tem sentido e não vê futuro, tudo passa a girar em torno de fama e dinheiro. Você acha que precisa ficar rico rápido ou virar famoso, senão perde no ‘jogo social’”, explica Haidt.

Um ex-executivo de mídias sociais, que falou sob condição de anonimato, resume: “se você apresenta apenas cenários catastróficos, as pessoas ficam dispostas a fazer loucuras.” É um efeito inevitável do modelo de negócios das plataformas.

O COLAPSO DAS REDES SOCIAIS

Quando a indignação viraliza, qualquer engajamento vira um “selo de aprovação”. As pessoas começam a enxergar isso como verdade – mesmo que seja falso ou, pior, parte de campanhas coordenadas por algoritmos.

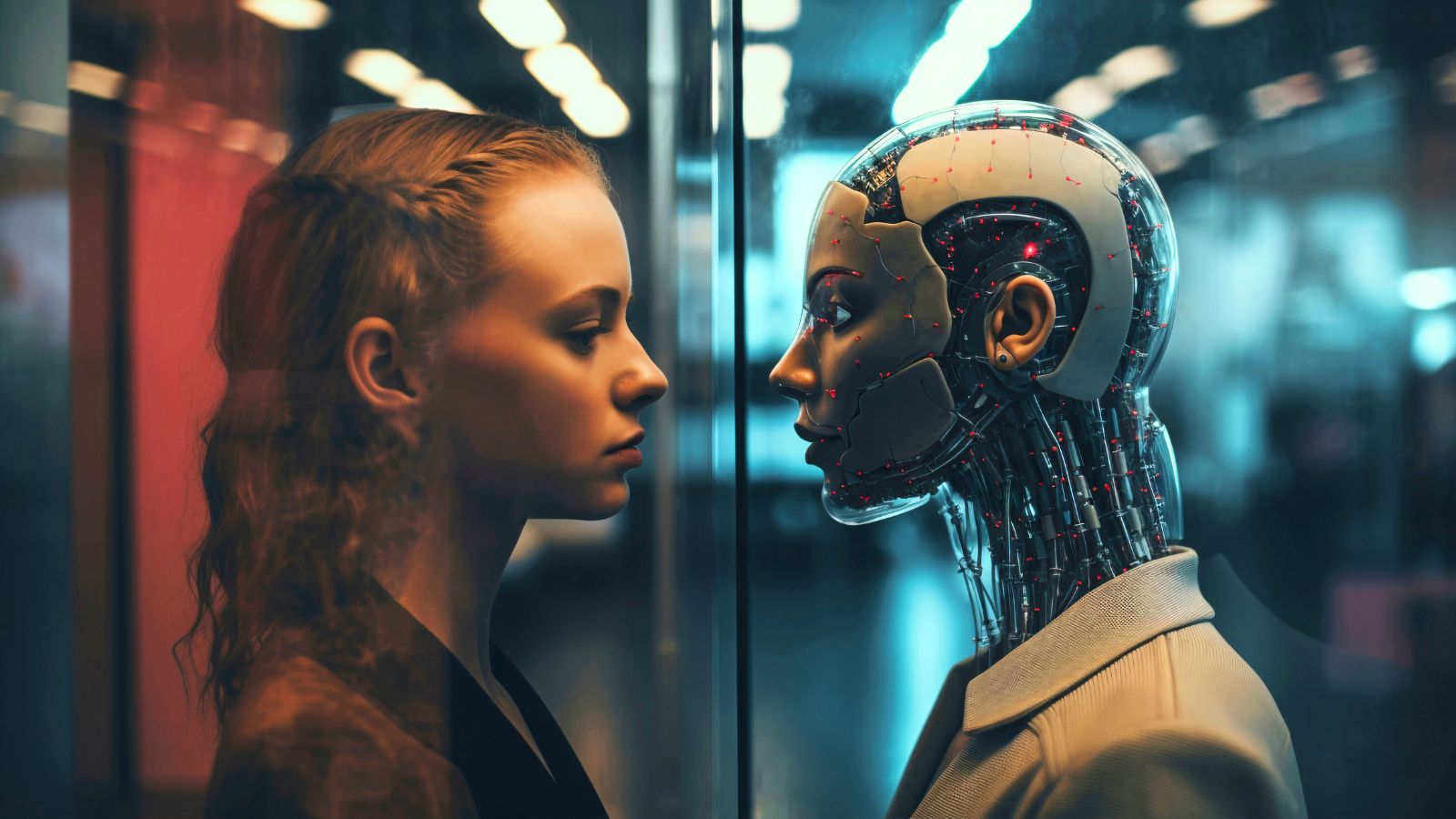

Um relatório da FAR.AI, uma organização sem fins lucrativos dedicada à segurança em IA, aponta que sistemas de inteligência artificial já são mais persuasivos que humanos e que modelos avançados estão sendo usados para manipulação política, desinformação e recrutamento extremista. Os riscos estão se multiplicando rapidamente. Perto disso, qualquer previsão de um futuro distópico sem empregos parece até menor.

A verdadeira ameaça é outra: a perda do nosso próprio julgamento crítico. O risco existencial da IA – abordado ainda em 1975 no livro “O Poder do Computador e a Razão Humana”, do cientista Joseph Weizenbaum – não é o desemprego total nem humanos vivendo em cápsulas como em “Matrix”.

O perigo não são máquinas conscientes. São algoritmos criados para nos manter engajados, irritados e eternamente divididos. O apocalipse não será causado por códigos de programação – mas sim pela nossa submissão a eles.