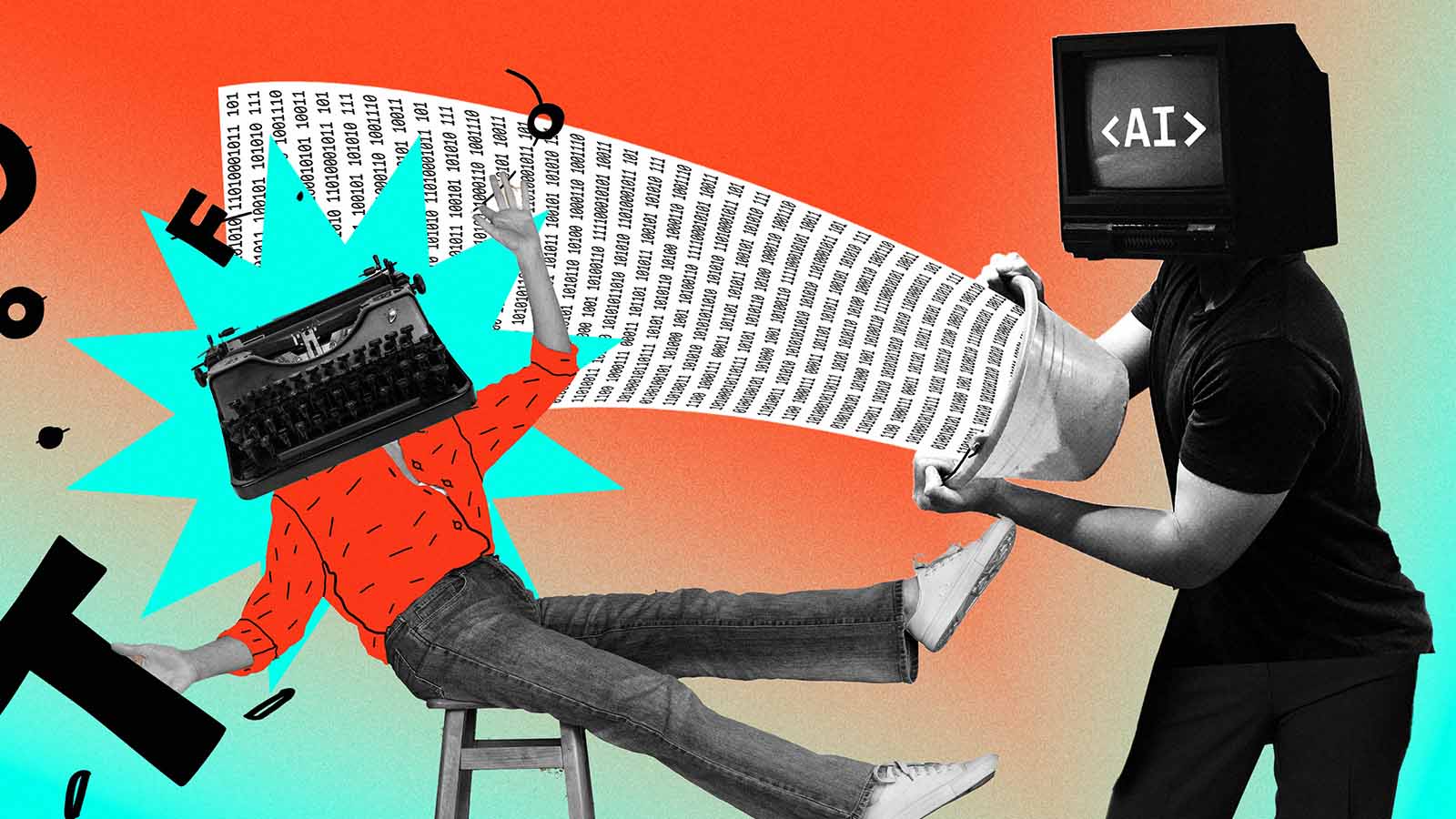

Ninguém sabe como a IA “pensa” de fato. Estes pesquisadores querem descobrir

Estudos revelam como os modelos de linguagem avaliam probabilidades e raciocinam com conceitos universais, mostrando seu potencial e seus riscos

O que faz os chatbots de IA parecerem tão inteligentes? Como conseguem compreender ideias complexas, criar histórias surpreendentemente boas e interpretar o que os usuários querem dizer com tanta naturalidade? A verdade é que ainda não sabemos totalmente.

Os modelos de linguagem operam de uma forma muito diferente da mente humana. Suas respostas são geradas a partir de bilhões de cálculos matemáticos processados em redes neurais altamente sofisticadas. A maior parte desse funcionamento interno ainda é um mistério – mas pesquisadores estão começando a decifrá-lo.

Especialistas em interpretabilidade mecânica, um campo da pesquisa em segurança de IA focado em entender como os modelos chegam às suas respostas, têm feito avanços importantes. Um exemplo recente é um conjunto de estudos da Anthropic, que traz novas descobertas sobre o processo de raciocínio interno dos grandes modelos de linguagem (LLMs, na sigla em inglês).

Assim como as redes neurais foram inspiradas nos neurônios do cérebro humano, os cientistas buscaram referências na neurociência para tentar compreender a inteligência artificial.

Eles criaram uma ferramenta de pesquisa – uma espécie de “microscópio de IA” – capaz de rastrear padrões de dados e fluxos de informação dentro de um LLM, analisando como ele conecta palavras e conceitos para chegar a uma resposta.

Até pouco tempo atrás, os pesquisadores só conseguiam observar elementos isolados desse processo. Agora, estão começando a enxergar como um pensamento leva a outro em uma sequência de raciocínio mais clara.

“Estamos tentando conectar todas as peças e entender, passo a passo, por que um modelo escolhe determinada palavra”, explica Joshua Batson, cientista da Anthropic. “Como a IA gera uma palavra por vez, podemos perguntar: ‘por que escolheu esta e não aquela?’. Se conseguirmos responder isso, podemos entender todo o processo.”

os cientistas buscaram referências na neurociência para tentar compreender a inteligência artificial.

Os estudos reforçam uma ideia já conhecida: os sistemas de IA abordam problemas de maneira muito diferente dos humanos. Por exemplo, os modelos de linguagem não aprendem a fazer contas da forma tradicional. Em vez disso, são expostos a exemplos de respostas corretas e desenvolvem suas próprias estratégias para chegar ao resultado.

Para entender melhor esse processo, os pesquisadores pediram a um modelo de linguagem com 18 camadas que resolvesse uma soma simples: 36 + 59. O que eles descobriram foi que a IA não faz cálculos da maneira convencional.

Em vez de seguir um passo a passo lógico, como aprendemos na escola, o modelo utilizou duas estratégias simultâneas: aproximou a resposta (perguntando-se se o resultado estaria na casa dos 90) e estimou o último dígito do resultado. Ao combinar essas probabilidades, chegou à resposta correta.

“Ele definitivamente desenvolveu um jeito próprio de calcular, bem diferente daquele que aprendemos na escola”, diz Batson.

COMO A IA PENSA ATRAVÉS DE CONCEITOS UNIVERSAIS

Outra questão que os pesquisadores quiseram responder foi: quando um modelo recebe uma pergunta em determinado idioma, ele pensa apenas naquele idioma? Ou será que processa conceitos mais abstratos, que transcendem os idiomas?

Para testar isso, eles pediram ao Claude que traduzisse frases simples para vários idiomas, acompanhando os tokens (unidades mínimas de significado) compartilhados durante o processamento.

O que descobriram foi que a IA combina os dois métodos: parte do modelo trabalha diretamente no idioma da pergunta e outra parte processa conceitos universais, independentes da língua.

Por exemplo, o modelo usa tokens que representam ideias como “pequenez” e “oposição”. Ao combinar esses conceitos, ele forma outros significados mais amplos, como “grandeza” (o oposto de pequeno).

Isso indica que Claude pode aprender um conceito em um idioma e aplicá-lo em outro sem precisar de um treinamento específico, explica Batson. Essa descoberta é essencial para entender como os modelos de IA transferem conhecimento entre diferentes contextos e raciocinam sobre perguntas em múltiplas áreas.

Se as empresas continuarem investindo em pesquisas sobre interpretabilidade, os cientistas poderão aprofundar ainda mais essas descobertas, chegando a um entendimento mais amplo e conectado sobre como os LLMs realmente funcionam.

Compreender melhor esses padrões pode ajudar a indústria a identificar riscos potenciais e desenvolver métodos mais eficazes para garantir que esses sistemas tenham um comportamento seguro e confiável.

Batson acredita que, com o tempo, as pessoas podem passar a confiar mais na IA, à medida que se familiarizam com seus resultados. Mas ele faz uma ressalva: “eu ficaria muito mais tranquilo se soubéssemos exatamente o que acontece dentro desses modelos”.