Polícia começa a usar IA para prever crimes antes de acontecerem. Funciona?

Em alguns países, o policiamento preditivo já é uma realidade. Analistas preveem um grande aumento na adoção da tecnologia

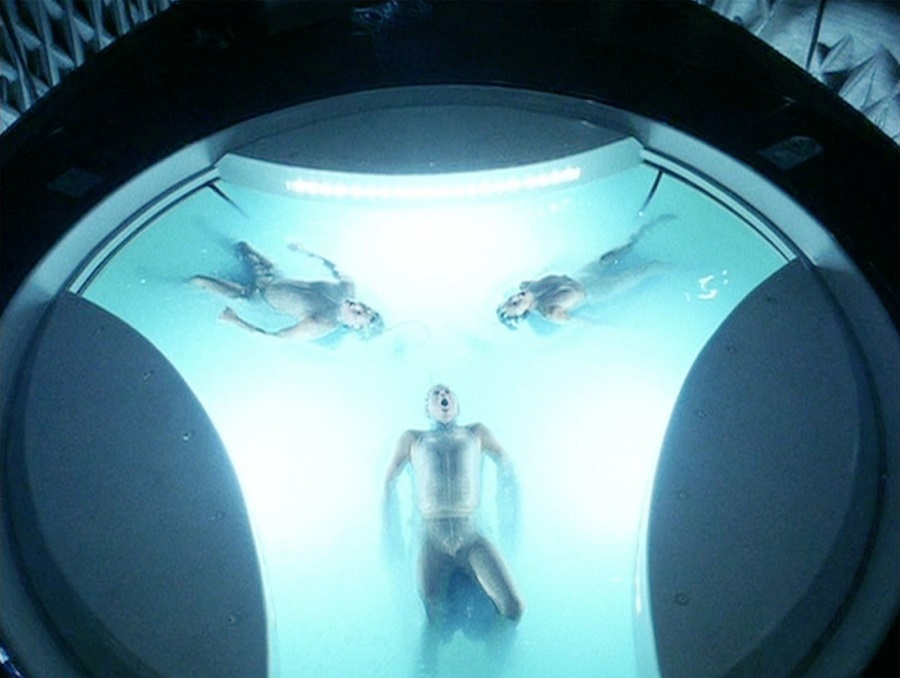

O filme de ficção científica “Minority Report: A Nova Lei”, lançado em 2002, mostra um futuro distópico no qual uma unidade especial da polícia é encarregada de prender pessoas por crimes que ainda não cometeram – fazendo o chamado policiamento preditivo.

Dirigido por Steven Spielberg e inspirado em um conto de Philip K. Dick, o enredo gira em torno do sistema “pré-crime”, baseado em três videntes – os “precogs” – que preveem assassinatos e permitem que a polícia aja antes que o crime aconteça.

A história levanta questões éticas importantes: como alguém pode ser culpado por algo que não aconteceu? E o que fazer quando o sistema falha?

Apesar de não existirem precogs na vida real, muitos elementos desse cenário futurista já fazem parte da nossa realidade – e chegaram mais rápido do que se imaginava. Há mais de 10 anos, forças policiais de diversos países vêm adotando sistemas baseados em dados para prever onde, quando e até quem pode estar envolvido em crimes.

Hoje, o policiamento preditivo já faz parte do cotidiano de muitas cidades – e analistas do setor preveem um grande aumento na adoção da tecnologia nos próximos anos. Mas, diante da dificuldade de usar o aprendizado de máquina de forma justa e eficiente, surgem sérios questionamentos sobre a ética desse modelo.

Sem grandes soluções técnicas no horizonte, uma alternativa é tratar o uso dessas ferramentas pelo governo como uma questão de responsabilidade democrática.

UM PASSADO PROBLEMÁTICO

O policiamento preditivo utiliza inteligência artificial e análise de dados para tentar antecipar crimes. Isso inclui o cruzamento de grandes bancos de dados – como boletins de ocorrência, registros de prisão e informações geográficas e sociais – para detectar padrões e prever locais e indivíduos com maior probabilidade de envolvimento em delitos.

O uso de dados para identificar tendências criminais não é novo. A diferença é que, hoje, os sistemas de IA conseguem processar volumes muito maiores de informação e fornecer análises mais detalhadas.

Essas previsões ajudam a polícia a decidir onde concentrar seus esforços. Há sistemas focados em “previsão por localização”, que apontam áreas com maior risco de ocorrência de crimes. Outros usam “previsão por perfil”, que tenta identificar indivíduos mais propensos a cometer – ou sofrer – crimes.

Sistemas de policiamento baseados em previsões algorítmicas têm gerado crescente preocupação pública nos Estados Unidos, após casos em que essas tecnologias resultaram em violações de direitos civis e práticas discriminatórias.

Um dos exemplos mais controversos ocorreu no condado de Pasco, na Flórida, onde o departamento de polícia implantou um programa de “policiamento orientado por inteligência” que criou uma lista de pessoas consideradas propensas a cometer crimes.

O policiamento preditivo utiliza IA e análise de dados para tentar antecipar crimes.

Com base nesses dados, autoridades realizaram visitas frequentes às casas de mais de mil moradores – incluindo menores de idade – sob o pretexto de monitoramento preventivo. Em várias ocasiões, cidadãos foram autuados por infrações triviais, como ausência de número na caixa de correio ou grama alta no jardim.

Em 2021, quatro moradores processaram o condado. No ano passado, foi firmado um acordo no qual a polícia local admitiu ter violado direitos constitucionais dos cidadãos, incluindo privacidade e tratamento igual perante a lei. O programa foi oficialmente encerrado após o acordo.

Casos semelhantes ocorreram em outras cidades dos EUA. Em 2021, o Departamento de Polícia de Los Angeles abandonou o uso do software PredPol, que prometia prever áreas com maior probabilidade de ocorrência de crimes, mas foi duramente criticado por sua baixa precisão e por reforçar preconceitos raciais e socioeconômicos.

INOVAÇÃO NECESSÁRIA OU EXTRAPOLAÇÃO?

Esses episódios reforçam o debate sobre os riscos de confiar decisões policiais a sistemas automatizados e algoritmos pouco transparentes que, muitas vezes, reproduzem desigualdades já existentes.

Especialistas em direitos civis e organizações da sociedade civil alertam que, sem transparência, supervisão e salvaguardas legais robustas, o uso dessas tecnologias pode comprometer direitos fundamentais em nome de uma suposta eficiência.

Nos Estados Unidos, a maioria dos departamentos de polícia não dispõem de regras claras sobre o uso de algoritmos, nem divulga como os modelos são criados, treinados ou avaliados quanto à precisão e possíveis vieses.

Essa falta de transparência é chamada de “caixa-preta”. Ela impede qualquer tipo de fiscalização independente e levanta sérias dúvidas sobre a forma como as decisões automatizadas do policiamento preditivo são tomadas.

Se uma pessoa for classificada como sendo de alto risco por um algoritmo, como ela pode recorrer? Quem garante que o sistema é justo? Existe algum controle externo?

COMO EVITAR OS RISCOS DO POLICIAMENTO PREDITIVO

Por outro lado, há iniciativas que mostram como o uso de dados pode ser mais transparente, ético e alinhado com os princípios democráticos. E se a população tivesse acesso às informações sobre como os algoritmos funcionam, quais dados eles utilizam e que medidas foram tomadas para evitar discriminação?

É exatamente isso que a cidade de San José, na Califórnia, está tentando fazer. O município adotou um conjunto de princípios para o uso de inteligência artificial, exigindo que qualquer tecnologia adotada pelo governo seja eficaz, transparente para a população e justa em relação ao seu impacto na vida das pessoas.

Se uma pessoa for classificada como sendo de alto risco por um algoritmo, como ela pode recorrer?

Além disso, os órgãos públicos são obrigados a avaliar os riscos antes de implementar qualquer sistema baseado em IA.

Se aplicadas corretamente, essas medidas podem abrir a “caixa-preta” e reduzir significativamente o nível de sigilo das empresas de IA sobre seus dados e códigos, impostos sob o argumento de segredo comercial.

Permitir o acesso público aos dados de treinamento, por exemplo, ajudaria a identificar e corrigir vieses raciais e socioeconômicos – que são difíceis de eliminar por completo, mas podem ser controlados.

A polícia provavelmente terá resultados melhores se enxergar a tecnologia como uma aliada, e não como substituta da justiça.

Este artigo foi republicado do “The Conversation” sob licença Creative Commons. Leia o artigo original.