Especialistas assinam carta aberta para frear a superinteligência artificial; entenda motivo

Documento internacional reacende o debate sobre segurança e regulação no avanço da inteligência artificial

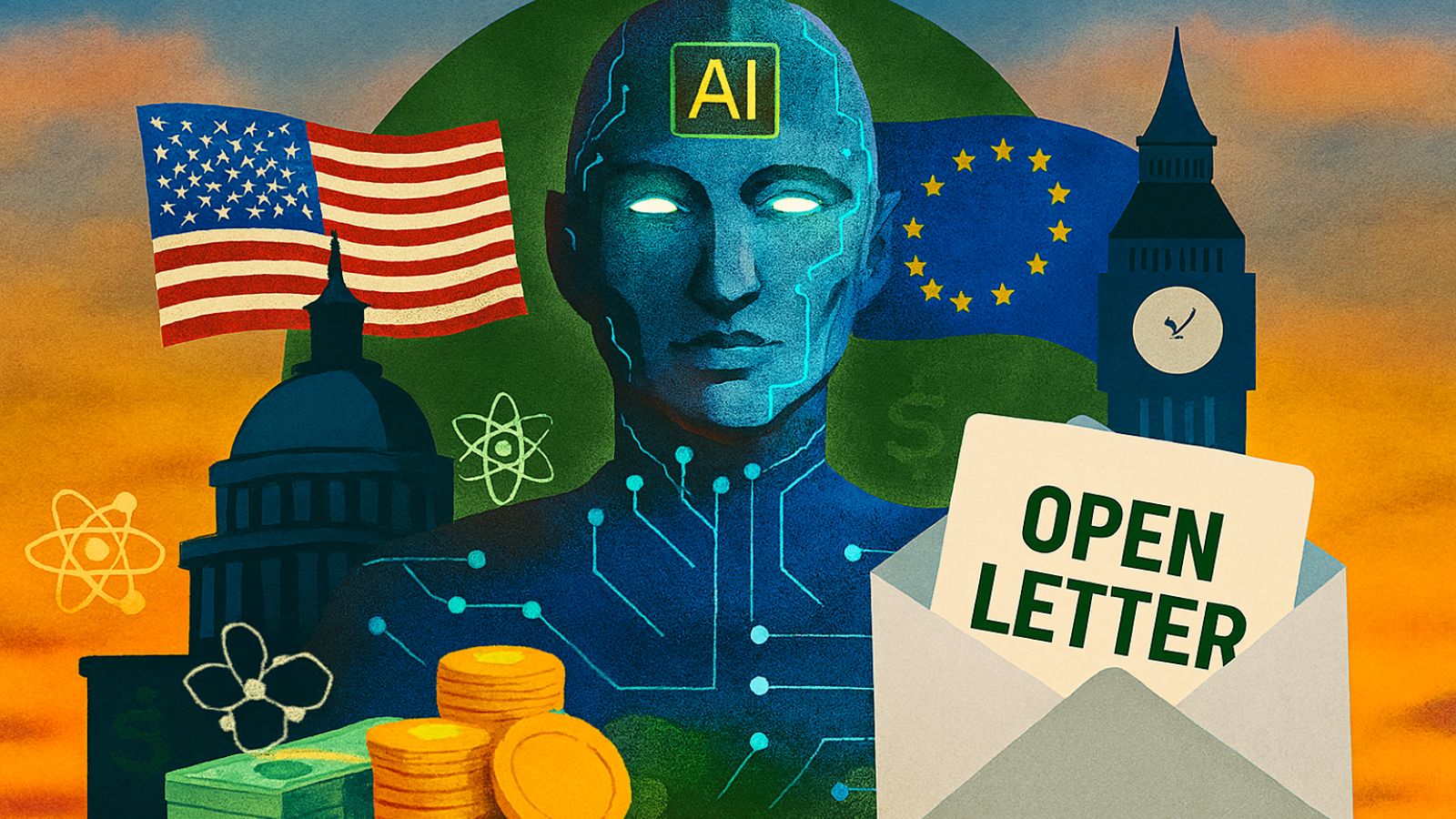

Especialistas, cientistas e personalidades públicas internacionais assinaram uma carta aberta (leia aqui) pedindo a suspensão imediata do desenvolvimento de sistemas de superinteligência artificial. Para eles, a tecnologia é capaz de ultrapassar as capacidades cognitivas humanas.

A iniciativa foi divulgada pelo Future of Life Institute, uma organização sem fins lucrativos com sede nos Estados Unidos que pesquisa os impactos éticos e sociais da Inteligência Artificial (IA).

O documento, intitulado "Pause Giant AI Experiments", argumenta que o avanço acelerado dessas tecnologias representa riscos à humanidade. O grupo pede que o desenvolvimento da chamada “superinteligência” seja interrompido até que exista um consenso científico sobre como tornar ela segura e controlável.

O grupo também defende que os avanços dessa tecnologia ocorram apenas com respaldo público e regulamentação internacional adequada.

Leia mais: X da questão: empresas estão treinando seus modelos de IA com os dados errados

Cientistas, empresários e líderes entre os signatários

Entre os signatários estão o ganhador do Nobel de Física de 2024, Geoffrey Hinton, considerado um dos “pais da inteligência artificial moderna”, Yoshua Bengio, professor da Universidade de Montreal, e Stuart Russell, pesquisador da Universidade da Califórnia, em Berkeley.

O texto também recebeu apoio de nomes fora do meio científico, como Richard Branson, fundador do grupo Virgin; Steve Wozniak, cofundador da Apple; e Paolo Benanti, assessor do papa Francisco e especialista em ética da tecnologia no Vaticano.

O avanço da superinteligência

O documento alerta que grandes empresas de tecnologia, como OpenAI, Google DeepMind e Anthropic, estão desenvolvendo sistemas capazes de atingir a Inteligência Artificial Geral (IAG), etapa em que as máquinas se igualaram às capacidades cognitivas humanas.

O passo seguinte seria a superinteligência, um nível em que sistemas autônomos poderiam ultrapassar a inteligência e o controle humanos.

Segundo reportagem do jornal francês, Le Monde, o presidente do Future of Life Institute, Max Tegmark, afirmou à Agence France-Presse (AFP) que construir algo dessa magnitude sem um marco regulatório global é inaceitável.

Tegmark destacou também que o objetivo não é interromper o desenvolvimento de sistemas úteis de IA, como aqueles voltados à cura de doenças, mas frear projetos que avancem sem controle ou transparência.

Esse vídeo pode te interessar:

Debate global sobre regulação

O pedido reforça discussões internacionais sobre o uso ético e responsável da inteligência artificial. Desde 2023, países da União Europeia, Reino Unido e Estados Unidos têm proposto leis para garantir transparência nos algoritmos, proteção de dados e salvaguardas éticas no avanço da tecnologia.

A carta do Future of Life Institute ressalta que a corrida pela superinteligência artificial não pode ocorrer às custas da segurança coletiva e da estabilidade global.

Leia mais: Dois avanços que passaram despercebidos, mas podem mudar o jogo da IA