Senado aprova marco regulatório da inteligência artificial; entenda

Com inspiração em regulamentação europeia, projeto de lei destaca análise de riscos e direitos autorais

O Senado aprovou nesta semana o marco legal da inteligência artificial. O projeto de lei (PL) 2338/2023 define as regras para desenvolvimento, produção e fiscalização da tecnologia no Brasil.

Pioneiras, as leis formalizam um sistema para fiscalizar a IA, criam filtros de risco para analisar a tecnologia e estabelecem limites de direitos autorais para uso das bases de dados. O documento segue agora para a Câmara dos Deputados.

Em discussão desde o ano passado, a regra é inspirada no AI Act , legislação da União Europeia que estabelece padrões para uso da IA. A regra analisa a tecnologia a partir de níveis de risco: do baixo risco a riscos excessivos.

Por exemplo: um sistema de IA que controla um veículo autônomo, considerado de alto risco, passará por mais exigências regulatórias do que uma IA que transcreve áudios, considerada de baixo risco.

Os riscos são analisados de acordo com a finalidade do sistema e o seu impacto sobre grupos de pessoas. Tecnologias com impacto significativo na segurança, na privacidade ou nos direitos dos cidadãos terão exigências mais rígidas, como maior supervisão e transparência.

Sistemas que selecionam estudantes, que podem mudar a vida de milhares de pessoas, serão considerados de alto risco. Assim como plataformas que fazem análise de currículos de trabalhadores e aquelas que são usadas para diagnósticos e procedimentos médicos.

Para a regra, existem usos de IA inaceitáveis. A lei proíbe a produção, o desenvolvimento e o uso de sistemas de IA de riscos excessivos, como usados para armas autônomas ou para explorar a vulnerabilidade de cidadãos. Plataformas que criam bots manipuladores ou deep fakes de menores de idade serão vedadas no Brasil.

RESPONSABILIZAÇÃO

O projeto prevê que desenvolvedores e operadores de IA sejam responsabilizados por danos que os seus sistemas gerem. Isso inclui desde falhas técnicas até impactos negativos em direitos fundamentais.

O cientista-chefe do Instituto de Tecnologia e Sociedade (ITS Rio), Ronaldo Lemos, se diz preocupado com o documento. “A ‘lei brasileira’ é uma cópia, ou melhor, uma caricatura, da lei europeia. Ela só trata de riscos. Não cuida de questões essenciais como futuro do trabalho, competitividade e concorrência”, diz.

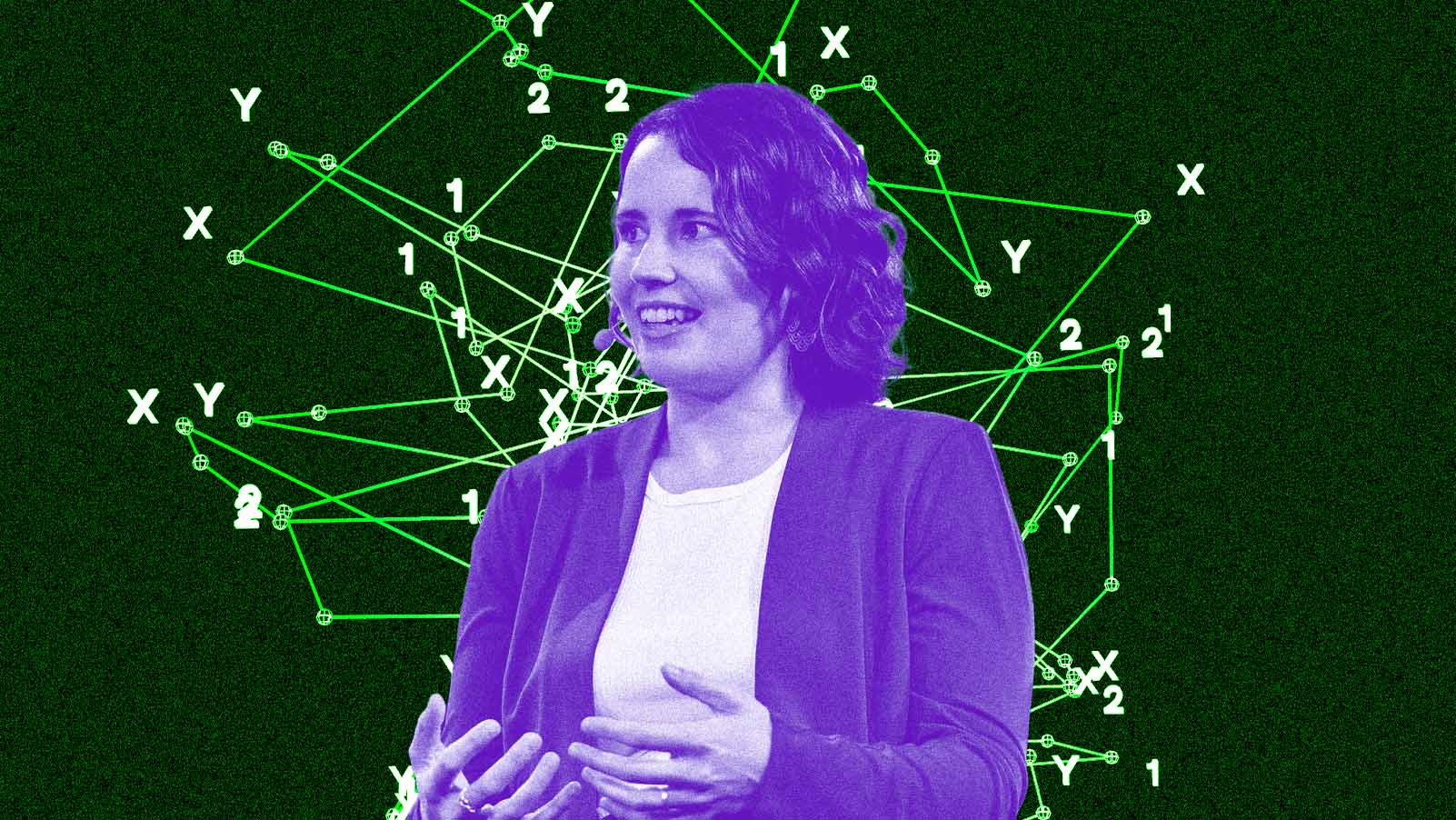

Ingrid Soares, advogada e cientista de dados, especialista em governança de IA, acredita que a regulamentação brasileira se afastou da europeia com as discussões nas comissões técnicas do Senado. Foram 14 audições públicas no total. Ingrid fez parte dos grupos de debate na Casa.

O Brasil poderá ser o primeiro país a exigir transparência dos chamados “outputs” da IA.

Para a advogada, a lei é positiva pois exige que as empresas entendam quais os riscos e as finalidades daquilo que produzem. “Existem diversos desenvolvedores e distribuidores que oferecem a solução, mas sequer têm visibilidade de como será utilizada", comenta.

Um dos diferenciais da regra brasileira é a proposta de criação do Sistema Nacional de Regulação e Governança de IA (SIA). A entidade fiscalizadora será ligada à Autoridade Nacional de Proteção de Dados (ANPD), mas também deve conversar com outras autoridades setoriais.

Caso o PL 2338 seja aprovado sem alterações, o SIA poderá identificar novas aplicações de alto risco ou reclassificar o risco das tecnologias. O objetivo é que a lei não fique desatualizada quando for aprovada, explica Ingrid.

TRANSPARÊNCIA ACIMA DE TUDO

A lei brasileira tem alguns pontos pioneiros, como a exigência da transparência algorítmica e a explicabilidade. As desenvolvedoras de IA de alto risco serão obrigadas a explicar como e porque a IA tomou uma decisão ou gerou certo resultado (os outputs).

Isso é algo que, em parte, já acontece com os protocolos de internet. Quando o usuário não consegue acessar um site, aparece uma tela que diz que o servidor demorou muito a responder. Há informações sobre o que o usuário pode fazer e o código de erro.

O Brasil poderá ser o primeiro país a exigir transparência dos chamados “outputs” da IA. A partir daí, surgem perguntas: como as desenvolvedoras comunicarão para o usuário “não entendido” de tecnologia? Em se tratando de redes neurais e sistemas generativos, que criam conexões próprias, como as companhias vão saber os resultados que elas podem dar?

Renato Opice Blum, advogado, presidente da Opice Blum Advogados e presidente da Comissão de Estudos de Novas Tecnologias, Neurodireitos e Inteligência Artificial do Instituto dos Advogados de São Paulo (IASP), acredita que, em algum momento, as companhias terão que informar que os resultados da IA são “inexplicáveis”.

Há críticas sobre quem são as plataformas obrigadas a dar explicações. O projeto foi alterado nas últimas tratativas no Senado, quando foi retirada a parte que falava sobre os sistemas de recomendação e moderação de redes sociais da categoria de alto risco.

“São, talvez, os sistemas de inteligência artificial mais presentes no dia-a-dia do povo brasileiro e, por isso, consideramos importante poder retomar esse aspecto no projeto”, afirma Alexandre Arns Gonzales, consultor da Coalizão Direitos na Rede, entidade que reúne mais de 50 organizações acadêmicas e da sociedade civil em torno do tema direitos digitais.

Gonzales trabalha em regulação das plataformas digitais na Coalizão e é membro do DiraCom. Apesar da crítica, para a Coalizão Direitos da Rede, a aprovação do projeto foi considerada "uma vitória”.

DIREITOS AUTORAIS DO GPT

O Marco Legal brasileiro se diferencia do europeu ao absorver questões sobre direito de autoria. Músicos, artistas e autores deverão ser notificados quando suas obras forem utilizadas para alimentar bases de dados de aprendizado de máquina. A permissão é “livre” caso a IA não seja voltada para uso comercial.

Além disso, autores terão a prerrogativa de vetar o uso de suas obras por esses sistemas, assegurando maior controle sobre direitos intelectuais. Outro ponto central é a criação de um ambiente experimental pelo órgão regulador de IA, previsto na lei, permitindo que empresas negociem diretamente com os autores o valor a ser pago pelo uso de suas criações.

“Não vi esse grau de detalhamento e depuração em outras regras de IA. Isso é inédito e um super amadurecimento”, diz Opice Blum. O assunto entrou na pauta da lei nos últimos dois meses, respondendo a pressões do mercado cultural e jornalístico.

Um dos diferenciais da regra brasileira é a proposta de criação do Sistema Nacional de Regulação e Governança de IA.

Mesmo amadurecida, a questão levanta pontos de atenção. De acordo com Caroline Capitani, vice-presidente de estratégia e inovação da ilegra, empresa global de estratégia, inovação e tecnologia, o desafio é identificar quem é o autor legal das obras.

Para Caroline, existe um desafio no entendimento dos direitos autorais, que é o de estabelecer o que é autoria quando uma IA generativa entra na equação. “Muitas vezes, é complicado entender quem seria o autor legal de uma obra que a IA generativa cria, se é o desenvolvedor da IA, o usuário que operou o sistema ou a organização que disponibiliza a ferramenta”, diz.

Já associações de empresas do setor de tecnologia, como a Associação Brasileira de Empresas de Software (ABES), veem a exigência de aviso para autores como uma trava para a competitividade do país no campo da IA.

O argumento é que sistemas mais "parrudos" de IA precisam de dados para se estruturar e aprender mais rápido. Além disso, há a obrigatoriedade em divulgar as bases de dados usadas para que algoritmos aprendam e sigam evoluindo.

FOCO NOS DESENVOLVEDORES

A proposta determina que os agentes dos sistemas de IA – desenvolvedores e distribuidores – deverão ter estruturas internas de governança para garantir a segurança e o atendimento das pessoas afetadas Os sistemas de alto risco deverão documentar, realizar testes e mitigar vieses discriminatórios.

O texto também propõe um sandbox, ou seja, um ambiente regulatório experimental, para sistemas inovadores de IA. A lei não deixa claro como será esse sandbox, apenas que ficará a cargo da SIA formatar regras e o tempo que as empresas podem estar nesse ambiente. Mesmo assim, significa um passo extra de burocracia para empresas entrantes do setor.

Para alguns críticos, isso significa que startups brasileiras terão mais dificuldade de entrar em algumas áreas de IA. Ronaldo Lemos, do ITS, diz que a lei é uma trava para a inovação brasileira. “Não tem um pensamento de como o Brasil pode se posicionar estrategicamente com relação à IA", critica o cientista.

Para outros especialistas, a lei cria oportunidades para companhias atuarem de forma mais segura desde o início, pois incentiva a produção de modelos de IA que já mapeiam possíveis danos. Na visão de Opice Blum, a burocracia que a regulamentação cria é natural e pode ser positiva.

“Quando você regula, está mostrando que esse mercado pode promover danos consideráveis e irreparáveis para as pessoas. E a IA é um setor de alto risco. Se a empresa não tem a capacidade de desenvolver um modelo que faça a segurança dos impactos de um setor de alto risco, talvez não deva entrar nele", diz o advogado.

O PL vai para a Câmara dos Deputados, onde será alvo de debates e de alterações. No entanto, o pontapé inicial foi dado. “É um passo importante para consolidar o Brasil como um player no cenário internacional", avalia Ingrid.