Sora consegue enganar especialistas em identificação de imagens feitas por IA

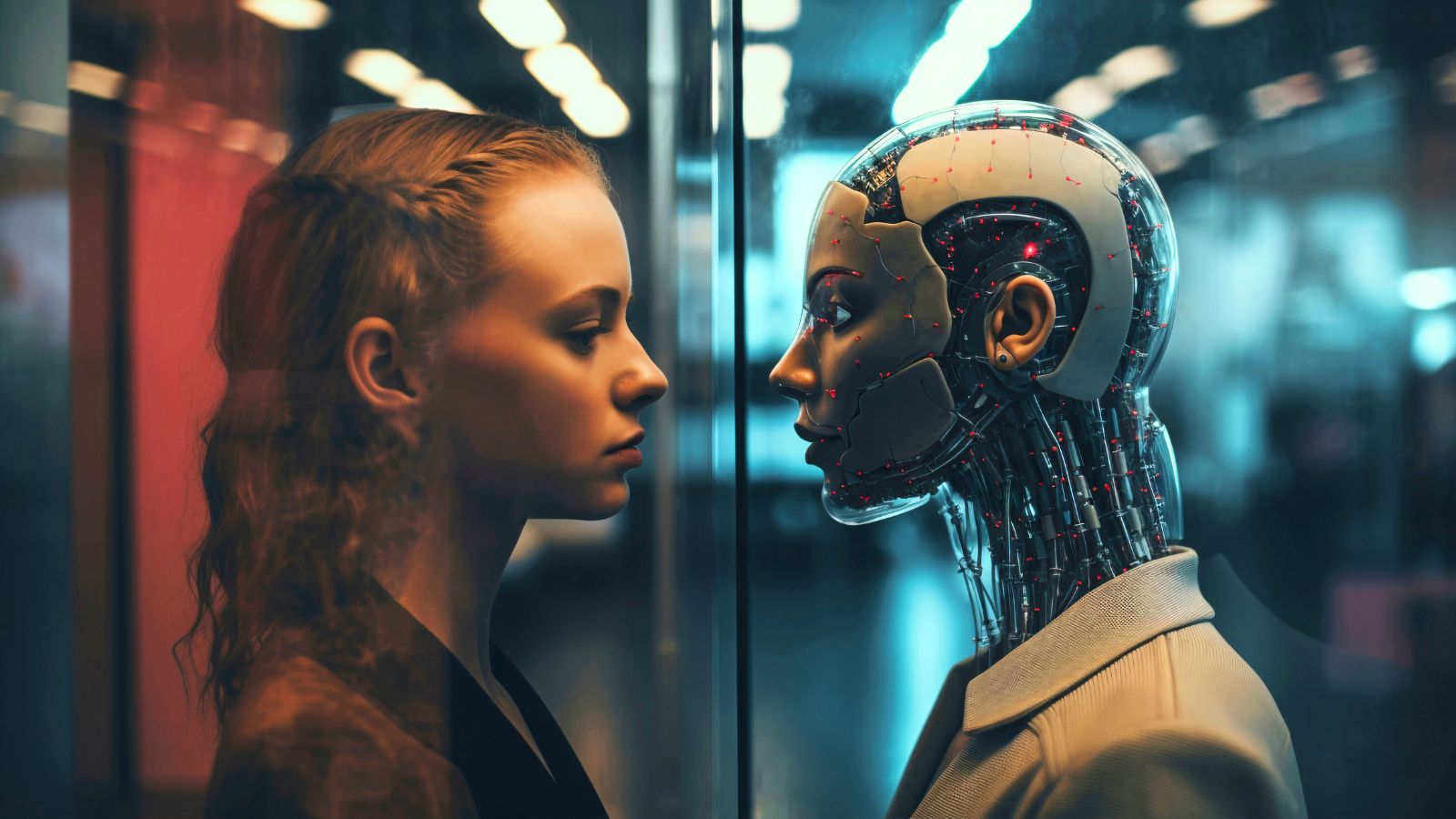

As pistas visuais que antes nos ajudavam a identificar conteúdos gerados por inteligência artificial estão desaparecendo rapidamente

Até pouco tempo atrás, as imagens geradas por inteligência artificial deixavam sinais evidentes de que não eram reais. A tecnologia criava pessoas com dedos a mais, membros extras, dentes desalinhados e uma pele com brilho e cor exagerados, como se tivessem saído de uma animação da Pixar.

A IA também tinha dificuldade para entender contextos. Se alguém pedisse uma imagem de um peixe nadando em um rio, por exemplo, ela podia gerar um filé de salmão boiando na água.

Vivíamos no famoso “vale da estranheza”. Mas, pelo menos, sabíamos disso. As imagens eram quase perfeitas, mas ainda causavam um certo desconforto.

Agora, nem isso. Embora ainda existam formas de identificar quando um conteúdo foi criado com a ajuda da inteligência artificial, as pistas visuais estão desaparecendo rapidamente.

O lançamento do Sora 2, novo modelo de geração de vídeos da OpenAI, só acelerou esse processo – o que significa que, em breve, talvez precisemos depender exclusivamente de ferramentas digitais e técnicas específicas para distinguir o que é real do que é artificial.

E isso não é um problema apenas para os usuários, mas também para instituições e empresas que precisam proteger suas imagens, marcas e identidades contra falsificação e uso indevido.

“Mesmo para especialistas como eu, que acompanharam a evolução dessa tecnologia, está ficando difícil – principalmente no caso de imagens”, afirma Francesco Cavalli, cofundador da Sensity AI, empresa especializada em identificar conteúdo manipulado.

“As formas, as cores, as pessoas – tudo está perfeito. Sem a ajuda de ferramentas específicas, é praticamente impossível para o usuário comum saber se uma imagem, vídeo ou áudio foi gerado por IA.”

PISTAS VISUAIS ESTÃO DESAPARECENDO

Antes, distorções físicas denunciavam o uso de inteligência artificial. Mas, segundo Emmanuelle Saliba, ex-jornalista e hoje diretora da GetReal Security, empresa de cibersegurança especializada em identificar conteúdo gerado e manipulado por IA, o Sora 2 atingiu um novo nível de realismo, reproduzindo o mundo físico com muito mais precisão.

Na Reality Defender, também especializada em detectar deepfakes, todos os pesquisadores já foram enganados por conteúdos produzidos por novas gerações de ferramentas de IA.

Nem as marcas d’água têm dado conta de resolver o problema. Apesar de as empresas as promoverem como solução para identificar imagens geradas por inteligência artificial, existem maneiras simples de removê-las. Os vídeos criados pelo Sora, por exemplo, incluem uma marca d’água, mas ferramentas online conseguem apagá-la facilmente.

Assim como outras empresas, a OpenAI adotou o padrão C2PA, desenvolvido pela Coalition for Content Provenance and Authenticity (iniciativa criada por grandes empresas de tecnologia e mídia voltada ao combate à desinformação visual), que registra a origem do conteúdo em seus metadados.

Mas basta tirar uma captura de tela de uma imagem gerada ou, em alguns casos, simplesmente arrastar e soltar o arquivo para remover a marca d’água.

A OpenAI reconheceu a falha, mas afirmou não ter conseguido reproduzir o problema de “arrastar e soltar”. Já a Adobe, que opera a ferramenta de verificação C2PA, disse à Fast Company que o erro estava no lado da OpenAI.

ATUALIZANDO AS TÉCNICAS

É claro que as empresas com as quais a Fast Company conversou estão interessadas em vender diversos produtos projetados para nos proteger da enxurrada de deepfakes.

Algumas preveem que a detecção de conteúdo gerado por IA pode seguir o caminho da varredura de vírus e ser integrada a inúmeras ferramentas online e corporativas.

Outras sugerem que suas plataformas serão necessárias porque o surgimento de ferramentas como o Sora 2 tornará a verificação baseada em videochamadas obsoleta.

o Sora 2 atingiu um novo nível de realismo, reproduzindo o mundo físico com muito mais precisão.

Seja como for, o lançamento do Sora provocou um aumento na demanda pelos serviços dessas empresas. Mas até elas precisam atualizar constantemente suas metodologias a cada nova geração de modelos de IA. “Mesmo que o ser humano não consiga detectar nada do ponto de vista técnico, sempre há algo a ser investigado”, afirma Cavalli, da Sensity.

Essas análises geralmente combinam diferentes abordagens – desde a leitura dos metadados de um arquivo até a detecção de ruídos de fundo e pequenas inconsistências. Segundo Cavalli, os sistemas da Sensity são reprogramados e aprimorados sempre que um novo modelo é lançado.

Mas nem isso é suficiente. Siwei Lyu, professor na Universidade Estadual de Nova York que estuda deepfakes explica que, embora seus sistemas ainda consigam identificar vídeos gerados pelo Sora 2, a precisão caiu em relação aos modelos anteriores – mesmo após ajustes.

Ainda não está claro se os métodos atuais de detecção de deepfakes continuarão eficazes. Por enquanto, parece que estamos entrando em uma era dominada por conteúdos artificiais enquanto ainda tentamos erguer barreiras para conter essa crescente onda de criações da IA.