Todo mundo quer uma fatia do mercado da Nvidia, mas vai ser duro conseguir

Quanto mais analisamos as complexidades do mercado de chips de IA, mais percebemos que outra empresa dificilmente vai conseguir derrubar a Nvidia

Até agora, a Nvidia forneceu a grande maioria dos processadores usados para treinar e operar modelos avançados de IA, como aqueles que sustentam o ChatGPT.

Empresas de tecnologia e laboratórios de IA não gostam de depender excessivamente de um único fornecedor de chips, especialmente à medida que suas necessidades de capacidade computacional crescem. Por isso, buscam maneiras de diversificar.

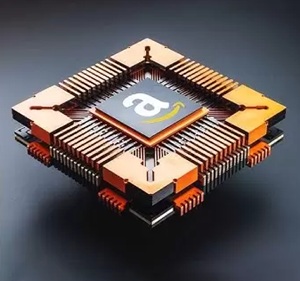

Nesse movimento, players como AMD e Huawei, além de gigantes da nuvem como Google e Amazon AWS – que acaba de lançar seu novo chip Trainium3 –, correm para aprimorar suas próprias versões de aceleradores de IA (processadores projetados para acelerar tipos específicos de tarefas computacionais).

Será que no futuro a concorrência conseguiria reduzir a Nvidia, hoje dominante, a apenas mais um fornecedor entre vários, abalando as bases tecnológicas do setor? Ou a maré crescente de demanda por chips de IA será grande o suficiente para levar todos os barcos? São perguntas que valem trilhões.

O Google sacudiu discretamente o setor ao mencionar, quase de passagem, que treinou seu novo e impressionante modelo Gemini 3 Pro inteiramente em suas próprias unidades de processamento tensor (TPUs), outra categoria de chips aceleradores de IA.

A revelação levou analistas a questionar se a dependência da indústria de IA em relação aos chips da Nvidia ainda se justifica. Afinal, eles são muito caros: uma parte significativa dos bilhões investidos hoje na expansão dos data centers de IA está indo diretamente para a empresa.

CHIPS DE IA "GENERALISTAS" x "ESPECIALISTAS

As TPUs do Google começam a se parecer mais com uma alternativa real à Nvidia. Já é possível alugar TPUs nos data centers do Google e, segundo relatos, a big tech estuda vender os chips diretamente para outras companhias de IA, incluindo Anthropic e Meta. Em outubro, a Anthropic anunciou que usaria até um milhão de TPUs em data centers do Google para desenvolver seus modelos Claude.

Vender TPUs diretamente colocaria o Google, tecnicamente, em competição com a Nvidia. Mas isso não significa que a empresa esteja disposta a disputar o mercado de chips para IA.

Afinal, o Google é também um dos maiores compradores de GPUs da Nvidia. A venda de TPUs para alguns clientes pode ser vista como uma extensão natural do aluguel dessas unidades operando na nuvem do Google.

A IDC projeta que a alta demanda por capacidade computacional de IA não deve diminuir tão cedo.

Essa lógica faz sentido quando os clientes precisam executar tipos de processamento de IA nos quais as TPUs são especialmente eficientes, explica Brandon Hoff, analista da IDC.

Enquanto as GPUs da Nvidia são verdadeiros trunfos capazes de executar uma ampla gama de tarefas, quase todas as grandes empresas de tecnologia desenvolveram aceleradores próprios, projetados sob medida para seus casos mais específicos.

A Microsoft desenvolveu chips otimizados para os serviços em nuvem da Azure. Os chips Trainium da Amazon são especialmente bons em tarefas relacionadas ao e-commerce, como sugestões de produtos e logística de entrega. As TPUs do Google se destacam ao veicular anúncios segmentados em suas plataformas e redes.

A grande vantagem da Nvidia tem sido a potência de seus chips: eles são a razão pela qual modelos de linguagem gigantes se tornaram possíveis. São também excelentes generalistas, capazes de lidar com uma ampla variedade de cargas de trabalho de IA.

Além disso, são flexíveis, funcionando em diferentes plataformas. Assim, se uma empresa quer executar seus modelos em mais de uma nuvem, é provável que desenvolva esses modelos para rodar em chips Nvidia, já que todas as grandes nuvens os utilizam.

DEMANDA DEVE CONTINUAR EM ALTA

Ainda assim, o risco de dependência excessiva de um único fornecedor continua uma grande preocupação, especialmente por conta dos investimentos bilionários de big techs e laboratórios de IA na expansão de data centers. A preferência é clara: usar uma combinação de chips de diferentes fabricantes.

A IDC projeta que a alta demanda por capacidade computacional de IA não deve diminuir tão cedo. “Vemos os provedores de nuvem crescendo rapidamente, mas seus gastos vão desacelerar”, afirma Hoff.

a Anthropic anunciou que vai usar TPUs do Google para desenvolver seus modelos Claude.

Além disso, uma segunda onda de demanda pode vir de “fundos soberanos”, como a Arábia Saudita, que está construindo o Humain, um grande complexo de infraestrutura de IA que será financiado e controlado pelo país.

Outro movimento pode vir de grandes multinacionais interessadas em criar infraestruturas de IA “soberanas”, explica Hoff. “Há muita coisa para 2027 e 2028 que continuará impulsionando a demanda.”

Existem muitas narrativas do tipo “concorrente desafia a Nvidia”. Mas, quanto mais se explora as complexidades econômicas e dinâmicas competitivas do mercado de chips de IA, mais o argumento perde força.

À medida que a IA encontra novas aplicações em empresas e no consumo, os modelos serão chamados a executar cada vez mais tipos de tarefas, cada uma exigindo combinações diferentes de chips generalistas ou especializados.

Assim, embora a pressão competitiva sobre a Nvidia esteja crescendo, ainda há muitos motivos para que players como Google e Amazon sigam colaborando com ela.

“Nos próximos dois anos, haverá mais demanda do que oferta, então quase nada disso importa”, diz Patrick Moorhead, analista chefe da Moor Insights & Strategy. Ele acredita que, daqui a cinco anos, as GPUs da Nvidia ainda terão 70% do mercado.