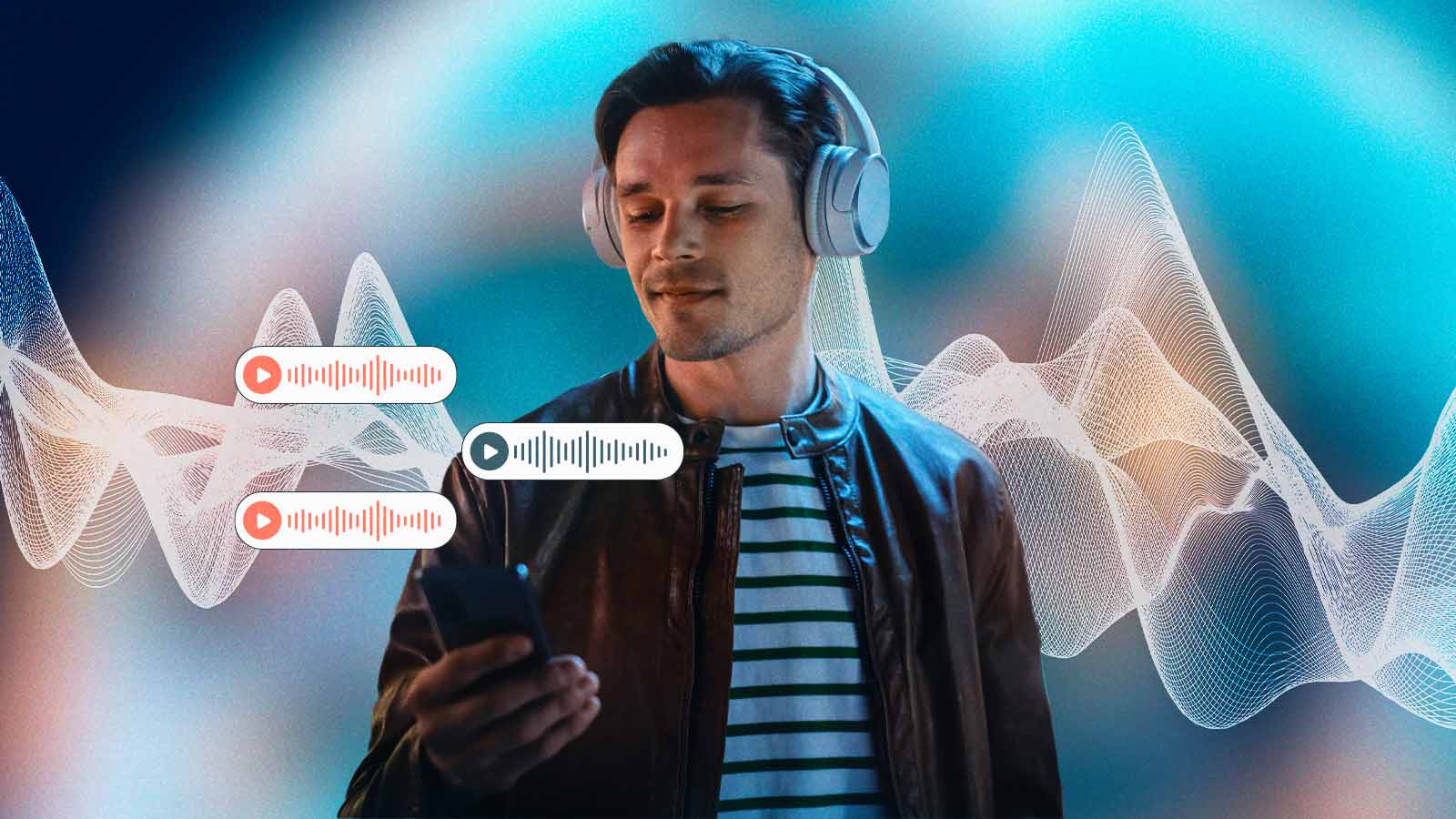

Cientistas ensinam como reconhecer um deepfake em áudio

Pesquisadores estão usando dinâmica de fluidos para detectar vozes artificiais

Imagine a seguinte situação: o telefone toca, uma pessoa atende e ouve sua chefe do outro lado da linha, em pânico, dizendo que esqueceu de transferir dinheiro para um dos funcionários antes de sair do escritório e que precisa que faça isso para ela. Então, passa as informações da conta e, com a transferência realizada, o problema é resolvido.

O funcionário se recosta em sua cadeira, respira fundo e vê a chefe entrar pela porta. A voz do outro lado do telefone não era dela. Na verdade, nem era humana. O que ele ouviu foi um deepfake gerado por computador, com o objetivo de se passar por sua chefe.

Golpes usando áudios manipulados já ocorreram antes e deepfakes capazes de interagir em conversas não são uma realidade distante.

Deepfakes, tanto de áudio quanto de vídeo, se tornaram possíveis com o desenvolvimento de tecnologias sofisticadas

deepfakes capazes de interagir em conversas não são uma realidade distante.

de machine learning nos últimos anos. Hoje, geram desconfiança quanto à veracidade de certos formatos de mídia. Para identificá-los, pesquisadores passaram a analisar elementos visuais – pequenas falhas e inconsistências – encontrados em deepfakes de vídeo.

Quando se trata de áudio, no entanto, eles representam um perigo ainda maior. Na maioria das vezes, as pessoas se comunicam por voz, não por vídeo – como por meio de chamadas telefônicas, rádio e gravações de voz. Isso abre mais espaço para que pessoas mal-intencionadas enganem possíveis vítimas.

Para detectar deepfakes de áudio, nós e nossos colegas de pesquisa da Universidade da Flórida desenvolvemos uma técnica que mede as diferenças acústicas e dinâmicas de fluído entre amostras geradas sinteticamente por computador e gravações de voz humana.

VOZES ORGÂNICAS X SINTÉTICAS

A voz humana é o resultado do som produzido pela passagem do ar sobre as várias estruturas do trato vocal, incluindo pregas vocais, língua e lábios. Ao articular essas estruturas, podemos alterar as propriedades acústicas do trato vocal, nos permitindo reproduzir mais de 200 sons ou fonemas distintos.

um farsante precisa só digitar uma frase para criar um deepfake que soa exatamente como a pessoa por quem quer se passar.

No entanto, a anatomia humana limita fundamen- talmente a acústica desses diferentes fonemas, resultando em uma faixa relativamente pequena de sons para cada um.

Os deepfakes de áudio, por sua vez, são criados a partir de gravações. Dependendo das técnicas usadas, o computador precisa ouvir de 10 a 20 segundos de áudio para extrair informações sobre as características da voz de um indivíduo.

A partir de um algoritmo de conversão de texto em fala, um farsante precisa apenas digitar uma frase para criar um deepfake de áudio que soa exatamente como a pessoa por quem quer se passar.

Esse processo pode ser realizado em questão de segundos, possibilitando seu uso em conversas.

DETECTANDO DEEPFAKES DE ÁUDIO

O primeiro passo para diferenciar a fala humana de deepfakes é entender o modelo acústico do trato vocal. Felizmente, cientistas têm técnicas para prever como alguém soaria, com base nas medidas anatômicas de seu trato vocal.

o deepfake de áudio, não importa o quão convincente, está longe de ser idêntico à fala humana.

Fizemos o contrário. Ao fazer o caminho inverso de muitas dessas mesmas técnicas, conseguimos extrair de uma gravação a estimativa do trato vocal de um falante. Isso nos permitiu examinar sua anatomia.

A partir disso, levantamos a hipótese de que os deepfakes não estariam restritos às mesmas limitações anatômicas que os humanos. Em outras palavras, a análise do áudio identificou estruturas de trato vocal anatomicamente impossíveis.

Nossos testes confirmaram a hipótese. Isso demonstra que o deepfake de áudio, não importa o quão convincente, está longe de ser idêntico à fala humana. Ao examinar a anatomia da voz presente na gravação, é possível identificar se o áudio foi gerado por um computador ou dito por uma pessoa de verdade.

POR QUE ISSO IMPORTA

O mundo de hoje é baseado na troca de mídias e informações digitais. Tudo, desde notícias e entretenimento à troca de mensagens entre entes queridos, se dá através de interações digitais. Os deepfakes, seja no formato de vídeo ou áudio, minam a confiança nessas trocas.

Para que o mundo digital continue a ser um recurso vital para a troca de informações, precisamos de técnicas eficazes e seguras que consigam determinar a fonte de um áudio.