Críticos apontam falta de transparência sobre tecnologia do ChatGPT-4

O GPT-4 acaba de ser lançado, mas com poucos detalhes sobre como o modelo realmente funciona

O tão falado e aguardado GPT-4 finalmente foi lançado. Em uma postagem em seu blog, a OpenAI, a empresa por trás do ChatGPT, anunciou seu mais recente modelo de inteligência artificial.

Como previsto, os resultados são impressionantes: o modelo multimodal – que, ao contrário de seu antecessor, aceita comandos no formato de imagem e texto – exibe um “desempenho semelhante ao humano” em várias tarefas.

Citar implicações de segurança como motivo é uma desculpa, afirma a pesquisadora Catherine Flick.

No exame da ordem dos advogados dos EUA (equivalente à prova da OAB), ele ficou entre os 10% melhores e foi capaz de passar em uma bateria de testes padronizados com habilidade incrível.

Mas para alguns, o que mais chama atenção não são os resultados surpreendentes. É a falta de transparência. Embora a OpenAI tenha divulgado um documento de 98 páginas, a empresa é relativamente discreta quando o assunto é a tecnologia em si.

“Dado o cenário competitivo e as implicações de segurança de modelos de grande escala como o GPT-4, este relatório não contém mais detalhes sobre a arquitetura (incluindo o tamanho do modelo), hardware, computação de treinamento, construção de conjunto de dados, método de treinamento e similares,” diz o relatório.

INTELIGÊNCIA NÃO TÃO 'ABERTA'

A explicação não agradou a alguns membros da comunidade acadêmica. Citar implicações de segurança como motivo é uma “desculpa”, afirma Catherine Flick, pesquisadora em computação e responsabilidade social na Universidade De Montfort, no Reino Unido.

“É sobre competitividade. Se realmente fosse uma inteligência artificial ‘aberta’ [fazendo alusão ao nome da empresa, OpenAI], eles buscariam ser o mais transparentes possível.”

A decisão de não divulgar como o GPT-4 foi treinado é uma prática conhecida como “segurança por obscurantismo”.

O ponto central é que os pesquisadores deveriam ter acesso aos dados que treinaram o chatbot, acredita de Irina Raicu, diretora do Programa de Ética na Internet do Centro Markkula de Ética Aplicada da Universidade de Santa Clara, na Califórnia. “Sabendo o que está no conjunto de dados os pesquisadores poderiam apontar falhas”, diz ela.

Mas isso pode muito bem ser uma estratégia legal, talvez relacionada ao processo aberto contra seu concorrente direto, Stability AI, em janeiro por, supostamente, ter usado o banco de imagens da Getty Images para treinar seu modelo de IA.

“Isso vai se tornar o padrão daqui para frente”, diz Andres Guadamuz, pesquisador de direito de propriedade intelectual da Universidade de Sussex, no Reino Unido.

Procurada, a OpenAI não respondeu até a publicação deste artigo.

VULNERABILIDADES

A decisão de não divulgar como o GPT-4 foi treinado, nem mesmo o tamanho do modelo ou como foi construído, é uma prática conhecida como “segurança por obscurantismo”, explica Guadamuz. “A transparência o torna vulnerável.”

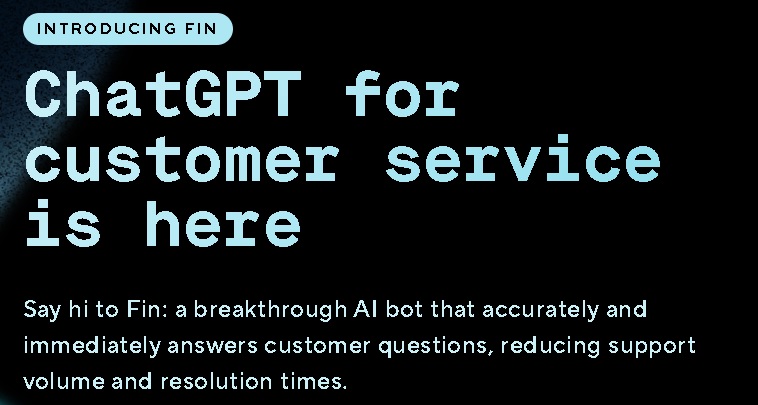

Mas, quando se fala de uma tecnologia transformadora, isso é muito importante. Os antecessores do GPT-4 – ChatGPT e GPT-3 – já foram incorporados a vários aplicativos. Poucas horas após o anúncio da OpenAI, o novo modelo de IA já estava sendo usado em aplicações humanitárias e no bot de atendimento ao cliente da empresa de software Intercom.

Segundo os críticos, a provável onipresença da tecnologia GPT-4 faz com que seja ainda mais importante que a população tenha acesso a informações sobre o modelo de IA. Sem saber como funciona, é mais difícil identificar suas falhas – o que será fundamental à medida que a inteligência artificial se entrelaça em nossas vidas cotidianas.

Além da OpenAI, Flick está preocupada com o fato de que a corrida para construir modelos de IA mais novos e

quando se fala de uma tecnologia transformadora, transparência é muito importante.

poderosos tenha criado um cenário que impede um desenvolvimento cuidadoso, que corresponda ao impacto social que eles podem ter.

“É um espaço competitivo e eles querem continuar lançando protótipos não testados para se manter à frente dos outros, prometendo correções futuras para aspectos técnicos não essenciais, como transparência”, diz ela.

“Na prática, é provável que os modelos não sejam realmente trabalhados adequadamente, porque o foco mudará das correções para o lançamento de uma próxima versão.”

Há ainda a questão de como a OpenAI está criando hype em torno do produto e o que está sugerindo implicitamente com isso. “Para mim, o mais impressionante neste lançamento foi o quanto eles destacaram o desempenho no exame da ordem de advogados e em outros testes padronizados”, diz Nick Seaver, diretor do programa de ciência, tecnologia e sociedade da Universidade Tufts.

“A empresa está sugerindo que o que nos define como humanos é a capacidade de passar nesses testes. Mas essas avaliações não são um bom parâmetro”, critica.