Efeito Elon Musk: sem moderação, Twitter se torna rede social mais agressiva e violenta

Como governo, sociedade e empresas podem responder à postura da plataforma em meio ao debate sobre responsabilização das redes

O Twitter passa por seu maior desafio no Brasil. Em meio a dois ataques a escolas, a rede social se tornou o centro de um debate complexo: a responsabilização pelo discurso de ódio e pelas postagens violentas nas redes sociais. A questão envolve mais do que apenas algoritmos, mas também os governos, os usuários e até as marcas.

De um lado, o governo anunciou que irá pedir para retirar contas do ar, além de ameaçar as plataformas com multas. As marcas, que procuram cada vez mais colocar suas mensagens ao lado de conteúdos seguros, também prestam atenção ao tema.

Já a sociedade civil tenta se recuperar do choque da morte de crianças após os ataques nas escolas, buscando entender como evitar novas tragédias.

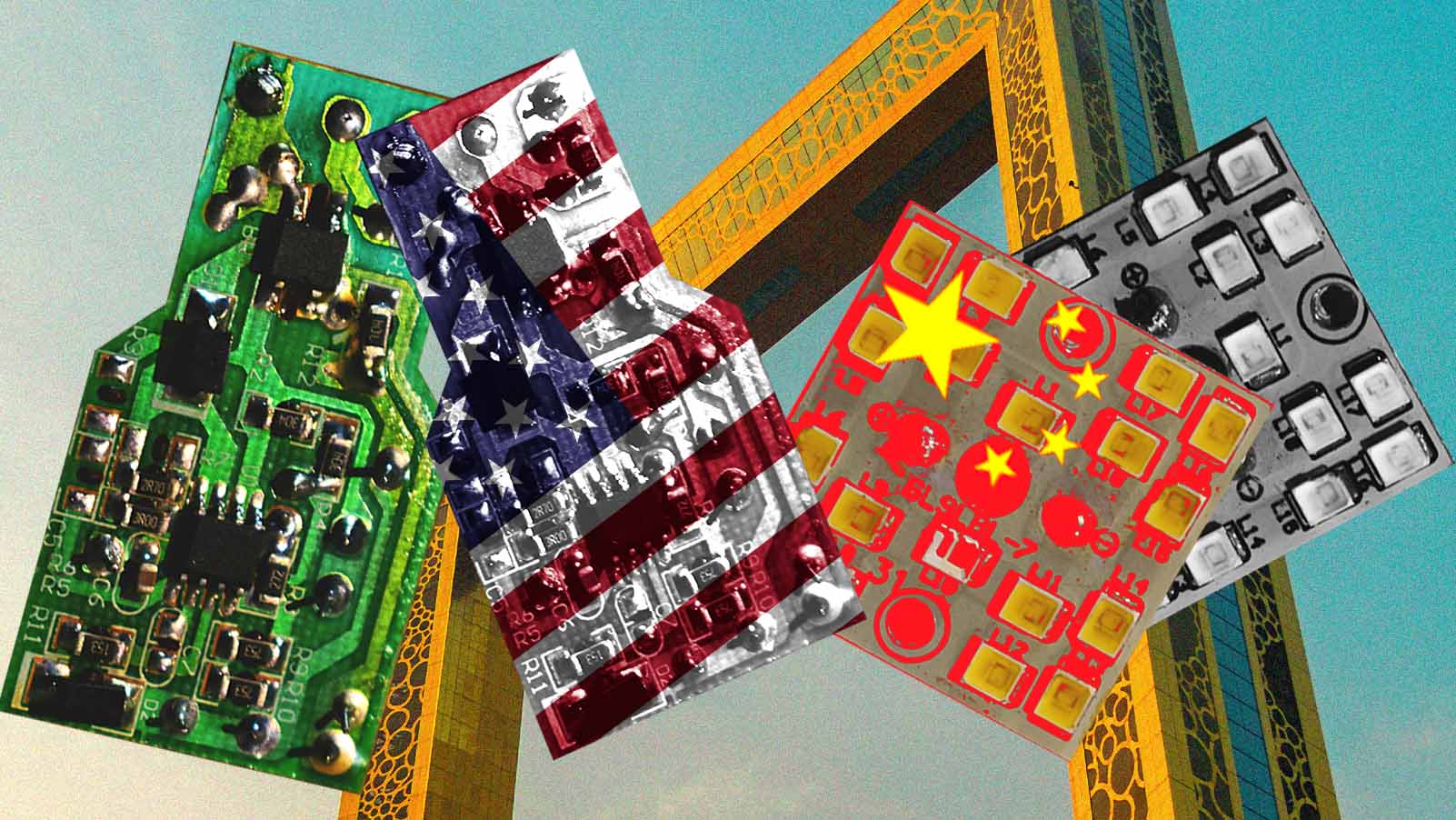

No lado oposto disso tudo está Elon Musk. O bilionário se autointitula “absolutista da liberdade de expressão” e levou suas crenças pessoais para dentro do Twitter, ao comprar a plataforma por US$ 44 bilhões em outubro do ano passado.

Mas seu “relacionamento” com a rede social começou bem antes. Coincidentemente, há um ano. Os primeiros indícios de que Musk queria comprar o Twitter apareceram em uma postagem feita no dia 14 de abril de 2022.

De lá para cá, a companhia fechou o capital e promoveu demissões em massa. Entre os seis mil demitidos estava toda a equipe brasileira de moderação, bem como times inteiros ligados aos dispositivos de Confiança & Segurança.

"Todos os mecanismos de proteção de conduta empresarial evaporaram. A conduta de um bilionário passou a definir como a plataforma é tocada”, diz Humberto Ribeiro, cofundador e diretor legal e de pesquisas do Sleeping Giants Brasil.

A ação teve consequências nos últimos meses. “A moderação do Twitter sempre foi falha, mas existia. Houve um total desmantelamento do time de moderação e as mensagens de ódio proliferaram”, afirma David Nemer, antropólogo, professor de estudos de mídia na Universidade da Virgínia e autor do livro “Tecnologia do Oprimido”.

A ativista, codificadora, designer e pesquisadora em privacidade de dados na Unico IDTech, Yasodara Córdova, chama a explosão de conteúdo impróprio e de perfis radicalizados no Twitter de “efeito Elon Musk”.

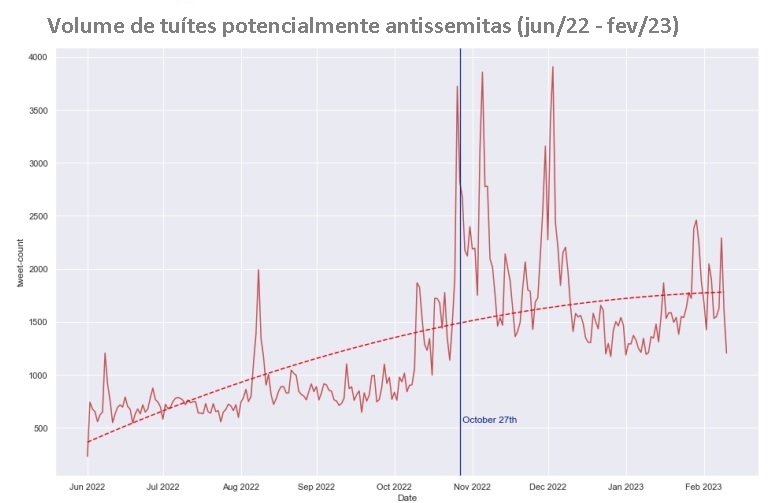

Desde o final de 2022, houve alta de 105% nos discursos antissemitas publicados na plataforma, como indica pesquisa da CASM Technology. Já o Center for Countering Digital Hate (Centro de Combate ao Ódio Digital, ou CCDH) mostrou alta de 119% nos discursos anti-LGBTQ+ no Twitter em comparação com a era pré-Musk.

SEM FILTRO, SEM MODERAÇÃO E SEM LIMITE

O Brasil é o quarto país com mais usuários da plataforma (cerca de 20 milhões). Nemer explica que o Twitter é como um “hub de distribuição de mensagens falsas e postagens radicais”. “É uma rede que faz parte do ecossistema de desinformação, já que as postagens podem ser ‘printadas’ e republicadas em outras redes”.

Responsáveis por pesquisas sobre grupos de extrema direita nas redes sociais afirmam que houve um salto na quantidade de usuários e perfis que falam sobre ataques em escolas no Twitter. “Depois do atentado à [escola da] Vila Sônia, o número de perfis e postagens sobre o tema explodiu”, diz Letícia Oliveira, editora do El Coyote e especialista em monitoramento online de grupos de extrema direita.

O grupo de trabalho de Oliveira, ligado à Campanha Nacional Pelo Direito à Educação, fez relatórios de análise da extrema direita para o governo de transição. Para a especialista, a permissividade facilitou a formação de comunidades que, antes, ficavam em espaços da chamada “dark web”, plataformas de nicho mais complexas de se entrar.

A análise das postagens, em comparação com as publicações no TikTok, no Telegram e no WhatsApp, mostrou que os usuários são mais agressivos e violentos no Twitter. Para Letícia, a falta de supervisão é uma das razões desse comportamento.

“Como são mensagens que geram ódio, medo, ansiedade e comoção negativa – e costumam engajar mais –, o algoritmo tende a priorizar e dar mais peso para esse tipo de conteúdo”, diz Nemer.

a permissividade facilitou a formação de comunidades que, antes, ficavam em espaços da chamada “dark web”.

Na última semana, a assessora especial do Ministério da Justiça, Estela Aranha, apontou em sua página oficial no Twitter que recebeu recomendações do algoritmo para seguir páginas que fazem apologia aos ataques a escolas.

No final de março, a rede social publicou a íntegra do seu algoritmo na internet. A partir deste documento, foi possível entender quais tipos de conteúdo viralizam e se espalham. Na prática, quem ganha visualização no Twitter são os perfis “verificados”.

Como agora o selo de verificação é pago ao se assinar o Twitter Blue, não há controle sobre quais mensagens ganham espaço na plataforma. Para Nemer, as pessoas estão se aproveitando da compra do verificado para disseminar discurso de ódio.

REPERCUSSÃO NEGATIVA

Esta semana, o Twitter informou que passará a colocar um rótulo nas postagens com supostos discursos de ódio, além de reduzir a visualização destes conteúdos. O que não reduz o efeito que tais mensagens podem ter em grupos radicalizados de WhatsApp e Telegram. A escolha é, portanto, manter o conteúdo, avisando os usuários sobre o teor das postagens.

O governo aprovou, em regime de urgência, portaria que obriga a retirada de conteúdos que promovem violência contra estudantes.

Letícia observa a ação de grupos de extrema direita ligados a ataques a escolas desde dezembro do ano passado. Dos 160 grupos monitorados, apenas três foram banidos nos últimos meses.

O governo brasileiro, no entanto, não se contentou com isso. Como parte da força tarefa para discutir a segurança nas escolas, o Ministério da Justiça se reuniu com as principais redes sociais para falar sobre o volume de publicações que exaltam atiradores e responsáveis por ações violentas em escolas.

Segundo o blog da jornalista Julia Dualibi, o Twitter se negou a retirar tais conteúdos do ar, alegando não ver neles violação dos termos de conduta da empresa. Ainda segundo a nota, uma representante da empresa, Adela Goberna, chegou a dizer que um perfil com foto de assassinos de crianças não configurava apologia ao crime.

O ato provocou uma reação do ministério, que chegou a anunciar multas contra o Twitter – o que não foi levado a cabo. Nas redes sociais, a repercussão do caso acabou gerando uma resposta na forma da hashtag #twitterapoiamassacres, impulsionada pelo influenciador Felipe Neto e por movimentos como o Sleeping Giants Brasil.

No final da semana, a rede cedeu e passou a retirar alguns dos perfis apontados pela força tarefa do governo. Segundo especialistas, este é apenas o primeiro passo que, na ausência de um sistema local de moderação de conteúdo, não dá conta da quantidade de perfis radicalizados que proliferam.

“A moderação pressupõe que o moderador seja falante da língua na qual o conteúdo foi publicado, já que é preciso conhecer o contexto social. Sem uma moderação adequada, os riscos de passar conteúdo de racismo, desinformação e discurso de ódio são enormes”, diz Ribeiro, do Sleeping Giants Brasil.

A Fast Company Brasil pediu ao Twitter, por email, um posicionamento sobre a questão, além de uma entrevista com a representante que teria participado da reunião com o governo. Como resposta, recebeu um emoji de cocô. Trata-se de uma mensagem automática a todos os jornalistas que tentam contactar a empresa, medida anunciada por Musk no final de março.

Na semana passada, a BBC publicou uma entrevista com o bilionário. Na conversa, ele pediu para que o jornalista comprovasse que havia desinformação e discurso de ódio na rede e negou os fatos. Em seu perfil do Twitter, a BBC foi rotulada como “mídia estatal”, identificação que, após protesto da empresa, mudou para “mídia financiada por recursos públicos”.

AS @S CONTRA-ATACAM

O governo aprovou, em regime de urgência, a portaria Nº 351/2023, que obriga as empresas digitais a retirarem conteúdos que promovem violência contra estudantes. Além disso, exige que elas enviem informações sobre as regras de recomendação dos algoritmos.

Para Yasodara, a ação pode ter um resultado positivo, mas deve ir além, tanto em escopo, quanto em narrativa.

“O governo tem seu papel, inclusive de regular economicamente o lucro que as plataformas obtêm com esse tipo de conteúdo. Por exemplo, reforçar o policiamento nas redes, melhorando o treinamento das unidades de cyber da polícia para que investiguem nazistas, misóginos, homofóbicos e racistas online”.

David pondera que, apesar da urgência em exigir a moderação nas redes sociais, é preciso ter calma para evitar medidas que imponham um limite entre segurança e vigilância. Para Letícia, a regulamentação é importante e não se trata de censurar as redes, mas sim de assegurar que "a vida de uma pessoa valha mais do que os termos de uso das plataformas”.

Enquanto o Twitter se limita a mandar emojis mal-educados em meio à discussão sobre como evitar ataques em escolas, os usuários e as empresas podem se posicionar. Em outras palavras, uma mudança efetiva passa pelo bolso de Musk.

“Quando as empresas que anunciam nessas redes forem cobradas, a coisa muda de figura. Enquanto esse tipo de conteúdo for lucrativo para quem vende anúncios e para quem anuncia, não tem jeito. Os anunciantes precisam se conscientizar de que sua reputação está em risco”, afirma Yasodara.

"Os anunciantes são essenciais para a mudança do sistema”, concorda Ribeiro, do Sleeping Giants Brasil, organização que atua para desmonetizar veículos e perfis que promovem desinformação e discurso de ódio. A estratégia é mostrar para as marcas o que elas podem estar financiando quando utilizam a mídia programática para veiculação de publicidade.

Há também o papel dos usuários nesse jogo de responsabilidades: não compartilhar e denunciar conteúdo violento e agressivo. “É papel da sociedade expor e das empresas, se posicionarem. A sociedade tem que construir uma resposta para isso”, acredita Ribeiro.