A hora da verdade para a IA generativa está chegando

Os grandes modelos de linguagem ainda apresentam uma série de falhas que limitam sua aplicação no mundo real

O lançamento do ChatGPT, em novembro de 2022, provocou uma onda de otimismo de que os grandes modelos de linguagem (LLMs, na sigla em inglês) poderiam revolucionar a maneira como as empresas realizam tarefas essenciais, diminuindo assim o papel dos trabalhadores humanos no processo.

De fato, desde o início, ficou evidente que ferramentas alimentadas por LLMs como o ChatGPT, Bard e Claude poderiam nos ajudar a escrever e-mails, resumir documentos e até mesmo gerar ideias.

Contudo, os críticos foram rápidos em apontar que esses grandes modelos também costumam inventar fatos. Essa falha, de certa forma, torna a tecnologia não confiável e sugere que ela precisaria ser supervisionada de perto em ambientes corporativos.

Sete meses depois, os LLMs ainda enfrentam um grande desafio relacionado às chamadas “alucinações”, junto com uma série de outras questões. Até agora, o progresso em direção a soluções tem sido lento. Parte do problema é que ninguém sabe exatamente como os grandes modelos de linguagem funcionam.

Em seu nível mais básico, eles são essencialmente ferramentas de preenchimento automático que tentam adivinhar a palavra mais provável em uma determinada sequência. Mas o processo de inferência pelo qual passam para encontrar as próximas palavras é extremamente complexo – a ponto de nem mesmo seus criadores conseguirem explicá-lo.

Há um debate sobre se grandes modelos de linguagem podem ser ao mesmo tempo criativos e confiáveis, já que o mecanismo que os permite improvisar é o mesmo que os leva a inventar coisas.

Parte do problema é que ninguém sabe exatamente como os grandes modelos de linguagem funcionam.

Embora muitos acreditem que eles sejam o caminho para a Inteligência Artificial Geral – um estágio hipotético em que o sistema de IA pode realizar as mesmas tarefas intelectuais que os humanos –, alguns duvidam que os LLMs atuais possam realmente solucionar problemas de forma lógica. Outros estudos questionam, inclusive, se podem ser completamente livres de viés.

Ainda assim, o entusiasmo pela IA generativa continua. O McKinsey Global Institute acredita que ela tem o potencial de gerar entre US$ 2,6 trilhões e US$ 4,4 trilhões em lucros corporativos globais por ano.

Além disso, o hype ajuda a sustentar as avaliações das startups de IA generativa, e investidores de capital de risco o utilizam como base, às vezes em detrimento de negócios bem fundamentados. Com sorte, todo esse entusiasmo pode se entender a outros tipos de empresas que desenvolvem modelos menores e mais especializados para solucionar problemas.

RASTREADOR DA WEB DA OPENAI

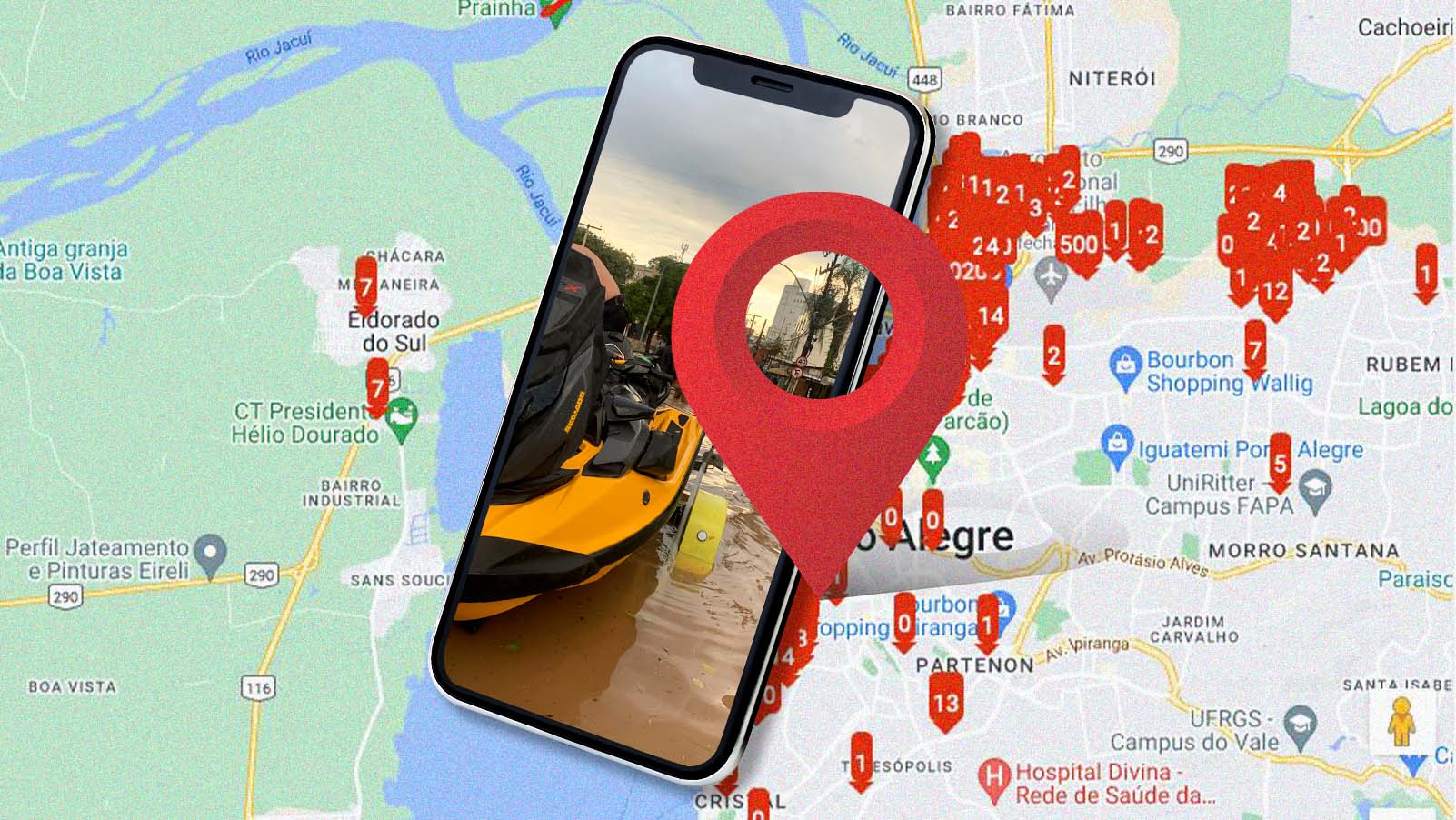

O LLM por trás do ChatGPT foi treinado com grandes quantidades de conteúdo extraído da internet (sem permissão dos editores). Esse processo foi viabilizado por meio de um web crawler, ou rastreador da web, de terceiros ou de uma ferramenta interna própria.

Agora, a OpenAI, criadora do ChatGPT, anunciou seu próprio rastreador, o GPTBot, que poderá permitir a coleta de conteúdo da internet de maneira mais precisa e segura.

Ele é, provavelmente, uma tentativa da empresa de ser mais transparente sobre os métodos pelos quais coleta dados de treinamento, e talvez também seja uma forma de se redimir de práticas passadas.

A OpenAI agora enfrenta pelo menos duas ações judiciais relacionadas às suas práticas de coleta de dados e, no mês passado, fechou um acordo de licenciamento com a “Associated Press” para usar o conteúdo da agência de notícias no treinamento de seus modelos.

No comunicado de lançamento do GPTBot, a empresa fornece instruções detalhadas para os editores que desejam bloquear o acesso do bot aos seus sites – possivelmente uma tentativa de acalmar os reguladores, que estão atentos aos direitos dos proprietários de conteúdo na era da IA.

Além disso, a OpenAI afirma que o rastreador evitará sites com acesso pago, bem como páginas que contenham informações de identificação pessoal ou conteúdo que viole suas políticas de uso.