Apple, Meta e Google estão na cola da OpenAI na onda da IA generativa

Várias gigantes da tecnologia fizeram grandes anúncios recentemente, tornando ainda mais acirrada a corrida da inteligência artificial

Estamos no oitavo mês da corrida da IA generativa, uma enxurrada de anúncios e lançamentos que teve início com o ChatGPT, da OpenAI, no final de 2022.

Enquanto outros grandes players, como Meta e Google, vinham trabalhando em grandes modelos de linguagem (LLMs, na sigla em inglês) para lançar novos chatbots de inteligência artificial, a OpenAI foi a pioneira ao perceber que os bots podem atingir níveis quase humanos de comunicação quando recebem grandes quantidades de dados (coletados da web) e enorme poder computacional.

A empresa não demonstrou esses resultados por meio de artigos de pesquisa, mas permitindo que as pessoas os vissem por si mesmas com o ChatGPT, e o efeito foi estrondoso. Os modelos da OpenAI foram reconhecidos como os mais avançados, e com razão.

Mas, após oito meses sob os holofotes, a OpenAI não parece mais tão invencível como há apenas três meses. Um número cada vez maior de desenvolvedores que utilizam seus modelos notou uma redução na velocidade e precisão dos resultados produzidos (a OpenAI nega que o desempenho esteja diminuindo).

Isso provavelmente está relacionado à falta de poder computacional disponível para executar os modelos da empresa. A OpenAI, cujos modelos rodam em servidores da Microsoft Azure, não tem mais o mesmo acesso ao poder computacional que a colocou em vantagem na corrida da inteligência artificial.

PODER DE COMPUTAÇÃO EM FALTA

Uma fonte bem-informada diz que executivos da Microsoft agora se reúnem semanalmente com a OpenAI para gerenciar os recursos do servidor destinados aos LLMs da empresa. A dona do ChatGPT provavelmente está pedindo mais poder de processamento de GPU, enquanto a Microsoft, sem dúvida, quer que ela encontre maneiras de economizar.

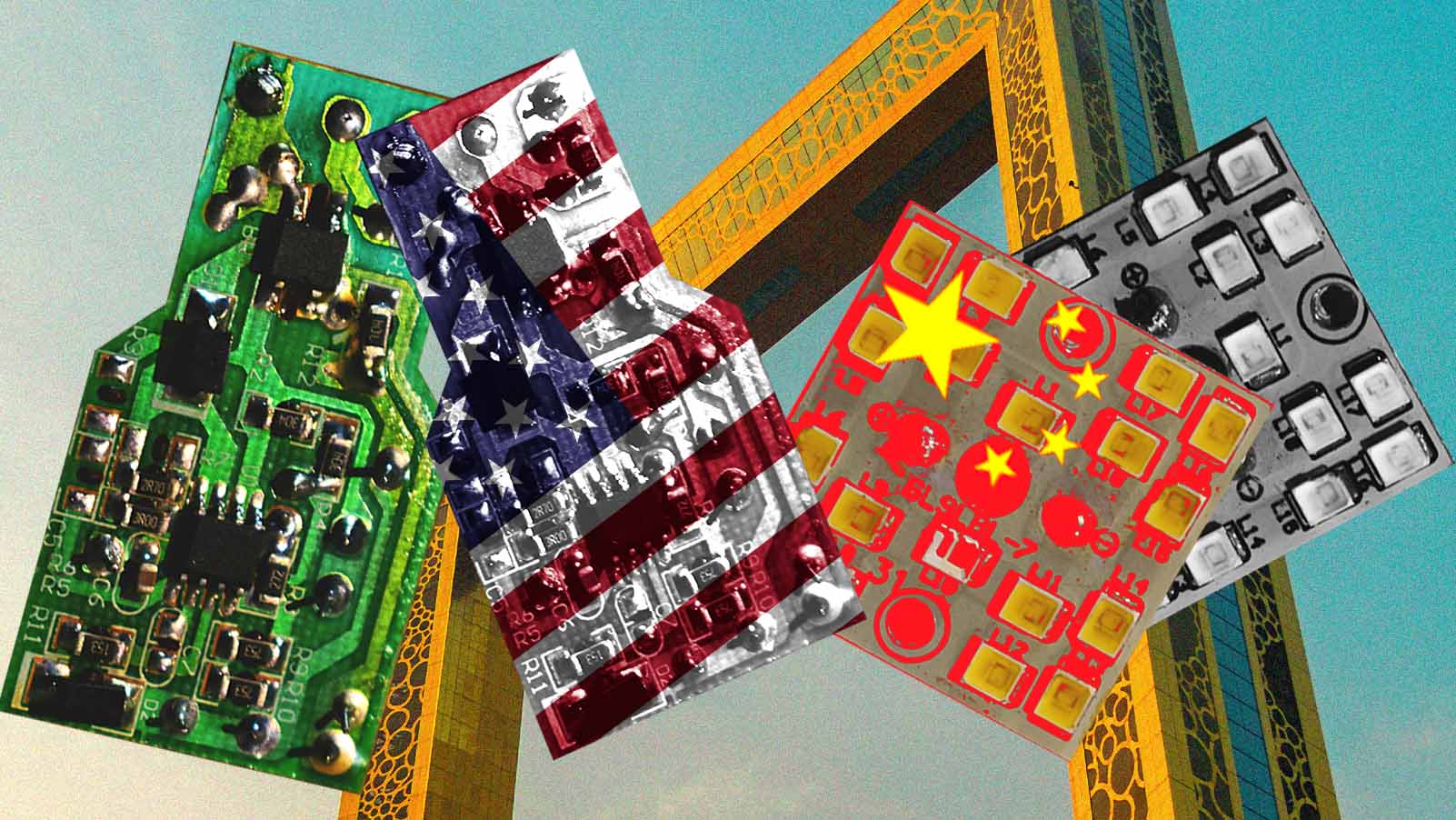

A Microsoft está tão preocupada com a escassez de recursos computacionais que começou a fechar acordos com startups menores de nuvem para ter acesso a mais servidores. Enquanto isso, a Meta, o Google e a Apple têm dinheiro suficiente e seus próprios chips para trabalhar com IA.

E esse não é o único problema que a OpenAI enfrenta. A Meta acabou de lançar o Llama 2, um LLM de código aberto que pode rivalizar com o GPT-4. A Apple também está, supostamente, desenvolvendo seu próprio concorrente do ChatGPT para bater de frente com a OpenAI.

Além disso, tanto o Google quanto a Meta descobriram como fazer com que os LLMs suportem e produzam imagens e palavras. Embora a OpenAI tenha anunciado que seu modelo mais recente, o GPT-4, seria multimodal, até o momento sua ênfase está apenas em palavras e códigos de computador.

De acordo com fontes (não reveladas) da “Bloomberg”, a administração da Apple ainda está decidindo como lançar publicamente sua tecnologia, que tende a inventar fatos e, às vezes, invadir a privacidade.

Supostamente, a empresa teria criado um novo framework chamado “Ajax” para desenvolver LLMs. A “Bloomberg” relata que o projeto se tornou uma “importante empreitada” dentro da Apple, envolvendo a colaboração entre várias equipes.

BARD AGORA COM IMAGENS

Alguns têm comparado o desenvolvimento de grandes modelos de linguagem ao desenvolvimento humano visto em bebês já que, nesta fase, eles aprendem muito sobre o mundo por conta própria (por meio dos sentidos) e com a ajuda dos pais.

A grande diferença é que, enquanto bebês têm os cinco sentidos para absorver informações, os LLMs contam apenas com palavras retiradas da internet e algum feedback humano sobre o que produzem.

Por isso, o recente anúncio do Google de que o Bard agora oferece suporte a imagens é tão importante. Embora não seja o LLM mais avançado do mercado – na verdade, em alguns aspectos, fica atrás dos concorrentes –, ele se tornou o primeiro chatbot disponível ao público com a capacidade de ver, por assim dizer.

a Open.AI foi pioneira ao perceber que bots podem atingir níveis quase humanos de comunicação quando recebem grandes quantidades de dados e enorme poder computacional.

Os usuários agora podem inserir uma imagem como prompt e o Bard consegue analisá-la e fornecer mais informações. Imagine tirar uma foto do seu almoço e perguntar ao bot sobre os ingredientes e o valor calórico da refeição. Ou transformar suas anotações de reuniões em um texto organizado.

Sim, ele pode cometer erros, mas alguns ajustes e melhorias no treinamento podem corrigi-los.

Por enquanto, o Bard suporta apenas imagens estáticas, mas, no futuro, pode ser capaz de processar vídeos em tempo real. Ele pode aprender continuamente a partir de fotossensores, por exemplo, ou digerindo todo o corpus de vídeos do YouTube (que é propriedade do Google). Se você fosse um extraterrestre, não haveria outra maneira mais rápida de aprender sobre o novo ambiente.

A Meta também vem investindo em pesquisa em IA multimodal. A empresa anunciou um novo modelo chamado CM3leon, que gera imagens a partir de prompts de texto com alta qualidade e também escreve legendas para imagens existentes.

Mas e quanto à OpenAI? Segundo relatos do “The New York Times”, ela pode estar hesitante em permitir que o GPT-4 processe imagens, por temer que ele possa reconhecer rostos de pessoas reais e fazer comentários sobre elas.