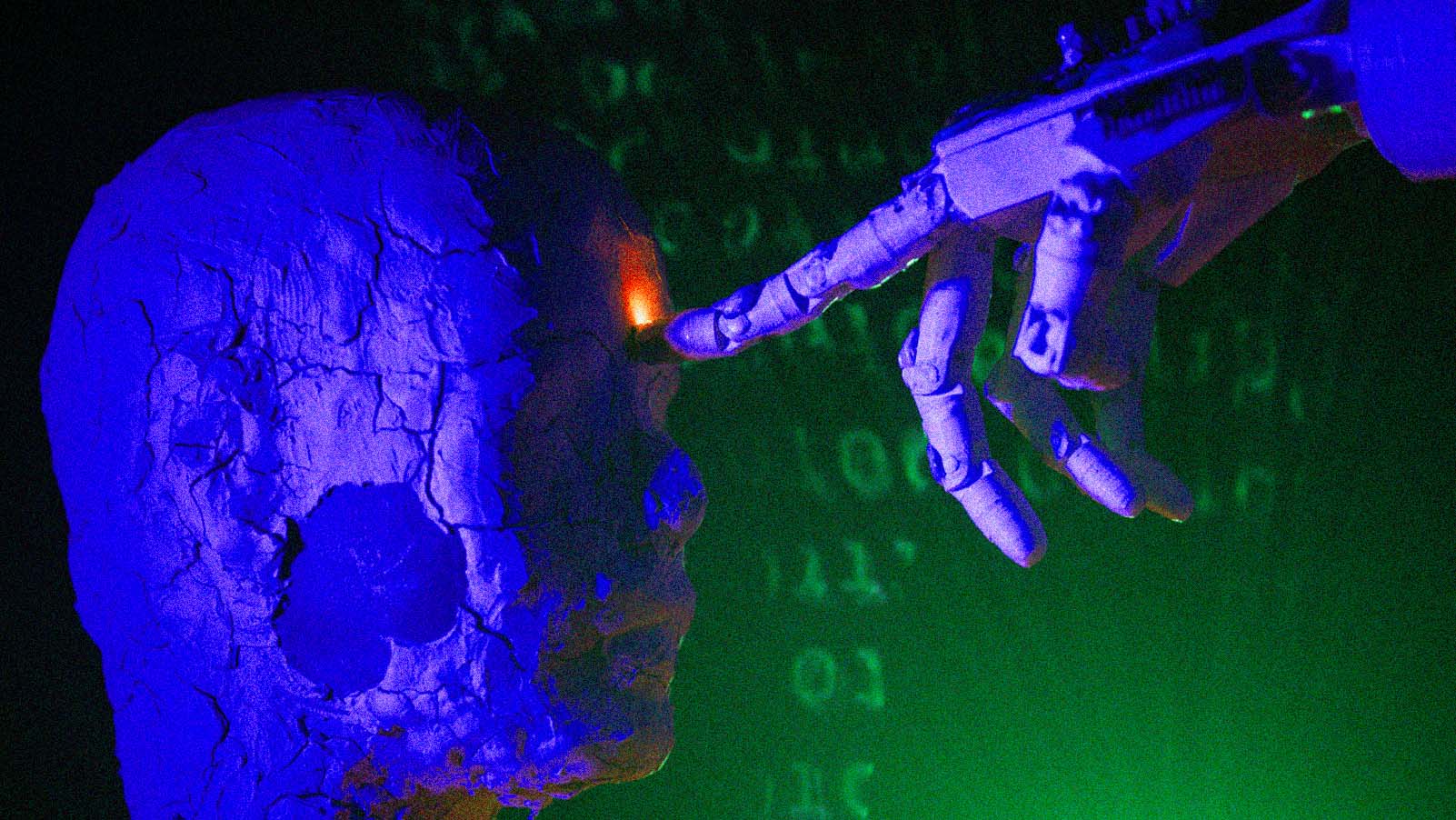

De zero a 100, qual a probabilidade de a IA destruir a humanidade?

O Vale do Silício está agitado com esta forma simples de expressar o nível de pessimismo tecnológico.

Em uma escala de zero a 100, o quanto você acredita que a IA pode destruir a humanidade?

A pergunta, que começou como uma piada interna em fóruns de tecnologia, agora está ganhando destaque. Ela proporciona tanto a especialistas em IA quanto a leigos uma maneira de descrever sua posição sobre se a inteligência artificial vai nos exterminar.

A métrica em questão recebeu o nome de “p(doom)”, que significa “probabilidade de destruição” e, como o próprio nome sugere, se refere à probabilidade de a inteligência artificial causar um cenário apocalíptico.

Ainda contaria como ‘destruição’ se apenas 50% dos humanos morressem como resultado da IA? E se ninguém morresse, mas todos nós ficássemos desempregados?

A escala vai de zero a 100. Quanto mais alto o número, mais convencida uma pessoa está de que a IA não apenas eliminará a humanidade, se necessário, mas também o grau de sucesso em realizar essa tarefa (cada um escolhe se índice de acordo com sua percepção sobre a questão).

Conforme a inteligência artificial se torna mais sofisticada, os temores sobre as consequências aumentam. P(doom) oferece uma maneira objetiva de mostrar como as pessoas encaram essa preocupante questão existencial.

Por exemplo, é razoável supor que alguém que está em 80 na escala fica horrorizado com os alertas dos líderes da indústria – como fizeram os CEOs da OpenAI, Google DeepMind e Anthropic em maio – de que a IA futura será capaz de acabar com os seres humanos tão facilmente quanto uma pandemia ou bomba nuclear.

Isso pode parecer uma repetição do debate sobre singularidade para os pessimistas experientes – só que usando uma métrica muito mais "tuitável".

FAÇAM SUAS APOSTAS

O CEO da Anthropic, Dario Amodei, afirma que seu p(doom) varia entre 10 e 25, dependendo do dia. Lina Khan, presidente da FTC, que é vista como uma das principais combatentes da IA, disse ao “The New York Times” que o dela está em torno de 15.

Enquanto isso, Emmett Shear, CEO interino da OpenAI que ocupou o cargo por 72 horas durante o afastamento de Sam Altman no mês passado, diz que o seu pode chegar a 50 em dias ruins – em dias bons, é cinco.

A maioria das pessoas ativas na área de inteligência artificial já revelou sua posição na escala, mesmo que acreditem que seja uma pergunta boba. Uma pesquisa recente com engenheiros de IA descobriu que a média de p(doom) entre eles era 40.

Vitalik Buterin, cofundador da Ethereum – que já alertou sobre a ameaça existencial da IA – tem um p(doom) de apenas 10. Jan Leike, chefe da equipe de alinhamento da OpenAI, coloca o seu entre 10 e 90, enquanto o diretor do Center for AI Safety, Dan Hendrycks, recentemente atualizou seu número de 20 para mais de 80. Elon Musk revelou ficar entre 20 ou 30.

O renomado engenheiro de software Grady Booch brincou que sua pontuação é equivalente a “p(todo o oxigênio da minha sala se mover espontaneamente para um canto e me sufocar)”.

Já Eliezer Yudkowsky, cofundador do Machine Intelligence Research Institute, afirma que seu p(doom) é superior a 95. “Os designers do reator RBMK-1000 que explodiu em Chernobyl entendiam a física dos reatores nucleares muito melhor do que qualquer pessoa entenderá a superinteligência artificial no momento em que ela for criada”, tuitou recentemente.

Conforme a inteligência artificial se torna mais sofisticada, os temores sobre as consequências aumentam.

Mas, assim como em uma casa de apostas, a quantidade de p(doom)s altos não determina o que vai acontecer de fato.

“Ninguém sabe se a IA tem 2%, 10% ou 85,2% de chance de nos matar, é claro”, aponta o colunista de tecnologia Kevin Roose, observando que há uma infinidade de questões que complicam ainda mais a discussão.

“Ainda contaria como ‘destruição’ se apenas 50% dos humanos morressem como resultado da IA? E se ninguém morresse, mas todos nós ficássemos desempregados? E como a IA dominaria o mundo, afinal?”

Para muitos, estas podem parecer perguntas válidas. Mas provavelmente não para todos. Garrett Jones, economista-chefe da Bluechip, realizou uma pesquisa com usuários do X/ Twitter na semana passada perguntando quais são as chances de que o p(doom) seja na verdade negativo, e quase um terço respondeu mais de 90%.

What's the probability that p(doom) is negative?

— Garett Jones (@GarettJones) December 3, 2023