Especialista em IA defende que modelos de linguagem sejam pequenos

Anos depois de ter sido demitida do Google, Timnit Gebru continua expondo os perigos da criação de modelos de linguagem grandes demais

Timnit Gebru é cientista da computação e acreditava que era possível controlar por dentro os piores defeitos das gigantes da tecnologia.

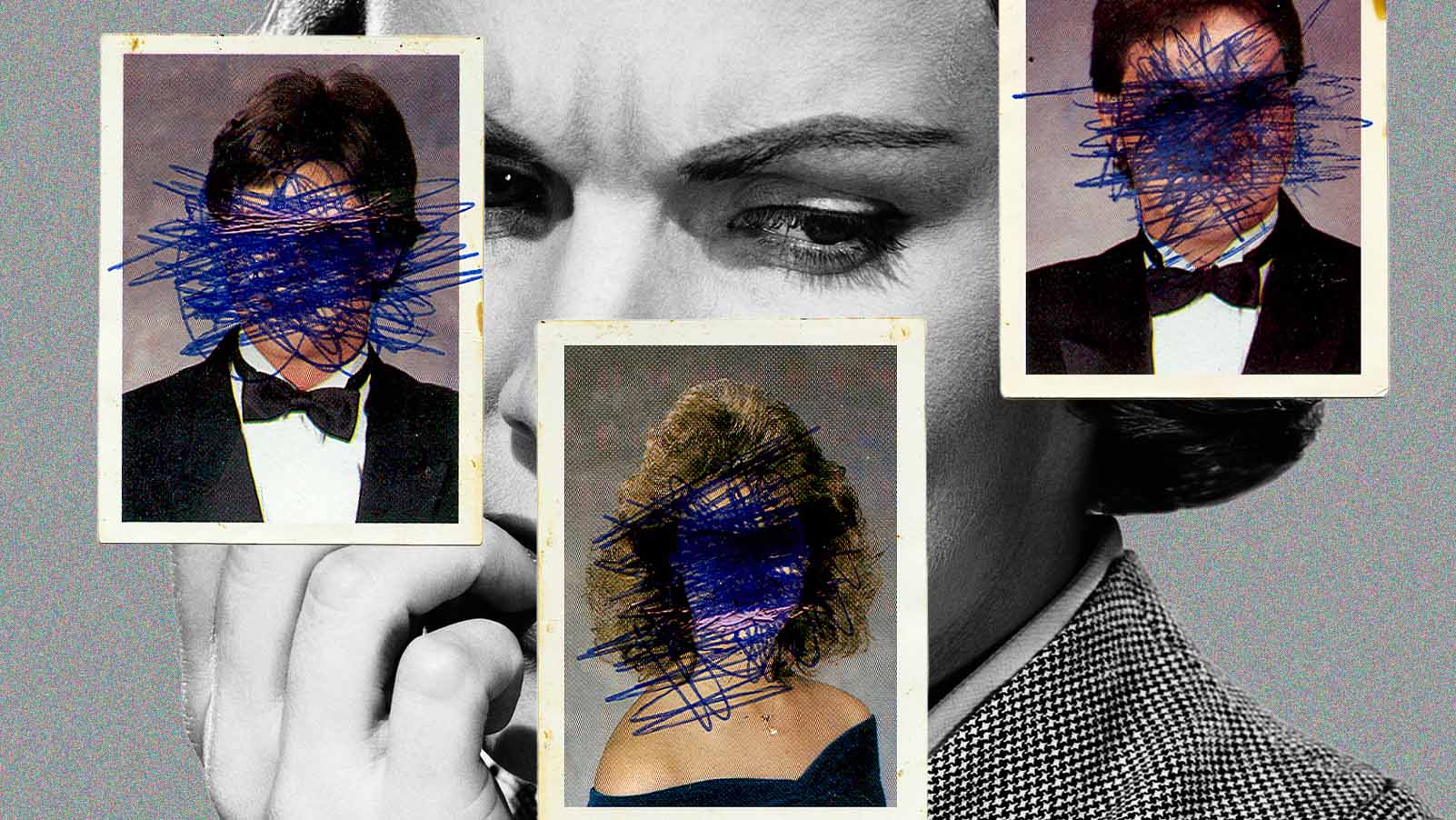

Ela mesma tentou mudar as coisas na Microsoft, onde, em 2018, foi coautora de um artigo importante, que revelou como os sistemas comerciais de reconhecimento facial – incluindo o da própria Microsoft – eram ruins na detecção de rostos negros e femininos. O artigo levou a empresa fazer ajustes no sistema, mas, para ela, foi um avanço pequeno, já que o ideal seria ter parado imediatamente de desenvolver essa tecnologia.

As big techs estão tentando criar modelos de linguagem muito grandes, mas sem nenhum objetivo específico em mente.

Depois, tentou levar esse mesmo senso de responsabilidade para o Google, onde foi trabalhar em 2018 como líder da equipe de ética em IA. Foi lá que ela escreveu outro artigo, descrevendo os perigos dos grandes modelos de linguagem – o potencial de reproduzir preconceitos, os custos ambientais de treiná-los, além da exploração da mão-de-obra necessária para sua construção.

Mas o Google tentou, de forma vergonhosa, forçá-la a retirar seu nome do artigo – um impasse que culminou na súbita e polêmica saída de Gebru da empresa, em dezembro de 2020.

Foram essas experiências – testemunhando em primeira mão as limitações de gerar grandes mudanças estando dentro de uma gigante da tecnologia – que a inspiraram a criar seu próprio grupo de pesquisa independente, o DAIR, de Distributed Artificial Intelligence Research Institute (Instituto de Pesquisa de Inteligência Artificial Distribuída).

O instituto é patrocinado pela ONG de interesse público Code for Science & Society e, desde então, tem atraído outros funcionários do Google, incluindo Alex Hanna, que atualmente é a diretora de pesquisa do DAIR.

Desde 2021, quando o instituto foi lançado, Gebru tem se empenhado em criar um local onde pesquisadores independentes de IA possam analisar seu setor de forma honesta e aberta, sem se preocupar com os resultados financeiros de qualquer empresa de um trilhão de dólares.

Construir modelos pequenos beneficia empresas que trabalham com essas ferramentas em comunidades de todo o mundo.

No último ano, conforme empresas como OpenAI, Meta, Google e Microsoft faziam defesas cada vez mais acaloradas dos grandes modelos de linguagem, Gebru se destacou como uma opositora de credibilidade, criticando as promessas exageradas da indústria e os danos que já estão ocorrendo com o aumento do hype em torno da IA.

Para Gebru, um dos maiores problemas é o fato de que essas empresas estão tentando criar modelos de linguagem muito grandes, mas sem nenhum objetivo específico em mente. “Quando você tenta criar uma espécie de modelo único para todos os tipos de situações, já está sacrificando a segurança”, diz ela.

“Não é possível sequer perguntar: para que essa IA serve? Em que situações ela não deveria ser usada? Como é alimentada? Como fornece suas respostas? As pessoas ficam sem um escopo claro para fazer qualquer crítica.”

Gebru argumenta que qualquer modelo de linguagem que pretenda fazer de tudo fatalmente será menos eficaz do que um modelo menor que tenha sido desenvolvido especificamente para uma determinada tarefa ou comunidade.

Um exemplo disso é a tradução automática. Nesse setor, modelos menores, treinados especificamente em um determinado idioma, geralmente superam modelos gigantescos que se propõem a traduzir centenas de línguas de uma só vez, mas que acabam fazendo um trabalho ruim com idiomas não majoritários.

Gebru se destacou como uma opositora de credibilidade, criticando as promessas exageradas da indústria.

“Quando você conhece seu contexto e sua população e faz a curadoria do conjunto de dados por esse motivo, constrói algo pequeno”, diz Gebru, que recentemente foi coautora de um artigo que aponta falhas no sistema de tradução automática da Meta quando se trata de determinadas línguas da Eritreia e da Etiópia.

Construir modelos pequenos, como diz Gebru, beneficia não apenas os usuários finais da tecnologia de IA, mas também o espectro muito mais amplo de empresas que trabalham com essas ferramentas em comunidades de todo o mundo.

Esse é o mal por trás do hype: quando algumas poucas gigantes do Vale do Silício prometem mais do que sua tecnologia pode realmente oferecer, fica ainda mais difícil para empresas menores competirem. Mas não precisa ser assim.

“Quero mostrar às pessoas que existem outros caminhos”, diz Gebru. “Ainda há tempo.”