IAs que resolvem problemas: um passo a mais para a IA realmente inteligente

Novo modelo de IA do laboratório do Google pode aprender a jogar games a partir de instruções verbais de um treinador humano

Por anos, pesquisadores têm ensinado modelos de IA a jogar videogame como uma forma de prepará-los para executar tarefas específicas da vida cotidiana. Mas a DeepMind, subsidiária do Google focada em inteligência artificial, aumentou a aposta, lançando um modelo “generalista” capaz de aprender a navegar em uma variedade de ambientes virtuais.

O agente de IA, chamado SIMA (acrônimo de “Scalable Instructable Multiworld Agent”, ou agente multimundo ensinável e escalável), pode seguir instruções em linguagem natural para realizar diversas tarefas em mundos virtuais.

Ele aprendeu a minerar recursos, pilotar espaçonaves, fabricar capacetes e construir esculturas usando blocos. Todas essas ações foram realizadas utilizando um teclado e um mouse para controlar o personagem principal do jogo.

O sistema (composto por vários modelos) que alimenta o SIMA foi projetado para mapear com precisão a linguagem e imagens. A equipe de desenvolvimento treinou um modelo de vídeo para prever o que aconteceria se o agente realizasse uma ação específica. Em seguida, ajustou o sistema com base em dados 3D específicos do jogo.

Os pesquisadores da DeepMind querem dar passos em direção à construção de modelos e agentes de IA capazes de descobrir como realizar tarefas no mundo real. “Estamos interessados no comportamento do nosso agente em ambientes que ele nunca viu antes”, afirma Frederic Besse, engenheiro de pesquisa da empresa.

Entretanto, seu colega Tim Harley, que liderou o projeto, ressalta que é muito cedo para falar sobre as aplicações da tecnologia. “Ainda estamos tentando entender como isso funciona... como criar um agente verdadeiramente generalista.”

ROBÔS CAPAZES DE SOLUCIONAR PROBLEMAS

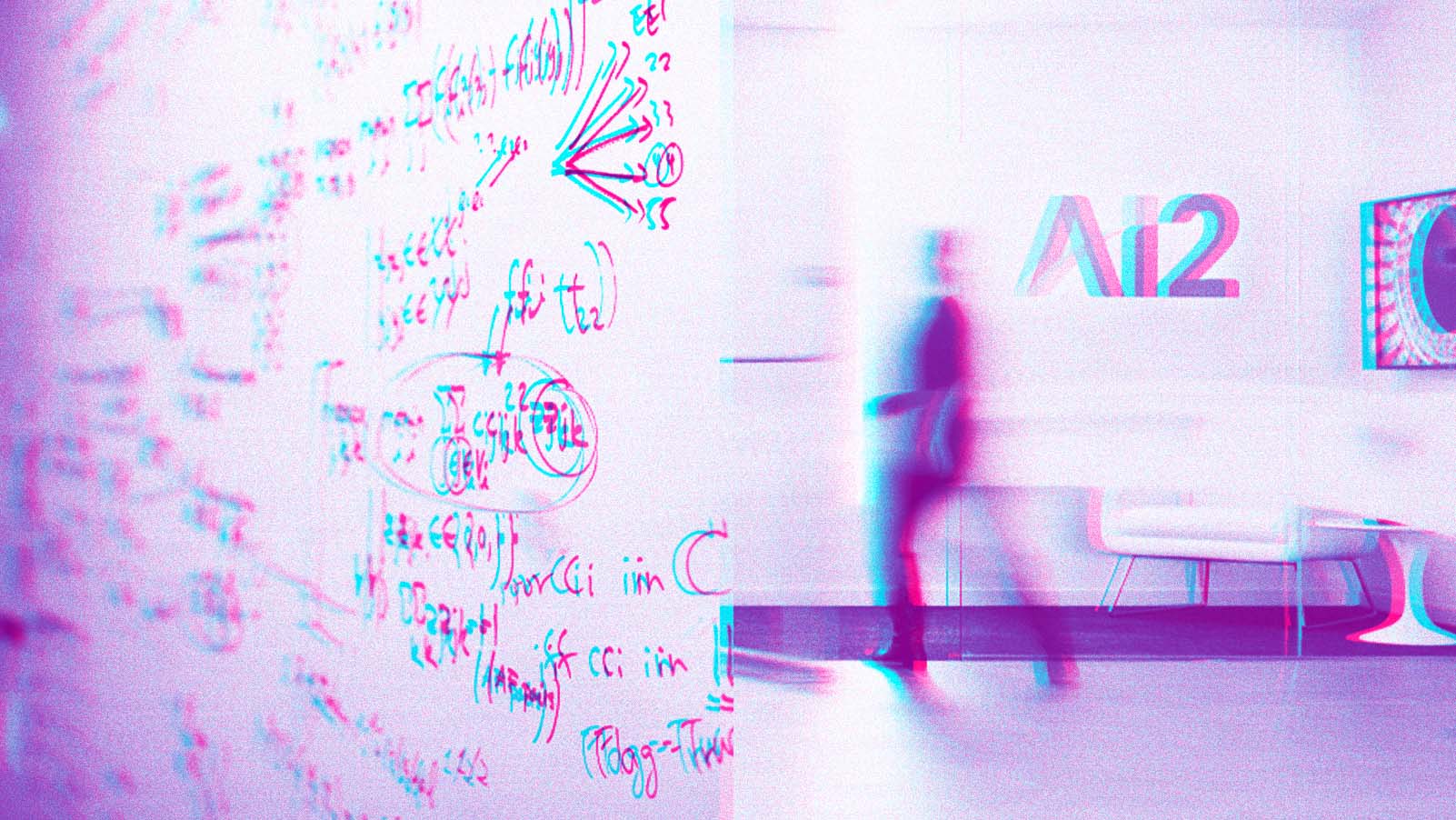

Assim como a DeepMind, a Covariant busca criar um cérebro de IA com a capacidade de aprender novas informações e reagir a problemas inesperados. Mas, em vez de treinar agentes para atuar em uma ampla gama de ambientes digitais, a empresa está focando em ambientes mais restritos, como chãos de fábrica e centros de distribuição.

Os clientes da Covarient estão espalhados por 15 países. Todos usam diferentes tipos de robôs para realizar diversas tarefas, desde selecionar verduras até empacotar produtos comprados online.

A variedade de itens e ações com os quais eles lidam é grande demais para ser replicada em um laboratório de treinamento, então os robôs precisam usar sua capacidade de intuição para manusear objetos que nunca viram, de formas que nunca fizeram antes.

Os robôs começam a desenvolver um instinto de resolução de problemas, assim como os humanos.

Enquanto realizam suas atividades diárias, eles também coletam dados valiosos de treinamento. Peter Chen, CEO da Covariant, compara isso a muitos tipos diferentes de corpos reportando a um mesmo cérebro.

A empresa, que é composta por um bom número de ex-membros da OpenAI, usou esses dados para treinar um novo modelo de base com oito bilhões de parâmetros, o RFM-1.

Os primeiros grandes modelos de linguagem (LLMs, na sigla em inglês) eram treinados apenas a partir de texto. Em 2024, estamos vendo o surgimento de modelos multimodais, capazes de processar imagens, áudios, vídeos e códigos. Mas a Covariant precisava de um que pudesse “pensar” usando um conjunto ainda mais amplo de tipos de dados.

O RFM-1 também entende o estado e a posição do robô e os movimentos que ele pode fazer. Todas essas informações são representadas como tokens no modelo, da mesma forma que dados de texto, imagem e vídeo.

Com todos diferentes tipos de tokens em um único espaço, ele é capaz de fazer coisas impressionantes. O modelo pode, por exemplo, combinar instruções de texto com observações de imagem para intuir a melhor maneira de pegar e mover um objeto.

Também pode gerar um vídeo mostrando o resultado de uma ação específica. Ou simular uma ação planejada com base nas leituras dos sensores do robô. Em essência, trata-se de dar aos robôs uma espécie de intuição geral para solucionar novos problemas e experiências para os quais não foram treinados.

Dessa forma, eles podem continuar trabalhando sem a necessidade de serem desligados para receber treinamento adicional sobre como lidar com um cenário específico. Os robôs começam a desenvolver um instinto de resolução de problemas, assim como os humanos.

A diferença é que ainda podem realizar a mesma ação duas mil vezes por dia, a uma velocidade muito superior à nossa – e nunca ficam entediados.