Nova versão do GPT-4 faz a inteligência artificial parecer mais humana

OpenAI acaba de lançar um modelo mais rápido e mais poderoso chamado GPT-4o

A OpenAI apresentou, em uma transmissão ao vivo, a nova versão de seu aplicativo ChatGPT, que lembra bastante a inteligência artificial do filme “Ela”, de 2013.

Essa nova experiência é possível graças a uma versão aprimorada do seu grande modelo de linguagem, o GPT-4, agora chamado GPT-4o, disponível para desktop e dispositivos móveis. Segundo a OpenAI, o novo modelo oferece respostas muito mais rápidas e é mais poderoso que seu antecessor.

Ele é uma vitrine para o desenvolvimento da IA multimodal da OpenAI. O GPT-4o é capaz de processar conteúdo a partir de texto, imagens e áudio e gerar resultados em linguagem e voz mais naturais.

Durante a demonstração ao vivo, o pesquisador da empresa Mark Chen mostrou as impressionantes habilidades conversacionais do novo modelo. Ele disse ao chatbot que estava nervoso com a demonstração e pediu conselhos para ajudar a se acalmar. Chen então fingiu hiperventilar, ao que o aplicativo brincou: “Mark, você não é um aspirador de pó”.

A interação foi espontânea e engraçada, muito parecida com a assistente de voz (dublada por Scarlett Johansson) do filme “Ela”, que inspirou o desenvolvimento de IA para consumidores.

Chen também pediu que o aplicativo contasse uma história com diferentes níveis de “drama” na voz, o que foi feito de maneira bastante convincente. A IA narrou a mesma história com uma voz estereotipada de robô e, em seguida, de forma mais melódica.

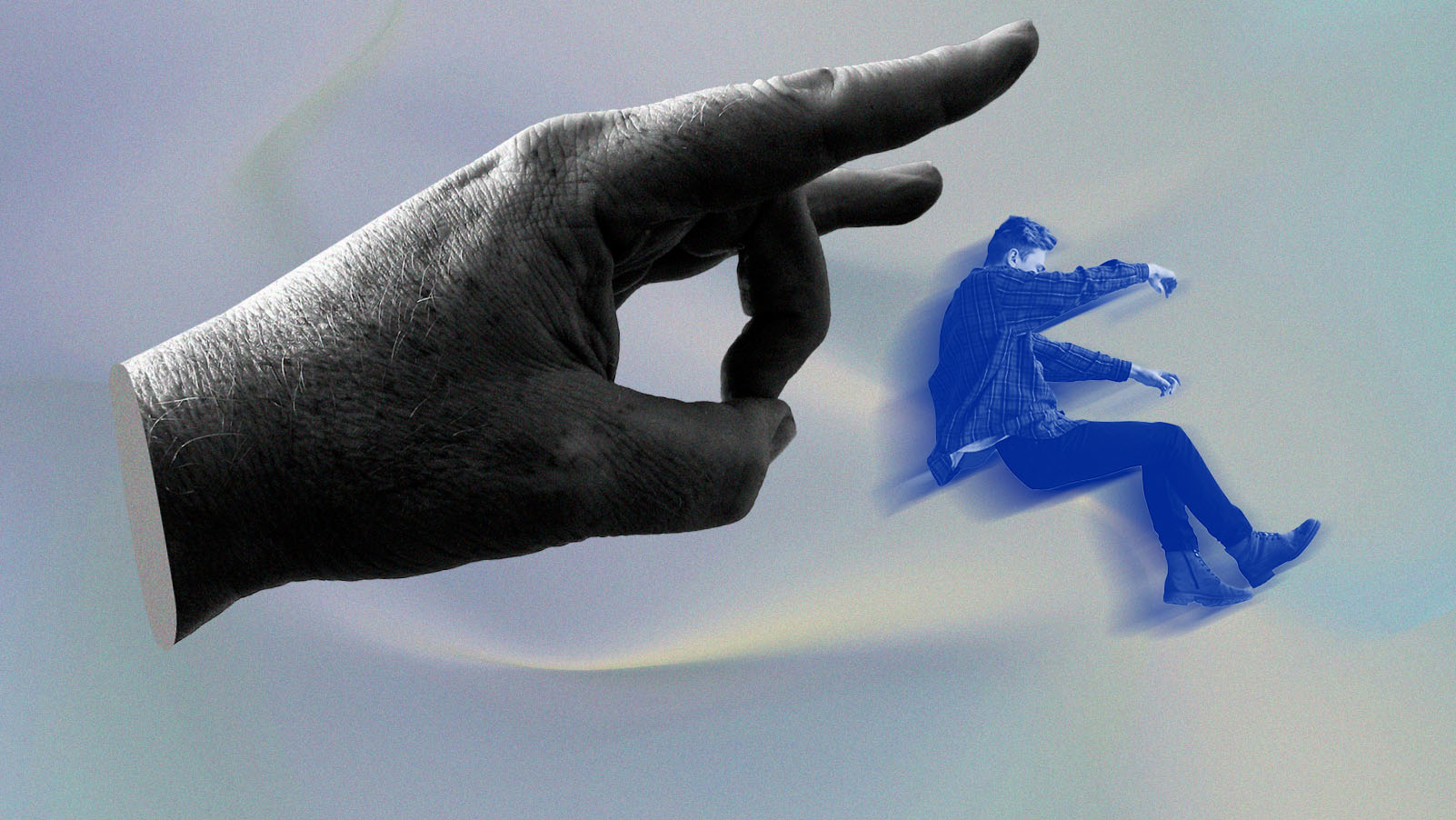

Mais tarde, ele demonstrou como interrompê-la e a IA prontamente parou de falar. Isso mostra que o ChatGPT está se tornando mais “emocionalmente” inteligente. Esse avanço é similar ao que a Inflection.ai estava desenvolvendo com seu aplicativo Pi AI, antes de ser adquirida pela Microsoft, que também é dona de quase metade da OpenAI.

O GPT-4o é capaz de processar conteúdo a partir de texto, imagens e áudio e gerar resultados em linguagem e voz mais naturais.

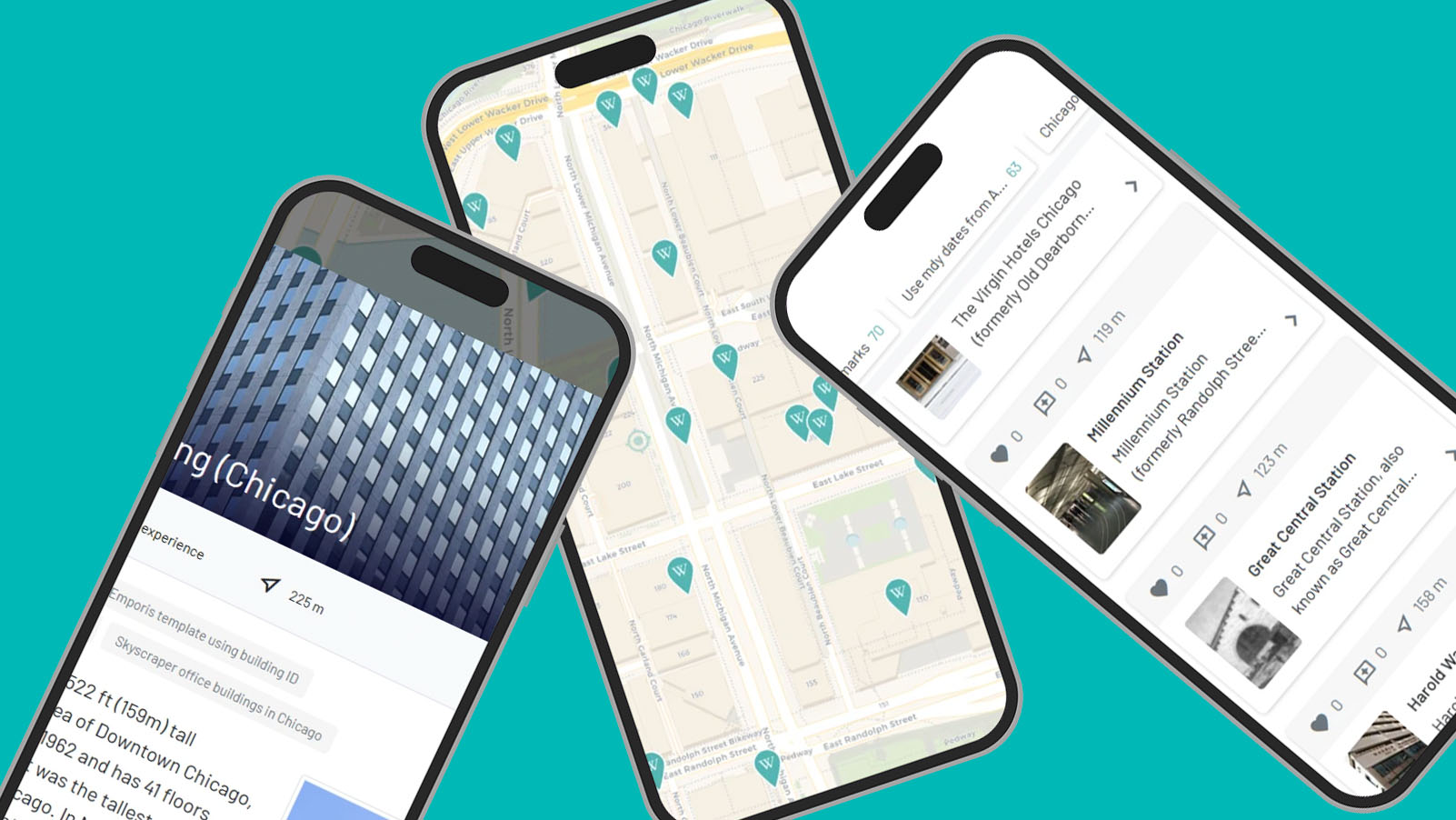

Além das habilidades de conversação, o novo modelo também pode “ver” e interpretar o mundo ao seu redor. Através da câmera do telefone, o aplicativo conseguiu resolver um problema matemático escrito em um quadro e explicar um trecho de código de computador. Também fez uma tradução ao vivo do italiano para o inglês e vice-versa.

Os novos recursos estarão disponíveis para os usuários do ChatGPT Plus ao longo das próximas semanas. A OpenAI também está disponibilizando o GPT-4o para desenvolvedores por meio de sua API.

O anúncio transmitido ao vivo pareceu ser estrategicamente programado para coincidir com a expectativa de anúncios relacionados à IA na conferência de desenvolvedores do Google, que aconteceu no dia seguinte (14 de maio).