O que fazer para evitar o colapso dos modelos de inteligência artificial

Pesquisadores descobriram que, sem dados humanos de alta qualidade, modelos treinados com conteúdo gerado por outras IAs ficam cada vez mais “burros”

Especialistas em inteligência artificial e veículos de mídia estão prevendo que o hype em torno da IA generativa pode estar chegando ao fim, com alguns até sugerindo um possível e catastrófico “colapso dos modelos”. Mas essas previsões são realmente plausíveis? E o que exatamente seria o colapso dos modelos?

O colapso de modelos se refere a um cenário hipotético em que, no futuro, sistemas de inteligência artificial se tornariam progressivamente mais “burros” devido ao aumento de dados gerados por IA na internet.

Os sistemas modernos são construídos usando aprendizado de máquina. Os programadores definem a estrutura matemática, mas a verdadeira “inteligência” surge do treinamento do sistema para imitar padrões presentes nos dados. Mas não qualquer tipo de dado. As IAs generativas atuais precisam de dados de alta qualidade – e em grandes quantidades.

Para obtê-los, as grandes empresas de tecnologia estão constantemente vasculhando a internet, coletando terabytes de conteúdo para alimentar suas máquinas. Mas desde que os sistemas de IA generativa se tornaram amplamente disponíveis, cada vez mais pessoas estão criando e compartilhando conteúdos total ou parcialmente gerados por IA.

Em 2023, alguns pesquisadores começaram a se perguntar se seria possível treinar modelos utilizando apenas dados gerados por inteligência artificial, em vez de dados criados por humanos. Há grandes incentivos para isso.

Além de estarem amplamente disponíveis na internet, os conteúdos feitos por IA são muito mais baratos de se obter do que os dados humanos. Além disso, sua coleta em massa não levanta tantas questões éticas e legais.

As IAs generativas atuais precisam de dados de alta qualidade – e em grandes quantidades.

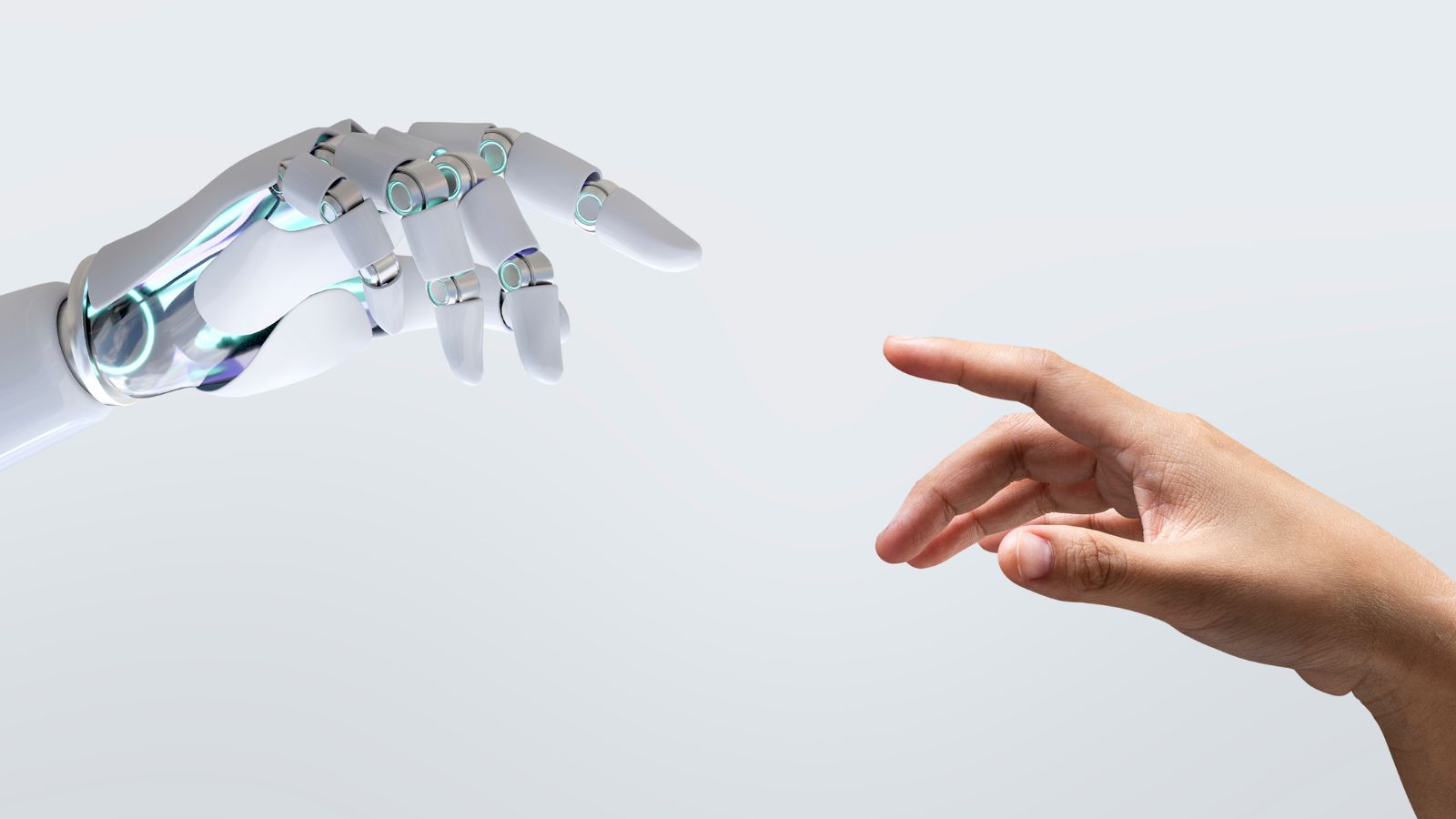

No entanto, os pesquisadores descobriram que, sem dados humanos de alta qualidade, os sistemas treinados com dados gerados se tornam cada vez mais “burros”, já que cada modelo aprende a partir do anterior.

Isso parece levar a uma diminuição na qualidade e na diversidade dos comportamentos dos modelos. Qualidade aqui significa, em termos gerais, uma combinação entre ser útil, inofensivo e honesto. Diversidade se refere à variação nas respostas e às diferentes perspectivas culturais e sociais representadas nos resultados da IA.

Resumindo: ao usar tanto os sistemas de inteligência artificial, corremos o risco de poluir a própria fonte de dados necessária para torná-los úteis em primeiro lugar.

EVITANDO O COLAPSO

As big techs não poderiam simplesmente filtrar o conteúdo gerado por IA? Na prática, isso não é tão simples. Essas empresas já gastam muito tempo e dinheiro limpando e filtrando os dados que coletam. Recentemente, uma fonte da indústria mencionou que, às vezes, até 90% dos dados inicialmente coletados para o treinamento de modelos são descartados.

Esses esforços podem precisar ser ainda maiores à medida que a necessidade de remover especificamente conteúdos gerados por IA aumenta. Mais importante: a longo prazo, será cada vez mais difícil distinguir o conteúdo gerado por IA do criado por humanos, tornando o processo de filtragem e remoção de dados sintéticos uma tarefa com retorno financeiro cada vez menor.

As pesquisas realizadas até agora mostram que não podemos simplesmente abrir mão dos dados humanos. Afinal, é daí que vem a “inteligência” da inteligência artificial.

ESTAMOS CAMINHANDO PARA UMA CATÁSTROFE?

Existem indícios de que os desenvolvedores já estão enfrentando dificuldades para obter dados de alta qualidade. Por exemplo, a documentação que acompanha o lançamento do GPT-4 creditou um número sem precedentes de funcionários envolvidos nas partes relacionadas a dados do projeto.

Além disso, também podemos estar ficando sem novos dados humanos. Algumas estimativas sugerem que o conjunto de dados humanos em texto pode se esgotar já em 2026.

a longo prazo, será cada vez mais difícil distinguir o conteúdo gerado por IA do criado por humanos.

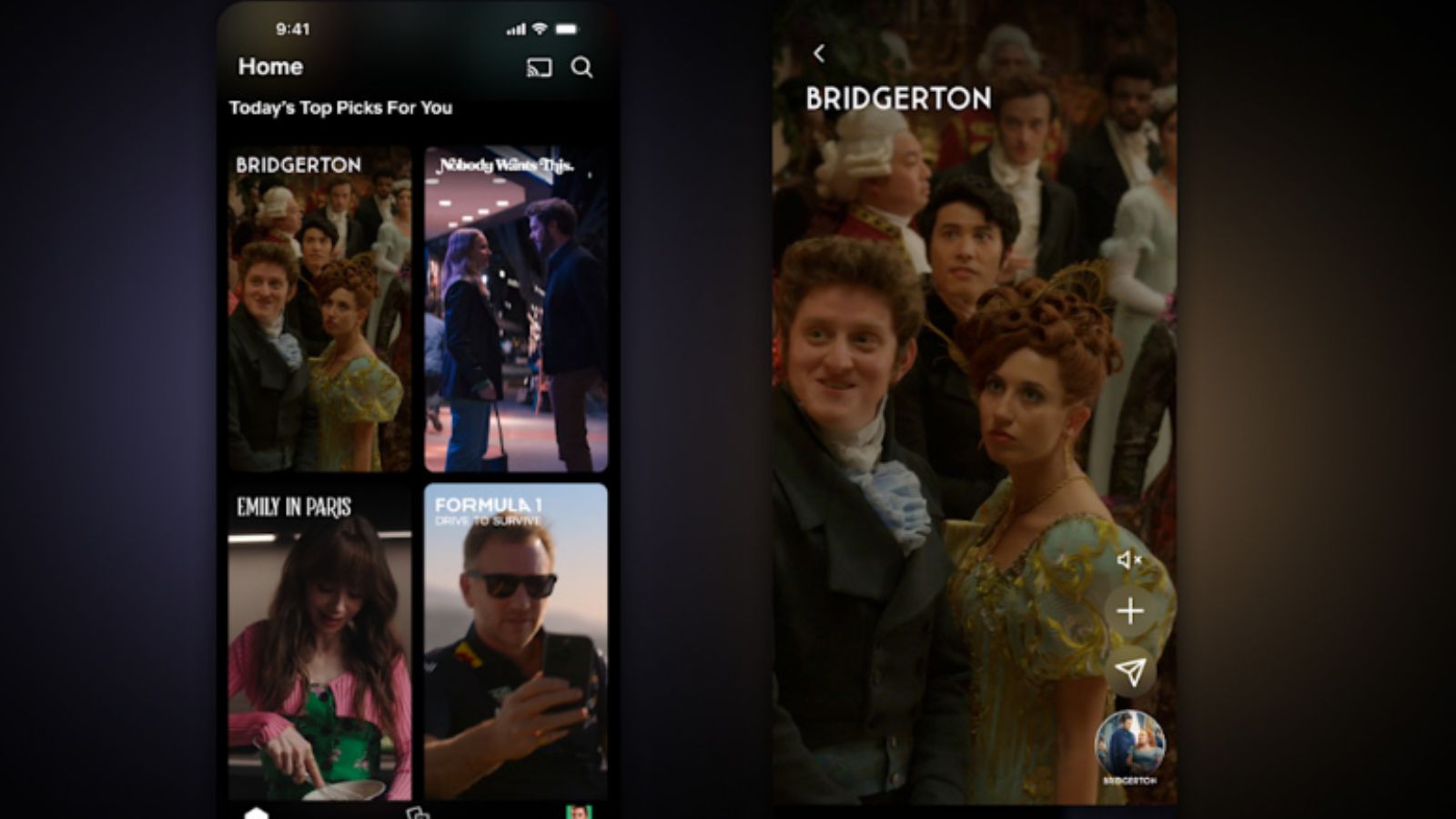

É provavelmente por isso que a OpenAI e outras empresas estão correndo para garantir parcerias exclusivas com gigantes da indústria, como Shutterstock, Associated Press e NewsCorp, que possuem vastas coleções de dados humanos proprietários, não disponíveis publicamente na internet.

No entanto, as previsões de um colapso catastrófico dos modelos podem ser exageradas. A maioria das pesquisas até agora se concentra em cenários nos quais dados sintéticos substituem completamente os dados humanos. Na prática, é mais provável que ambos continuem a se acumular em paralelo, o que reduz as chances de um colapso.

O cenário futuro mais provável também inclui um ecossistema de plataformas de IA generativa relativamente diversas, em vez de um único modelo dominante. Isso também aumenta a resiliência contra o colapso.

Essa é uma boa razão para os reguladores promoverem uma concorrência saudável, limitando monopólios no setor de inteligência artificial, e para financiarem o desenvolvimento de tecnologias de interesse público.

As interações e os dados humanos são cruciais e devem ser protegidos – para o nosso próprio bem e, talvez, para evitar um possível colapso dos modelos no futuro.

Este artigo foi publicado no “The Conversation” e reproduzido sob licença Creative Common. Leia o artigo original.