Seria Sam Altman, CEO da OpenAI, o novo Mark Zuckerberg?

Embora a IA ainda esteja em seus estágios iniciais, os perigos potenciais que ela representa fazem com que os danos do Facebook pareçam insignificantes

Há quase duas décadas, Mark Zuckerberg lançou uma plataforma que, segundo ele, era mais do que uma simples empresa – era uma “missão social” destinada a “conectar todas as pessoas do mundo”.

Os legisladores pareceram acreditar nessa visão otimista e pouco fizeram para regular a empresa, mesmo quando ela passou de um pequeno banco de dados de estudantes universitários para um conglomerado global com quase três bilhões de usuários.

Não existem regras que regulem o uso da inteligência artificial em eleições.

Agora, a “missão social” de Zuckerberg se tornou um terreno fértil para o ódio e a desinformação, permitindo que agentes estrangeiros manipulassem eleições e extremistas fomentassem uma insurreição violenta contra o governo norte-americano. Também no Brasil as redes sociais tiveram papel importante na invasão das sedes dos três poderes em Brasília, em 8 de janeiro.

A ascensão não regulada do Facebook deveria servir como um alerta. Mas, enquanto Sam Altman, CEO da OpenAI e criador do ChatGPT, se dirige ao Congresso dos EUA, os legisladores parecem determinados a repetir os mesmos erros.

Em vez de recebê-lo com um jantar bipartidário em sua homenagem, deveriam submeter a nova tecnologia de inteligência artificial ao escrutínio que ela e o público merecem, assim como deveriam ter feito com Zuckerberg.

AUTORREGULAMENTAÇÃO OU NÃO?

Se a história do Facebook nos ensinou algo é que a inovação deve ser acompanhada de regulamentação. Há apenas alguns anos, a OpenAI foi fundada como uma organização sem fins lucrativos responsável, cuja “obrigação primária é com a humanidade” – uma visão não muito diferente daquela que Zuckerberg tinha para o Facebook. Agora, é uma empresa de US$ 30 bilhões que lidera a corrida da IA.

É verdade que a OpenAI expressou apoio à regulamentação. Mas vimos uma história semelhante se desenrolar com o Facebook e outras big techs. Muitas vezes, essas empresas pedem regulamentação apenas como uma estratégia de relações públicas e investem milhões de dólares para combatê-la.

Um exemplo disso foi quando Zuckerberg escreveu um artigo de opinião no “The Washington Post” implorando pela aprovação de uma legislação sobre privacidade, depois de gastar milhões para barrar um projeto de lei na Califórnia que tinha exatamente esse objetivo. Na época, o Facebook estava gastando pelo menos US$ 17 milhões em lobby contra a regulamentação tecnológica em nível federal.

Quatro anos depois, a controladora do Facebook, a Meta, e outras grandes empresas de tecnologia gastariam mais de US$ 230 milhões em lobby e anúncios para derrubar a legislação antitruste.

Apesar de tudo isso, os legisladores continuam acuados diante dessa questão, confiando na autorregulamentação do Facebook, mesmo depois de sua flagrante má gestão em relação às interferências nas eleições norte-americanas de 2016 e de reconhecer sua contribuição para os danos generalizados à saúde mental de crianças e adolescentes.

A OpenAI foi fundada como uma organização sem fins lucrativos e hoje é uma empresa de US$ 30 bilhões.

Diante de uma nova era impulsionada pela inteligência artificial, o Congresso continua ignorando os sinais de alerta vindos de Altman. Os legisladores parecem dispostos a confiar mais uma vez na autorregulamentação sob o pretexto de “inovação”, mesmo que tecnólogos e acadêmicos expressem preocupações.

Infelizmente, apesar de a IA ainda estar em seus estágios iniciais, os perigos potenciais que ela representa fazem com que os danos do Facebook pareçam insignificantes.

Embora a tecnologia possa ser usada em prol do bem comum – como avanços na medicina ou ensino personalizado –, já estamos vendo chatbots espalhando desinformação, validando teorias conspiratórias e até encorajando crianças a se expor a situações sexuais predatórias com adultos.

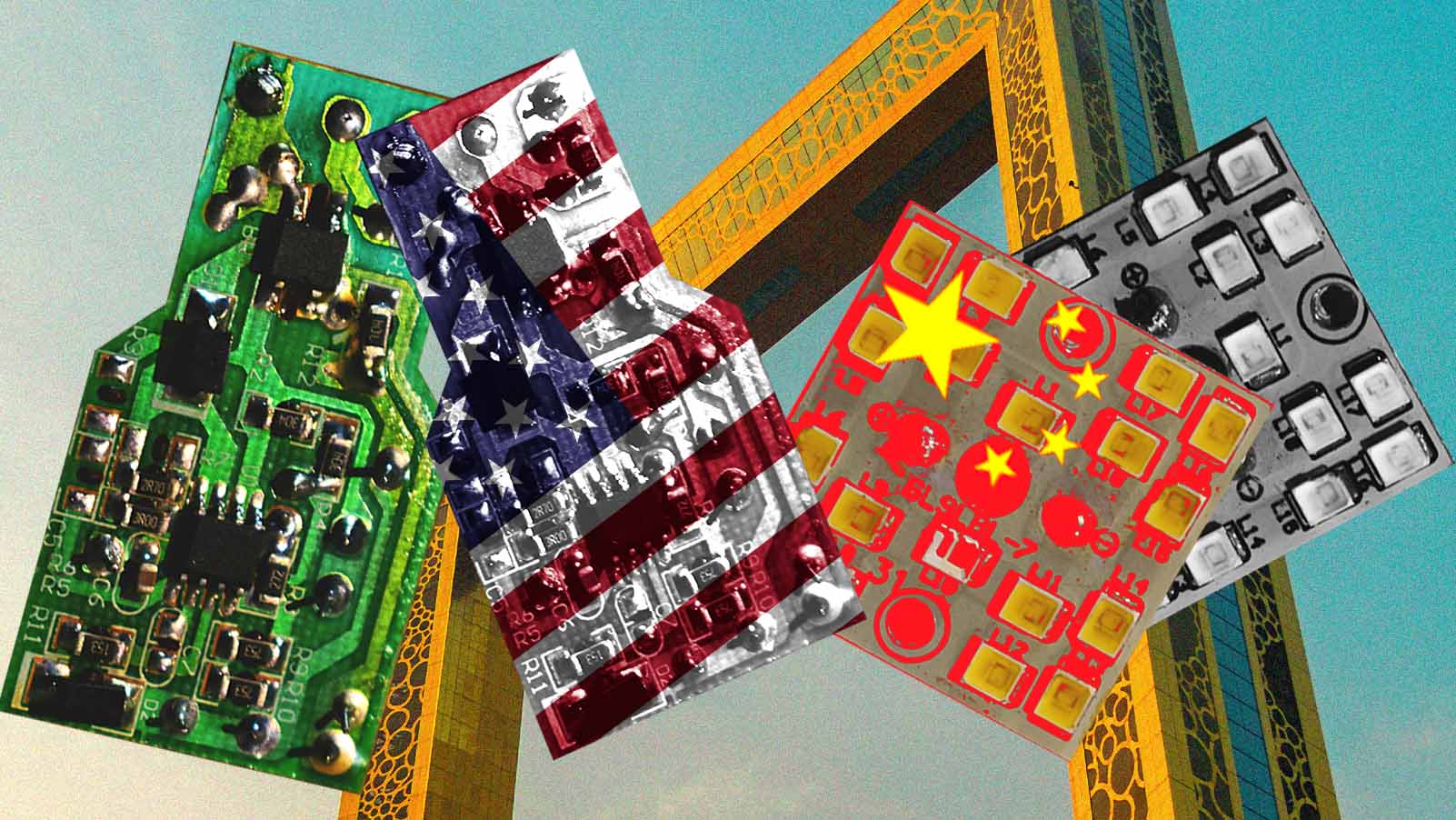

RISCO PARA A DEMOCRACIA

As consequências da IA são particularmente graves para a democracia. Não existem regras que regulem seu uso em eleições. O que impede uma campanha de utilizar ligações automatizadas com a voz de um adversário político? Ou de tentar destruir sua imagem manipulando um vídeo?

No início deste mês, a administração do presidente Joe Biden convocou CEOs de empresas que desenvolvem IA para discutir seus riscos. A presidente da Comissão Federal de Comércio (FTC), Lina Khan, se comprometeu a “aplicar rigorosamente a lei” conforme necessário. Mas o depoimento de Altman perante o Congresso oferece mais uma oportunidade para exigir salvaguardas e reforçar a segurança para o público.

Entre outras medidas, o parlamento poderia aproveitar para estabelecer as bases para um órgão independente que regule e supervise produtos de IA generativa. Assim como a FTC e a FDA – que autoriza a venda de alimentos e medicamentos nos EUA –, esse órgão seria responsável por regular as ferramentas de IA antes de chegarem ao mercado.

Se os anos 2010 foram moldados por Mark Zuckerberg e pelo surgimento das redes sociais, a década de 2020 será moldada pela IA generativa e pela maneira como ela se integra às nossas vidas – quer queiramos ou não. Os legisladores têm em mãos o poder de corrigir o curso dessa tecnologia. Caso falhem, os danos podem ser irreparáveis.