Vem aí a nova batalha no campo da cibersegurança: IA x IA

Com os avanços em IA, os ciberataques serão bem diferentes em um futuro próximo

O rápido avanço da inteligência artificial generativa tem gerado preocupação entre especialistas em cibersegurança e reguladores. Com o machine learning contribuindo para a criação de conteúdo enganoso, os invasores cibernéticos podem agir mais rapidamente e identificar novas vulnerabilidades.

Como resultado, os vetores de ataque já conhecidos, como manipulação em redes sociais ou malwares intrusivos, provavelmente se tornarão mais precisos e difíceis de serem combatidos com softwares de detecção convencionais.

A indústria de segurança só conseguirá se manter um passo à frente com investimentos e desenvolvimento contínuos em inteligência artificial.

A boa notícia é que, da mesma forma que os cibercriminosos estão desenvolvendo novos ataques com a ajuda da IA, os profissionais de cibersegurança estão usando a tecnologia para fortalecer suas defesas e reconhecer padrões ou anomalias que não seriam detectados sem o uso da inteligência artificial.

Reforçar medidas básicas de proteção, como corrigir vulnerabilidades conhecidas, identificar e-mails ou mensagens suspeitas, passar o mouse sobre os links antes de clicar e confirmar com os colegas, pessoalmente ou através de chamadas no Zoom, se eles realmente solicitaram os dados em questão, ajudará muito os líderes de TI a proteger suas organizações em meio ao avanço da IA.

Fornecer às equipes de segurança ferramentas de inteligência artificial de detecção de ameaças é a melhor estratégia que se pode adotar para fortalecer sua defesa contra ciberataques. Pesquisas recentes mostram que organizações que utilizam essas tecnologias são capazes de combater violações de segurança quase dois meses e meio mais rápido do que aquelas que não empregam IA ou automação.

A seguir estão três vetores de ataque que serão bem diferentes em um futuro próximo.

MALWARE GERADO POR IA

É preciso ter em mente que os invasores vão explorar a tecnologia para criar novos tipos de malware e ferramentas maliciosas que sejam mais eficazes em evitar a detecção. Já existem evidências de que isso está começando a se concretizar, e pesquisas iniciais mostram os caminhos possíveis que serão explorados.

Um exemplo é o Black Mamba, um malware gerado por IA criado como um experimento por pesquisadores da HYAS. Surpreendentemente, ele conseguiu evitar ser detectado pelos principais softwares de endpoint do setor.

O fato de malwares gerados por inteligência artificial como esse serem “virtualmente indetectáveis” pelos padrões atuais deve ser motivo de grande preocupação para organizações que utilizam soluções de segurança desatualizadas.

A cibersegurança inevitavelmente se tornará um confronto entre IAs, e os esforços conduzidos exclusivamente por humanos não serão capazes de acompanhar o volume e a sofisticação dos ataques gerados por inteligência artificial.

PHISHING GERADO POR IA

Com a capacidade da IA generativa de extrair informações de todos os cantos da internet, os cibercriminosos são capazes de criar mensagens com um tom específico para uma organização ou figura pública, tornando cada vez mais difícil distingui-las de conteúdos legítimos.

A IA já está sendo usada para gerar mensagens altamente realistas. Mas é a quantidade e a escala que, em breve, irão diferenciá-las das técnicas atuais de phishing. Automatizar essas mensagens, ou usar chatbots, permitirá que criminosos atinjam um grande número de vítimas em pouco tempo.

Os avanços na IA generativa também tornarão mais fácil a criação de deepfakes de áudio e vídeo convincentes, que serão usados para se passar por pessoas ou espalhar informações falsas. Infelizmente, assim como em muitos aspectos da inteligência artificial, os legisladores não estão preparados para lidar com essas ameaças.

ENGENHARIA SOCIAL ASSISTIDA POR IA

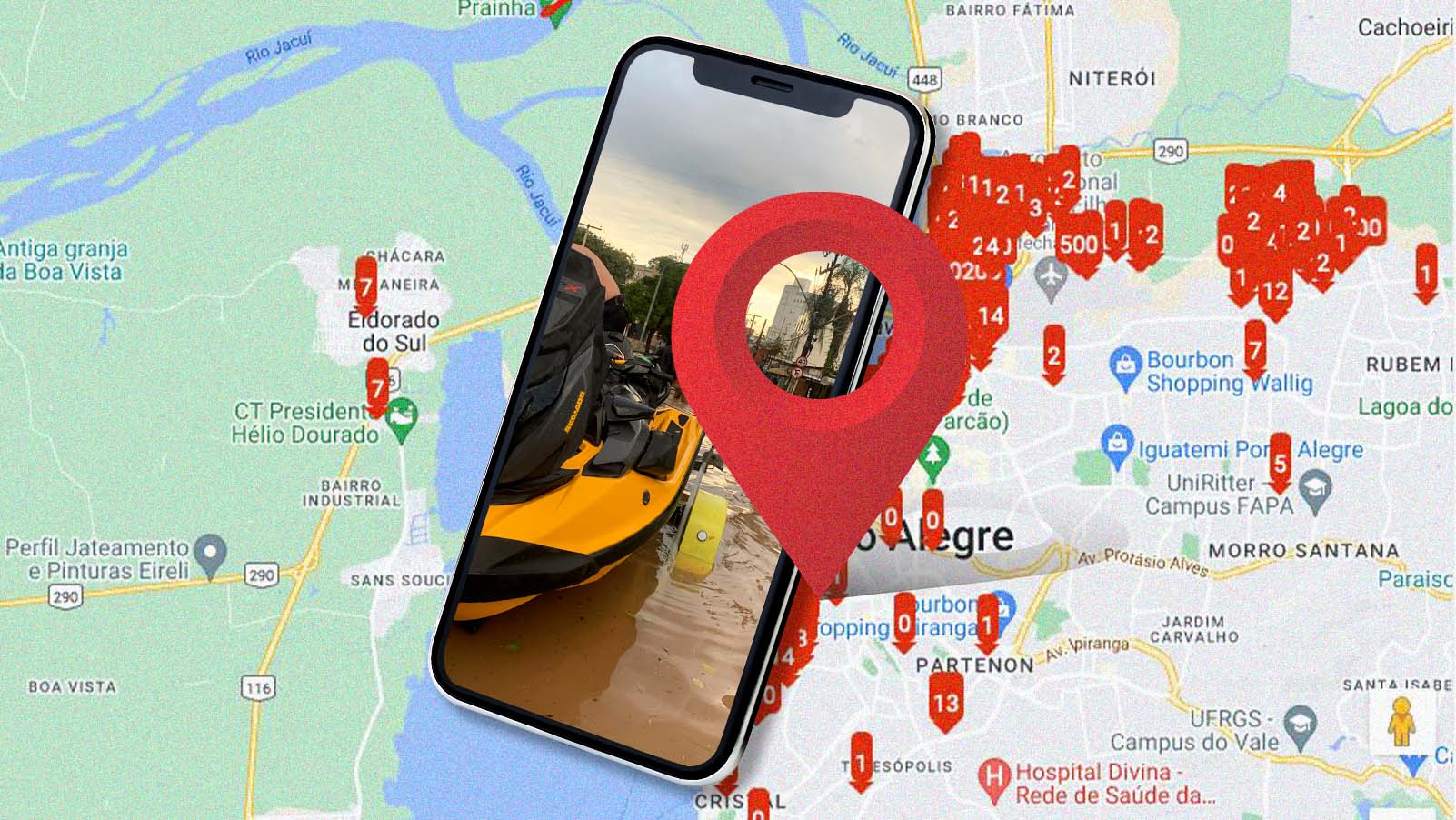

É perfeitamente possível criar contas falsas com uma aparência realista para espalhar informações inverídicas ou enganosas com o auxílio de plataformas de IA, bem como notícias convincentes que influenciam a opinião pública de diferentes maneiras.

Embora as fake news não sejam um fenômeno novo, a automação proporcionada pela inteligência artificial possibilita a criação de uma imensa quantidade delas, o que será um grande problema.

Recentemente, na China, um homem foi preso por usar o ChatGPT para criar uma notícia falsa sobre o descarrilamento de um trem. Provavelmente, veremos mais pessoas usando essa tecnologia para causar o caos.

Os vetores de ataque que os profissionais de segurança vêm estudando há anos passarão por uma transformação completa à medida que as ferramentas de IA se tornam mais avançadas e difundidas. A indústria de segurança só conseguirá se manter um passo à frente com investimentos e desenvolvimento contínuos em inteligência artificial.