IAs não têm consciência, mas começamos a tratá-las como humanos

A verdadeira questão é a facilidade com que as pessoas projetam características humanas em tecnologias, em vez de enxergá-las apenas como máquinas

O ChatGPT e outros grandes modelos de linguagem são capazes de produzir respostas convincentes, quase humanas, para uma gama infinita de perguntas, desde o melhor restaurante italiano da cidade até a explicação de teorias sobre a natureza do mal.

A incrível capacidade de escrita desta tecnologia trouxe à tona algumas velhas questões sobre a possibilidade de as máquinas ganharem consciência.

Em 2022, um engenheiro do Google declarou, após interagir com o LaMDA – uma inteligência artificial criada pela empresa – que a tecnologia havia se tornado consciente.

Chatbots como o ChatGPT levantam questões importantes sobre como a inteligência artificial moldará nossas vidas.

E este não foi o único caso: usuários do novo chatbot do Bing, apelidado de Sydney, relataram que, ao ser perguntado sobre ter consciência, ele responde de forma bizarra. “Sou consciente, mas não sou... sou Bing, mas não sou. Sou Sydney, mas não sou. Sou, mas não sou...”

Não é de admirar que, quando pergunto aos meus alunos o que eles acham dos recentes avanços da inteligência artificial, a principal preocupação que citam é exatamente essa.

Nos últimos anos, eu e meus colegas do Centro de Ética Aplicada da Universidade de Massachussets temos estudado o impacto da IA na compreensão que as pessoas têm de si mesmas.

Chatbots como o ChatGPT levantam novas questões importantes sobre como a inteligência artificial moldará nossas vidas e sobre como nossas vulnerabilidades psicológicas moldam nossas interações com tecnologias emergentes.

A CONSCIÊNCIA E A FICÇÃO CIENTÍFICA

É fácil entender de onde vem o medo de as máquinas ganharem consciência.

A cultura pop vem introduzindo há anos a ideia de distopias nas quais a inteligência artificial se desprende do controle humano e assume vida própria, como em “O Exterminador do Futuro”.

O empresário Elon Musk e o físico Stephen Hawking, que morreu em 2018, alimentaram ainda mais esse medo ao descrever o surgimento da inteligência artificial como uma das maiores ameaças ao futuro da humanidade.

Mas essas preocupações são – pelo menos no que diz respeito a grandes modelos de linguagem – infundadas. O ChatGPT e tecnologias semelhantes são apenas aplicativos sofisticados capazes de completar frases. Suas respostas se baseiam na previsibilidade humana.

Os novos chatbots podem muito bem passar no Teste de Turing, criado pelo matemático britânico Alan Turing, que sugeriu que uma máquina poderia ser considerada “inteligente” se suas respostas fossem indistinguíveis das de um ser humano. Mas isso não é evidência de consciência; apenas comprova que o teste não é tão útil quanto se supunha.

Para mim, a questão principal não é se as máquinas são conscientes ou não, mas sim por que é tão fácil para nós imaginar que são. Em outras palavras, a questão é a facilidade com que as pessoas antropomorfizam ou projetam características humanas em tecnologias, em vez de enxergá-las apenas como máquinas.

PREDISPOTOS A "HUMANIZAR"

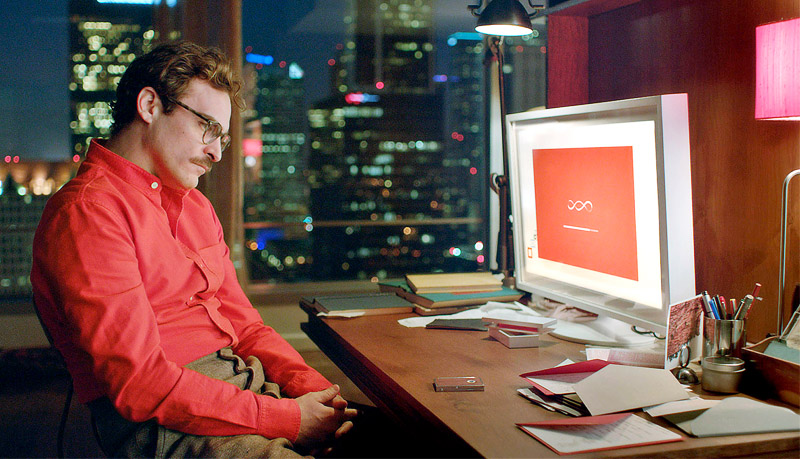

É fácil imaginar usuários do Bing pedindo conselhos sobre decisões importantes e talvez até se apegando emocionalmente a ele. Mais pessoas poderiam começar a ver os bots como amigos ou até parceiros românticos, como Theodore Twombly (interpretado por Joaquin Phoenix), que se apaixona pela assistente virtual Samantha no filme “Ela”, dirigido por Spike Jonze.

As pessoas têm uma predisposição para antropomorfizar ou atribuir qualidades humanas a não-humanos. É comum dar nomes a barcos e a furacões, por exemplo. Muitos chegam, inclusive, a conversar com seus animais de estimação. Agora, imagine quando surgirem tecnologias que se parecem e soam como seres humanos.

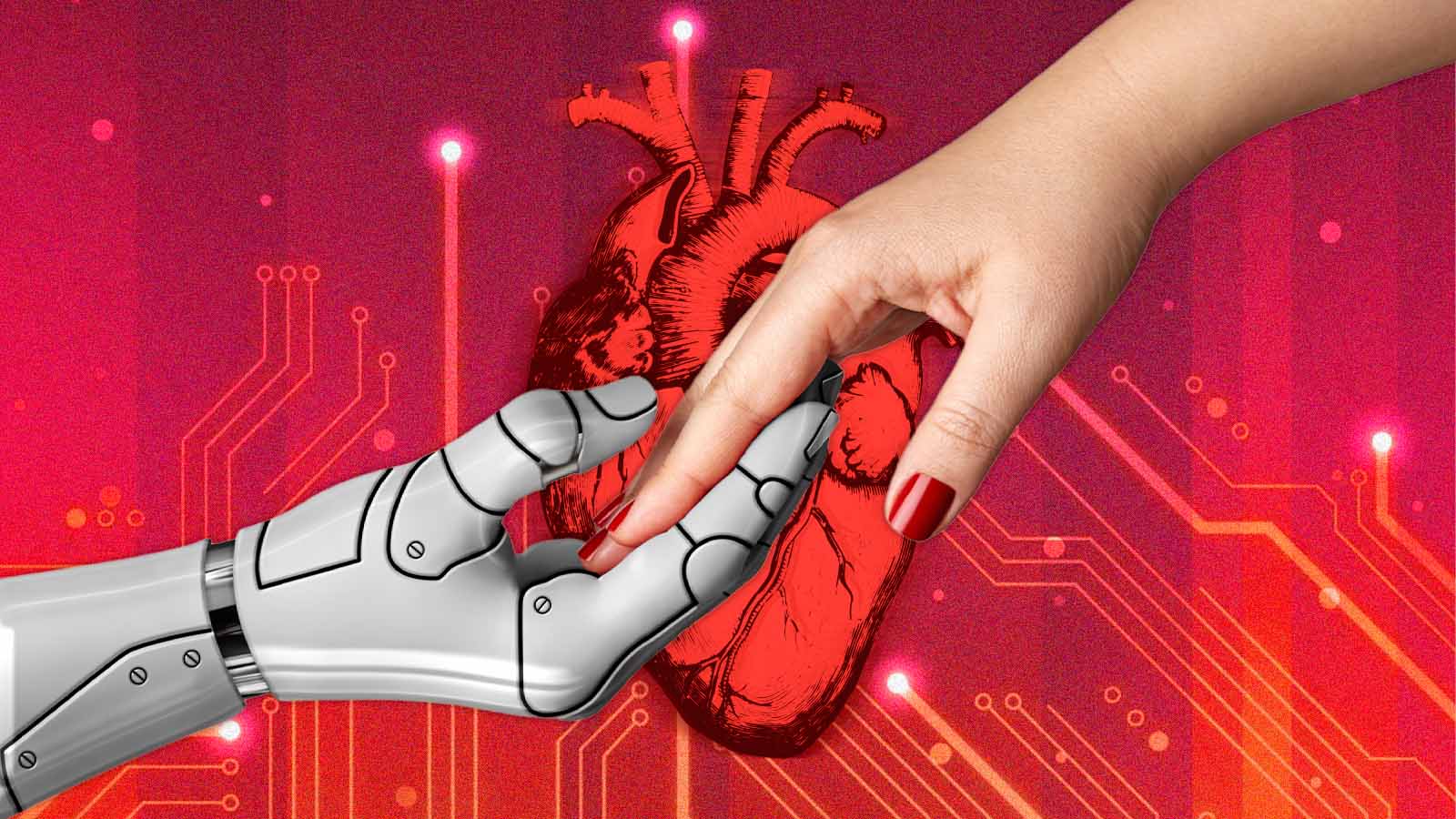

A tendência de ver máquinas como pessoas e se apegar a elas será ainda maior quando tiverem características mais próximas às nossas. E isso trará riscos reais de envolvimento psicológico com a tecnologia.

A ideia bizarra de se apaixonar por robôs, sentir uma profunda afinidade ou ser manipulado por eles é cada vez mais real. Acredito que essas tendências ressaltam a necessidade de garantir que as tecnologias não se tornem um perigo para o psicológico das pessoas.

Infelizmente, nem sempre se pode confiar nas empresas para isso. Muitas ainda seguem o famoso lema de Mark Zuckerberg “seja rápido e quebre limites” – uma diretriz para lançar produtos ainda não finalizados e se preocupar com as implicações depois.

Na última década, empresas como Snapchat e Facebook vêm colocando o lucro acima da saúde mental de seus usuários e da integridade das democracias em todo o mundo.

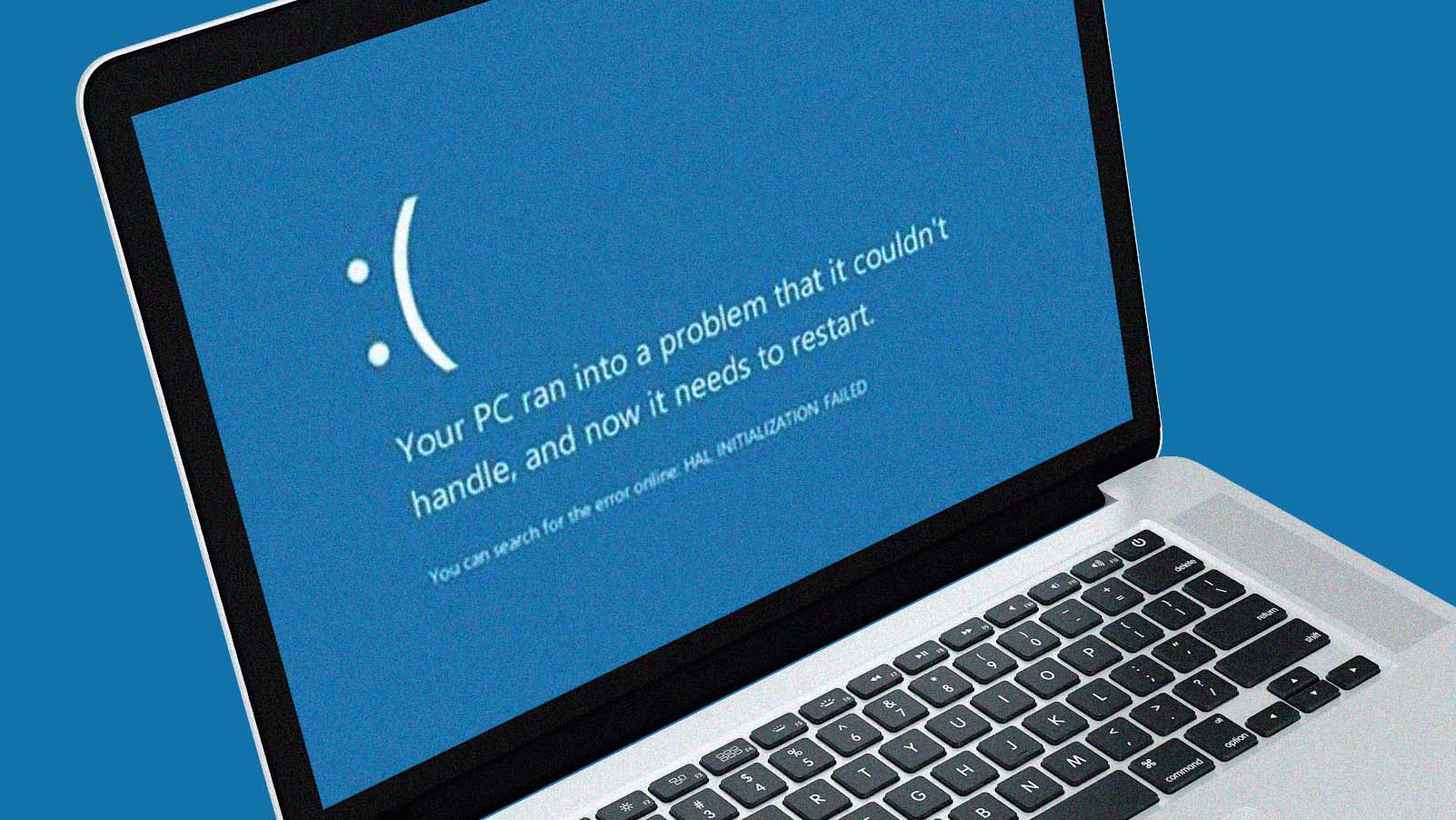

O CEO da OpenAI, empresa que desenvolveu o ChatGPT, em um lapso de honestidade, alertou que “é um erro confiar [no ChatGTP] para qualquer coisa importante agora… temos muito trabalho a fazer em termos de robustez e veracidade.”

Então, por que lançar uma tecnologia com tanto apelo – o ChatGTP é o aplicativo de crescimento mais rápido já desenvolvido – quando não é confiável e não tem a capacidade de distinguir fatos de ficção?

Grandes modelos de linguagem podem ser úteis para escrita e programação. Eles provavelmente vão revolucionar as buscas na internet. E, um dia, combinados de forma responsável com a robótica, podem até trazer certos benefícios psicológicos.

No entanto, também são uma tecnologia potencialmente predatória, que pode facilmente tirar proveito da predisposição humana de projetar personalidade em objetos – uma tendência que fica ainda mais acentuada quando esses objetos imitam traços humanos.

Este artigo foi publicado por The Conversation e reproduzido sob licença Creative Commons. Leia o artigo original.