Uma arma para combater fraudes com IA generativa: a marca d’água

Existem medidas razoáveis e tecnologicamente viáveis que podem ser aplicadas para ajudar a combater abusos

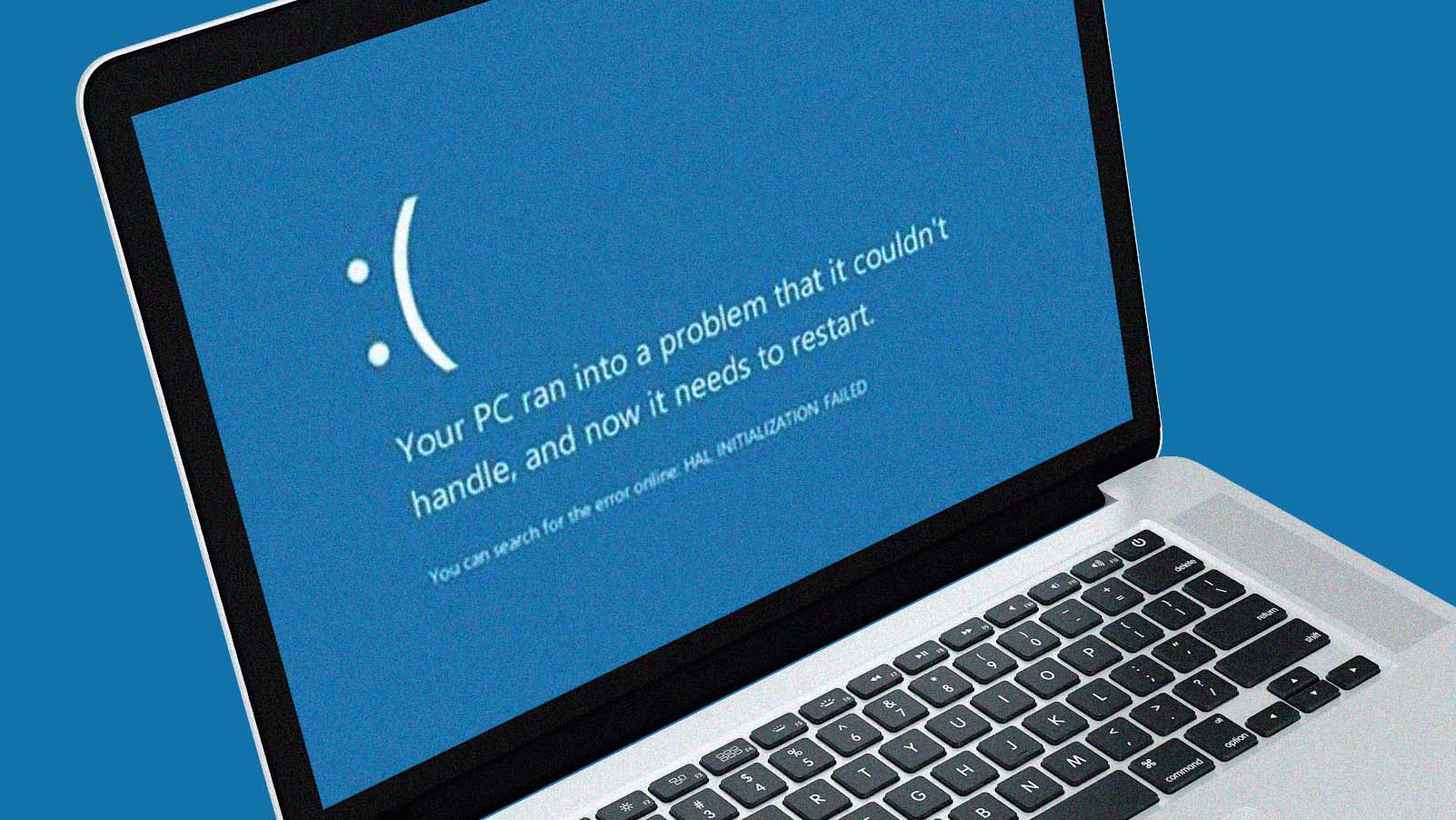

Pouco depois de vazarem rumores sobre o indiciamento iminente do ex-presidente Donald Trump, imagens mostrando sua prisão surgiram na internet. Pareciam fotos publicadas em um jornal, mas eram falsas. Elas foram criadas por um sistema de inteligência artificial generativa.

Esta tecnologia se tornou popular com o surgimento de geradores de imagens, como o DALL-E, Midjourney e Stable Diffusion, e de chatbots, como Bard, ChatGTP e LLaMA.

Combinando algoritmos inteligentes de machine learning com bilhões de conteúdos gerado por humanos, esses sistemas podem fazer qualquer coisa, desde criar uma imagem assustadoramente realista a partir de uma legenda, gerar um discurso na voz do presidente Joe Biden, substituir a aparência de uma pessoa por outra em um vídeo até escrever um artigo de opinião coerente a partir de um prompt.

Embora os áudios e vídeos ainda não tenham ultrapassado completamente o chamado “vale da estranheza” – aquele

Os avanços na IA generativa logo significarão que o conteúdo falso, mas visualmente convincente, se espalhará pela internet.

ponto em que uma tecnologia é parecida com um humano de verdade, mas não totalmente realista, gerando assim uma sensação perturbadora –, é provável que o façam em breve. Quando isso acontecer, e é quase certo que acontecerá, se tornará cada vez mais simples distorcer a realidade.

Neste novo mundo, será fácil gerar um vídeo de um CEO dizendo que os lucros de sua empresa caíram 20%, o que poderia levar a bilhões em perda de participação de mercado; ou gerar um vídeo de um líder mundial ameaçando uma ação militar, o que poderia desencadear uma crise geopolítica; ou até mesmo inserir a imagem de alguém em um vídeo de sexo explícito.

Os avanços na IA generativa logo significarão que o conteúdo falso, mas visualmente convincente, se espalhará pela internet, levando a um ecossistema de informações ainda mais confuso. Outra consequência é a facilidade com que detratores poderão desqualificar evidências em vídeo, desde violência policial até um líder mundial queimando documentos ultrassecretos.

Enquanto a sociedade encara o que é quase certamente apenas o começo desses avanços na IA generativa, existem medidas razoáveis e tecnologicamente viáveis que podem ser aplicadas para ajudar a combater esses abusos. Como cientista da computação especializado em análise forense de imagens, acredito que a marca d’água seja um método eficaz.

MARCAS D’ÁGUA

Há séculos usamos algum tipo de marcação ou selo para comprovar a autenticidade de documentos, produtos e outros itens. Hoje, a Getty Images adiciona marcas d’água visíveis em todo o seu banco de imagens. Isso permite que as pessoas tenham acesso livre a ele, enquanto garante a proteção dos ativos da empresa.

Elas também são usadas para proteger direitos autorais. Podem ser adicionadas a imagens digitais a cada 10 pixels, por exemplo, para que sua cor (normalmente um número no intervalo de 0 a 255) tenha um valor uniforme.

Esse ajuste é tão pequeno que a marca d’água se torna imperceptível. E, como é improvável que esse padrão periódico ocorra naturalmente, pode ser usado para verificar a procedência de uma imagem.

Mesmo imagens com resolução média contêm milhões de pixels, o que significa que informações adicionais podem ser incorporadas à marca d’água, como um identificador exclusivo que codifica o software gerador ou o ID de um usuário. E isso também pode ser aplicado em áudio e vídeo.

O ideal é que seja imperceptível e resistente a edições simples, como corte, redimensionamento, ajuste de cores e conversão de formato. Embora o exemplo de marca d’água incorporada à cor do pixel não seja totalmente seguro, já que seus valores podem ser alterados, existem estratégias que impedem tentativas de removê-las.

MARCA D’ÁGUA E IA

As marcas podem ser inseridas nos dados de treinamento de sistemas de IA generativa. Desta forma, todo o conteúdo gerado carregará a mesma marca d’água.

Esta é uma solução atraente porque permite que as ferramentas de IA generativa sejam de código aberto, sem a preocupação de que a marca possa ser removida. Mas os caracteres em um parágrafo não podem, é claro, ser ajustados como um valor de pixel. Por isso, a marca d’água precisa assumir uma forma diferente.

A IA generativa usada em geradores de texto se baseia na previsão da próxima palavra mais provável em uma frase. Por exemplo, a partir do trecho “um sistema de IA pode...”, o ChatGPT deduzirá que o complemento deve ser “aprender”, “prever” ou “entender”.

se as grandes empresas de tecnologia aplicarem essas regras e banirem softwares que não estão de acordo com elas, o dano será reduzido significativamente.

Essas palavras estão associadas à probabilidade de uma delas ser usada na frase. O ChatGPT aprendeu como prevê-las a partir de um grande conjunto de textos em que foi treinado. Assim, é possível adicionar secretamente uma marca d’água em um texto gerado através de marcações em um subconjunto de palavras e, então, influenciar sua escolha.

Por exemplo, a palavra “compreender”, que carrega a marcação, será usada em vez de “entender”. Ao influenciar periodicamente a seleção de palavras dessa maneira, o texto recebe uma marca d’água com base em uma distribuição específica de marcações. Esse método geralmente é eficaz para textos de 800 ou mais palavras, dependendo dos detalhes específicos.

Os sistemas de IA generativa podem, e acredito que devem, adicionar marcas d’água em todo o seu conteúdo, para que seja mais fácil identificá-lo e, se necessário, fazer alguma intervenção. Se a indústria não fizer isso voluntariamente, os legisladores podem aprovar uma regulamentação para aplicar essa regra.

Alguns, é claro, não a cumprirão. Mas, se as grandes empresas – Apple, Google, Amazon, Microsoft e GitHub – aplicarem essas regras e banirem softwares que não estão de acordo com elas, o dano será reduzido significativamente.

A sociedade vem travando, há décadas, uma batalha contra ameaças cibernéticas, como spams, malwares e phishing. Com as fraudes que utilizam IA generativa não será diferente.

Este artigo foi publicado originalmente em The Conversation e reproduzido sob licença Creative Commons. Leia o original.