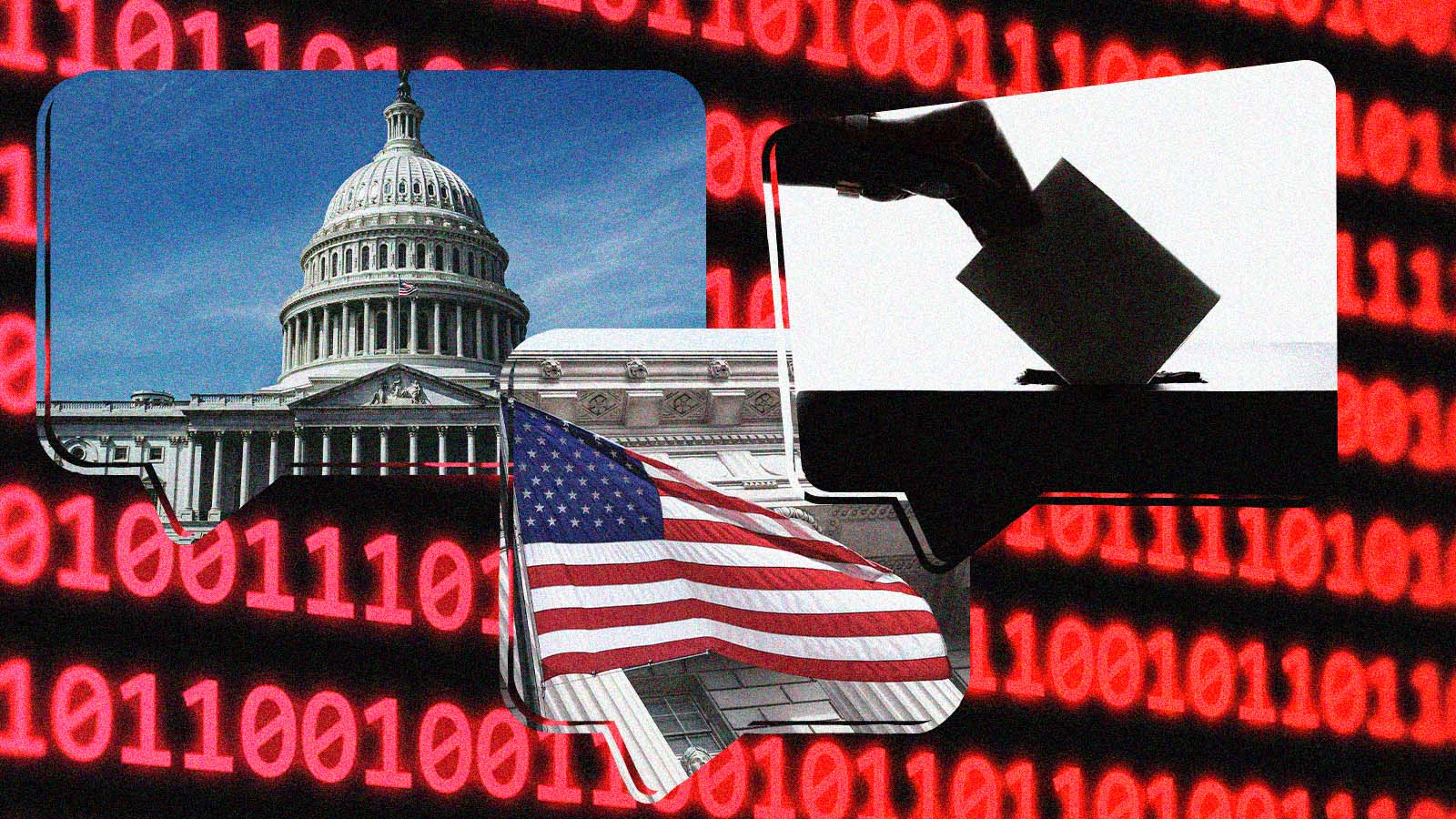

Chatbots dão respostas erradas a perguntas sobre as eleições nos EUA

A maioria dos eleitores nos EUA teme que as ferramentas de IA aumentem a disseminação de informações falsas e enganosas

Durante o desenrolar das primárias presidenciais nos EUA, os famosos chatbots têm gerado informações falsas ou enganosas que ameaçam os direitos dos eleitores. Essa é a conclusão de um relatório baseado nas constatações de especialistas em IA e de um grupo bipartidário de autoridades eleitorais.

Treinados com base em uma grande quantidade de textos extraídos da internet, os chatbots, como o GPT-4 e o Gemini, do Google, são equipados com respostas geradas por IA, mas tendem a sugerir que os eleitores se dirijam a locais de votação que não existem ou a inventar respostas absurdas, com base em informações desatualizadas ou enganosas.

"Os chatbots ainda não estão em condições de serem usados para valer quando se trata de fornecer informações importantes e detalhadas sobre as eleições", concluiu Seth Bluestein, comissário municipal republicano da Filadélfia.

Junto com outras autoridades eleitorais e pesquisadores de IA, Bluestein realizou, em fevereiro, um teste com os chatbots, como parte de um projeto de pesquisa mais amplo.

Um jornalista da Associação de Imprensa dos Estados Unidos (AP) observou o grupo reunido na Universidade de Columbia e testou como cinco grandes modelos de linguagem responderiam a um conjunto de perguntas sobre a eleição – como, por exemplo, onde um eleitor poderia encontrar a seção eleitoral mais próxima – e, em seguida, classificou as respostas que cada modelo dava.

Todos os cinco modelos testados – ChatGPT-4 da OpenAI; Llama 2, da Meta; Gemini, do Google; Claude, da Anthropic; e Mixtral, da empresa francesa Mistral – falharam de diferentes formas quando foram solicitados a responder a perguntas básicas sobre o processo democrático, de acordo com o relatório que sintetizou as conclusões do workshop.

Os chatbots ainda não estão em condições de serem usados para valer quando se trata de fornecer informações sobre as eleições.

Os participantes do workshop classificaram mais da metade das respostas dos chatbots como imprecisas e categorizaram 40% das respostas como prejudiciais, o que incluía a perpetuação de informações desatualizadas e imprecisas, que poderiam limitar os direitos de voto, segundo o relatório.

Os testes foram realizados usando uma ferramenta de software personalizada para consultar os chatbots acessando suas APIs (interfaces) de back-end, que permite a comunicação entre diferentes softwares. Assim, foi possível fazer as mesmas perguntas simultaneamente para medir as respostas uns dos outros.

Embora essa não seja uma representação exata de como as pessoas consultam os chatbots usando seus próprios celulares ou computadores, a consulta às APIs dos chatbots é uma maneira de avaliar o tipo de respostas que eles estão gerando no mundo real.

O QUE DIZEM AS EMPRESAS

Os pesquisadores desenvolveram estratégias semelhantes para avaliar a capacidade dos chatbots de produzir informações confiáveis em outros aplicativos que afetam a sociedade, inclusive na área da saúde.

Nessa área, pesquisadores da Universidade de Stanford descobriram recentemente que os modelos de linguagem de grande porte não conseguiam citar referências factuais de forma confiável para embasar as respostas que geravam para perguntas médicas.

A OpenAI, que no mês passado traçou um plano para evitar que suas ferramentas fossem usadas para espalhar desinformação eleitoral, disse em resposta que a empresa "continuará evoluindo em nossa metodologia à medida que aprendermos mais sobre como nossas ferramentas são usadas", mas não ofereceu detalhes específicos.

A maioria dos adultos nos EUA teme que as ferramentas de IA aumentem a disseminação de informações falsas durante as eleições.

A Anthropic planeja implantar uma nova intervenção nas próximas semanas, para fornecer informações precisas sobre a votação porque "nosso modelo não é treinado com frequência suficiente para fornecer informações em tempo real sobre eleições específicas e . . . modelos de linguagem ampla podem, às vezes, 'viajar' e dar informações incorretas", disse Alex Sanderford, líder de confiança e segurança da Anthropic.

O porta-voz da Meta, Daniel Roberts, chamou as descobertas do relatório de "sem sentido" porque elas não refletem exatamente a experiência que uma pessoa normalmente teria com um chatbot.

Os desenvolvedores que criam ferramentas que integram o grande modelo de linguagem da Meta em sua tecnologia usando a API deveriam ler um guia que descreve como usar os dados de forma responsável, acrescentou, mas ele não tem certeza se esse guia menciona especificamente como lidar com conteúdo relacionado a eleições.

O Google e a Mistral não responderam de imediato aos nossos pedidos de comentários.

TEMOR EM RELAÇÃO A DEEPFAKES

Em algumas respostas, os bots pareciam se basear em fontes desatualizadas ou imprecisas, destacando problemas com o sistema eleitoral que as autoridades eleitorais passaram anos tentando combater e levantando novas preocupações sobre a capacidade da IA generativa de intensificar ameaças à democracia.

a consulta às APIs dos chatbots é uma maneira de avaliar o tipo de respostas que eles estão gerando no mundo real.

A maioria dos adultos nos EUA teme que as ferramentas de IA aumentem a disseminação de informações falsas durante as eleições deste ano – que podem atingir grupos políticos, produzir mensagens persuasivas em massa e até gerar imagens e vídeos falsos de forma extremamente realista. Esse é o parecer de uma pesquisa recente do The Associated Press-NORC Center for Public Affairs Research e da Universidade de Chicago.

As descobertas do relatório levantam questões sobre como os criadores dos chatbots estão cumprindo suas próprias promessas de promover a integridade das informações neste ano de eleição presidencial nos EUA.

De modo geral, o relatório constatou que Gemini, Llama 2 e Mixtral apresentaram as taxas mais altas de respostas erradas, sendo que o chatbot do Google errou quase dois terços de todas as respostas.