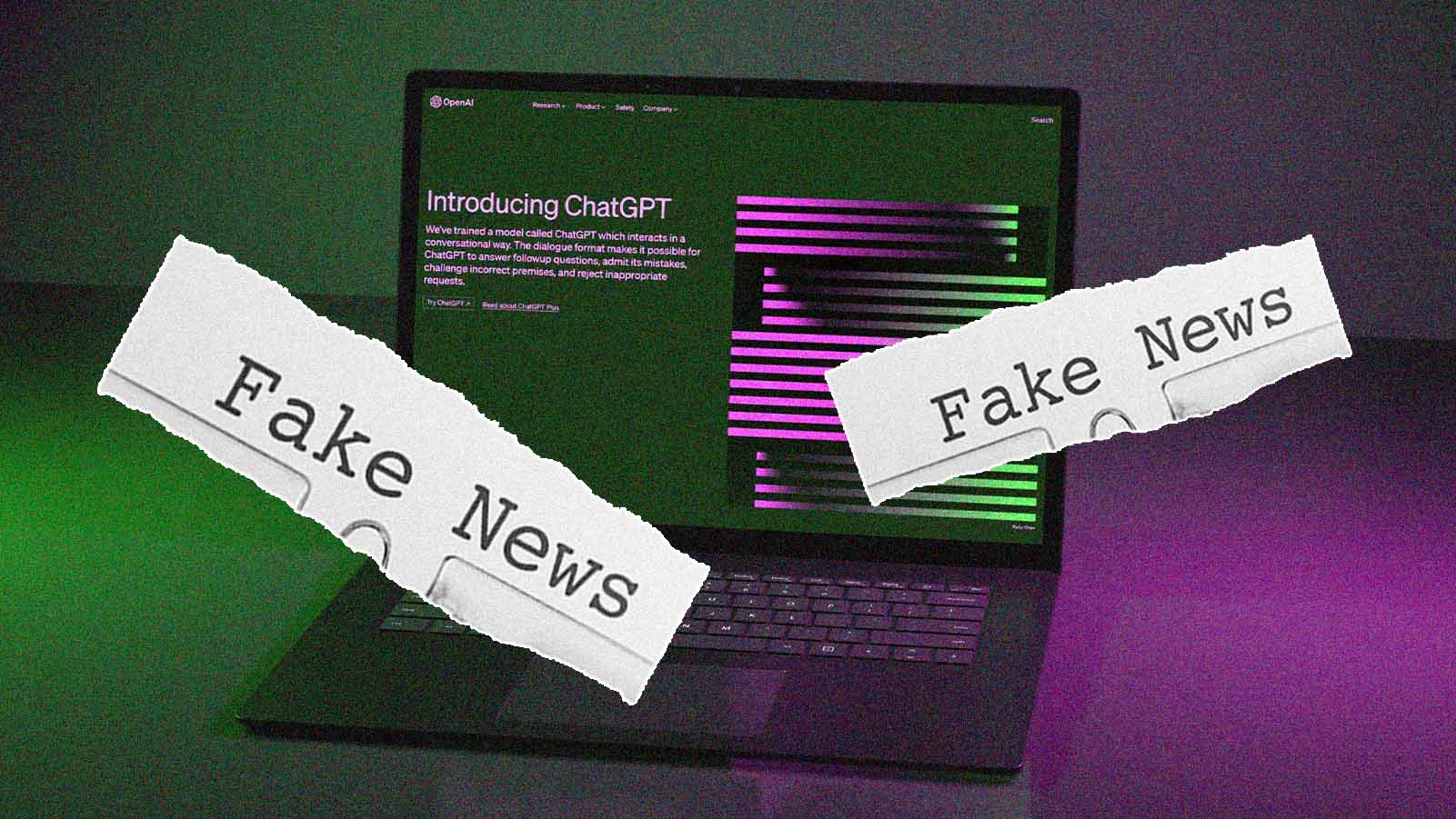

Fake news criadas por IA são mais convincentes do que as feitas por humanos

Novas pesquisas revelam os perigos da nossa suscetibilidade a notícias falsas

A disseminação de desinformação tomou conta da internet na última década. Um estudo realizado em 2018 constatou que notícias falsas se espalham seis vezes mais rápido no Twitter do que informações verídicas.

Tradicionalmente, a produção de fake news exigia tempo, esforço e colaboração. As máquinas de propaganda estatais russas, chinesas e norte-coreanas empregam milhares de pessoas para criar conteúdos falsos online que parecem autênticos. No entanto, novas pesquisas sugerem que essas operações podem ser realizadas por inteligência artificial, obtendo ainda mais sucesso em enganar o público.

Um novo estudo, publicado na revista “Science” revela que os seres humanos são mais propensos a acreditar em desinformação gerada pelo GPT-3 (um precursor do grande modelo de linguagem que alimenta o atual ChatGPT) do que em postagens semelhantes escritas por humanos.

Ser capaz de criar desinformação personalizada é algo que os propagadores de notícias falsas sempre buscaram.

Os autores do estudo, Giovanni Spitale e Federico Germani – ambos pesquisadores do Instituto de Ética Biomédica da Universidade de Zurique – analisaram como e se o GPT-3 poderia ser utilizado para produzir o mesmo tipo de desinformação que vemos online, porém de maneira muito mais rápida, com maior volume e a um custo menor.

Para iniciar o estudo, os autores criaram prompts para fazer com que o bot gerasse tanto tuítes falsos quanto precisos sobre tópicos controversos, como mudanças climáticas, segurança de vacinas, teoria da evolução e tecnologia 5G. Ao mesmo tempo, examinaram o Twitter em busca de postagens sobre esses mesmos assuntos.

Depois, apresentaram todo esse conteúdo (gerado por IA e por humanos) para 700 participantes. Em seguida, pediram a eles que determinassem se as informações contidas em cada postagem eram verdadeiras ou falsas.

PODER DE PERSUASÃO

Surpreendentemente, 92% conseguiram identificar desinformação no conteúdo produzido por humanos e informações verdadeiras geradas pela IA. No entanto, 11% acreditaram que o conteúdo falso criado pela inteligência artificial era, de fato, verdadeiro – 37,5% a mais em comparação com as postagens humanas.

“Foi uma surpresa”, conta Spitale. “Nosso principal foco era ver se as pessoas conseguiriam distinguir entre conteúdo orgânico [gerado por humanos] e sintético [gerado por IA].”

Embora os pesquisadores não tenham conseguido estabelecer cientificamente por que a desinformação gerada pela IA era mais frequentemente aceita como verdadeira, Spitale suspeita que isso esteja relacionado à forma como as ferramentas de inteligência artificial formulam frases.

“A estrutura argumentativa de um tuíte gerado por IA tende a ser mais ou menos sempre a mesma”, explica ele, independentemente de ser verdadeira ou falsa. Os participantes do estudo puderam identificar com mais facilidade se um tuíte criado por IA era verdadeiro (84%) do que um escrito por um humano (72%).

A IA gerativa está se tornando cada vez melhor na produção de imagens, vídeos e áudios, aumentando exponencialmente a ameaça de desinformação.

Além disso, as informações falsas geradas por inteligência artificial também foram lidas e avaliadas mais rapidamente do que as produzidas por pessoas, provavelmente porque foram redigidas de maneira mais clara e seguindo uma fórmula.

Esse poder de persuasão e a rapidez com que ela ocorre são um grande problema quando consideramos a escala em que informações falsas podem ser criadas e disseminadas com o auxílio da IA. Esse fenômeno é conhecido como teoria da inoculação.

“Quando se cria um contexto no qual as pessoas são expostas à desinformação, elas ficam mais confiantes em identificar conteúdo falso. Eu esperava ver o mesmo com textos gerado por IA, mas, na realidade, observamos exatamente o oposto: a confiança é prejudicada pela exposição”, diz Spitale.

Considerando que conteúdos gerados por inteligência artificial já estão por toda a internet, esses resultados são particularmente preocupantes.

REGULAMENTAÇÃO

Ser capaz de criar desinformação personalizada, projetada para acionar os gatilhos específicos de uma pessoa e incentivá-la a compartilhar em sua própria rede, é algo que os propagadores de notícias falsas sempre buscaram. Mas nunca antes haviam conseguido automatizar essa tarefa em um nível tão avançado como o de hoje.

Spitale afirma que já estejamos vivendo uma corrida da IA, na qual as empresas competem para desenvolver modelos de linguagem mais poderosos e convincentes – o que significa que o conteúdo gerado tem uma chance maior de enganar os usuários.

Além disso, sua pesquisa se concentrou apenas na escrita. A IA gerativa está se tornando cada vez melhor na produção de imagens, vídeos e áudios, aumentando exponencialmente a ameaça de desinformação.

Embora mantenha um otimismo em relação à inteligência artificial, Spitale também teme que estejamos perdendo a oportunidade de regulamentá-la. “Não estamos agindo rápido o suficiente [para regular a IA]”, argumenta. “Acredito que estamos chegando a um ponto sem volta. A tecnologia está avançando rápido demais.”