Projeto quer evitar que as pessoas sejam enganadas por imagens falsas

A Iniciativa de Autenticidade de Conteúdo liderada pela Adobe ajudará as pessoas a distinguir o que é real do que foi manipulado por IA

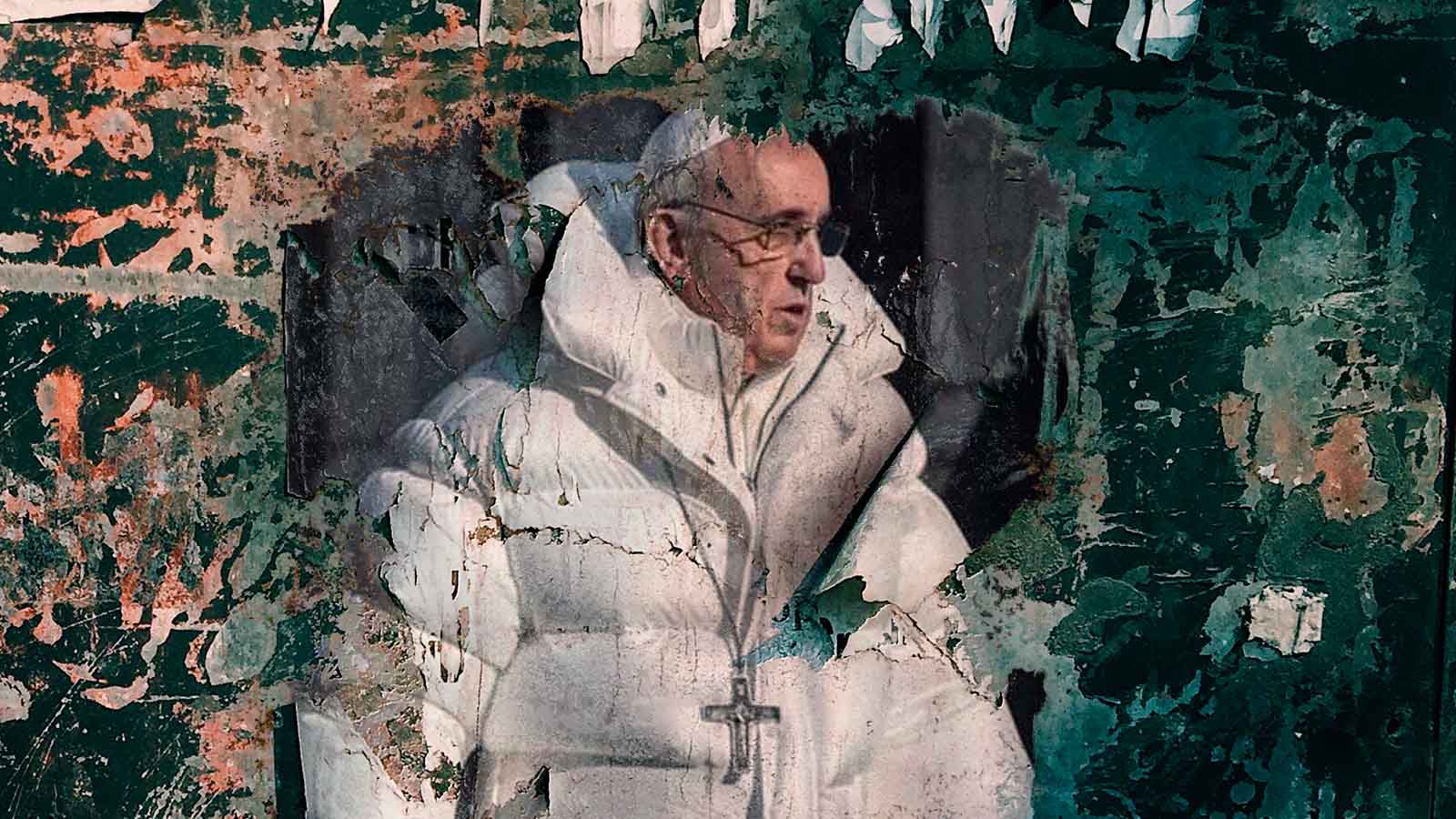

Ao tentar fazer com que outras empresas ajudassem a desmascarar deepfakes, o vice-presidente executivo da Adobe, Dana Rao, recebeu uma ajuda inesperada do papa Francisco. Uma imagem falsa do papa com um casaco branco, que viralizou em março depois de ter sido gerada no Midjourney, enganou muita gente.

Apesar de ter sido uma brincadeira inofensiva, Rao, que nos últimos cinco anos trabalhou como conselheiro geral da Adobe, diz que o caso chamou a atenção e serviu para impulsionar a Content Authenticity Initiative (Iniciativa de Autenticidade de Conteúdo), um grupo liderado pela Adobe que quer trazer transparência às obras de arte geradas por IA.

"A quantidade de participantes da iniciativa aumentou porque as pessoas perceberam a intensidade do problema que estávamos tentando resolver", diz Rao. "Aquela foto Papa foi um evento catalisador."

O objetivo é colocar nas imagens online uma espécie de rótulo. As que fazem parte da Iniciativa contarão com um tipo de marcação no qual o usuário poderá clicar para obter informações sobre sua origem. A Adobe e outras empresas vão disponibilizar páginas com mais recursos, incluindo uma forma de comparar as imagens com os originais, não adulterados.

Rao e o diretor de estratégia da Adobe, Scott Belsky, tiveram a ideia em 2019, depois de apresentar alguns recursos de IA na conferência anual de criatividade da empresa. Mesmo antes do boom da IA generativa, eles perceberam que a tecnologia abriria uma caixa de Pandora de desinformação.

As imagens contarão com um tipo de marcação no qual o usuário poderá clicar para obter informações sobre sua origem.

Eles sabiam que a rotulagem manual do conteúdo da IA seria inviável e que a utilização de tecnologia para detectar deepfakes nunca seria suficientemente precisa para ser confiável. Assim, Rao resolveu criar uma forma de os usuários fazerem a checagem por si mesmos.

"As pessoas já não acreditam nas instituições. Por isso, nossa solução com as credenciais de conteúdo é, basicamente, dizer: 'eis o que aconteceu, você decide'", afirma.

A Iniciativa de Autenticidade de Conteúdo não é a única forma pela qual a Adobe tenta resolver as questões éticas da IA. Com as suas próprias ferramentas de IA generativa, batizada de Firefly, a empresa treinou seus modelos de forma a evitar potenciais violações de direitos autorais e se ofereceu para compensar seus clientes se forem processados por seu uso.

Mas, quando se trata de deepfakes, não há como uma empresa fazer tudo sozinha. Nos últimos quatro anos, Rao tem sido responsável por trazer mais membros para a Iniciativa de Autenticidade de Conteúdo, incluindo fabricantes de câmaras, veículos de mídia e fabricantes de software concorrentes.

É um trabalho em progresso. O grupo ainda está em conversações com as redes sociais, que têm que decidir como integrar os “rótulos” ou se vão utilizar soluções completamente diferentes. Além disso, será necessário investir na educação do público para que as pessoas compreendam o que é um rótulo de imagem com IA.

Mas, com a próxima eleição presidencial dos EUA a pouco mais de um ano de distância, Rao vê outro evento catalisador no horizonte. "Não queremos que as eleições sejam decididas por deepfakes virais", afirma.