Dicas para identificar imagens modificadas por inteligência artificial

Desde os primeiros casos de deepfakes, a manipulação de fotos e vídeos foi ficando mais sofisticada. Mas existem formas de identificar as falsificações

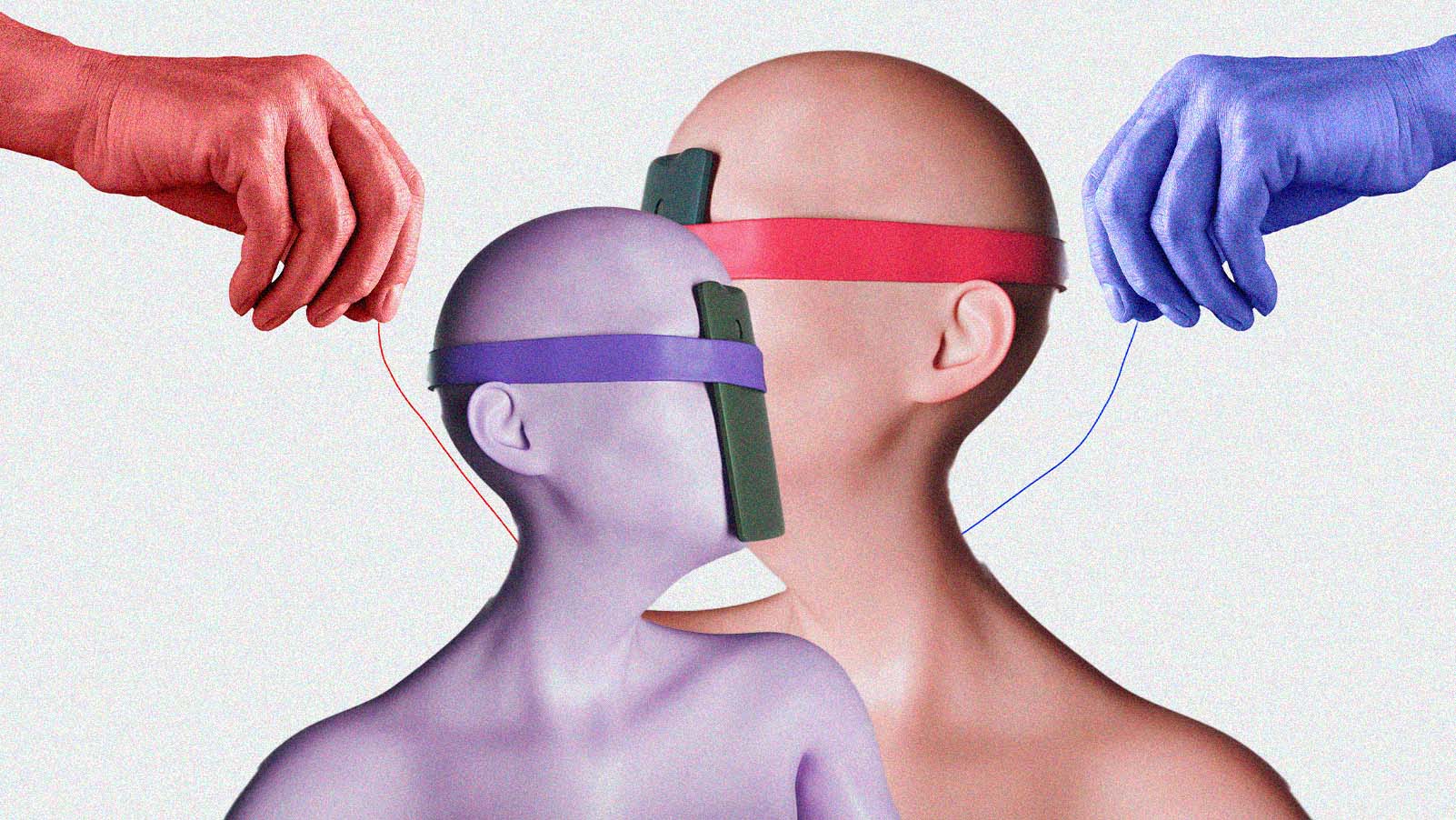

A falsificação por IA está se tornando rapidamente um dos maiores problemas que enfrentamos online. Imagens, vídeos e áudios enganosos estão proliferando como resultado do aumento de opções e do uso indevido de ferramentas de inteligência artificial generativa.

Com deepfakes de IA surgindo quase todos os dias, está se tornando mais difícil distinguir o que é real do que não é. Geradores de vídeo e imagem como DALL-E, Midjourney e Sora tornam fácil para pessoas sem muito conhecimento técnico criar deepfakes.

Essas imagens falsas podem parecer inofensivas. No entanto, elas podem ser usadas para dar golpes, roubo de identidade ou manipulação eleitoral. Aqui vão algumas dicas para evitar ser enganado por deepfakes:

COMO IDENTIFICAR UM DEEPFAKE

No começo da onda dos deepfakes, a tecnologia estava longe de ser perfeita e muitas vezes deixava sinais evidentes de manipulação. Pessoas que trabalhavam com verificação de informações conseguiam apontar imagens com erros óbvios, como mãos com seis dedos ou óculos com lentes de formatos diferentes.

Mas, à medida que a IA melhorou, foi ficando mais difícil. Algumas dicas básicas – como procurar por padrões de piscadas não naturais nas pessoas que aparecem em vídeos suspeitos de manipulação – não são mais válidos, alerta Henry Ajder, um dos principais especialistas em IA generativa. Ainda assim, há algumas coisas que dá para observar.

Muitas fotos adulteradas com IA, especialmente de pessoas, têm um brilho eletrônico, um efeito de "suavização estética" que deixa a pele "com um aspecto brilhante", diz Ajder. No entanto, ele alerta que imagens geradas a partir de indicações mais elaboradas podem eliminar esse e muitos outros sinais de manipulação por IA.

Verifique a consistência das sombras e da iluminação. Muitas vezes, o sujeito está em foco nítido e parece bem realista, mas os elementos do fundo podem não ser tão realistas ou brilhantes.

REPARE NOS ROSTOS

A troca de rostos é um dos métodos de deepfake mais comuns. Especialistas recomendam observar de perto as bordas da face. O tom da pele corresponde ao resto da cabeça ou do corpo? As bordas do rosto são nítidas ou borradas?

Se você suspeitar que um vídeo de uma pessoa falando foi adulterado, observe a boca. Os movimentos dos lábios correspondem perfeitamente ao áudio? Ajder sugere observar os dentes. Eles estão nítidos ou borrados e, de alguma forma, não consistentes com a aparência na vida real?

A empresa de cibersegurança Norton diz que os algoritmos podem ainda não ser sofisticados o suficiente para gerar dentes um por um, então a falta de contornos para dentes individuais pode ser uma pista.

ATENTE PARA O CONTEXTO

Às vezes, o contexto importa. Dê uma pausa para considerar se o que você está vendo é plausível. O site de jornalismo Poynter aconselha que, se você vir uma figura pública fazendo algo que pareça "exagerado, irrealista ou fora de propósito", pode ser um deepfake.

Por exemplo, o papa realmente estaria usando um casacão fofo de luxo, conforme retratado em uma foto falsa que ficou famosa? Se estivesse, não haveria fotos ou vídeos adicionais publicados por fontes legítimas?

USE IA PARA ENCONTAR OS FAKES

Outra abordagem é usar a IA para combater a IA. A Microsoft desenvolveu uma ferramenta de autenticação que pode analisar fotos ou vídeos para dá uma "nota" sobre a confiabilidade do material. O FakeCatcher, da Intel, usa algoritmos para analisar os pixels de uma imagem para determinar se é real.

Existem ferramentas online que prometem detectar falsificações se você carregar um arquivo ou colar um link para o material suspeito. Mas algumas, como o autenticador da Microsoft, estão disponíveis apenas para parceiros selecionados e não para o público em geral. Isso porque os pesquisadores não querem alertar os criminosos e dar a eles uma vantagem maior na "corrida armamentista" dos deepfakes.

O acesso livre a ferramentas de detecção também pode dar às pessoas a impressão de que são "tecnologias mágicas que podem terceirizar o pensamento crítico para nós", quando, na verdade, precisamos estar cientes das limitações dessas tecnologias, aponta Ajder.

OS DESAFIOS DE ENCONTRAR FALSIFICAÇÕES

Dito tudo isso, a IA tem avançado a uma velocidade vertiginosa e os modelos de linguagem (LLMs) estão sendo treinados com dados da internet para produzir conteúdo de qualidade cada vez melhor e com menos falhas. Ou seja, nada garante que essas dicas continuem válidas daqui a um ano.

Os especialistas dizem que pode ser perigoso deixar essa responsabilidade nas mãos de pessoas comuns, fazendo com que se sintam detetives digitais. Isso pode dar a elas uma falsa sensação de confiança à medida que se torna cada vez mais difícil, até mesmo para olhos treinados, detectar deepfakes.

Colaborou Ali Swenson, da Associated Press.