Quem vai pedir desculpas pelos danos dos deepfakes?

A pressão para que as big techs respondam pelos danos causados por suas plataformas cresceu na última semana. Durante audiência no Congresso dos Estados Unidos e pressionado pelo senador republicano Josh Hawrley, o CEO da Meta, Mark Zuckerberg, pediu desculpas aos pais de crianças e adolescentes vítimas de crimes nas redes sociais.

Depois de quase uma década e meia desde o início das redes sociais, a sociedade ainda não está preparada para responsabilizar aqueles que criaram o caos.

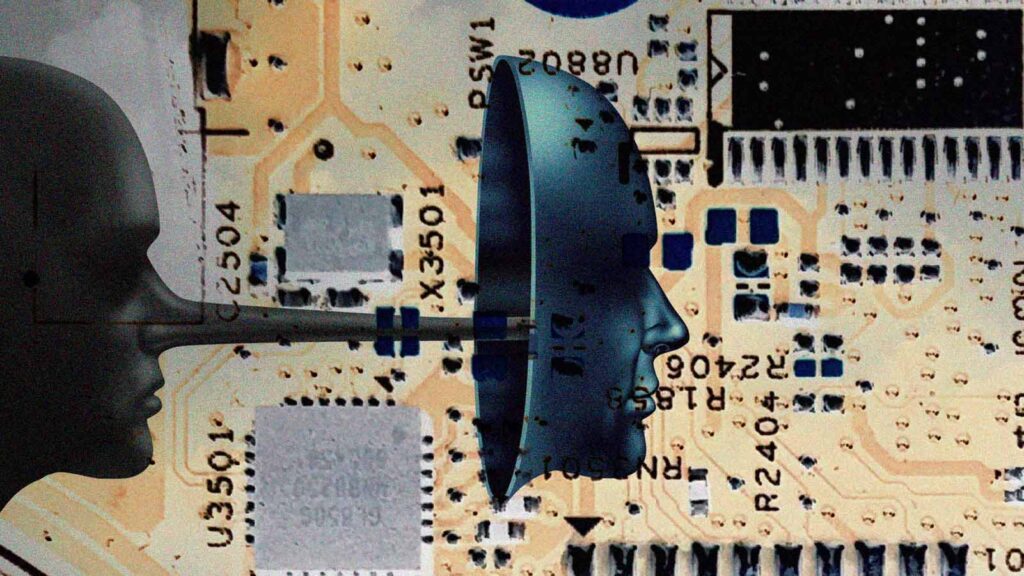

O que parecia ser a fase final de uma longa saga para controlar os efeitos danosos da tecnologia está mais para o começo de uma nova série ainda mais complicada. Porque, enquanto estávamos tentando entender os algoritmos, outra ferramenta ainda mais opaca e complicada entrou no ar e ganhou fôlego: a inteligência artificial generativa.

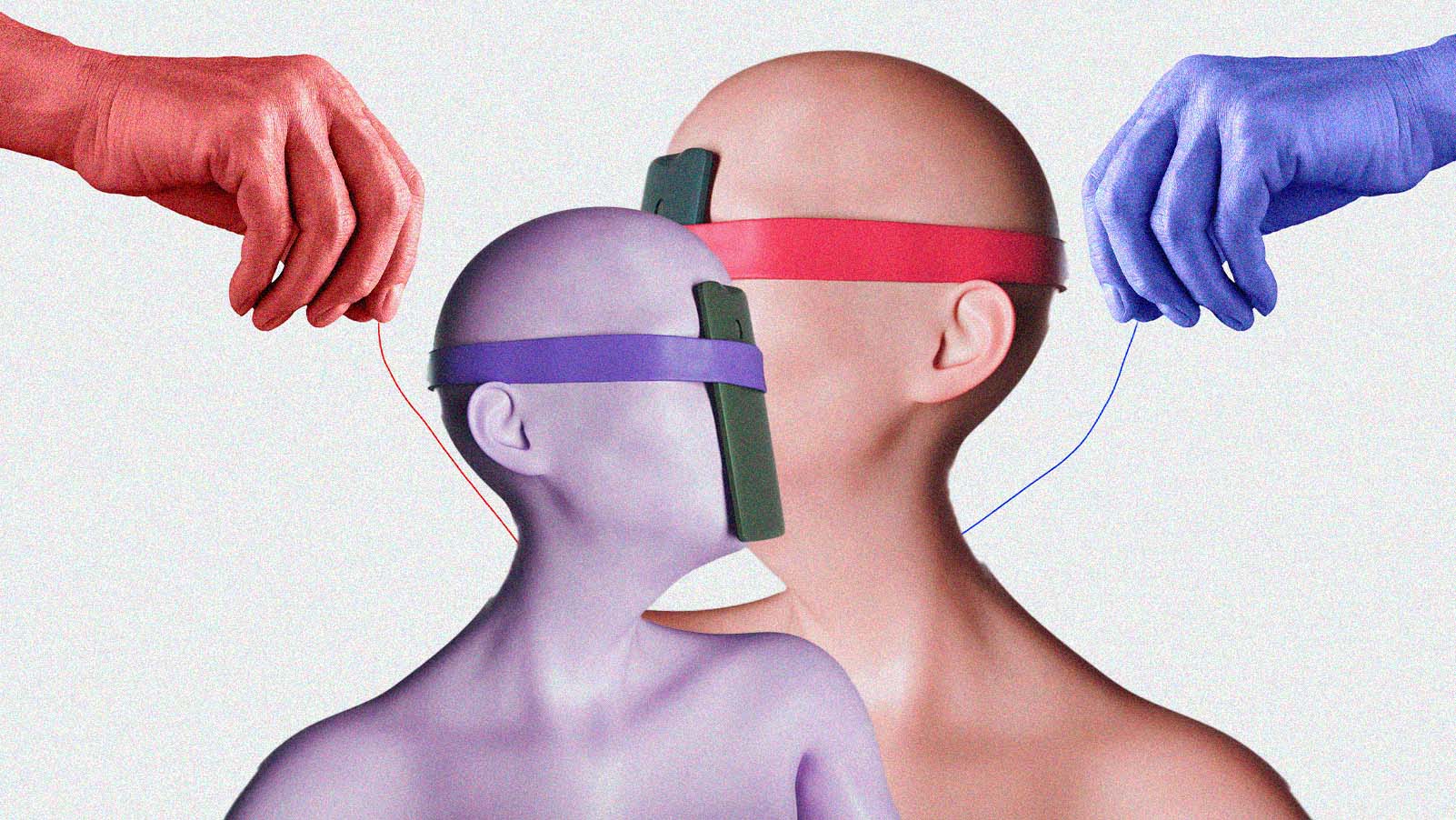

Por meio dela, imagens e vídeos hiper-realistas podem ser criados, manipulados e divulgados com rapidez. Imagens deepfakes têm potencial de elevar o grau de dano do mundo real.

Na semana passada, imagens pornográficas falsas da cantora Taylor Swift caíram nas redes. A reação de fãs pelo mundo todo levou as grandes empresas de tecnologia a banir os deepfakes, mas a ação demorou um pouco mais de um dia. O que é uma eternidade em termos de redes sociais. Apenas um dos perfis do X/ Twitter que continha as imagens já tinha recebido 45 milhões de visualizações.

Nem mesmo a fama blinda as pessoas da invasão de privacidade ou do uso indevido da sua imagem. Nos últimos meses, vídeos falsos de pessoas públicas no Brasil, como Pedro Bial, Claudia Raia e Dráuzio Varella, foram usados para promover supostos suplementos "milagrosos".

Celebridades não são as únicas atingidas pela manipulação de imagens. No final de 2023, mais de 20 alunas do sétimo e nono anos do Colégio da Barra, no Rio de Janeiro, foram vítimas da divulgação de imagens pornográficas falsas, produzidas por colegas de sala usando IA generativa.

O caso chegou aos tribunais e também à Câmara dos Deputados, que, no final de dezembro, aprovou alteração do código penal para agravar penas para a criação e promoção dos "deep nudes". Este é apenas o primeiro passo de um caminho ainda obscuro para os reguladores e para a sociedade.

"Simplesmente não estamos preparado para lidar com deepfakes no curto prazo", afirma Diogo Cortiz, professor da Pontifícia Universidade Católica de São Paulo (PUC/ SP) e pesquisador no Núcleo de Informação e Coordenação do Ponto BR (NIC.br), entidade que implementa as decisões do Comitê Gestor da Internet no Brasil.

SEM FILTRO ALGUM

A discussão deve ser feita em muitas camadas: da produção, da reprodução e da recepção dos deepfakes. Cada parte da cadeia tem um grau diferente de responsabilidade. Mas como captá-los? A saída da União Europeia (UE), o grupo de países que está mais próximo de aprovar regulação para IA,, é fazer tudo para evitar que tais mídias sejam produzidas.

A professora do IDP e autora do livro "Inteligência Artificial No Direito: Limites Éticos" , Tainá Junquilho, explica que a ˜"Lei da IA" da UE é baseada em sistemas de riscos. O ponto será analisar quais são os riscos que certos sistemas de inteligência artificial podem ter para a sociedade. Plataformas de reconhecimento facial, por exemplo, serão proibidas de serem comercializadas.

A regulação europeia também contabiliza os riscos de compartilhamento (ou seja, reprodução) dos deepfakes – a tão temida regulação das redes sociais. Segundo a regra, as big techs terão que providenciar avisos, marcas d'água e certificações de que a mídia publicada em seus espaços foi criada por sistemas automatizados.

A Câmara aprovou alteração do código penal para agravar penas para a criação e promoção dos chamados "deep nudes".

É aí que começa o perigo, segundo Carlos Affonso Souza, diretor do Instituto de Tecnologia e Sociedade (ITS Rio) e professor de direito da Universidade Estadual do Rio de Janeiro (UERJ).

Não há tecnologia suficiente para filtrar a IA generativa. Até porque, não se trata apenas de impedir vídeos pornográficos ou com conteúdos explícitos – o que ainda não se consegue fazer por inteiro – como também coibir produções vexatórias e manipuladas.

Um vídeo do empresário e apresentador Silvio Santos cantando uma música do Dire Straits é engraçado; um vídeo de Silvio Santos apoiando um candidato, não. E ainda existe o questionamento ético, como, por exemplo, no caso de Taylor Swift.

Depois das imagens criadas, a OpenAI e a Microsoft reforçaram os filtros para nomes de celebridades na ferramenta de geração de imagens. Se alguém tentar usar a palavra "Taylor Swift" no Dall-E, receberá uma negativa do sistema.

"Existem outros nomes que ainda podem ser usados. O que faz um estar no filtro e não o outro? Isso levanta outra questão mais profunda: só as pessoas conhecidas terão o direito à proteção automatizada nessas ferramentas?", questiona Souza.

Os sistemas atuais que dão rótulos para a mídia produzida não conseguem dar conta do volume de vídeos criados com IA. E, mesmo se conseguissem, haveria outro ponto-cego: as plataformas de código aberto, como a Stable Diffusion. Cortiz lembra que essas ferramentas não são comercializadas e têm seus próprios sistemas neurais – ou seja, podem operar abaixo do radar.

QUEM PAGA A CONTA?

Os filtros digitais serão necessários junto com o arcabouço legal, que ainda está em fases de discussão. No Brasil, a Comissão Temporária Interna sobre Inteligência Artificial promete um marco legal para a IA em abril. "A primeira pergunta a ser respondida no direito é se a responsabilidade vai ser civil ou criminal", lembra Carlos Affonso Souza.

Tainá, que participa da comissão de IA aplicada à justiça na Comissão Nacional de Justiça (CNJ), acredita que não há como fugir da responsabilização direta das plataformas de redes sociais. Para ela, será necessária a criação de uma agência independente ou de um conselho para avaliar caso a caso, como a Autoridade Nacional de Proteção de Dados (ANPD).

Talvez, o maior perigo dos deepfakes não seja o de nos fazer acreditar em uma mentira, mas de nos fazer parar de acreditar na verdade.

A advogada acredita que as eleições deste ano serão um bom teste para justiça brasileira com relação aos deepfakes. A justiça eleitoral vai monitorar de perto o tema e já está criando regras para o uso da "mídia sintética" em campanhas eleitorais.

Uma decisão proferida na semana passada pelo Tribunal Superior Eleitoral (TSE) já indica que o caminho a ser seguido será ir atrás dos mecanismos de compartilhamento das informações falsas, pedindo para os aplicativos retirarem as mensagens do ar.

De acordo com levantamento feito pelo jornal O Globo, três estados (Amazonas, Rio Grande do Sul e Sergipe) já registraram casos de uso de deepfakes por pré-candidatos. "Pensando no cenário eleitoral, o pior está por vir", diz Filipe Medon, doutor em Direito Civil pela UERJ (Universidade do Estado do Rio de Janeiro).

O advogado lembra do ocorrido nas eleições presidenciais da Argentina no ano passado. Vídeos verossímeis do candidato peronista, Sérgio Massa, usando cocaína viralizaram nas redes.

A gravação falsa foi vista por muita gente antes de ser desmentida e atingiu duramente a imagem de Sérgio Massa. E, o pior: ninguém foi responsabilizado. Até hoje, Milei afirma que não foi ato da sua campanha, mas de apoiadores do partido. "Esse é um argumento que poderá ser usado por candidatos aqui", avisa Medon.

Para o processo de desinformação, o alcance inicial das publicações já causa estrago suficiente. Não adianta a rede social ou de mensageria retirar as mensagens falsas. Deveria existir uma forma de exigir que as imagens e vídeos de desmentido chegassem na mesma quantidade de pessoas.

Dado o histórico da Meta, Google e TikTok, tal situação é “quase impossível de acontecer”, diz Medon. De acordo com o especialista, a falta de tecnologia para barrar a profusão de deepfakes em municipalidades cria um cenário nada otimista para o resto do ano.

VER PARA NÃO CRER

No outro lado de qualquer tecnologia existem aqueles que a percebem. E, embora com poder menor do que comparado ao das plataformas, os usuários ainda têm papel importante na hora da "redução de danos" causados por informações manipuladas.

Atos como verificar fontes, comparar com a realidade e se questionar fazem parte desse processo. A educação midiática é necessária. É um estado permanente de desconfiança.

A justiça eleitoral está criando regras para o uso da "mídia sintética" em campanhas eleitorais.

O impacto mais contundente dos deepfakes não são as leis, as empresas ou a tecnologia, e sim que eles mudam a maneira como a sociedade compreende o mundo. Normalmente, o vídeo de um acontecimento é a "prova cabal" de que o fato ocorreu.

A própria justiça recorre a vídeos para apoiar as evidências de algum crime. Isso não poderá mais acontecer. “Não existe mais o ver para crer”, afirma Cortiz, da PUC/ SP.

“Talvez, o maior perigo dos deepfakes não seja o de nos fazer acreditar em uma mentira, mas de nos fazer parar de acreditar na verdade”, analisa Medon.

Diante do avanço de novas tecnologias, sem regulamentação específica e responsabilização, o pedido de desculpas de Zuckerberg corre o risco de ser apenas um episódio emblemático, porém pouco efetivo.