Gemini, a aposta do Google na disputa pela liderança em IA generativa

A empresa anunciou uma prévia limitada e uma implementação gradual do modelo, que será integrado ao chatbot Bard

O Google foi pego desprevenido quando a OpenAI lançou o ChatGPT ao público, há um ano. Desde então, a big tech tem se esforçado para não ficar para trás.

Nesta quarta-feira (06 de dezembro), o Google anunciou seus novos (e poderosos) grandes modelos de linguagem (LLMs), batizados de Gemini. Segundo a empresa, são os primeiros LLMs construídos para processar não apenas palavras, mas também sons e imagens.

Modelos que podem ver e ouvir representam um grande avanço em termos de funcionalidade.

O Gemini foi desenvolvido pela divisão Google DeepMind, com participação em toda a organização. Com base no que foi mostrado à imprensa, o Gemini pode recolocar o Google na vanguarda da corrida pela liderança no setor de IA generativa.

O Gemini é uma família de modelos: Ultra (grande), para tarefas complexas de IA; Pro (tamanho médio), para trabalhos mais gerais; e Nano, projetado para rodar em celulares e similares – o Google planeja incorporar o Gemini ao sistema operacional Android de um de seus smartphones em 2024.

O modelo Ultra "ultrapassa os resultados atuais de última geração" em 30 dos 32 benchmarks usados para testar LLMs, segundo a empresa. Além disso, atingiu 90% em um teste mais difícil, chamado de Compreensão Multitarefa Maciça de Linguagem.

O teste avalia a capacidade de compreensão de um modelo em 57 áreas, incluindo matemática, física, história e medicina. O Google afirma que é o primeiro LLM a superar a maioria dos humanos no teste.

REALIDADE VIRTURAL, AUMENTADA E MISTA

Os modelos foram treinados (ou seja, autorizados a processar grandes quantidades de dados de treinamento por conta própria) usando imagens, áudio e código.

Segundo o Google, os novos modelos foram treinados usando "dados" do YouTube, mas não foi informado se eles realmente "assistiram" a vídeos, o que seria uma grande inovação. O modelo GPT-4 da OpenAI, por exemplo, é multimodal e pode aceitar prompts de imagem e voz.

Modelos que podem ver e ouvir representam um grande avanço em termos de funcionalidade. Ao ser executado em um celular Android, o Gemini (na versão Nano) poderia usar a câmera e os microfones do dispositivo para processar imagens e sons do mundo real.

Se o Nano for capaz de fazer algo semelhante ao que os modelos maiores fazem, poderia ser usado para identificar e "pensar" sobre objetos do mundo real que ele "vê" através das lentes de um futuro headset de realidade aumentada, desenvolvido pelo Google ou por um de seus parceiros de hardware.

Isso é algo que, provavelmente, o iPhone e o headset Vision Pro VR, da Apple, não conseguirão entregar no ano que vem. A Meta também está trabalhando duro em headsets de realidade mista que realizam esse tipo de computação visual.

INTEGRAÇÃO AO BARD

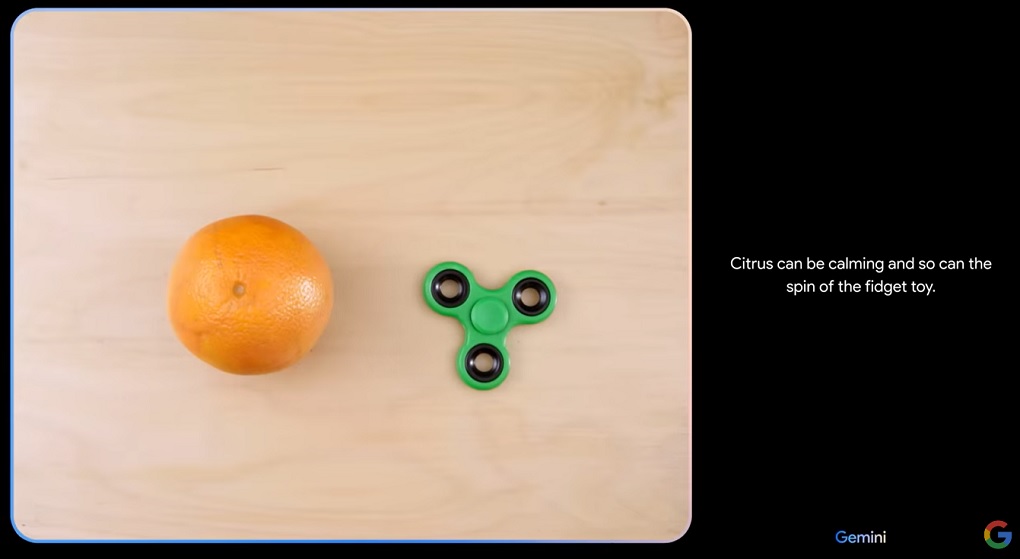

Ao anunciar a novidade, o Google exibiu um vídeo que mostra o Gemini “pensando” sobre um conjunto de imagens. No vídeo, uma pessoa põe uma laranja e um brinquedo giratório sobre a mesa, na frente de uma lente conectada ao Gemini.

O Gemini identificou imediatamente os dois objetos e respondeu com uma inteligente semelhança entre ambos: "uma laranja pode ser calmante e também pode ser o movimento de um brinquedo giratório", disse em voz alta.

Em outro vídeo, o Gemini examina um teste de matemática em que alguém escreveu à mão os cálculos para resolver um problema. O Gemini identifica e explica os erros nos cálculos do estudante.

A curto prazo, as capacidades do Gemini podem ser experimentadas por meio do chatbot Bard. O Google afirma que o Bard será alimentado pelo modelo Gemini Pro de médio porte, o que, espera-se, proporcionará ao chatbot melhores habilidades de aprendizado e raciocínio.

O Bard será atualizado para o modelo mais poderoso, Gemini Ultra, no ano que vem, afirma Sissie Hsiao, vice-presidente de assistentes virtuais da empresa. Desenvolvedores e clientes corporativos poderão acessar e construir sobre o Gemini Pro por meio de uma API fornecida pelo Google Cloud a partir do dia 13 de dezembro.