Armadilhas do reconhecimento facial

Essa é a primeira vez na vida que me aventuro a escrever mensalmente para uma coluna. Contei um pouco desse desafio no meu primeiro texto aqui.

Gosto sempre de relembrar isso porque me comprometi a usar esse espaço como canal de esperança, como instrumento de reflexão sobre as possibilidades de libertação que as novas tecnologias podem proporcionar. Imaginar futuros possíveis para nossas comunidades adoecidas tem sido um sul para o meu trabalho.

Acontece que algumas coisas me pegam tão profundamente que não me aguento. Desvio então um pouquinho do caminho e te peço paciência e empatia para ouvir um caso de desesperança. Quem sabe isso ajude a mobilizar sentimentos importantes para a luta coletiva que nosso tempo demanda.

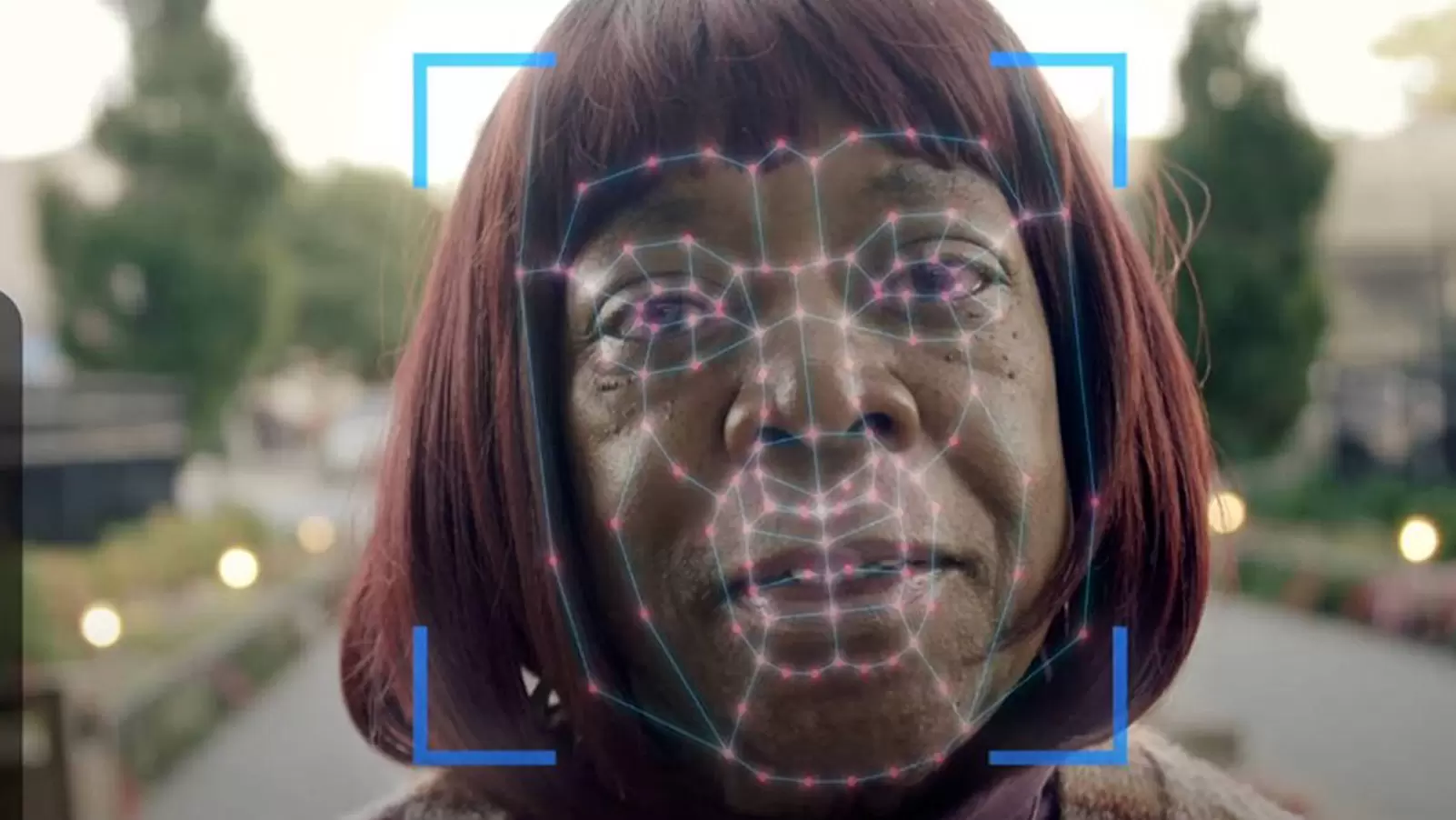

É que nos últimos meses tenho sido atravessada (e talvez você também) por notícias sobre o uso de tecnologias de reconhecimento facial como ferramenta para a melhoria da segurança pública nas grandes cidades do país.

Aqui no Rio a implementação de drones com esse tipo de tecnologia tem sido justificada para "qualificar" as operações policiais que massacram a população que vive nas favelas.

No calçadão das praias da zona sul ou no carnaval da Marquês de Sapucaí, centenas de câmeras já estão instaladas. A questão é complexa e merece debate.

A gente já quase se acostumou em mostrar o rosto para entrar em quartos de hotel ou condomínios, a desbloquear aplicativos no celular, realizar cadastros públicos ou brincar de envelhecer no Instagram.

Nossos dados finalmente deixaram de ser números de documentos, telefone, cartão de crédito, ou até a nossa impressão digital, e passaram a ser nossos traços físicos, nosso formato de rosto, nossa cor de pele.

sistemas de reconhecimento facial têm tendência a interpretar expressões faciais de pessoas brancas e negras de maneira diferente.

Eu já falei aqui sobre os problemas materiais e subjetivos do uso indiscriminado da inteligência artificial. Quando aplicada ao reconhecimento facial, o uso desse tipo de tecnologia definitivamente não garante mais segurança para nossas transações digitais e ainda se torna porta de entrada para a composição de bancos de dados utilizados por corporações de toda ordem.

Além disso, o que mais me preocupa é o fato de que todos esses serviços seguem sendo criados por pessoas e seus vieses racistas.

Tarcízio Silva é um dos principais pensadores brasileiros sobre racismo e tecnologia e organizou um livro só com intelectuais negros refletindo sobre o tema. Com ele, tenho discutido sobre o termo “racismo algorítmico”, que vem sendo cada vez mais usado e que trata da influência do racismo estrutural no desenvolvimento das tecnologias.

Você já deve ter me ouvido dizer por aí: tecnologias não são neutras! Parece simples de entender, mas vejo cada vez mais o discurso manipulador de que as tecnologias de reconhecimento facial são mais rápidas, mais neutras e precisas. É fácil desmontar esse argumento.

Veja: no ano passado, mais de 1,7 mil escolas no Paraná implementaram um sistema com o objetivo de facilitar a transmissão de conteúdos multimídia e a realização de videochamadas entre professores.

Acontece que o aparato também está sendo utilizado para o reconhecimento facial dos alunos e, pasme, se diz capaz de identificar expressões faciais dos estudantes para avaliar seu comportamento em sala de aula.

Um relatório detalhado produzido pelos meus companheiros da PUC-PR e UFPR destaca uma série de preocupações, incluindo os riscos de classificação errônea e viés racial nos algoritmos.

o termo “racismo algorítmico” vem sendo cada vez mais usado e trata da influência do racismo estrutural no desenvolvimento das tecnologias.

O projeto do governo do Paraná ultrapassou R$ 6 milhões e veio a reboque dos ataques violentos nas escolas no ano passado. Uma ótima desculpa para vigiar, classificar, monitorar e vender, em escala nunca antes imaginada, dados de crianças e adolescentes.

O relatório aponta estudos qualificados que mostram que não há uma correspondência direta entre expressões faciais e comportamento violento. A classificação incorreta de alunos como "violentos" por inteligência artificial pode resultar em prejuízos acadêmicos e profissionais enormes.

Eu sei disso porque vi e vivi uma série de racismos nos meus anos escolares que impediram que colegas (a maioria meninos negros) não tivessem qualquer chance de, ao menos, terminar o ensino médio.

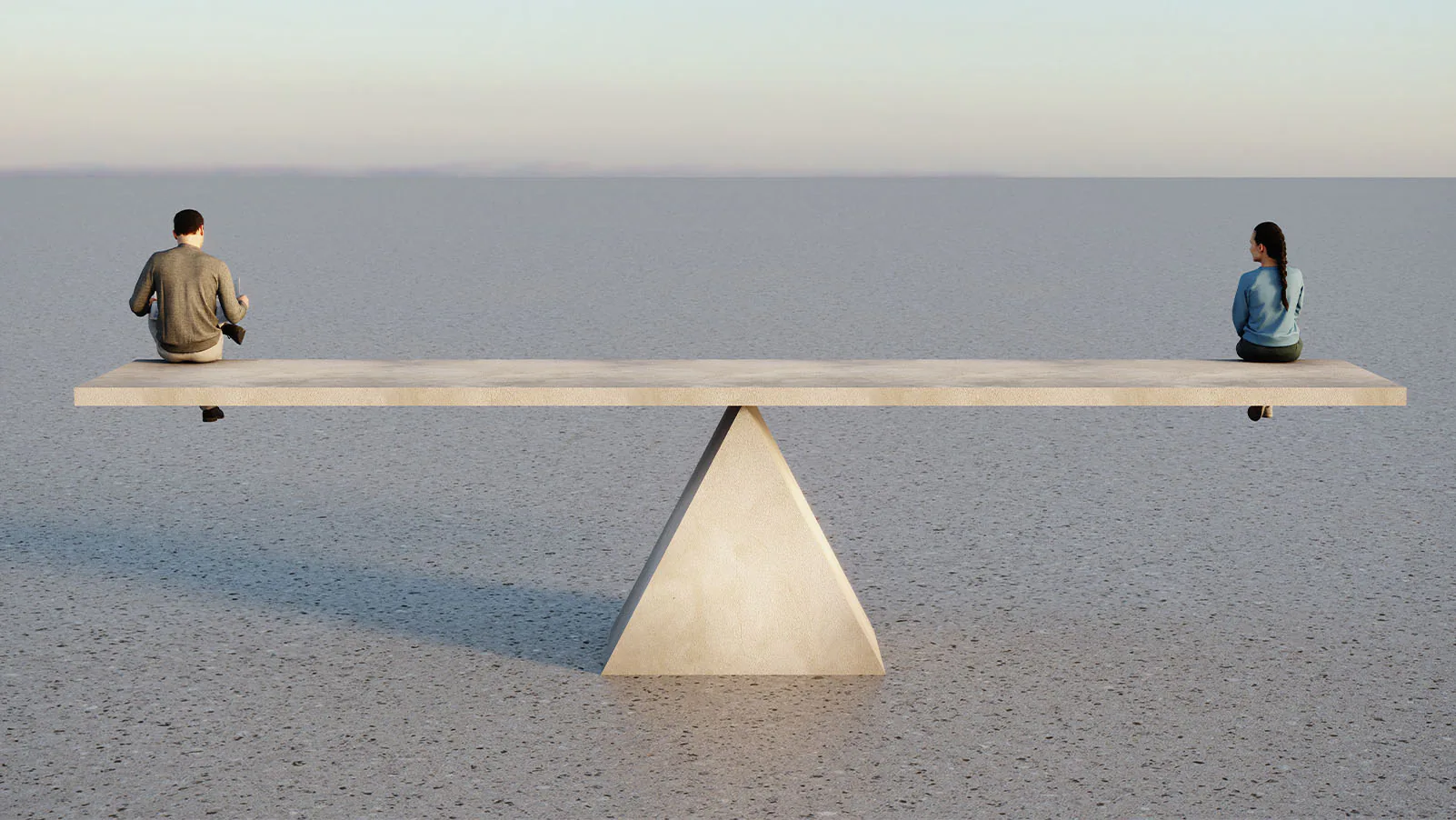

Além disso, o relatório diz que sistemas de reconhecimento facial têm tendência a interpretar expressões faciais de pessoas brancas e negras de maneira diferente, com uma maior atribuição de sentimentos negativos às pessoas negras. É a perpetuação do racismo, do uso de novas tecnologias para seguir reproduzindo velhas violências.

Quando sistemas como esse são aplicados às políticas de segurança pública, aí o buraco fica mais fundo. Desde 2018 estão implementados projetos de uso de tecnologias de reconhecimento facial para fins de segurança pública no Brasil.

São seis anos de experimentação que acumulam falhas e constrangimentos cotidianos. Além disso, os bancos de dados utilizados pelas polícias não combinam com dados atualizados de processos judiciais em aberto.

Se o benefício desses programas está em identificar foragidos, o que justifica a vulnerabilidade e potencial constrangimento de qualquer um que esteja caminhando pela rua?

E é importante dizer que quando digo “qualquer um”, estou me referindo especialmente às pessoas negras – aquelas que têm quatro vezes mais chances de serem abordadas pela polícia.

Os defensores do reconhecimento facial acreditam que bastaria melhorar o sistema, reduzir a margem de erros. Eles me lembram aqueles defensores das tecnologias neutras.

A classificação incorreta de alunos como "violentos" por inteligência artificial pode resultar em prejuízos acadêmicos e profissionais enormes.

A tentativa de reduzir erros e adaptar a tecnologia para diferentes grupos populacionais aumentaria a identificação, vigilância e rastreamento desses grupos, perpetuando um uso desigual e a violência sistêmica causada pelo racismo.

Mesmo que haja supostos benefícios para a sociedade, comprometer o direito à privacidade nessas circunstâncias é questionável, especialmente considerando a complexidade da promoção de medidas de segurança pública justas. É muito importante indagar se esses benefícios encobrem violências institucionais contra grupos historicamente marginalizados.

Uma campanha nacional pelo banimento total do uso de tecnologias de reconhecimento facial na segurança pública tem sido articulada desde 2022 (apoie a campanha!). O manifesto #TireMeuRostoDaSuaMira é didático e aponta casos internacionais que vem avançando em legislações capazes de proteger as populações em detrimento da ganância das big techs.

A última novidade é uma Lei de Inteligência Artificial (AI Act) que acaba de ser aprovada pelos países da União Europeia. Os desafios para implementação da legislação e para desviar dos maiores interesses das corporações são muitos, como aponta minha companheira Joana Varon aqui nesse artigo.

Mas a conquista europeia pode representar avanço para que outros países sigam pressionados a também formular suas propostas de regulação, como foi o caso da Lei Geral de Proteção de Dados no Brasil (e em muitos países) que veio a reboque da lei gringa.

No final do ano passado, participei de um episódio do podcast Ciência Suja, que já está na sua quarta temporada levantando questões polêmicas (e criminosas) protagonizadas pela ciência. Nesse episódio, eu e um time brabo discutimos sobre tecnologia, ciência e política.

Nossos dados finalmente deixaram de ser números e passaram a ser nossos traços físicos, nosso rosto, nossa cor de pele.

Para mim, a ferida aberta nessa história toda é a falta de diversidade e o excesso de concentração de poder no desenvolvimento de inteligência artificial. Um dos meus companheiros de mesa no podcast é o Pablo Nunes.

Pablo é responsável pelo Panóptico, um projeto do Centro de Estudos de Segurança e Cidadania (CESEeC). Ele e sua equipe vêm monitorando os casos de racismo algorítmico no uso de reconhecimento facial, assim como a implementação de políticas desse tipo no Brasil.

O trabalho já rendeu inúmeras parcerias com outras ONGs e coletivos e apoiou a formulação de leis que propõem regular o setor.

Para mim, projetos como o Panóptico e a campanha #TireMeuRostoDaSuaMira são referências de organização e conhecimento de uma sociedade atenta aos novos desafios que as tecnologias têm imposto à luta por direitos civis nesses tempos catastróficos.