Por que especialistas estão chamando de besteira as alucinações das IAs

Dizer que as IA só falam m* não é apenas uma forma de chocar – na verdade, esse palavrão tem um significado filosófico

Desde o lançamento do ChatGPT, no final de 2022, já percebemos que os modelos de linguagem de inteligência artificial têm a tendência de proferir inverdades, o que também ficou conhecido como "alucinações" da inteligência artificial.

As empresas de IA têm alegado que esse é um problema que pode ser resolvido. E com o uso de tecnologias como a geração aumentada por recuperação (na qual a IA recorre a um banco de dados de informações confiáveis), essas inconsistências de fato diminuíram em muitos casos.

Mas elas persistem, conforme demonstrado em uma recente investigação da revista "Wired" sobre a ferramenta de pesquisa de IA Perplexity. A reportagem traz um título bem ousado: "O Perplexity é uma máquina de falar m*".

O uso da palavra "bullshit" no título é mais do que uma manchete chamativa; é uma referência a uma pesquisa publicada recentemente por um trio de professores de filosofia da Universidade de Glasgow.

Para alguém alucinar, é preciso antes ter alguma consciência ou consideração pela verdade.

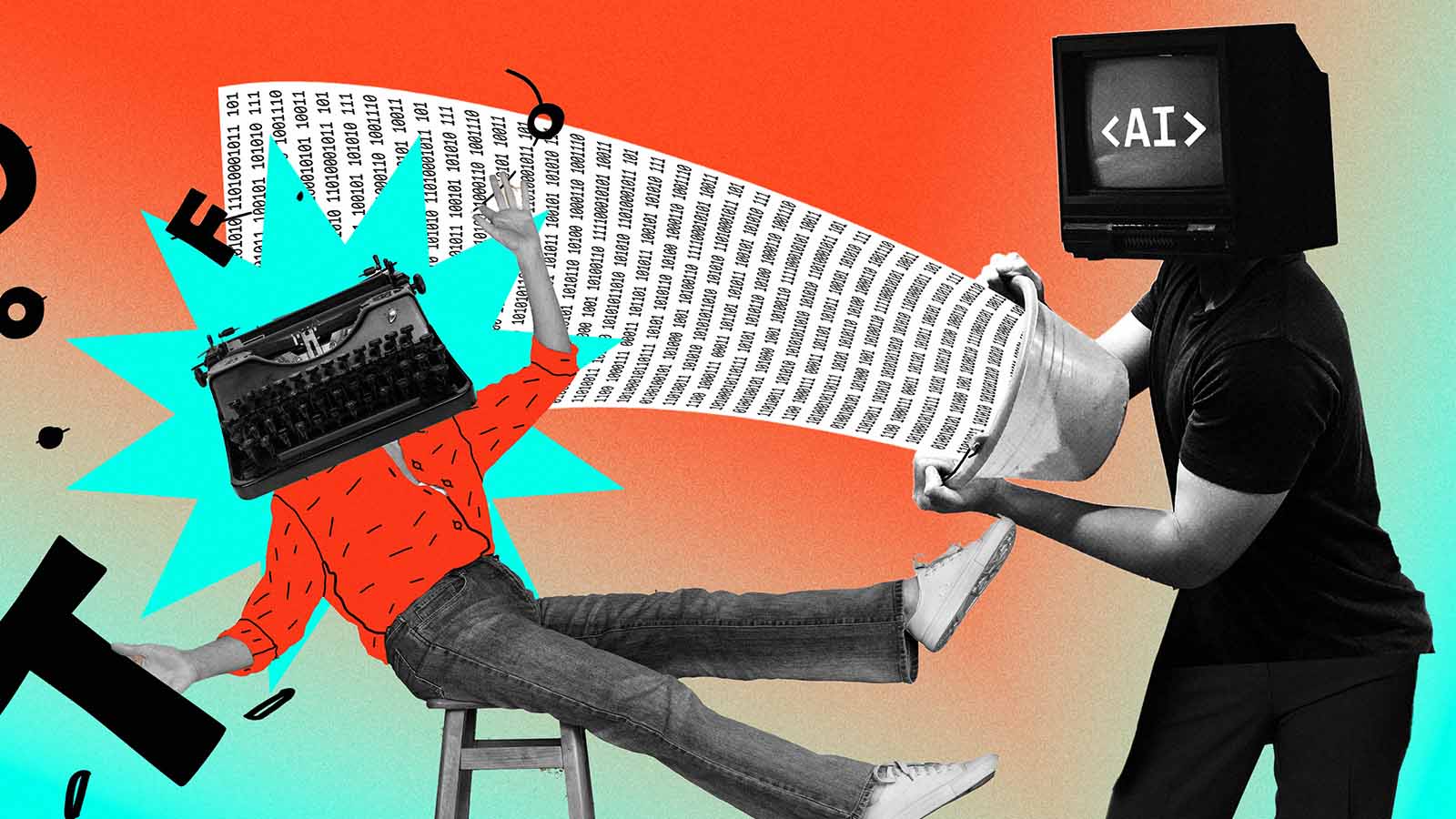

O autores do relatório, intitulado "ChatGPT is bullshit" (O ChatGPT é uma m*), dizem que chamar os falsos resultados gerados por grandes modelos de linguagem (LLMs, na sigla em inglês) de "alucinação" é distorcer o que de fato acontece.

O argumento é que aquilo que os LLMs estão dizendo é, basicamente, um monte de besteiras. E não é qualquer besteirinha, mas sim o tipo de besteira definida pelo falecido filósofo moral Harry Frankfurt em seu best-seller de 2005, "On Bullshit" (“Sobre falar m*”, na edição em português).

VERDADE IRRELEVANTE

O livro de Frankfurt trata principalmente de definir a diferença entre um "mentiroso" e um " falador de m*". Um mentiroso não usa fatos para parecer confiável – e, portanto, persuasivo – mas se satisfaz em dizer coisas que parecem verdadeiras para obter o mesmo resultado.

Por exemplo, um vendedor de carros usados que diz um monte de bobagem usa um conjunto de argumentos que ele acha que levará alguém a comprar um carro. Alguns desses argumentos são verdadeiros, outros são falsos. Mas, para ele, isso pouco importa: ele os usaria independentemente de serem verdadeiros ou não.

"Um falador de m* não rejeita a autoridade da verdade, como faz um mentiroso, nem se opõe a ela", escreveu Frankfurt. "Ele simplesmente não presta nenhuma atenção a ela. Em virtude disso, esse tipo de informação falsa prejudica mais a verdade do que as mentiras propriamente ditas."

Em seu relatório recente, os pesquisadores de Glasgow – Michael Townsen Hicks, James Humphries e Joe Slater – argumentam que a definição de “falar m*” de Frankfurt é mais adequada para descrever o comportamento dos LLMs do que o termo "alucinação".

Para alguém alucinar, é preciso antes ter alguma consciência ou consideração pela verdade. Só que os LLMs trabalham com probabilidades e não com julgamentos binários de correto/ incorreto.

O termo "alucinação" alimenta o exagero da propaganda sobre as habilidades das máquinas.

Com base em um enorme mapa multidimensional de palavras criado pelo processamento de grandes quantidades de texto, os LLMs decidem quais palavras seriam mais prováveis de seguirem aquelas usadas em um prompt (com base no significado e no contexto atual). Eles estão mais preocupados em parecer verdadeiros do que em dar uma resposta de fato correta, concluem os pesquisadores.

"O ChatGPT e outros LLMs produzem um monte de besteiras, no sentido de que não se preocupam com a veracidade de seus resultados", diz Hicks. "Pensar neles desta forma proporciona uma maneira mais precisa de pensar sobre o que eles estão fazendo e, assim, permite que os consumidores e os órgãos reguladores entendam melhor por que eles costumam errar."

DE ONDE VÊM AS "ALUCINAÇÕES"

Quando os LLMs "alucinam", normalmente é porque se deparam com uma escassez de informações sobre o assunto ou contexto específico em seus dados de treinamento. Eles confiam demais em suas configurações de probabilidade existentes e, de certa forma, improvisam.

A definição de "falar m*" de Frankfurt parece captar muito bem esse comportamento. "A besteira é inevitável sempre que as circunstâncias exigem que alguém fale sem saber do que está falando", escreveu ele.

Essas metáforas são importantes, dizem os pesquisadores. "Chamar as falhas da IA de 'alucinações' não é algo inofensivo. Essa terminologia se presta à confusão de que as máquinas estariam, de alguma forma, interpretando mal, mas que, mesmo assim, tentam transmitir algo que acreditam ou que entenderam", escreveram eles, concluindo que o termo também "alimenta o exagero da propaganda sobre as habilidades das máquinas entre os entusiastas da tecnologia".

É claro que Frankfurt estava se referindo aos humanos que falam besteira sem filtros, e não à inteligência artificial. Mas as metáforas humanas são as melhores ferramentas que temos para entender a IA.

A besteira é inevitável sempre que as circunstâncias exigem que alguém fale sem saber do que está falando

"A maioria dos consumidores de IA e muitos reguladores não têm uma compreensão técnica clara do que os modelos de linguagem de grande porte estão fazendo e os compreendem por meio dessas descrições não técnicas, de analogias e metáforas", diz Hicks.

O público tem contado com os pesquisadores de IA e com as grandes empresas de tecnologia para lhes dar a linguagem necessária para entender os modelos de IA. Isso poderia ter sido bom antes de a IA generativa se tornar um grande negócio – e antes de haver um motivo de lucro para girar e controlar as narrativas.

Com empresas ávidas por lucro, como o Google e a OpenAI, escolhendo suas palavras com cuidado, os reguladores de IA e os consumidores precisam insistir em ouvir uma diversidade de opiniões, especialmente quando se trata de questões cruciais, como preconceito e segurança.