Todo mundo discorda sobre como definir inteligência artificial geral

A conferência TED AI trouxe várias definições de inteligência artificial geral, destacando as divergências sobre quando ela se tornará realidade

Estamos apenas começando a ver as primeiras aplicações da IA generativa, mas muitas pessoas já estão pensando na próxima fronteira: a inteligência artificial geral (IAG). Este foi um tema importante durante a conferência TED IA que aconteceu na semana passada em São Francisco. No entanto, parece não haver um consenso claro sobre quando os sistemas de IAG serão desenvolvidos, nem como devemos defini-los.

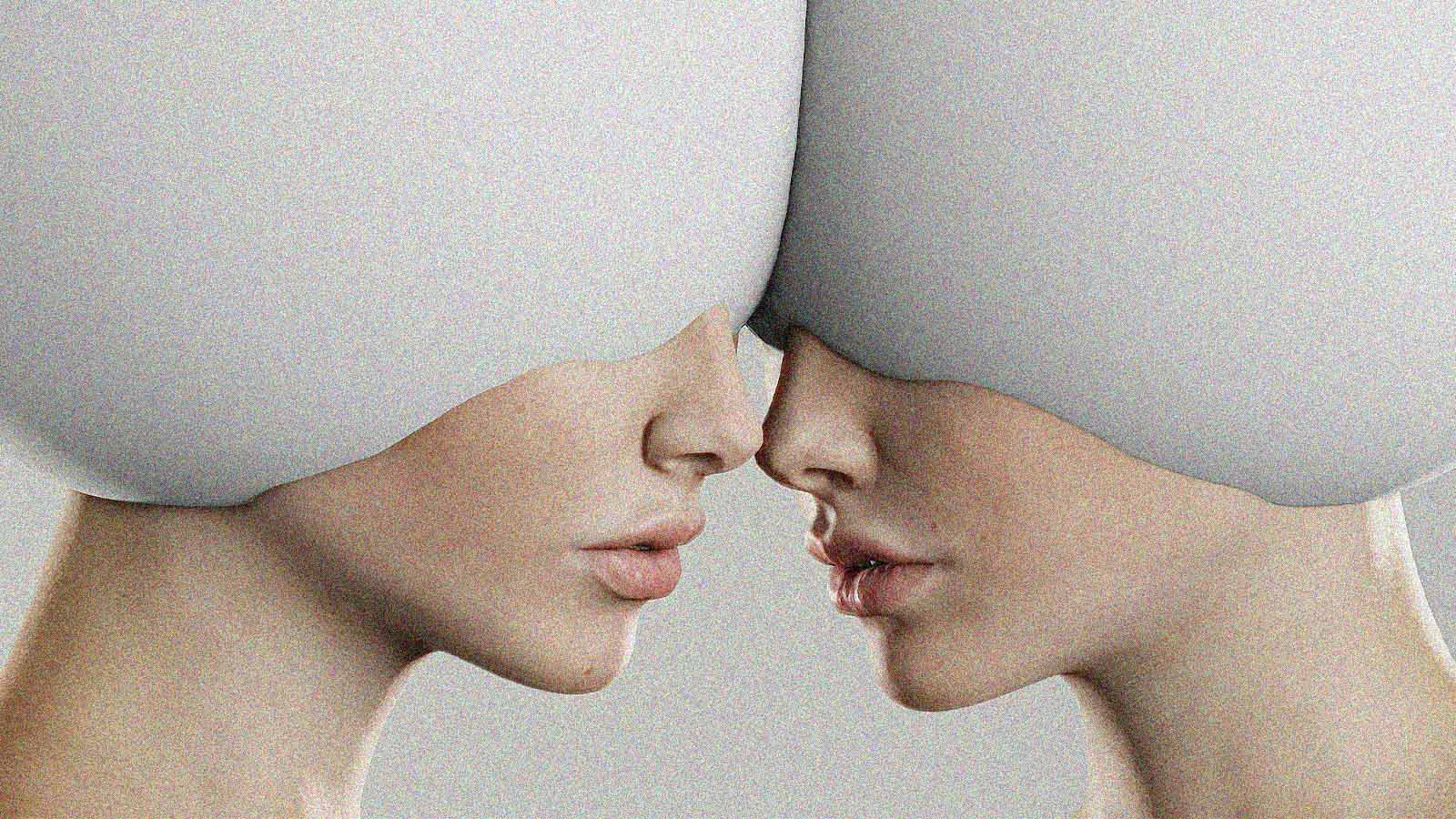

O termo geralmente se refere a sistemas capazes de aprender a executar qualquer tarefa intelectual que os seres humanos podem realizar. Por outro lado, alguns afirmam que a IAG diz respeito a modelos que podem aprender a executar tarefas inteiramente novas sem depender de instruções explícitas ou exemplos em seus dados de treinamento.

A maior parte da indústria acredita que modelos como o utilizado no ChatGPT são o caminho para a IAG.

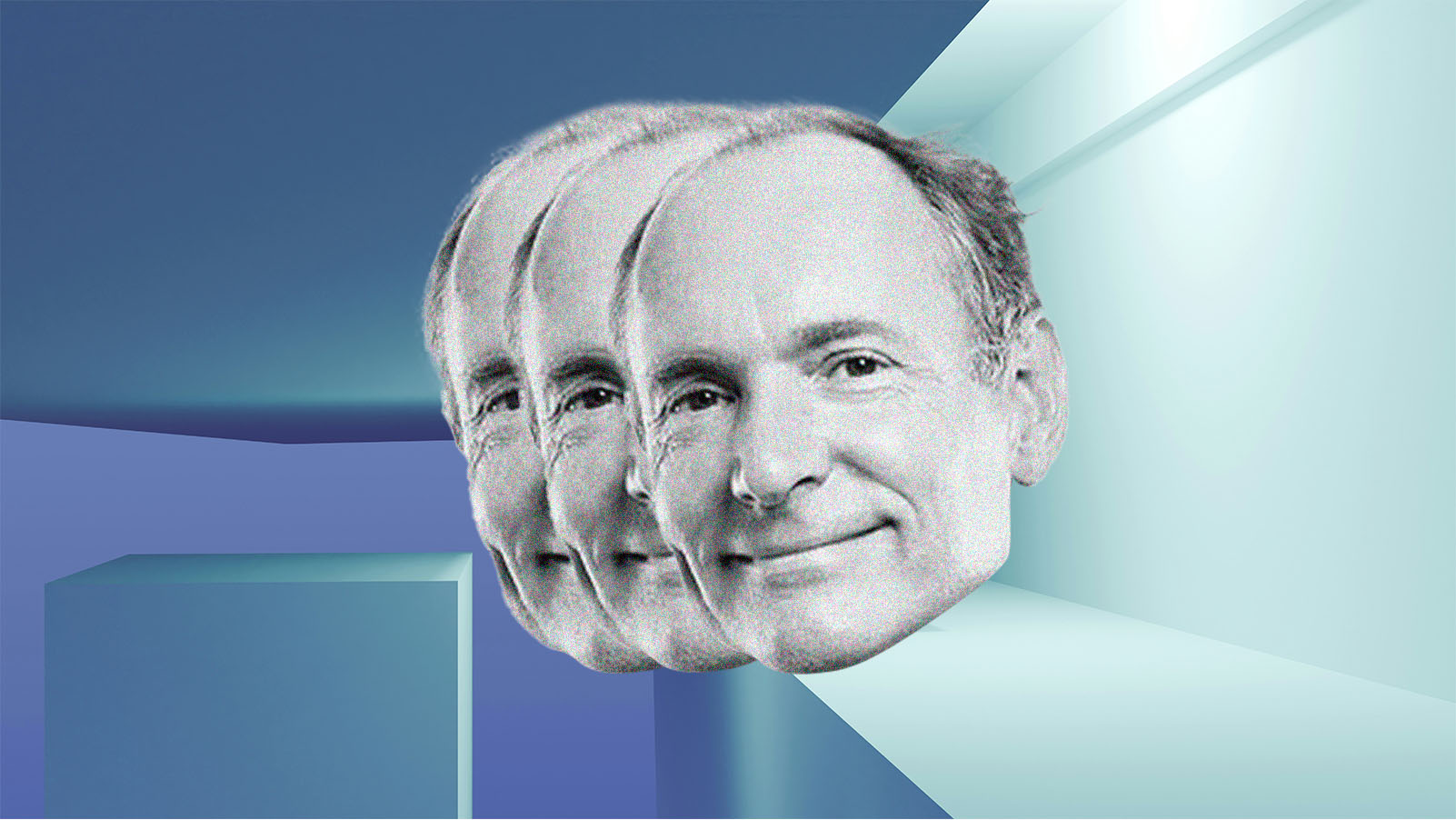

Ilya Sutskever, cientista-chefe da OpenAI (cujo objetivo é criar sistemas de IAG), deu uma definição bastante convencional, embora um tanto vaga, afirmando que, para atingir os padrões da inteligência artificial geral, é necessário um sistema que possa ser ensinado a fazer tudo o que um ser humano pode aprender a fazer.

Mas a OpenAI usou uma definição menos restritiva no passado, descrevendo a IAG como sistemas que superam as capacidades humanas na maioria das tarefas economicamente valiosas.

Durante o evento, uma fonte anônima me informou que as empresas de IA estão começando a manipular a definição do termo para tornar mais fácil afirmar que seus produtos possuem capacidades de IAG. A primeira a conseguir alcançar a inteligência artificial geral receberá muita atenção – e provavelmente verá um aumento considerável em seu valor de mercado.

A maior parte da indústria acredita que modelos como o utilizado no ChatGPT são o caminho para a IAG e que os avanços vistos com eles reduziram o tempo necessário para atingir esse objetivo.

O termo geralmente se refere a sistemas capazes de aprender a executar qualquer tarefa intelectual que os seres humanos podem realizar.

Pesquisadores da Microsoft afirmam que viram indícios de IAG no GPT-4 (a empresa detém 49% da OpenAI). Dario Amodei, CEO da Anthropic, prevê que a inteligência artificial geral surgirá em dois ou três anos. Shane Legg, cofundador da DeepMind, estima que existe uma chance de 50% de alcançá-la até 2028.

A definição é importante, pois pode afetar a decisão das empresas de quando começar a implementar medidas de segurança em seus modelos para mitigar os prováveis riscos associados a esses sistemas.

A IAG não só poderia ser usada por pessoas mal-intencionadas para prejudicar outras, como também é possível que esses sistemas possam aprender independentemente dos seres humanos.

Naturalmente, as empresas de tecnologia deveriam estar dedicando tempo e esforço para proteger os modelos que já construíram. E, de fato, estão investindo em segurança. Mas parece haver uma espécie de corrida armamentista, e o incentivo econômico para construir modelos maiores e mais eficazes está fazendo com que deixem de lado a ideia de desenvolver a IA de maneira mais lenta e segura.

O “OTIMISMO INGÊNUO” DO VALE DO SILÍCIO

Em seu recente livro “The Coming Wave” (A Onda que se Aproxima), o cofundador da DeepMind, Mustafa Suleyman, descreve o “otimista ingênuo” do Vale do Silício como alguém que ignora conscientemente os possíveis efeitos negativos das novas tecnologias e avança sem se preocupar em criar salvaguardas.

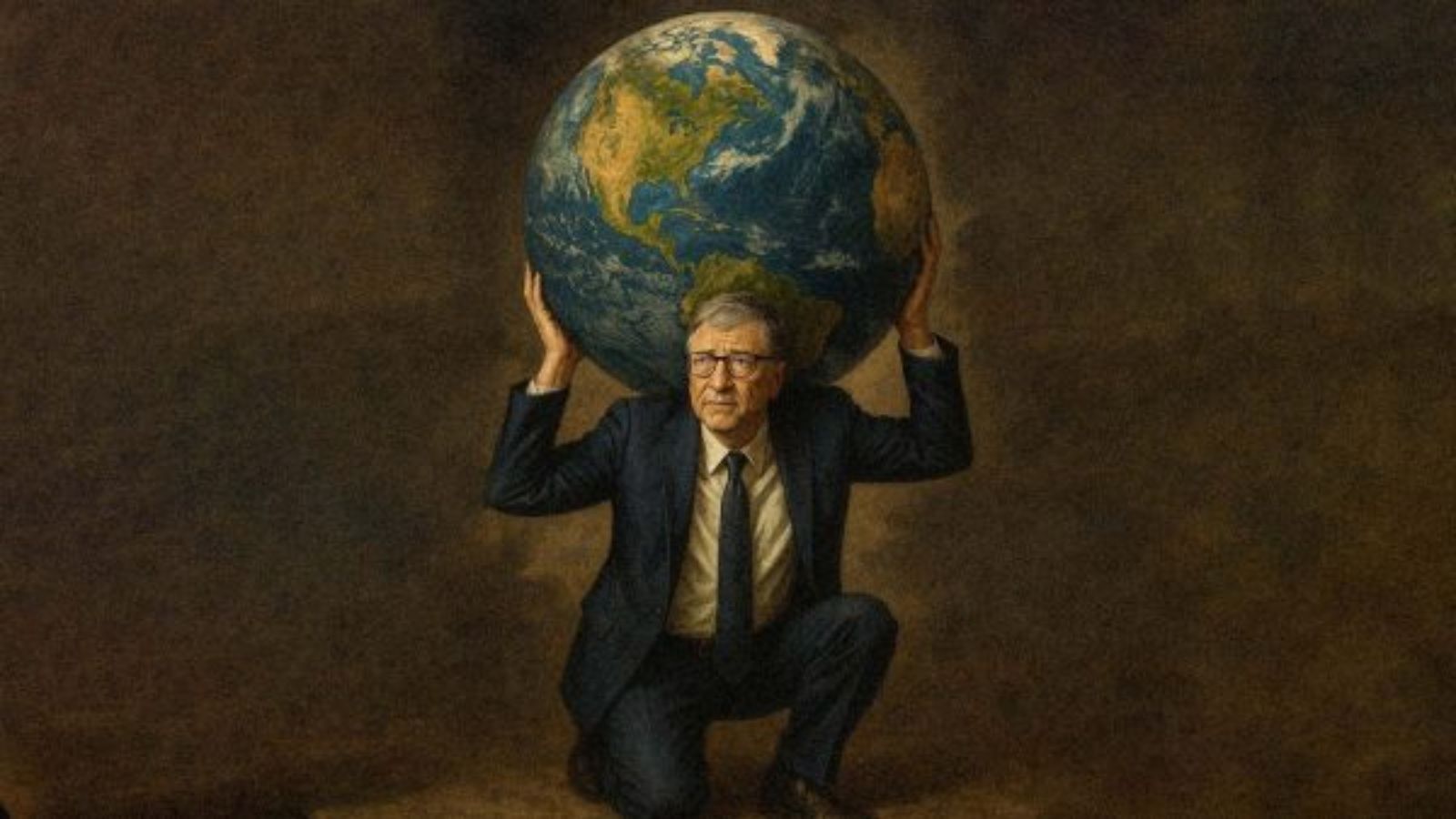

O mais recente texto do superinvestidor Marc Andreessen, intitulado “The Techno-Optimist Manifesto” (O Manifesto do Tecno-Otimista), parece resumir tudo o que Suleyman adverte.

Andreessen, cujo patrimônio líquido é estimado em cerca de US$ 1,8 bilhão, investe há anos em empresas de IA e, certamente, colherá muitos frutos se algumas de suas apostas estiverem certas. Alguns trechos marcantes de seu manifesto:

- “Acreditamos que a inteligência artificial é a nossa alquimia, nossa pedra filosofal – estamos, literalmente, fazendo a areia pensar.”

- “Acreditamos que qualquer desaceleração na inteligência artificial custará vidas. Mortes que poderiam ser evitadas pela IA que foi impedida de existir são uma forma de homicídio.”

- “Nosso inimigo é o princípio da precaução, que teria impedido praticamente todo progresso desde que o homem dominou o fogo... É profundamente imoral, e devemos nos livrar dele sem piedade.”

Em nenhum lugar do manifesto aparecem as palavras “consequências não intencionais”, “aquecimento global” ou “mudanças climáticas”. Apesar de pessoas, como Sam Altman da OpenAI, pedirem publicamente regulamentações para o desenvolvimento da IA, suspeito que muitos líderes de tecnologia do Vale do Silício concordem com Andreessen.

Muitos acreditam que a IA trará riqueza e abundância sem precedentes e mal podem esperar para colher os frutos. Mas, se o manifesto de Andreessen deixa algo claro, é que não há muita preocupação com as consequências.