Nvidia investe na criação de um centro de pesquisa em computação quântica

Laboratório tem como objetivo resolver alguns dos principais desafios da computação quântica. Anúncio derruba ações das principais empresas do setor

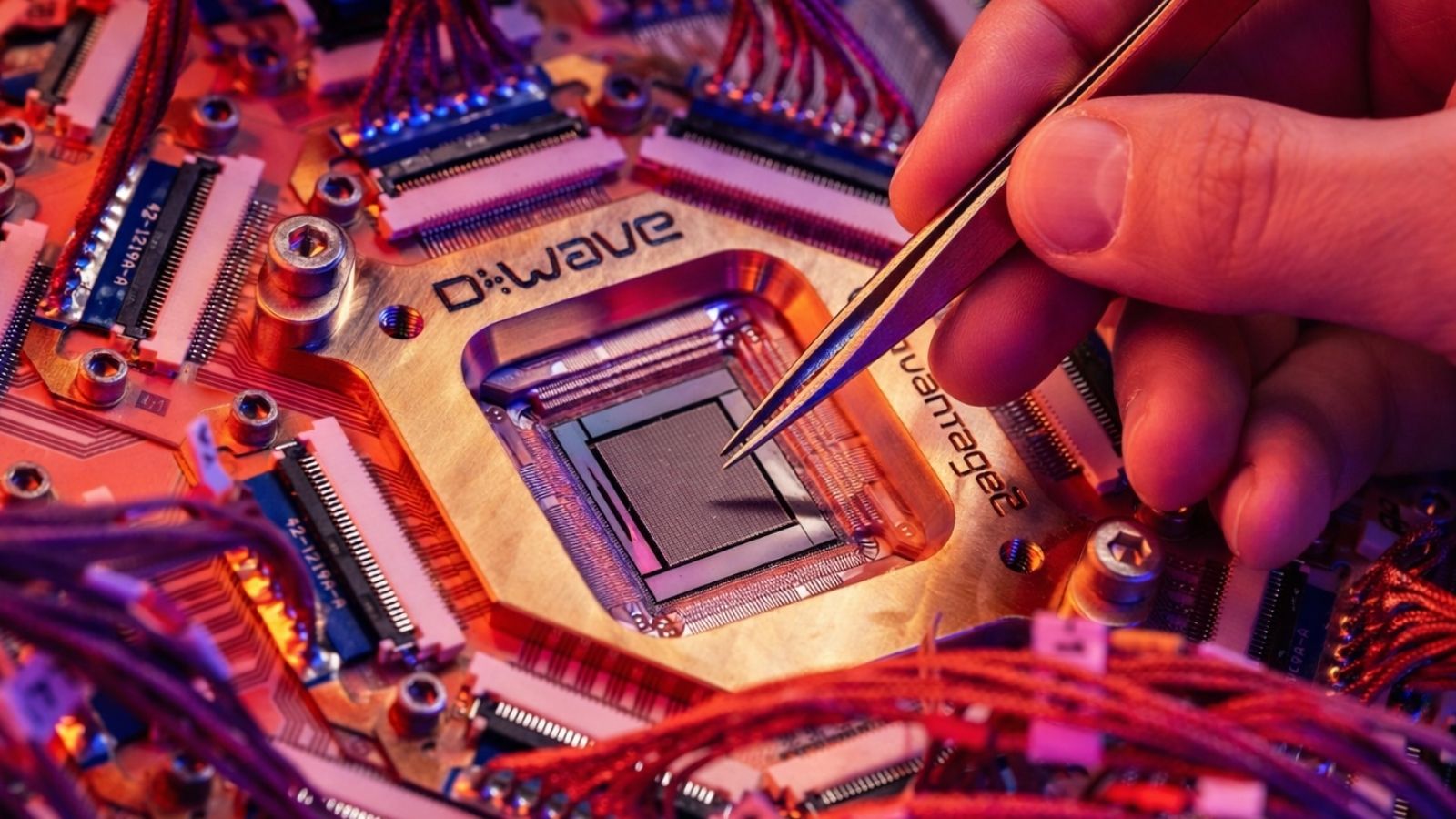

As ações das principais empresas de computação quântica sofreram uma forte queda recentemente. Os quatro maiores players do setor listados na bolsa – IonQ, Rigetti Computing, Quantum Computing Inc. e D-Wave Quantum Inc. – registraram perdas entre 9% e 18%. O motivo? Tudo indica que foi, mais uma vez, o impacto de um anúncio da Nvidia, gigante dos chips de IA.

A queda aconteceu justamente no dia em que a Nvidia abriu seu evento Quantum Day (na quinta-feira, dia 23), uma conferência de dois dias focada em computação quântica. Além de reunir especialistas da área, a empresa aproveitou a ocasião para anunciar a criação de um novo centro de pesquisa em computação quântica em Boston.

Batizado de Nvidia Accelerated Quantum Research Center (NVAQC), o laboratório tem como objetivo resolver alguns dos principais desafios da computação quântica, como a instabilidade dos qubits e a dificuldade de transformar processadores experimentais em dispositivos realmente utilizáveis, segundo a empresa.

A escolha de Boston como sede coloca o centro próximo de duas das principais instituições do mundo em pesquisa avançada: a Universidade Harvard e o Instituto de Tecnologia de Massachusetts (MIT).

“Nosso centro será um espaço para grandes avanços na computação híbrida, ajudando a desenvolver supercomputadores quânticos acelerados e de grande escala”, afirmou Jensen Huang, CEO da Nvidia.

Até então, IonQ, Rigetti, D-Wave e Quantum Computing Inc. lideravam o setor emergente de computação quântica. Por enquanto, essas empresas continuam no topo – afinal, o centro de pesquisa em computação quântica da Nvidia ainda não saiu do papel.

Mas há temores de que a companhia, com seu gigantesco valor de mercado de US$ 2,9 trilhões, possa investir bilhões de dólares na área e, rapidamente, assumir a liderança do setor.

APOSTA NA INTELIGÊNCIA ARTIFICIAL EM TEMPO REAL

Durante o Quantum Day, Jensen Huang descreveu o momento como o “Super Bowl da IA”. E faz sentido: a Nvidia é a principal fornecedora de chips da revolução da inteligência artificial, sendo não apenas a empresa mais influente do setor, mas também a mais lucrativa.

Além do anúncio do centro e pesquisa em computação quântica da Nvidia, Huang aproveitou sua apresentação para revelar a nova geração de chips, que serão responsáveis por treinar e operar os modelos de IA nos próximos anos.

O CEO apresentou a plataforma Vera Rubin, composta pelo primeiro processador (CPU) customizado da Nvidia, chamado “Vera”, e por duas novas unidades de processamento gráfico (GPUs), batizadas de “Rubin” – uma homenagem à astrônoma Vera Rubin, pioneira na descoberta de evidências da matéria escura.

Segundo a Nvidia, o Vera é duas vezes mais rápido que o processador baseado em arquitetura Arm usado na plataforma Blackwell do ano passado. Combinados, Vera e Rubin entregam mais que o dobro do desempenho em inferência comparado à geração anterior.

Huang também anunciou o Blackwell Ultra, uma versão ainda mais potente da GPU carro-chefe da empresa, com maior capacidade de processamento e memória. O lançamento está previsto para o segundo semestre de 2025.

Essas novas plataformas, especialmente a Vera Rubin, foram desenvolvidas para otimizar a inferência, ou seja, o processo de raciocínio em tempo real dos modelos de IA para gerar respostas.

Huang destacou a crescente necessidade de chips capazes de processar e armazenar grandes volumes de dados rapidamente durante a inferência. Em um comentário provocativo, afirmou que “quase todo mundo errou feio” ao avaliar o fenômeno DeepSeek, uma referência à startup chinesa que afirmou conseguir treinar modelos avançados de IA com um número menor de GPUs menos potentes.

A empresa apresentou a nova geração de chips que serão responsáveis por treinar e operar os modelos de IA nos próximos anos.

“O volume de computação necessário para a IA generativa, devido ao aumento do raciocínio e da inteligência autônoma, é pelo menos 100 vezes maior do que pensávamos no ano passado”, afirmou Huang. Ou seja, a demanda por inferência deve disparar – e, com isso, a necessidade de mais hardware.

Com esse crescimento, a Nvidia está ampliando sua atuação além da infraestrutura, entrando diretamente no mercado de aplicativos de inteligência artificial. Como parte dessa estratégia, a empresa anunciou uma nova família de modelos de IA de raciocínio de código aberto, chamada Nemotron.

Baseados na arquitetura Llama, da Meta, esses modelos podem rodar no hardware Spark ou no Station, além de serem compatíveis com a nuvem. Embora não sejam os mais potentes, foram desenvolvidos para tarefas empresariais mais leves e otimizados para rodar de forma eficiente nos chips da Nvidia – criando mais um incentivo para que empresas permaneçam dentro do ecossistema da companhia.