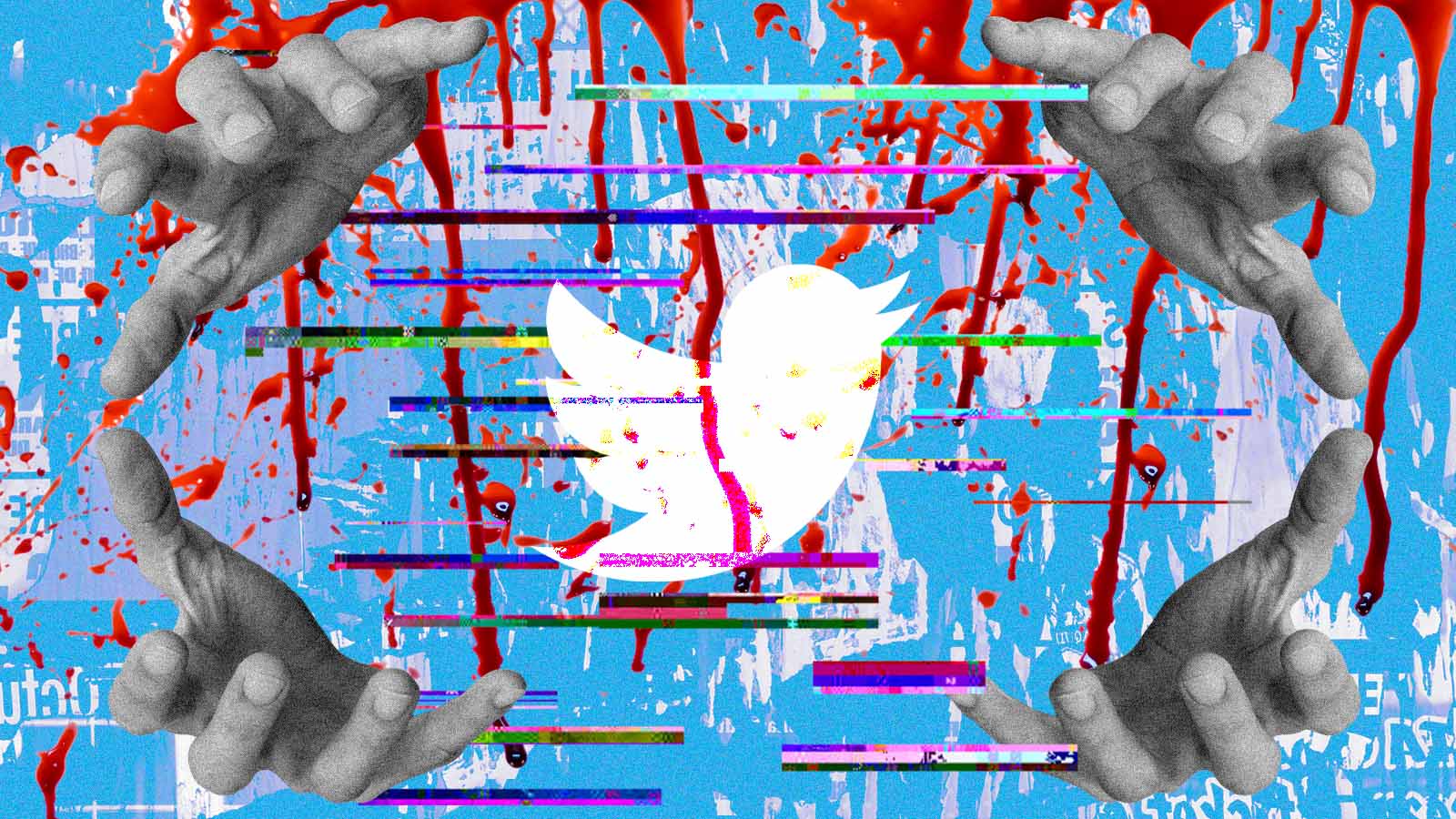

A incógnita do X

O X da questão é que existe uma opacidade intencional para que ninguém saiba como funciona a moderação dos conteúdos

Nas conversas dos últimos dias, comenta-se em todos os cantos sobre o bloqueio da plataforma X (ex-Twitter) no Brasil. O ministro do STF Alexandre de Moraes decidiu bloquear a plataforma após a rede social não cumprir uma ordem judicial que exigia a nomeação de um representante legal no país.

Porém, o imbróglio tem como pano de fundo ordens judiciais anteriores, feitas por Moraes, para que a plataforma de Elon Musk moderasse discursos de ódio, racistas e antidemocráticos e retirasse alguns perfis relacionados a esses conteúdos, o que, segundo o ministro, poderia interferir negativamente nas eleições municipais de 2024.

A medida visa, segundo Moraes, garantir que a plataforma opere dentro dos limites da legislação brasileira e respeite as normas de segurança e a ordem pública. Musk se recusa a aceitar os pedidos de moderação na plataforma acusando o Superior Tribunal Federal de censura.

A recusa gerou multas e ordem judicial que menciona, em caso de desobediência, a possibilidade de prisão do responsável legal pelo operação do X no Brasil. Para escapar das penalidades, o empresa fechou o escritório no Brasil, alegando que estava sendo ameaçada pelo ministro do STF.

O debate central é a moderação de conteúdo e sua relação com as ideias de liberdade e responsabilidade. Discute-se até que ponto a justiça e os governos podem e/ ou devem impor remoção de conteúdo baseado em leis locais e se isso configura censura. Porém pouco se fala que todas as plataformas moderam milhares de conteúdos diariamente.

Isso também significa censurar os usuários? Quais são os motivos e as responsabilidades de moderação de conteúdo dessas empresas? Qual é o percentual de pedidos judiciais diante do total retirado pelas próprias plataformas? Não temos transparência sobre essas informações, que são evidentemente de interesse público.

Os algoritmos de recomendação e de moderação das plataformas definem o quê, quando e como os usuários vão consumir conteúdo. Nesse contexto, a transparência na moderação se torna fundamental. A Europa exige que grandes plataformas publiquem relatórios detalhados sobre moderação de conteúdo. No Brasil, essa prática ainda é incomum.

Os algoritmos de recomendação e de moderação das plataformas definem o quê, quando e como os usuários irão consumir conteúdo.

Pesquisadores têm alertado sobre o quão perigosa é a opacidade das plataformas. Mesmo em países onde há exigência de relatórios de moderação, os dados são vagos e não indicam os critérios aplicados.

Isso pode configurar uma estratégia de manipulação da opinião pública, que supervaloriza as requisições governamentais e judiciais enquanto minimiza ou oculta as moderações realizadas pelas próprias empresas.

Portanto, o X da questão fica evidente: existe uma opacidade intencional para que ninguém saiba como funciona a moderação dos conteúdos. O conceito de transparence-washing tem sido utilizado por diversos pesquisadores, que sugerem que esta é uma prática corporativa comum das big techs para “distrair o público" e desviá-lo das reais questões sobre transparência e responsabilidade na moderação.

Fica a pergunta: a quem interessa a falta de transparência?